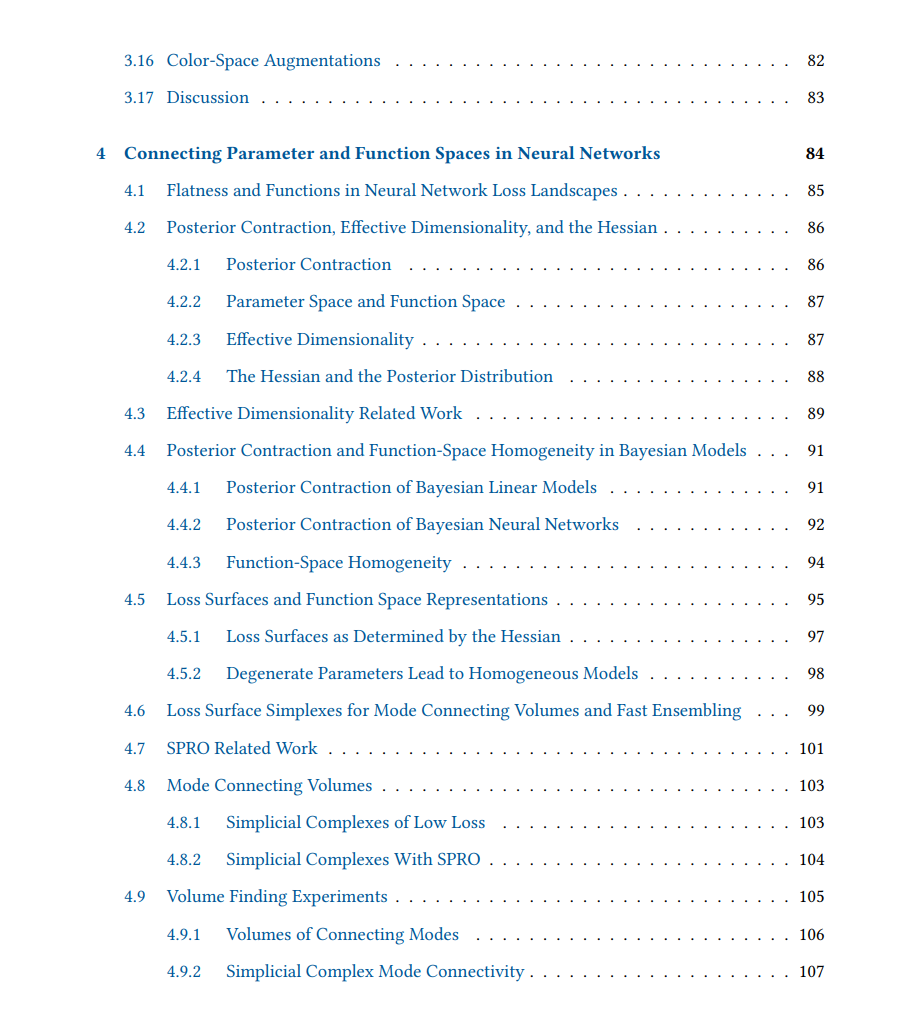

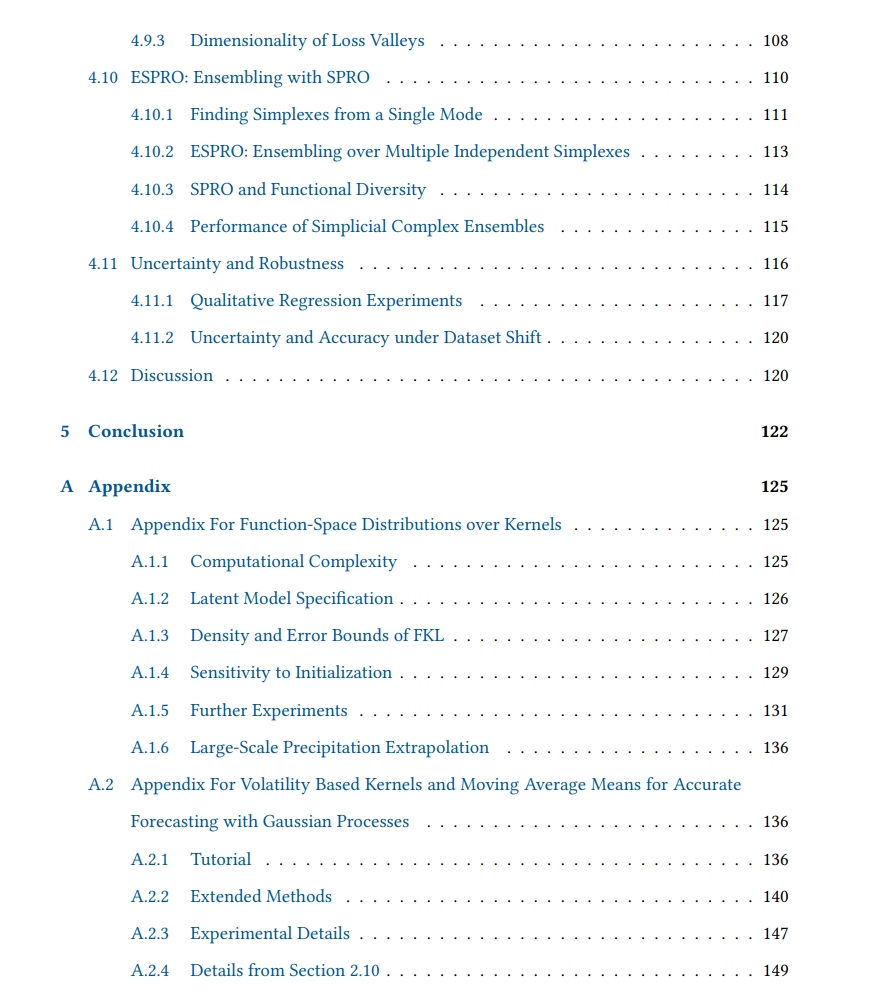

在一个典型的建模设置中,我们对想要学习的函数类型有先验的概念。例如,在回归中,我们可能想要学习一个平滑函数或周期函数;在图像分类中,我们可能想要学习一个对旋转不变的函数。虽然函数空间为我们提供了理解诸如不变性或平滑性等特性的好处,但直接量化模型的功能属性往往是困难的。 在这篇论文中,我们利用对函数空间的推理能力来构建更强大的模型,无论是在高斯过程(GPs)还是神经网络中。通过将GP核作为潜在过程本身的函数生成,我们引入了一种方法,不仅仅是对GP模型中的函数本身,而且对我们产生的函数类型提供不确定性。我们还引入了一种方法,用于在神经网络中学习不变性和等变性的水平,使我们能够赋予模型产生的函数以软感应偏见,而不是硬约束。最后,我们展示了如何利用对神经网络参数空间的理解,高效地整合多样化的函数集合,以提高模型的准确性和鲁棒性。通过引入这些方法,我们展示了通过仔细考虑我们正在产生的函数类型,我们可以描述具有一系列理想特性的模型。这些特性包括更灵活的模型、更符合领域知识的模型,以及既准确又鲁棒的模型。我们在包括时间序列预测、图像分类和强化学习在内的广泛问题上展示了这些结果。 在许多建模背景下,对于我们想要产生什么类型的函数进行规定要比推理函数的参数形式或函数本身的参数容易得多。例如,在时间序列中,我们可能只需简单地观察我们的数据,就能确定我们想要的,比如某种具有上升趋势的准周期函数。相反地,给定一个足够复杂的参数化回归模型和相同的数据,如果没有一些数值优化程序,我们可能无法事先确定合理的参数值来拟合数据。尽管推理我们想要产生的函数类型可能更容易,但在实践中直接产生这些函数却是具有挑战性的,我们的努力反而集中在学习参数上。 虽然从函数空间的角度提供了与我们旨在建模的数据更直接的联系,而不是参数空间的视角,但它也引入了许多新的和令人兴奋的挑战。尽管高斯过程(GPs)提供了一种建模函数的方法,甚至在函数空间中进行贝叶斯推理,但用于考虑GP模型本身的不确定性的方法是有限的。例如,在核学习中,我们可能希望对一系列核的分布进行边缘化,其中每个核可能产生不同类型的函数。通过对核本身设置函数空间先验,我们能够对我们的GP模型产生的函数类型提供不确定性,而不仅仅是对函数本身。 另一个直接处理函数空间的日益增长的兴趣领域是神经网络中的等变性和不变性。例如,如果我们寻求建模一个对旋转不变或仅对一部分旋转不变的函数,这意味着我们的预测不应随输入的旋转而改变,那么我们可能会旨在学习一个分布,反映我们期望我们的函数对其不变的旋转范围。通过对变换进行简单的分布假设,我们使模型能够学习对正确变换的近似不变性,以及这些变换的正确数量。 这篇论文由三部分组成,每部分都关注于函数空间建模的一个独特组成部分,重点是高斯过程模型或神经网络。在第2章中,我们讨论了在高斯过程模型中形成协方差函数分布的方法。首先是从谱表示的角度,通过使用一个潜在的GP对核函数的傅里叶变换进行建模,然后是通过随机波动模型,使用一个潜在的GP来模型一个随时间变化的波动性术语。 在第3章中,我们引入了在神经网络中构建对称性分布的方法。我们首先研究对有限范围的变换的近似对称性,例如仅对一部分旋转的不变性。然后我们研究学习仅近似满足的对称性分布,例如在物理系统中,关于某一轴的反射可能几乎但不完全保持能量和动量等量。 最后,在第4章中,我们探讨了神经网络中参数空间和函数空间之间的联系。我们通过描述在神经网络中聚合和集成训练解决方案集合的一般方法来结束。这种方法围绕着我们无法直接解决像对称性这样的函数空间量的情况,而希望集成多样化的函数集合的案例。在我们无法有效测量功能多样性的情况下,我们依靠损失表面推理来收集多样化的参数集,作为收集多样化函数的代理。 总体而言,这些方法反映了从函数空间的角度进行建模的力量,或者从一个能够建立我们的模型中的参数与它们产生的函数之间联系的视角。