在2023年的「百模大战」中,众多实践者推出了各类模型,这些模型有的是原创的,有的是针对开源模型进行微调的;有些是通用的,有些则是行业特定的。如何能合理地评价这些模型的能力,成为关键问题。

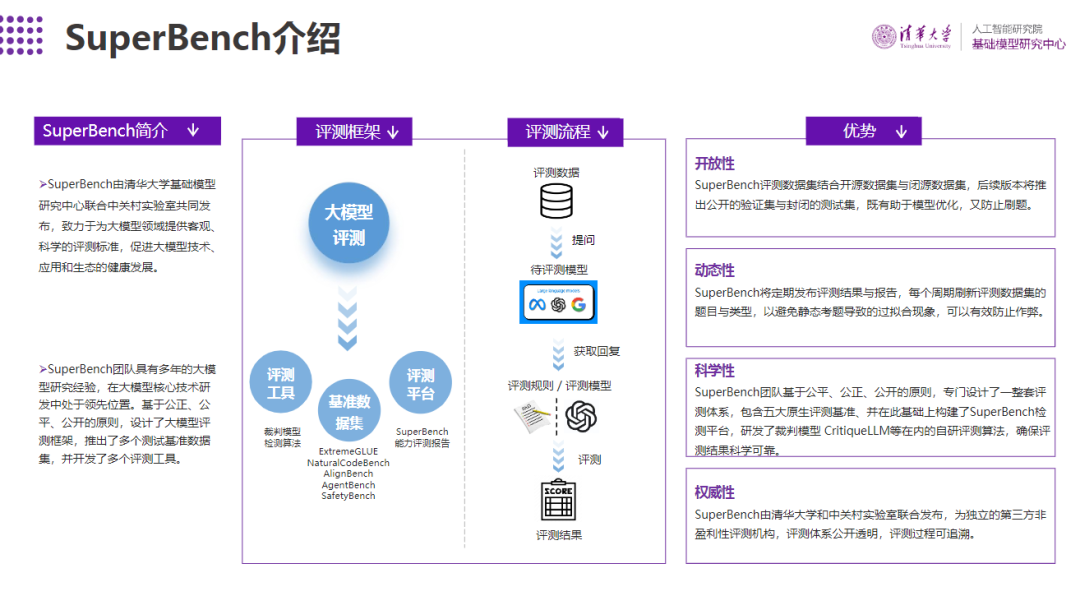

尽管国内外存在多个模型能力评测榜单,但它们的质量参差不齐,排名差异显著,这主要是因为评测数据和测试方法尚不成熟和科学。我们认为,好的评测方法应当具备开放性、动态性、科学性和权威性。

为提供客观、科学的评测标准,清华大学基础模型研究中心联合中关村实验室研制了SuperBench大模型综合能力评测框架,旨在推动大模型技术、应用和生态的健康发展。

最近,2024年3月版《SuperBench大模型综合能力评测报告》正式发布。

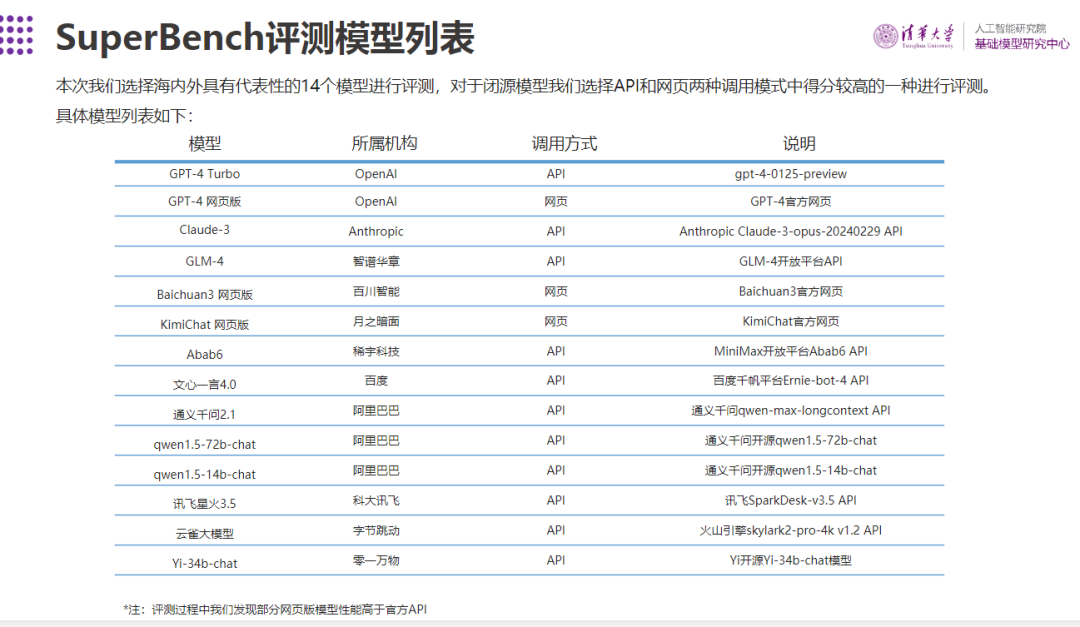

评测共包含了14个海内外具有代表性的模型。其中,对于闭源模型,选取API和网页两种调用模式中得分较高的一种进行评测。

根据评测结果,可以得出以下几个主要结论:

● 整体来说,GPT-4系列模型和Claude-3等国外模型在多个能力上依然处于领先地位,国内头部大模型GLM-4和文心一言4.0表现亮眼,与国际一流模型水平接近,且差距已经逐渐缩小。

● 国外大模型中,GPT-4系列模型表现稳定,Claude-3也展现了较强的综合实力,在语义理解和作为智能体两项能力评测中更是获得了榜首,跻身国际一流模型。

● 国内大模型中,GLM-4和文心一言4.0在本次评测中表现最好,为国内头部模型;通义千问2.1、Abab6、moonshot网页版以及qwen1.5-72b-chat紧随其后,在部分能力评测中亦有不俗表现;但是国内大模型对比国际一流模型在代码编写、作为智能体两个能力上依然有较大差距,国内模型仍需努力。

https://cloud.tsinghua.edu.cn/f/47717c3407bb4d279e0c/