2025年的IJCAI(International Joint Conference on Artificial Intelligence) 将于8月16日至8月22日在加拿大蒙特利尔召开。IJCAI是中国计算机学会推荐的A类国际学术会议,是人工智能领域最具权威性和影响力的学术会议之一。本次IJCAI 2025一共有5404篇投稿,录用1042篇,录用率19.3%。

还在思考如何设计图异常检测方法,不知从何入手?欢迎关注来自新加坡管理大学,伊利诺伊大学香槟分校,等单位的研究人员给出的《深度图异常检测》教程!无论你是研究者、工程师,还是学生,本教程都将帮助你掌握图异常检测的基础与前沿。

教程链接:https://sites.google.com/view/ijcai-tutorial-on-ad/home

概述

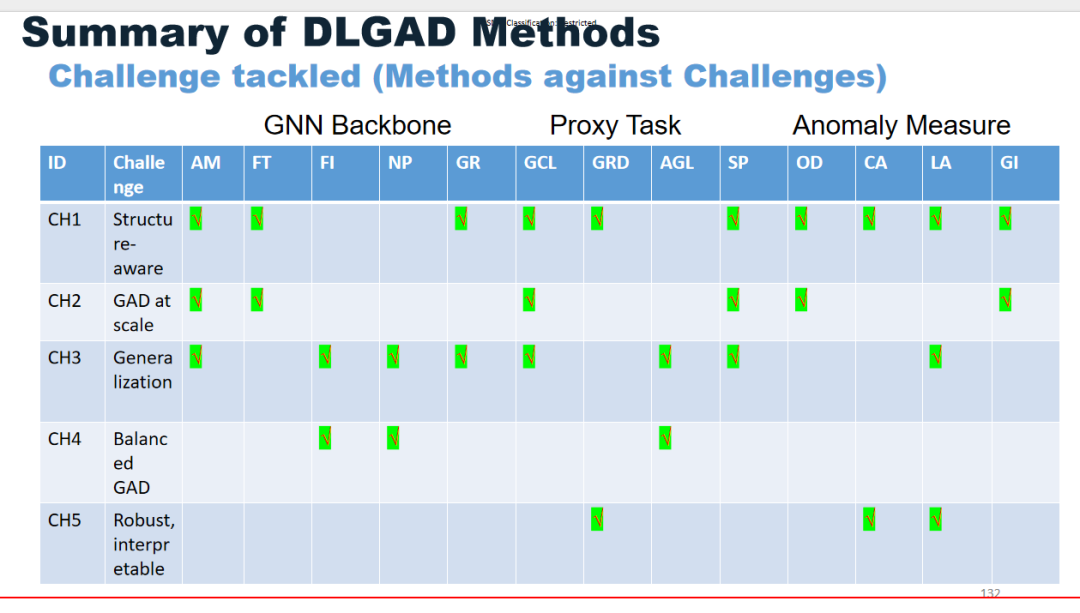

深度学习图异常检测(DLGAD)旨在识别图中的稀有观测点,近年来因其在多个应用领域的重要性而受到快速关注,例如在线购物应用中的虚假评论检测和恶意行为检测、网络攻击检测、以及线上/线下金融服务中的可疑活动检测。然而,由于图结构的复杂性,传统在欧几里得数据上运行的异常检测方法无法直接应用于图数据,而简单地采用图神经网络(GNN)可能会导致过度平滑,使得正常节点与异常节点(或图)的表示难以区分,这在很大程度上限制了其在真实场景中的应用。 在本次教程中,我们旨在系统性地介绍专门为图异常检测设计的深度学习方法。具体来说,我们将首先阐述 DLGAD 的关键概念与分类体系;随后从多种方法论设计角度回顾当前主流的深度异常检测方法,包括 GNN 主干设计、代理任务设计以及异常度量方法;最后,我们将探讨未来的研究方向,帮助研究者深入理解该领域,并推动更多高质量的研究和真实应用的落地。 总体而言,通过本次教程,受众将能够系统性地了解该领域,并掌握不同类别的前沿 DLGAD 方法的核心直觉、基本假设、目标函数、优点与不足。

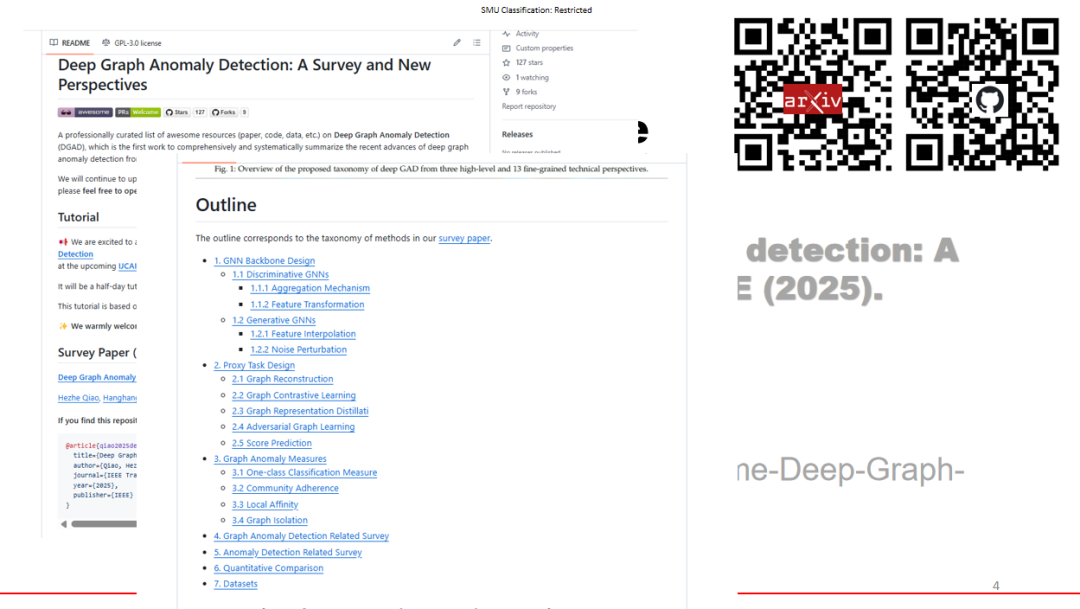

教程大纲

本教程的时长为半天(3.5小时)

**开场部分(30分钟)

**我们将首先介绍 DLGAD,然后展示该领域现有的问题与挑战。同时,我们还将介绍一些图异常检测在实际中取得成功的关键应用案例。

DLGAD 简介 * DLGAD 的问题与挑战 * DLGAD 的应用

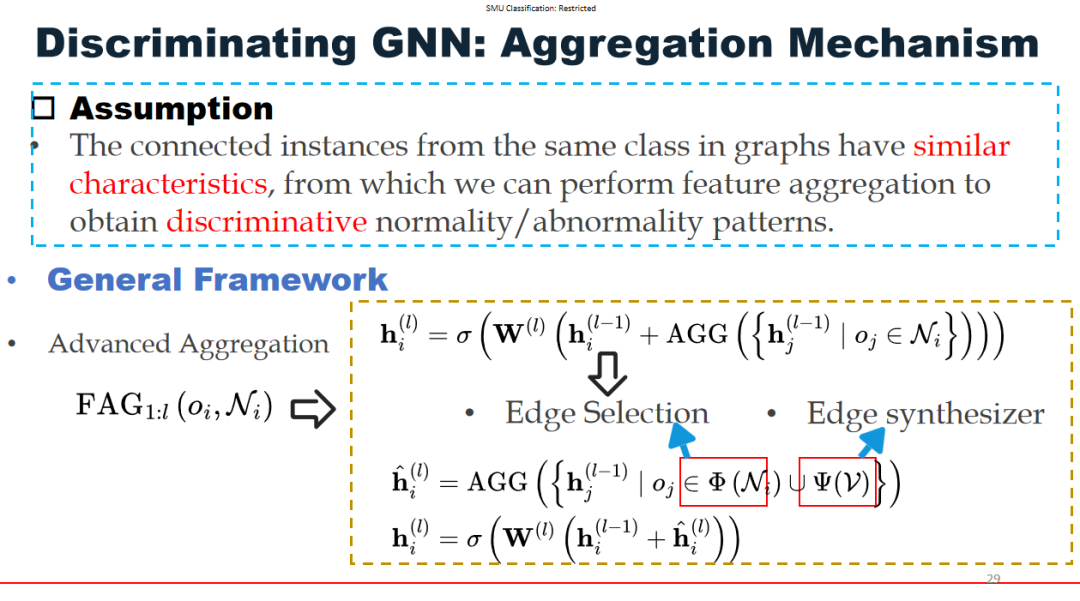

**GNN 主干设计 (60 分钟)

**在这一部分中,我们总结了现有的主流图深度学习模型如何能够被直接利用来提取低维特征表示,以用于后续的异常检测。我们还重点介绍了一些特殊技术,例如处理图的异质性、建模图谱结构、减少标签不平衡等,这些技术已被应用于设计具备更强图异常检测能力的 GNN 模型。

判别式 GNN 方法 * 生成式 GNN 方法

**代理任务设计(30分钟)

**我们将总结通过优化一系列精心设计的学习目标函数(称为代理任务)来训练深度图异常检测的模型。这些代理任务能够引导深度模型捕获多样化的图异常模式,例如图重建、图对比学习以及对抗式图学习。

- 图重建

- 图对比学习

- 图表示蒸馏

- 对抗式图学习

- 分数预测

**图异常度量 (30 分钟)

**我们介绍了一组基于专门为深度图异常检测设计的异常度量来构建模型的方法,例如单类度量、社区依附性和局部节点亲和力。我们将详细回顾这一类方法中各自异常度量的核心直觉和目标函数。

单类分类度量 * 社区依附性 * 基于局部节点亲和力的异常度量 * 图隔离

**

总结部分 (30 分钟)

**本节对该领域的发展进行了总结,并讨论了未来重要的研究机遇。

DLGAD 的进展总结 * DLGAD 的未来研究机遇

******

******

******