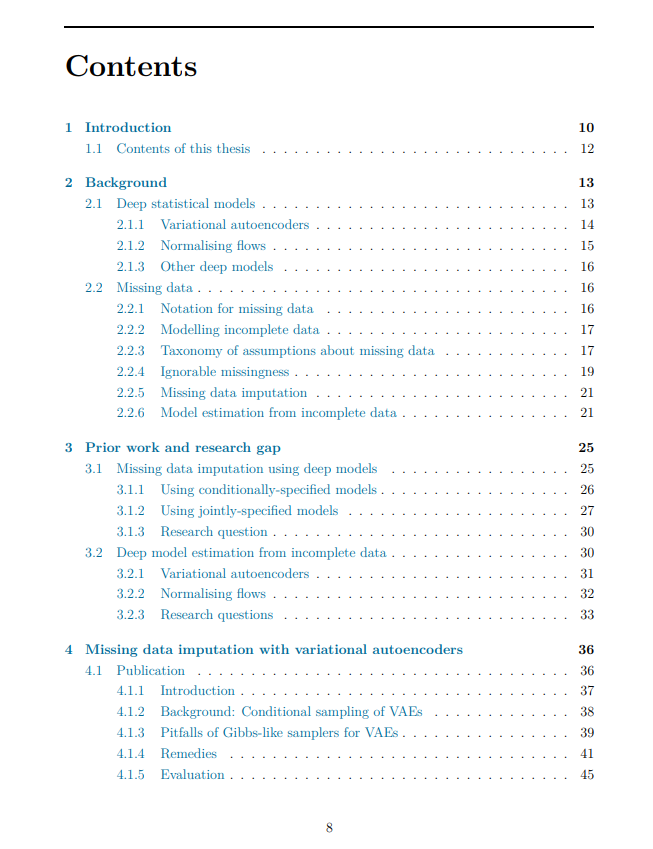

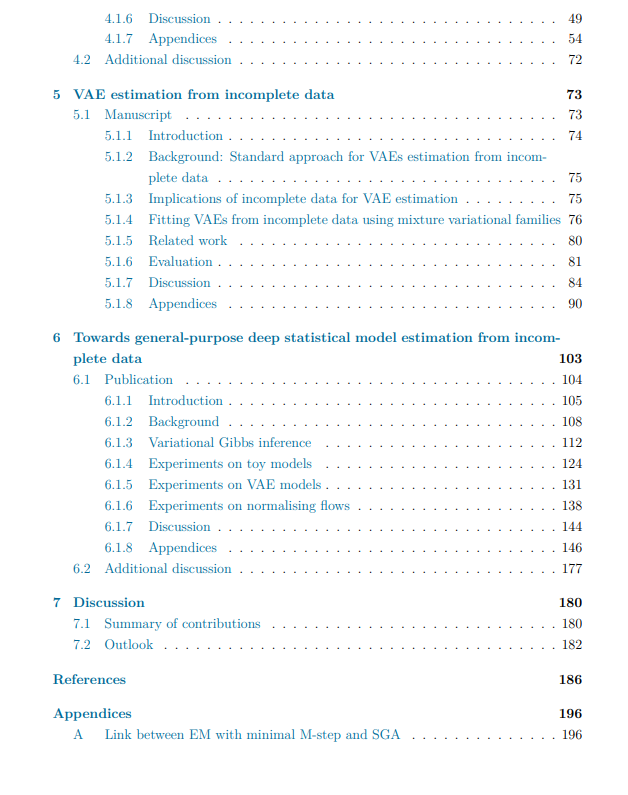

深度统计模型的进展重新定义了现代数据驱动应用,在各个领域展现了显著的经验成功。然而,虽然一些领域受益于大量干净且完全观测的数据,使得实践者能够充分发挥深度模型的优势,但其他领域通常面临着不完整数据的问题,这阻碍了这些强大模型的有效应用。在本论文中,我们旨在研究并解决由缺失数据引起的重要挑战,这些挑战妨碍了深度模型的使用,重点关注两个关键统计任务:从不完整训练数据集中进行参数估计和缺失数据填补。首先,我们探讨了使用预训练模型进行缺失数据填补的问题,重点关注变分自编码器(VAE)类的深度统计模型。我们的探索揭示了现有的 VAE 条件采样方法的局限性,识别了与常见的 VAE 学习特性相关的陷阱,这些陷阱在某些场景中妨碍了方法的性能。为了解决这些问题,我们提出了基于马尔科夫链蒙特卡洛和重要性采样的两种新方法。我们的评估表明,所提出的方法在不同数据集上改进了使用预训练 VAE 进行的缺失数据填补。随后,我们将注意力转向了从不完整训练数据集中估计 VAE 的问题。尽管这一领域在文献中得到了相当大的关注,但我们报告了由缺失数据引起的一个之前未知的现象,该现象妨碍了 VAE 的有效拟合。为了克服这些不利影响并改进从不完整数据中估计 VAE,我们引入了基于变分混合分布的两种策略,这些策略在计算效率、模型精度和学习到的潜在结构之间进行权衡。我们展示了与不使用变分混合的现有方法相比,所提出的方法在不完整数据下改善了 VAE 的估计效果。扩展到估计一般统计模型的更广泛挑战时,我们观察到不同类别的深度模型在进展上存在不平衡。为了推动所有深度统计模型的采用,我们引入了变分吉布斯推断(VGI),这是一种通用方法,用于最大似然估计具有可处理似然函数的一般统计模型。我们表明,该方法能够从不完整数据中进行精确的模型估计,包括 VAE 和归一化流。值得注意的是,VGI 是当前文献中少数几种具有概率原理的方法之一,能够从不完整数据中进行归一化流的估计,且达到了最先进的性能。通过提供一个统一的框架来处理模型估计中的缺失数据,VGI 为在面临缺失数据的各个领域中充分发挥深度统计模型的潜力铺平了道路。