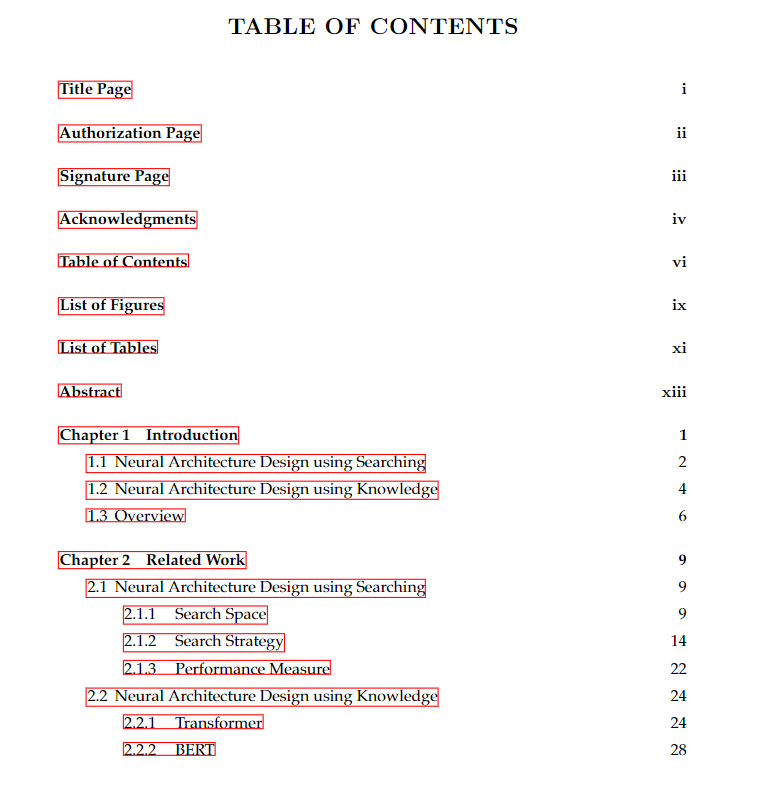

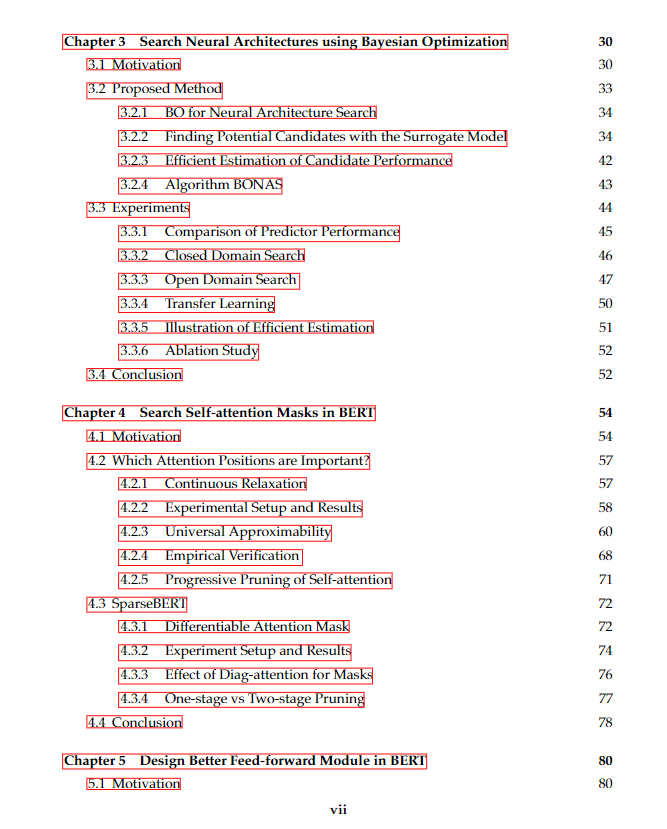

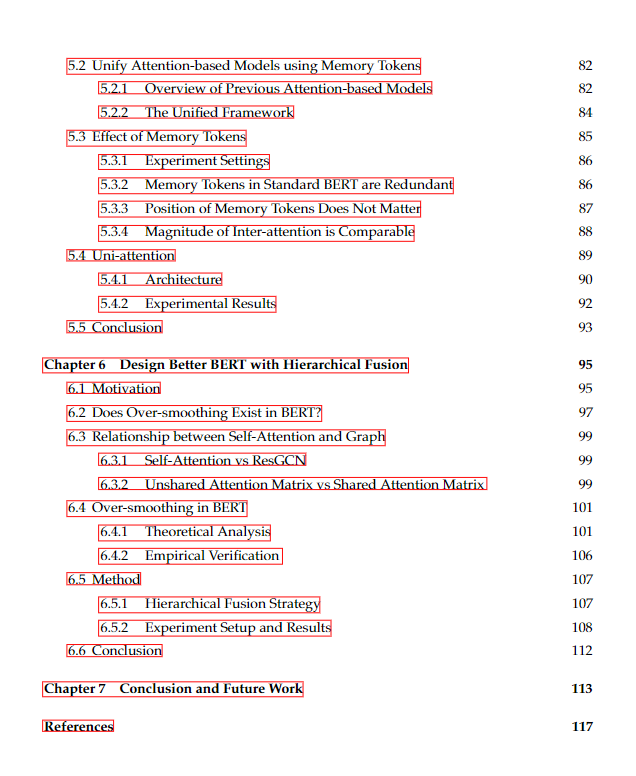

由于深度学习在计算机视觉和自然语言处理等各种任务中的显著能力,它已成为机器学习领域的一个里程碑。神经网络的结构对性能有显著影响,因此确定神经网络的结构非常重要。通常,神经架构设计的方法可以分为两类。一类是利用搜索方法设计神经结构,目的是自动实现潜在的神经结构。例如,NASNet架构是在使用强化学习算法定义的搜索空间中找到的。另一类是基于领域知识手工设计神经体系结构。大多数实用的体系结构,如ResNet和Transformer都是基于先验知识提出的。在本文中,我们从以上两个角度对神经架构设计进行了全面的讨论。

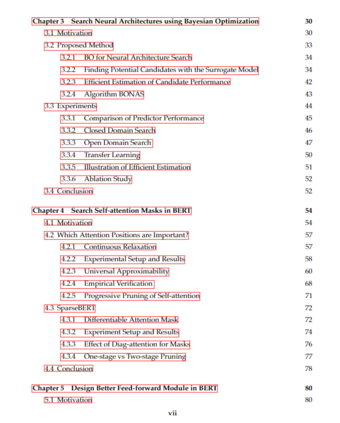

首先,我们介绍了一种基于贝叶斯优化的神经结构搜索算法BONAS。在搜索阶段,GCN嵌入提取器和贝叶斯sigmoid回归器构成贝叶斯优化的代理模型,并根据采集函数选择搜索空间中的候选架构。在查询阶段,我们将它们合并为一个超级网络,并通过权值共享机制对各个体系结构进行评估。提出的BONAS可以获得开发与勘探平衡的重要体系结构。

其次,针对著名的Transformer中的自注意力模块,提出了一种可微架构搜索方法来查找重要的注意力模式。与以往的研究不同,我们发现注意力地图中的对角线元素可以在不影响性能的情况下被丢弃。为了理解这一观察结果,我们从普遍近似的角度提供了理论证明。基于所提出的搜索方法,实现了一系列用于高效架构设计的注意力掩码。

第三,我们试图从一个统一的框架来理解Transformer中的前馈模块。具体来说,我们引入了记忆标记的概念,并建立了前馈和自注意力之间的关系。在此基础上,我们提出了一种新的结构——单注意力,它包含了所有四种类型的注意力连接。在给定相同数量的内存令牌的情况下,与以前的基线相比,Uni-attention实现了更好的性能。

最后,我们研究了整个Transformer体系结构中的过平滑现象。我们通过建立自注意力与图域之间的关系来进行理论分析。具体而言,我们发现层归一化在过平滑问题中起着重要作用,并通过经验验证了这一点。为了缓解这个问题,我们提出了分层融合体系结构,这样输出可以更加多样化。