在人工智能(Al)和机器学习(ML)的高节奏、高风险的军事应用中,操作人员需要迅速了解他们的AI/ML辅助工具的优势和局限性,以便人类+AI团队的组合能够提供决策优势。随着AI智能体变得越来越复杂,操作员需要这些先进系统的透明度,就像为他们的人类合作者建立心理模型的能力,以最终判断他们的适当使用。

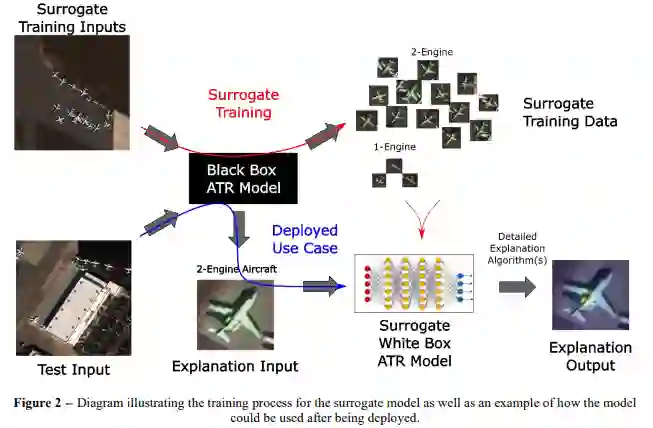

要让不是计算机或数据科学家,也没有时间或工具来理解AI系统的内部运作的人类能够解释人工智能,一个关键的挑战是将机器推理的隐藏层映射到人类可以解释的语义中,以获得对AI建议的更多了解,这样操作者就可以对AI的结果更有信心,或者知道何时推翻它。为了解决将机器生成的解释的语义与人的解释相一致的挑战,我们首先描述了创建一个代用的白盒方法作,随后描述了语义一致方法概念。我们描述了一个自动目标识别(ATR)的用例,并说明了为什么目前的解释器方法不足以实现机器的透明度,并讨论了研究需求。

成为VIP会员查看完整内容

相关内容

Arxiv

42+阅读 · 2023年4月19日