机器学习的爆炸性增长使其在人工智能时代成为关键基础设施。数据的广泛使用对个人隐私构成了重大威胁。各国已实施了相应的法律,如GDPR,以保护个人数据隐私和被遗忘权。这使得机器遗忘在近年来成为隐私保护领域的研究热点,旨在高效地从训练模型中删除个人数据的贡献和影响。学术界对机器遗忘的研究不断丰富其理论基础,提出了许多方法,针对不同的数据删除请求在各种应用场景中进行研究。然而,最近研究人员发现各种机器遗忘方法存在潜在的隐私泄漏问题,使得机器遗忘领域的隐私保护成为一个关键话题。本文提供了现有机器遗忘研究的概述和分析,旨在呈现机器遗忘方法的当前漏洞。我们从定义、实现方法和实际应用等方面分析了隐私风险。与现有综述相比,我们从隐私威胁的角度分析了最新恶意攻击技术对机器遗忘提出的新挑战。我们希望本综述能够为这一新兴领域提供一个初步但全面的讨论。

引言

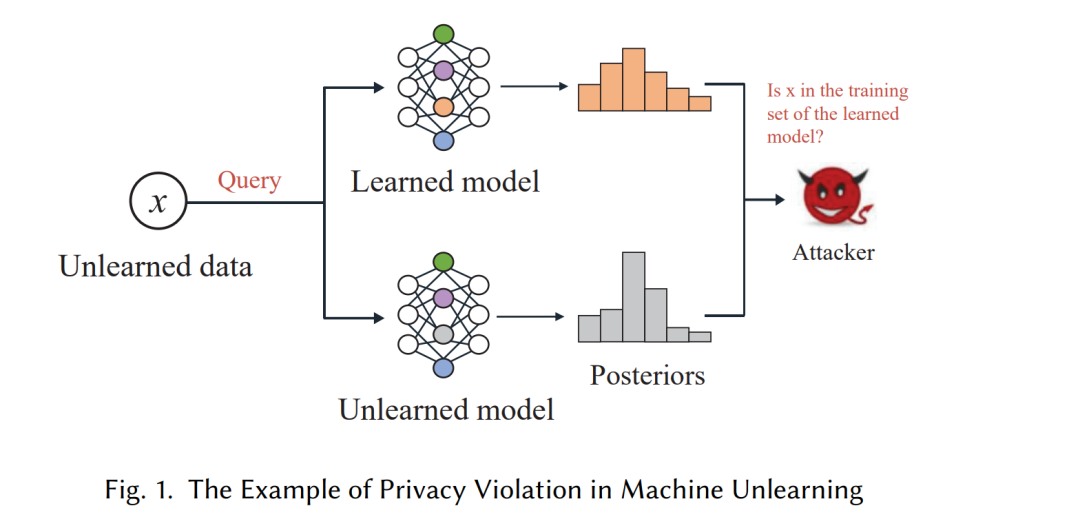

由于机器学习算法的重要作用,大量计算机系统开始持有大量个人数据用于决策和管理。例如,日益显著的ChatGPT积极利用大量数据集进行知识发现【1】。然而,研究表明,机器学习模型可以记住训练数据的信息【2, 3】,引发了对个人隐私潜在攻击的担忧。对抗性攻击,如成员推理攻击【4】和模型反演【5】,已展示了从机器学习模型中提取目标数据的信息的能力。为了应对这些担忧,各国在个人隐私的监管和法律方面取得了重大进展。例如,欧盟实施的《通用数据保护条例》(GDPR)和《加州消费者隐私法》(CCPA)明确规定了被遗忘权。数据所有者有义务及时响应这些删除请求【7】,从而催生了一项新技术:机器遗忘【8】。 机器遗忘是指从机器学习模型中移除数据及其影响的过程。一个直接的方法是从头开始重新训练模型。然而,这可能会导致显著的计算时间和开销,特别是在处理大数据集和复杂结构的模型时。因此,机器学习中的关键挑战是如何在不完全重新训练的情况下减轻必须被遗忘的数据对模型的影响。

大量研究已经针对机器遗忘展开,现有技术主要分为两类:面向数据的遗忘和面向模型的遗忘【9】。面向数据的方法通过修改原始训练集来实现数据删除。例如,Bourtoule等人【10】提出了一种称为SISA的遗忘方法,该方法将训练集划分为几个不相交的子集,并独立训练每个子模型。通过重新训练子模型,可以有效地删除数据。面向模型的方法涉及操作原始模型,如参数,以实现遗忘。例如,Guo等人【11】提出的认证删除机制,旨在抵消被遗忘数据对模型的影响并更新模型参数。

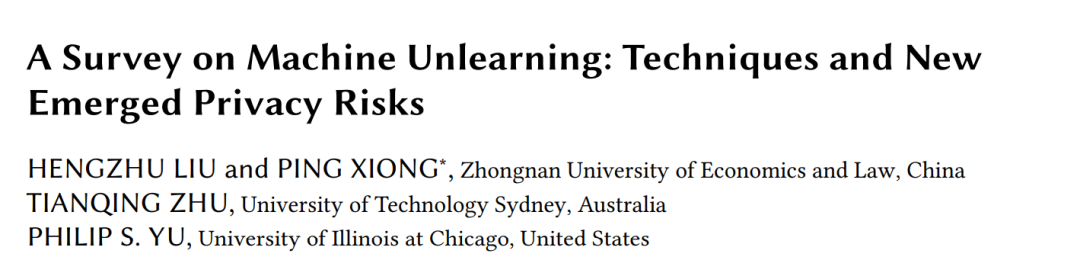

尽管机器遗忘的目标是保护数据隐私,但最近研究人员发现遗忘方案可能会以意想不到的方式危及隐私。这是因为当前大多数机器遗忘方案应用了机器学习算法,从而继承了这些算法的自然弱点或缺陷。Chen等人【12】指出,遗忘前后两个模型输出分布的差异可能导致被遗忘数据的额外信息泄露,这极大地挑战了遗忘算法的设计。例如,在数据驱动的方案中,划分原始训练集可以通过重新训练受影响的子模型来提高效率。通过聚合操作,重新训练的子模型的预测结果会反映在置信向量中,从而导致已学习和已遗忘模型输出的差异,这可能导致暴露关于已遗忘数据的成员信息的隐私违规。当攻击者查询已学习和已遗忘模型时,可以获得已遗忘数据后验概率的差异,并用于确定已遗忘数据是否为已学习模型训练集的成员。此过程如图1所示。 目前尚无明确的机器遗忘隐私风险定义。现有的综述未充分呈现当前机器遗忘方案的隐私问题。利用机器遗忘需要进一步分析和总结,特别是涉及隐私攻击和保护时。因此,我们认为有必要对机器遗忘的隐私问题进行更全面和系统的综述。通过总结和比较当前的遗忘方案,我们可以更深入地了解每种方法的优缺点,并涉及遗忘的性能评估和实际应用,以确定未来的研究方向。这些系列分析可以帮助当前研究人员、模型所有者和数据所有者意识到机器遗忘方案的现有隐私风险,同时警示未来的潜在隐私风险。 除了强调隐私威胁并讨论每种遗忘方案的脆弱性外,我们还提供了带有潜在隐私风险的遗忘方法的明确分类法,并总结了潜在的防御方法以及流行应用中的风险。

本文的贡献如下:

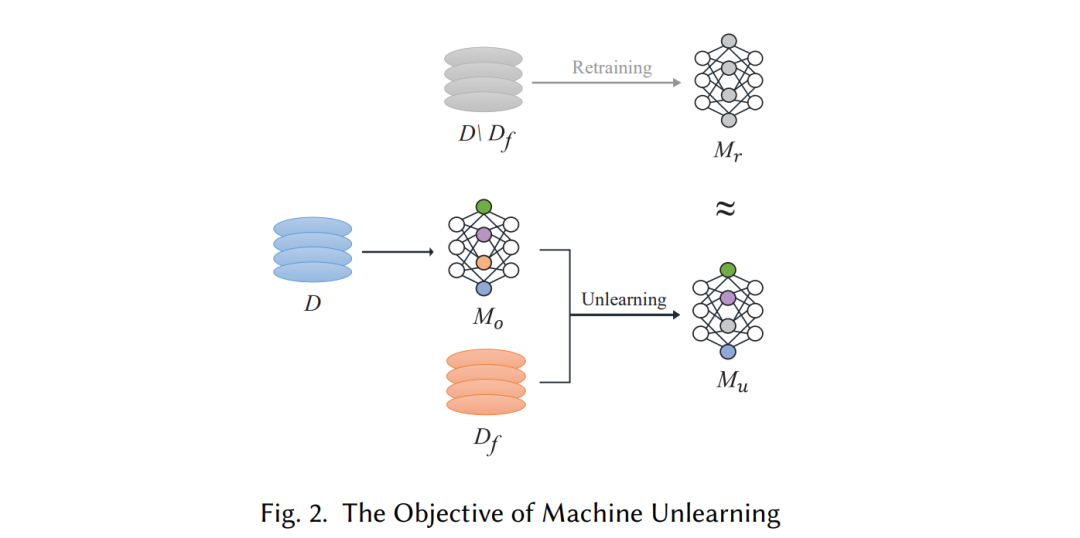

- 我们提出了一种分类法,将当前的机器遗忘方法分为面向数据和面向模型的技术。

- 我们基于攻击方案仔细分析了遗忘中的隐私风险,并突出了不同遗忘技术的脆弱性。为应对这些隐私违规,我们提出了可能的防御方法。

- 我们回顾了机器遗忘的应用和潜在的隐私问题。此外,我们讨论了当前的研究趋势和主要问题,并确定了潜在的未来方向。

机器遗忘技术

基于修正目标,我们将机器遗忘方法分为面向数据和面向模型的技术。前者是指操作训练集的遗忘方法,包括数据划分和数据修改;而后者是指修改原始模型的遗忘方法,包括模型重置和模型修改。图3总结了机器遗忘技术的分类。

### 2.3.1 面向数据的技术

面向数据的技术是指数据持有者通过操作原始训练集 (D) 来删除被遗忘的数据,主要包括两种处理策略,即数据划分和数据修改。 数据划分:在数据划分中,数据持有者将原始训练集划分为若干子集,并在每个子集上训练相应的子模型。然后,这些子模型通过聚合函数来汇总预测结果。当收到遗忘请求时,数据持有者从包含被遗忘数据的子集中删除这些数据并重新训练相应的子模型。 数据修改:在数据修改中,数据持有者通过添加噪声或新转换的数据 (D_T) 来修改训练集 (D),例如使用转换数据 (D_T) 替换被遗忘数据 (D_f),即 (D' = D_r \cup D_T)。例如,Cao等人【8】将训练集转换为易于计算的求和形式,使得遗忘过程只需更新受 (D_f) 影响的求和部分。这种方法可以简化重新训练并加快遗忘过程。

### 2.3.2 面向模型的技术

面向模型的技术是指数据持有者通过修改原始模型 (M_o) 来完成遗忘的方法。这种技术可以分为模型重置和模型修改。 模型重置:在模型重置中,数据持有者直接更新模型参数以消除被遗忘数据 (D_f) 对模型 (M_o) 的影响,即 (w_u = w_o + \sigma),其中 (w_o) 和 (\sigma) 分别是模型 (M_o) 的参数和更新值。Guo等人【11】提出的认证删除机制是模型重置的基本形式。其基本思想是计算 (D_f) 对模型的影响并更新相应的参数。但这些方法通常会增加计算成本,特别是对于结构复杂的模型。 模型修改:在模型修改中,数据持有者用计算得出的参数替换 (D_f) 的相关参数,以从原始模型 (M_o) 中移除 (D_f),即 (w_u = w_o \cup w_{cal}),其中 (w_{cal}) 是用于替换的计算参数。以Brophy等人【13】提出的遗忘方法为例。这类方法通常适用于具有简单结构的机器学习模型和深度学习模型,如随机森林,因为它们需要预先计算的参数。