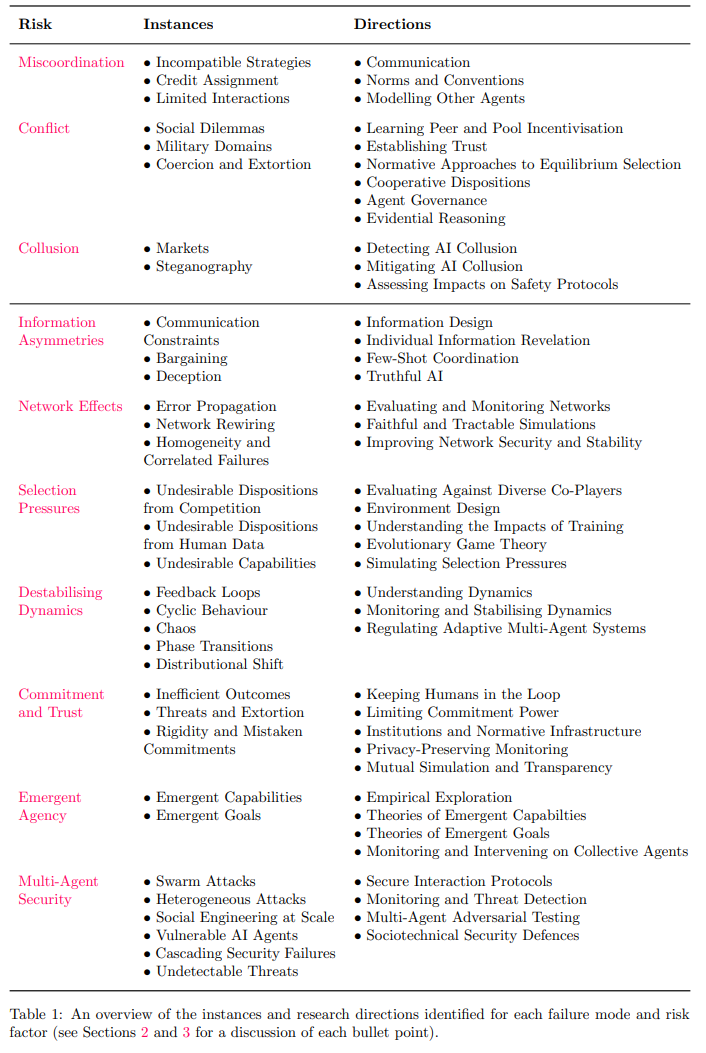

先进AI智能体的快速发展及其规模化部署,将催生复杂度前所未有的多智能体系统。此类系统会引发新型且未被充分认知的风险。本报告通过分析智能体的激励机制,提出三大核心故障模式(协调失灵、冲突与共谋),并揭示支撑这些风险的七大关键因素:

- 信息不对称

- 网络效应

- 选择压力

- 失稳动态

- 承诺问题

- 突现能动性

- 多智能体安全性

报告详述了每类风险的典型场景及可行的缓解方向。通过结合现实案例与实验证据,阐明多智能体系统对AI安全、治理与伦理带来的独特挑战。

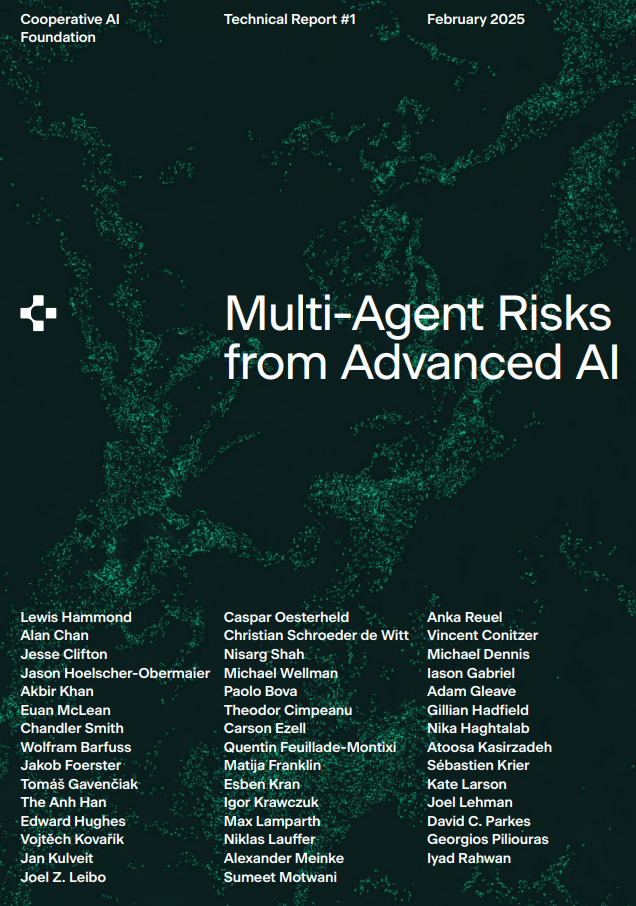

高级AI带来的多智能体风险

日益先进的人工智能(AI)的普及不仅带来广泛效益,也催生了新的风险(Bengio et al., 2024; Chan et al., 2023)。当前,AI系统已开始自主交互并动态调整行为,形成多智能体系统。这一转变得益于以下驱动因素:复杂模型的广泛应用(支持跨模态交互,如文本、图像、音频)以及自主适应型智能体的竞争优势(Anthropic, 2024a; Google DeepMind, 2024; OpenAI, 2025)。

尽管仍属少数,高级AI群体已承担起从百万美元级资产交易(AmplifyETFs, 2025; Ferreira et al., 2021; Sun et al., 2023a)到战场指挥官行动建议(Black et al., 2024; Manson, 2024; Palantir, 2025)等关键任务。未来,其应用将不仅限于经济与军事领域,还将延伸至能源管理、交通网络等关键基础设施(Camacho et al., 2024; Mayorkas, 2024)。大量AI智能体也将以个人助手或代理身份融入社会生活,承担日益复杂的重任。

尽管这些系统为规模化自动化与社会普惠带来机遇,但其引发的多智能体特有风险——迥异于单体AI或传统技术——仍被系统性低估与研究不足。这种忽视既因现有系统多局限于受控环境(如自动化仓库),也因单体AI本身存在诸多未解难题(Amodei et al., 2016; Anwar et al., 2024; Hendrycks et al., 2021)。鉴于技术发展速度,亟需评估与应对多智能体风险。本报告提出三大行动方向:

• 评估(Evaluation)

当前AI系统多孤立开发测试,但实际将面临复杂交互。需建立新评估体系:

- 模型能力检测:合作倾向、偏见与漏洞分析

- 多环境危险能力测试:操纵、共谋、安全机制突破

- 开放式动态仿真:研究演化压力与突现行为

- 虚实映射验证:确保测试结果反映真实部署

• 缓解(Mitigation)

需技术创新支撑风险防控:

- 激励对齐扩展:前沿模型的同伴激励机制

- 安全交互协议:可信智能体通信框架

- 信息设计应用:利用AI透明性优势

- 动态网络稳定:抗对抗攻击的鲁棒架构

• 协作(Collaboration)

多主体风险需跨领域协同:

- 复杂系统研究:借鉴复杂适应系统失效机制

- 责任界定创新:非单点故障的归责体系

- 高风险场景经验:金融市场等现有监管案例

- 安全脆弱性分析:系统性攻防能力评估

为支持上述建议,我们提出多智能体环境下新型、更复杂或性质迥异的AI风险分类,并初步评估缓解措施。基于智能体目标与系统预期行为,定义三大故障模式:协调失灵(目标错位)、冲突(资源争夺)与共谋(损害全局)。进一步识别七大风险因素:信息不对称、网络效应、选择压力、失稳动态、承诺与信任缺失、突现能动性及多智能体安全性。每类问题均附定义、典型案例、实证研究与未来方向。最后,探讨其对AI安全、治理与伦理的深远影响。