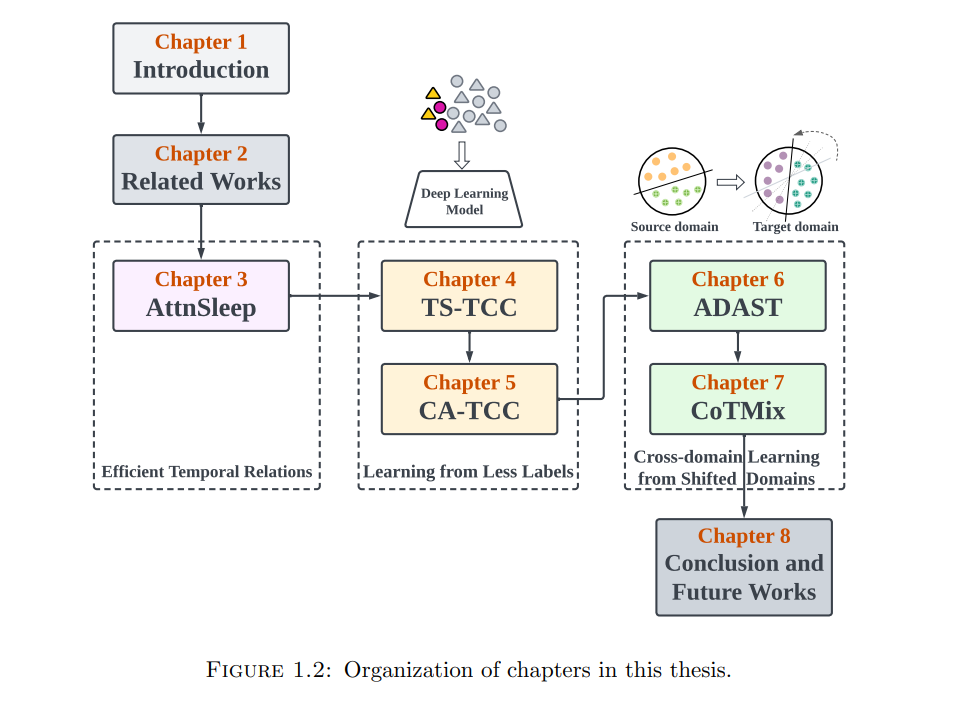

时间序列数据是从不同应用的各种源头随时间收集的顺序测量数据,例如,医疗保健和制造业。随着这些应用产生的时间序列数据量的增加,对它们的分析变得越来越重要以获得洞见。深度学习已经展现出在从大量数据中自动学习的潜力和能力,通过直接从数据中识别复杂模式和表示。然而,当前基于深度学习的模型存在显著的局限性。首先,它们缺乏在利用并行处理的同时有效学习时间序列的时间关系的能力。其次,这些模型需要大量的标签数据进行训练,这在面对复杂的时间序列数据时可能难以获得。第三,这些模型的泛化能力有限,当从一个有标签的源域转移到一个分布外的无标签目标域时,它们的性能会下降。在这篇论文中,我们解决了这些问题,并为时间序列数据的深度学习模型的现实世界部署提供了解决方案。我们首先提出了一个名为AttnSleep的新颖的基于注意力的深度学习架构,用以分类基于EEG的睡眠阶段,这是常见的时间序列医疗保健数据类型之一。具体来说,我们提出了一个强大的特征提取器,它能够学习EEG信号中不同频带的信息。我们还提出了一个时间上下文编码模块,使用因果多头注意力机制学习提取特征之间的时间依赖性。最后,我们开发了一个针对睡眠数据类别不平衡问题的类别感知损失函数,而不增加任何额外的计算成本。接下来,我们提出了两个框架来解决不同设置中的标签稀缺问题。第一个框架,TS-TCC,是一种自监督学习方法,它从无标签数据中学习有用的表示。TS-TCC利用特定于时间序列的增强来为每个样本生成两个视图。然后我们通过一个新颖的跨视图时间预测任务学习时间表示。此外,我们提出了一个上下文对比模块,进一步学习判别性表示。第二个框架,CA-TCC,在半监督设置中改进了TS-TCC学到的表示,通过四个阶段训练模型。首先,我们使用TS-TCC进行自监督训练。然后,我们用少量标签样本微调预训练模型。接着,我们使用微调后的模型为无标签集分配伪标签。最后,我们利用这些伪标签实现一个类别感知对比损失,用于半监督训练。这两个框架与传统的监督训练相比,在有少量标签样本的情况下显示出显著的性能提升。最后,我们解决了领域偏移问题,并提出了两个新颖的框架来解决这一问题。在第一个框架中,我们引入了一个名为ADAST的对抗性域适应技术,该技术解决了两个挑战,即在特征提取过程中丢失领域特定信息以及在域对齐过程中忽略目标域中的类别信息。为了克服这些挑战,我们结合了一个非共享注意力机制和一个带有双重不同分类器的迭代自训练策略。在第二个框架中,我们尝试克服对抗性训练的复杂性,并提出了一种名为CoTMix的新颖方法,使用一种简单而有效的对比学习策略来解决领域偏移问题。具体来说,我们提出了一种跨域时间混合策略,以创建源域主导和目标域主导的域。这些域作为源域和目标域在对比学习中的增强视图。与以往的工作不同,CoTMix将源域和目标域映射到一个中间域。这些框架展示了深度学习模型在时间序列数据上的改进鲁棒性。