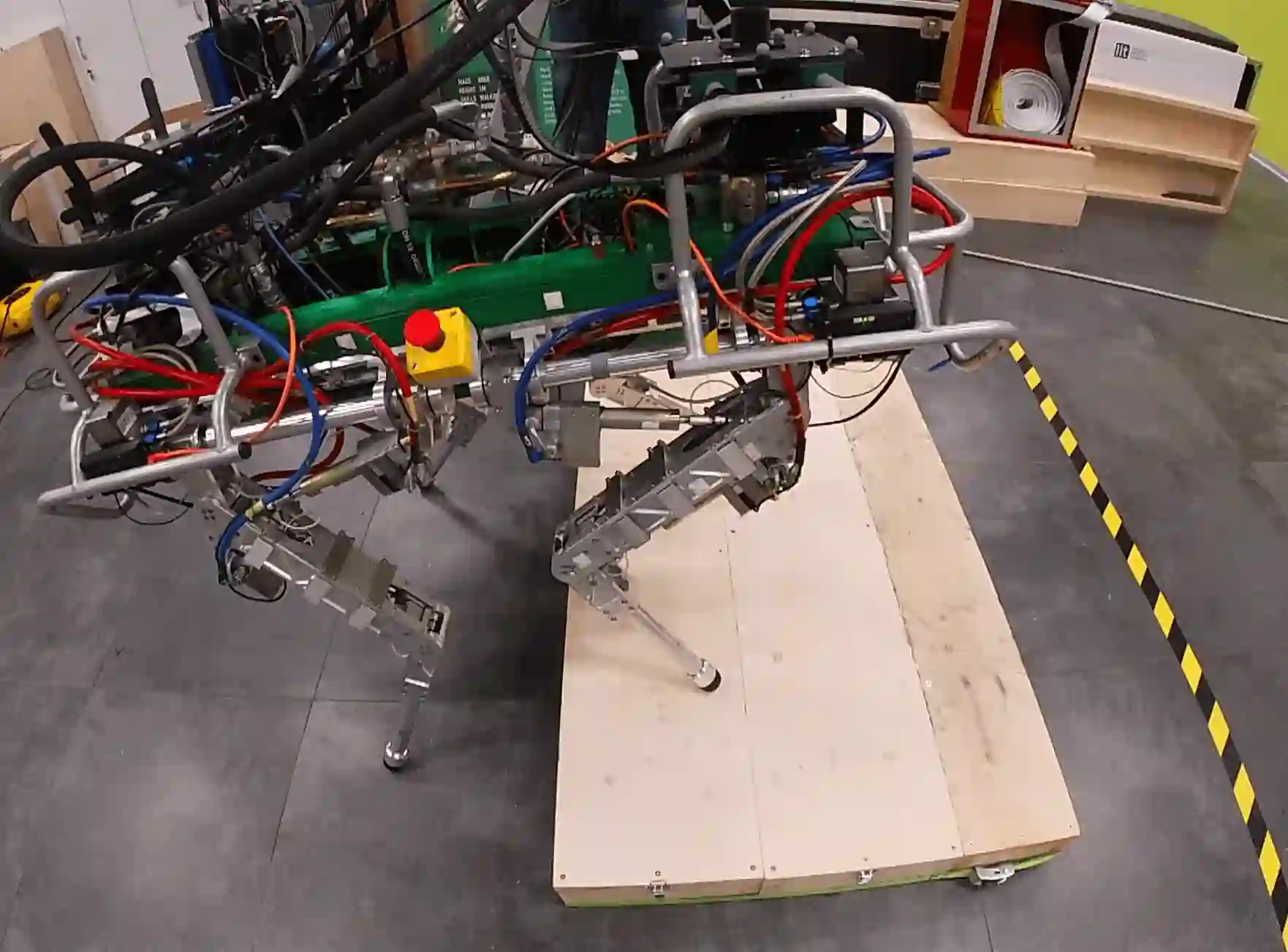

Re-planning in legged locomotion is crucial to track the desired user velocity while adapting to the terrain and rejecting external disturbances. In this work, we propose and test in experiments a real-time Nonlinear Model Predictive Control (NMPC) tailored to a legged robot for achieving dynamic locomotion on a variety of terrains. We introduce a mobility-based criterion to define an NMPC cost that enhances the locomotion of quadruped robots while maximizing leg mobility and improves adaptation to the terrain features. Our NMPC is based on the real-time iteration scheme that allows us to re-plan online at $25\,\mathrm{Hz}$ with a prediction horizon of $2$ seconds. We use the single rigid body dynamic model defined in the center of mass frame in order to increase the computational efficiency. In simulations, the NMPC is tested to traverse a set of pallets of different sizes, to walk into a V-shaped chimney, and to locomote over rough terrain. In real experiments, we demonstrate the effectiveness of our NMPC with the mobility feature that allowed IIT's $87\, \mathrm{kg}$ quadruped robot HyQ to achieve an omni-directional walk on flat terrain, to traverse a static pallet, and to adapt to a repositioned pallet during a walk.

翻译:在这项工作中,我们提出并测试一个实时的在线实时循环计划,让我们能以25美元、\mathrm{Hz}$重订在线计划,预测值为2美元秒。我们采用一个基于流动性的标准来界定NMPC的成本,以提升四重机器人的移动率,同时最大限度地提高腿流动性,改进对地形特征的适应性。我们的NMPC基于实时循环计划,让我们可以重新以25美元、\mathrm{Hz}$重订在线计划,预测值为2美元。我们使用在质量框架中心确定的单一硬体体动态模型,以提高计算效率。在模拟中,NMPC测试可以绕过一套不同尺寸的托盘,走进一个V-形烟味的烟囱,并跨过粗地形。在实际实验中,我们展示了我们NMPC滚动的实效,允许在固定的平面上使用IMTQ的固定式移动率,可以使IIT达到8-MQ。