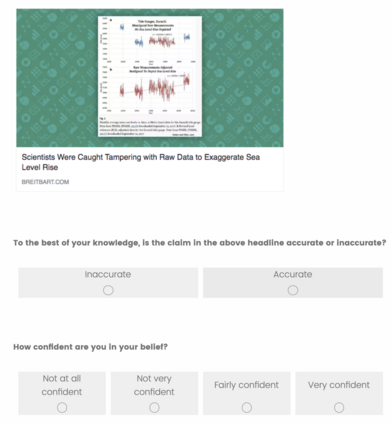

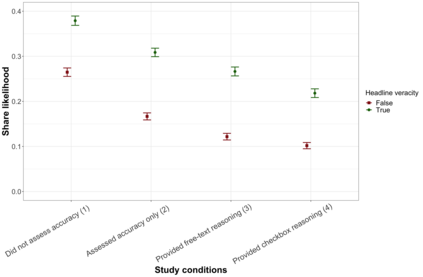

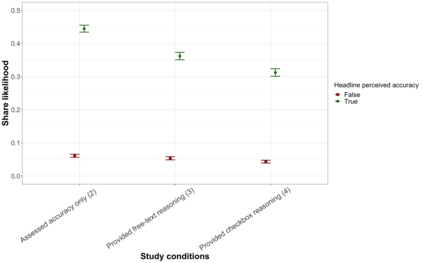

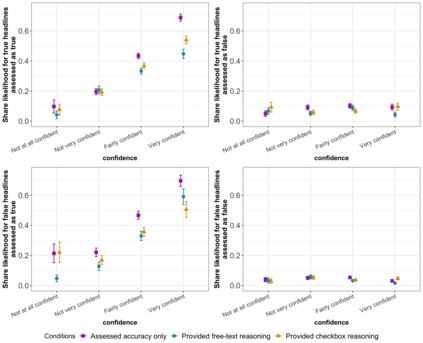

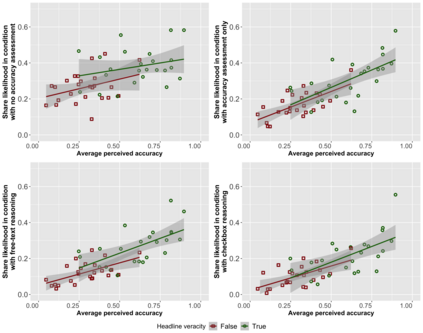

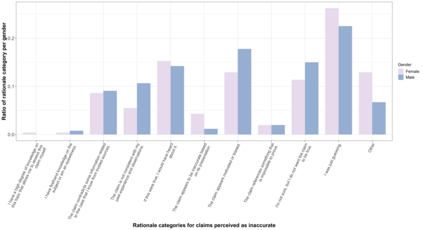

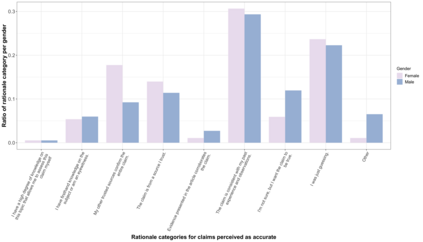

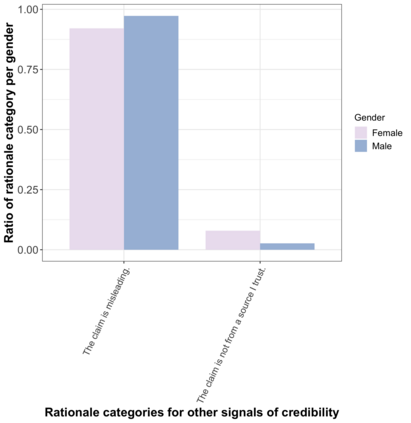

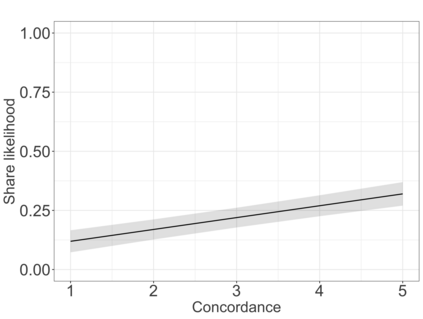

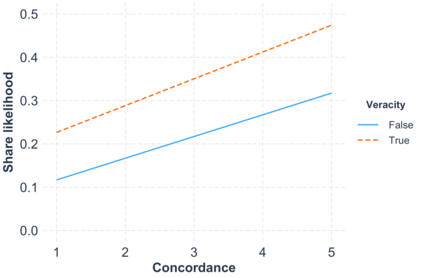

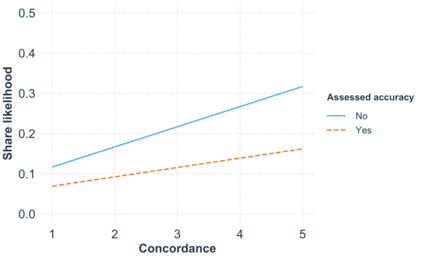

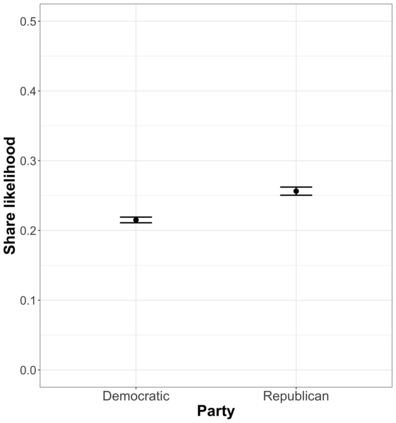

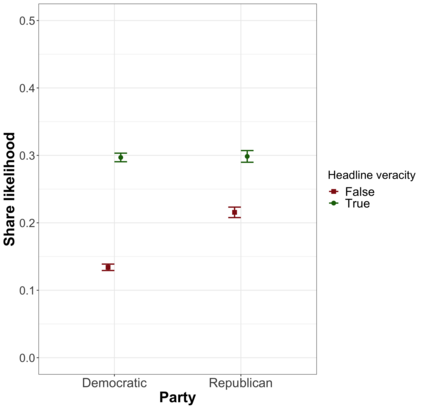

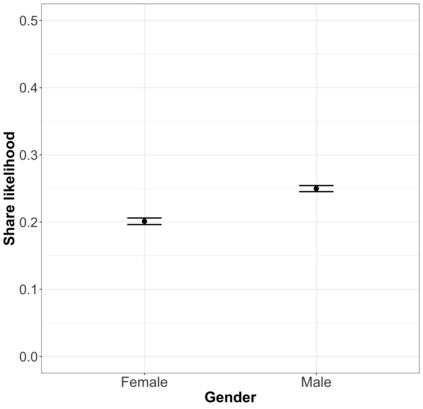

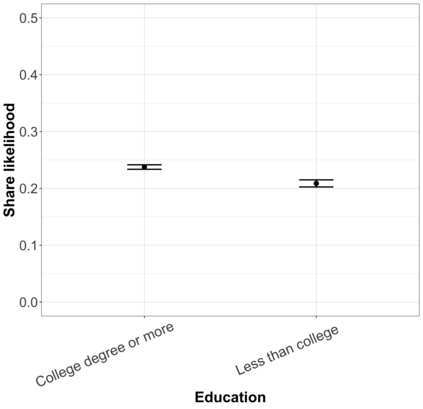

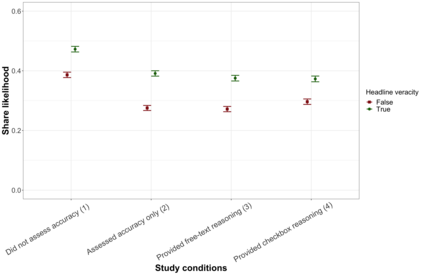

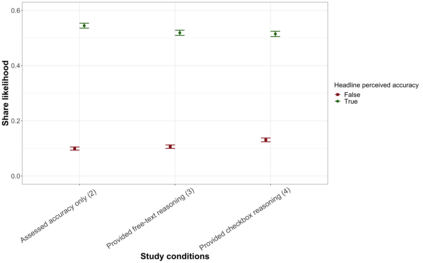

When users on social media share content without considering its veracity, they may unwittingly be spreading misinformation. In this work, we investigate the design of lightweight interventions that nudge users to assess the accuracy of information as they share it. Such assessment may deter users from posting misinformation in the first place, and their assessments may also provide useful guidance to friends aiming to assess those posts themselves. In support of lightweight assessment, we first develop a taxonomy of the reasons why people believe a news claim is or is not true; this taxonomy yields a checklist that can be used at posting time. We conduct evaluations to demonstrate that the checklist is an accurate and comprehensive encapsulation of people's free-response rationales. In a second experiment, we study the effects of three behavioral nudges -- 1) checkboxes indicating whether headings are accurate, 2) tagging reasons (from our taxonomy) that a post is accurate via a checklist and 3) providing free-text rationales for why a headline is or is not accurate -- on people's intention of sharing the headline on social media. From an experiment with 1668 participants, we find that both providing accuracy assessment and rationale reduce the sharing of false content. They also reduce the sharing of true content, but to a lesser degree that yields an overall decrease in the fraction of shared content that is false. Our findings have implications for designing social media and news sharing platforms that draw from richer signals of content credibility contributed by users. In addition, our validated taxonomy can be used by platforms and researchers as a way to gather rationales in an easier fashion than free-response.

翻译:当社交媒体的用户在不考虑其真实性的情况下分享内容时,他们可能无意中传播错误信息。在这项工作中,我们调查了轻度干预的设计,以迫使用户评估信息是否准确而共享信息。这种评估可能首先阻止用户发布错误信息,而他们的评估也可能为朋友提供有益的指导,以便评估这些职位本身。为了支持轻度评估,我们首先对人们认为新闻主张是否真实的原因进行分类分析;这一分类产生一份清单,可以在发布时使用。我们进行评估,以证明清单准确和全面地概括了人们的自由反应依据。在第二次试验中,我们研究了三种行为判断的效果 -- -- 1) 检查框显示标题是否准确;2) 标记了(我们分类学)一个职位是否准确的原因,3)为人们相信新闻主张是否准确提供了自由的理论依据;该分类提供了人们在社交媒体上分享头条的意向的方便度。从与1668名参与者的实验中,我们发现提供准确性评估和总体税收结论的准确性评估, 也降低了我们分享数据质量的准确性,从而降低了我们分享数据的质量。