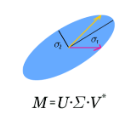

The success of matrix factorizations such as the singular value decomposition (SVD) has motivated the search for even more factorizations. We catalog 53 matrix factorizations, most of which we believe to be new. Our systematic approach, inspired by the generalized Cartan decomposition of Lie theory, also encompasses known factorizations such as the SVD, the symmetric eigendecomposition, the CS decomposition, the hyperbolic SVD, structured SVDs, the Takagi factorization, and others thereby covering familiar matrix factorizations as well as ones that were waiting to be discovered. We suggest that Lie theory has one way or another been lurking hidden in the foundations of the very successful field of matrix computations with applications routinely used in so many areas of computation. In this paper, we investigate consequences of the Cartan decomposition and the little known generalized Cartan decomposition for matrix factorizations. We believe that these factorizations once properly identified can lead to further work on algorithmic computations and applications.

翻译:单值分解(SVD)等矩阵因子化的成功促使我们寻找更多的因子化。我们把53个矩阵因子化(我们认为其中多数是新因素)编成目录,我们根据Lie理论普遍的Cartan分解(Cartan分解),在Lie理论的普遍化启发下,系统化的方法还包括已知的因子化(SVD)、对称分解(Symatic eigendecommation)、CS分解(CS)、双曲SVD、结构化SVD、Takagi因子化(SVD)、以及其它方法,从而涵盖了熟悉的矩阵因子化以及有待发现的因子化。我们认为,Lie理论在某种程度上隐藏在非常成功的矩阵计算领域的基础,其应用经常用于如此众多的计算领域。在本文件中,我们研究了Cartan分解(Cartan)和鲜为人所知的母体分解(Cartan)对矩阵因子化(Casten)的后果。我们认为,这些因子化一旦正确确定,这些因子化可以导致关于算算和应用的进一步工作。