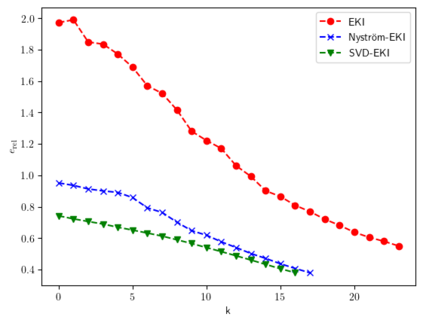

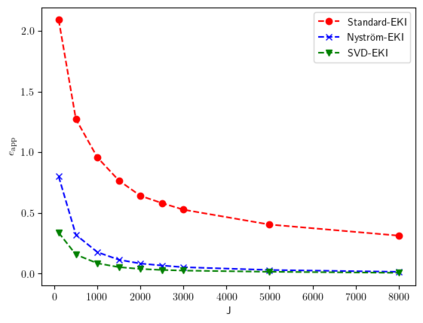

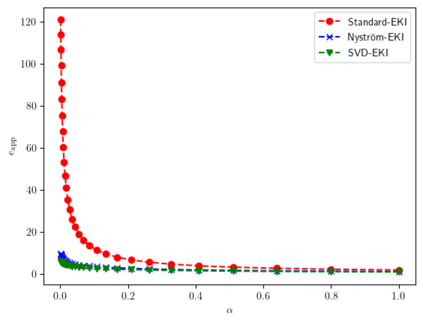

In this paper we show that ensemble Kalman inversion for linear inverse problems can equivalently be formulated as a stochastic low-rank approximation of Tikhonov regularization. This point of view allows us to introduce an alternative sampling scheme based on the Nystr\"om method that improves practical performance. Furthermore, we formulate an adaptive version of ensemble Kalman inversion where the sample size is coupled with the regularization parameter. We prove under standard assumptions that the proposed scheme yields an order optimal regularization method if the discrepancy principle is used as a stopping criterion.

翻译:在本文中,我们证明,对于线性反问题,共通的Kalman反向反向反向反向反向反向可被等同于Tikhonov正规化的随机低端近似值。 这一观点使我们能够采用基于Nystr\'om方法的替代抽样计划, 提高实际性能。 此外, 我们还在样本大小与正规化参数相结合的情况下, 开发了共通Kalman反向反向的适应性版本。 我们根据标准假设证明, 如果差异原则被用作停止标准, 则拟议方案将产生最优化的顺序规范化方法 。