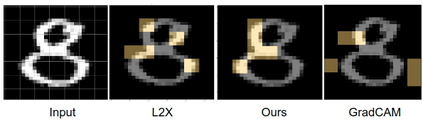

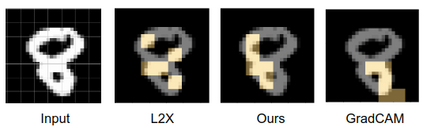

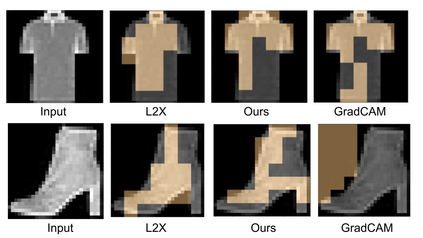

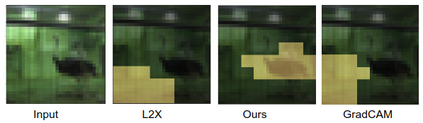

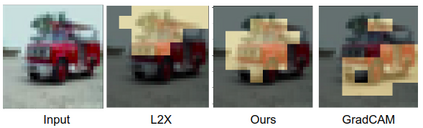

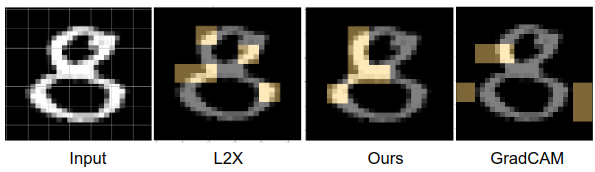

We formulate a causal extension to the recently introduced paradigm of instance-wise feature selection to explain black-box visual classifiers. Our method selects a subset of input features that has the greatest causal effect on the models output. We quantify the causal influence of a subset of features by the Relative Entropy Distance measure. Under certain assumptions this is equivalent to the conditional mutual information between the selected subset and the output variable. The resulting causal selections are sparser and cover salient objects in the scene. We show the efficacy of our approach on multiple vision datasets by measuring the post-hoc accuracy and Average Causal Effect of selected features on the models output.

翻译:我们为最近引入的实例性特征选择范例设计一个因果延伸, 以解释黑盒视觉分类器。 我们的方法选择了一组对模型输出产生最大因果效应的输入特性。 我们用相对内心距离测量来量化一组特性的因果影响。 根据某些假设, 这相当于选定子集和输出变量之间的有条件的相互信息。 由此得出的因果选择在现场是稀疏和隐蔽的物体。 我们通过测量后热精确度和选定特征对模型输出的平均因果关系来显示我们在多个视觉数据集上的方法的有效性 。