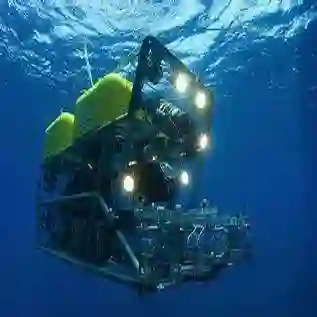

Efficient and intuitive Human-Robot interfaces are crucial for expanding the user base of operators and enabling new applications in critical areas such as precision agriculture, automated construction, rehabilitation, and environmental monitoring. In this paper, we investigate the design of human-robot interfaces for the teleoperation of dynamical systems. The proposed framework seeks to find an optimal interface that complies with key concepts such as user comfort, efficiency, continuity, and consistency. As a proof-of-concept, we introduce an innovative approach to teleoperating underwater vehicles, allowing the translation between human body movements into vehicle control commands. This method eliminates the need for divers to work in harsh underwater environments while taking into account comfort and communication constraints. We conducted a study with human subjects using a head-mounted display attached to a smartphone to control a simulated ROV. Also, numerical experiments have demonstrated that the optimal translation is often the most intuitive and natural one, aligning with users' expectations.

翻译:高效和直观的人机界面对于扩大操作者的用户群体并在关键领域(如精密农业、自动化建筑、康复和环境监测)中实现新应用至关重要。在本文中,我们研究了用于动态系统远程控制的人机界面设计。所提出的框架寻找符合用户舒适度、效率、连续性和一致性等关键概念的最优界面。作为概念证明,我们引入了一种创新的水下航行器远程操纵方法,允许将人体运动转化为车辆控制指令。这种方法消除了潜水员在恶劣水下环境中工作的需要,同时考虑到舒适性和通信限制。我们使用连接到智能手机的头戴式显示器对人体进行了研究,用于控制模拟ROV。此外,数值实验表明,最优的转换通常是最直观和自然的,符合用户的预期。