慢动作重播~ 英伟达AI能把普通视频,变成高质量慢动作视频

问耕 发自 凹非寺

量子位 出品 | 公众号 QbitAI

生活中,总有一些时刻,你想要慢动作重播。

比如孩子第一次走路,比如运动过程中的高光时刻,比如狗狗玩耍的瞬间……虽然现在手机也能录制慢动作视频。

但想要以高帧率记录所有的视频,是一个不切实际的幻想。因为慢动作需要的存储空间太大了。

现在,英伟达的一项新研究,可以帮助解决这个问题。

只需要一段普通的视频,英伟达训练出来的人工智能,就能生成一个高质量的慢动作视频。从30FPS,一举变身240FPS。

效果嘛,如下面动图所示:

这是怎么做大的?

其实,就是基于人工智能技术,在两帧画面之间,自动生成补充上“缺失”的画面帧,让慢动作重播得以实现。

这个人工智能系统,是一个使用了Nvidia Tesla V100 GPU和cuDNN加速的PyTorch深度学习系统,使用了超过1.1万个视频进行训练。

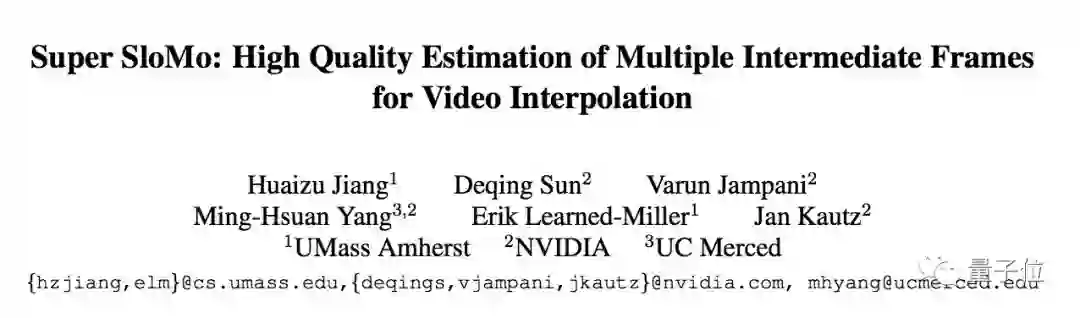

如果你对这个AI感兴趣,更多细节可见他们的论文:Super SloMo: High Quality Estimation of Multiple Intermediate Frames for Video Interpolation。

传送门:https://arxiv.org/abs/1712.00080

论文作者:Huaizu Jiang、Deqing Sun、Varun Jampani、Ming-Hsuan Yang、Erik Learned-Miller、Jan Kautz。分别来自:马萨诸塞大学安姆斯特分校、英伟达、加州大学美熹德分校等。

更多慢动作演示,可见这个视频:

— 完 —

诚挚招聘

量子位正在招募市场运营实习生,参与线上/线下活动整体流程,帮助制作相关物料,运营社群等。工作地点在北京中关村。

期待有热情的同学加入!简历欢迎投递到quxin@qbitai.com

具体细节,请在量子位公众号(QbitAI)对话界面,回复“实习生”三个字。

量子位 QbitAI · 头条号签约作者

վ'ᴗ' ի 追踪AI技术和产品新动态