最新基于强化学习的推荐系统综述

链接 | mp.weixin.qq.com/s/yOcWMmqddQPyEa2oROCzxQ

编辑 | 机器学习与推荐算法

祝老师们教师节节日快乐~

摘要

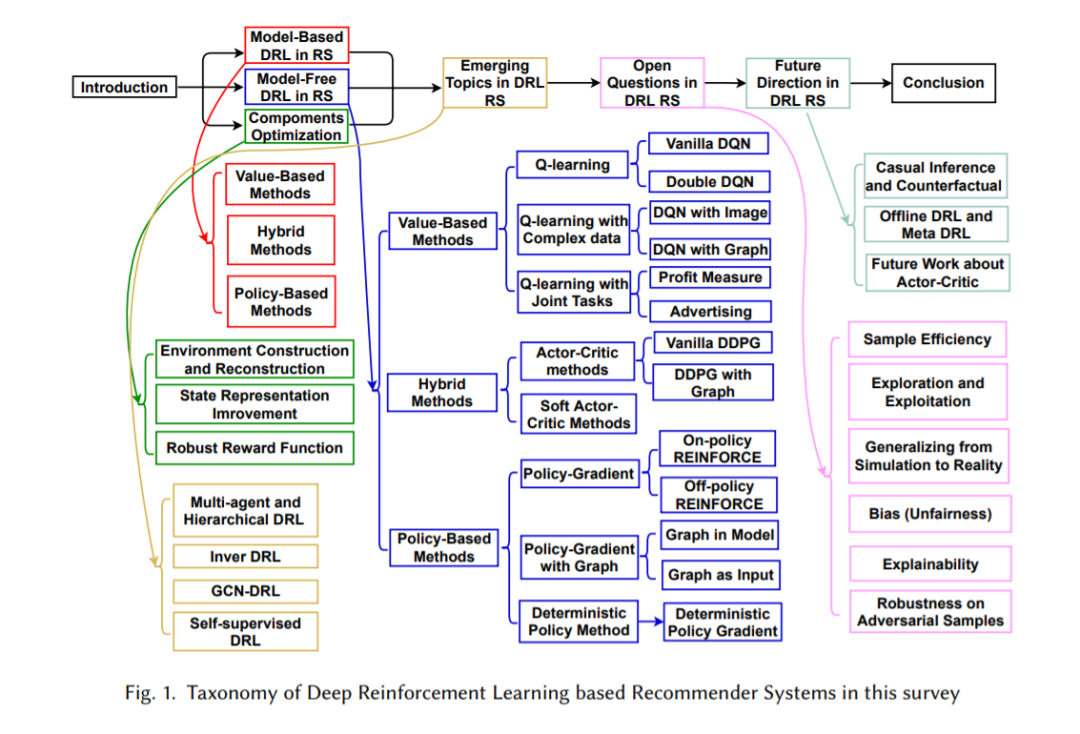

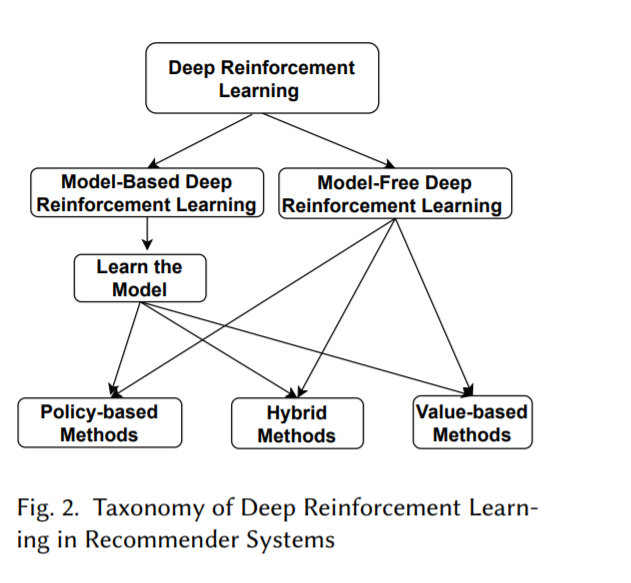

鉴于深度强化学习(DRL)在推荐系统研究中的出现,以及近年来取得的丰硕成果,本研究旨在对深度强化学习在推荐系统中的最新发展趋势提供一个及时而全面的概述。我们从在推荐系统中应用DRL的动机开始。然后,我们给出了当前基于DRL的推荐系统的分类,并对现有的方法进行了总结。我们讨论新出现的话题和未决的问题,并提供我们推进该领域的观点。本综述为来自学术界和工业界的读者提供了入门材料,并确定了进一步研究的显著机会。

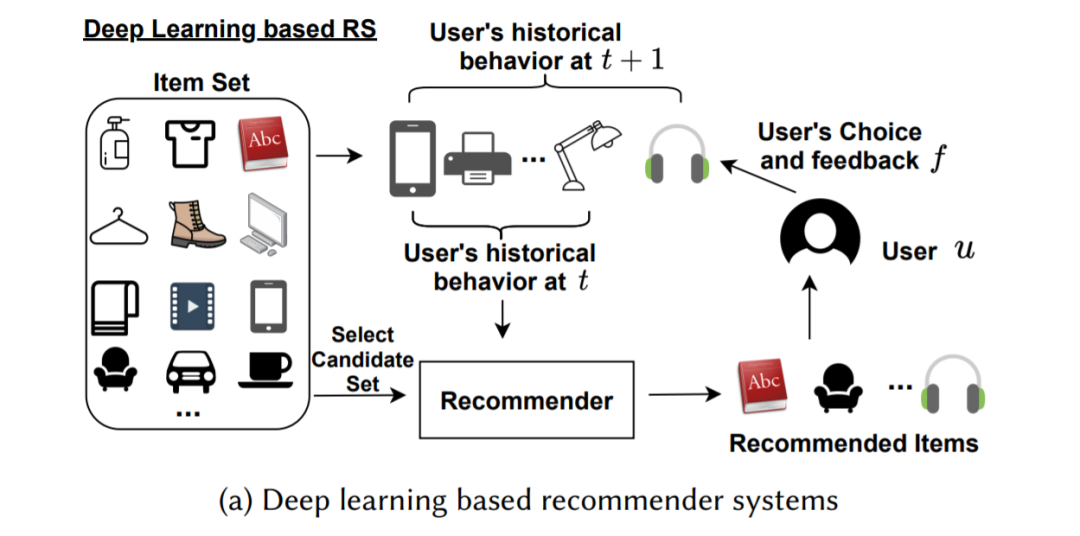

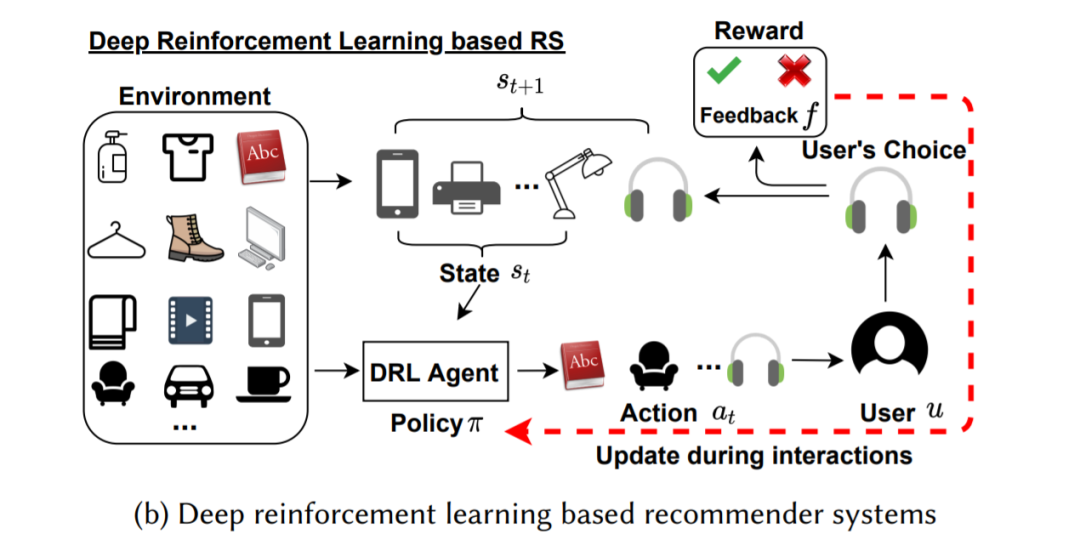

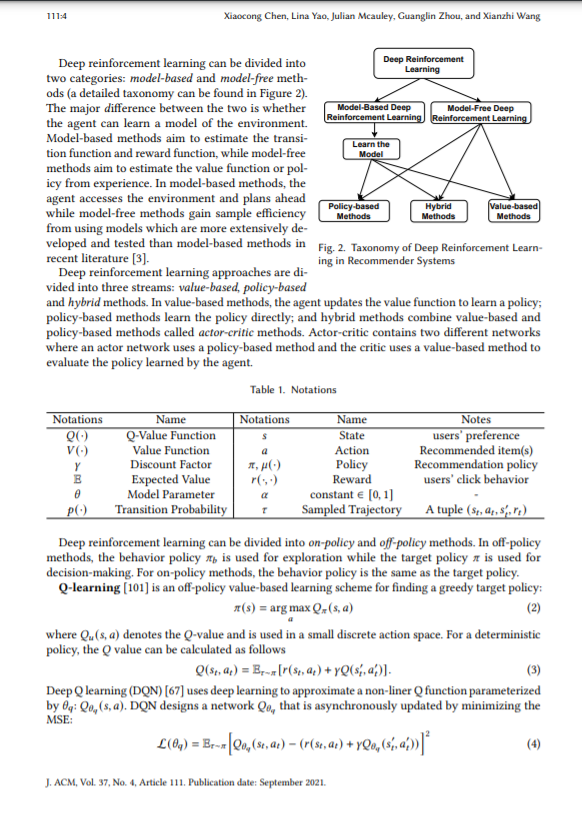

近年来,推荐技术有了长足的发展,从传统的协同过滤、基于内容的推荐、矩阵分解等推荐技术[62],到基于深度学习的推荐技术。特别是深度学习在解决复杂任务和处理复杂数据方面具有很强的优势,因为深度学习能够捕捉非线性的用户-项目关系,能够处理图像、文本等各种类型的数据源。因此,它在推荐系统中得到了越来越多的应用。由于分布的变化,基于深度学习的推荐系统在捕获兴趣动态方面存在局限性[17,115],即训练阶段基于现有的数据集,这可能不能反映真实的用户喜好,而用户的喜好变化很快。而深度强化学习(deep reinforcement learning, DRL)的目标是将深度学习和强化学习的力量结合起来,训练出一种能够从环境提供的交互轨迹中学习的agent。由于DRL中的agent可以主动从用户的实时反馈中学习,从而推断出用户的动态偏好,因此DRL特别适合于从交互中学习,如人-机器人协作; 它还推动了一系列互动应用的显著进步,从视频游戏、Alpha Go到自动驾驶[3]。鉴于DRL对推荐系统的重要性和最近的进展,我们旨在在本次综述中及时总结和评论基于DRL的推荐系统。

这项综述的主要贡献包括:

我们提供关于推荐系统中深度强化学习的最新综合综述,具有最先进的技术和指向核心参考文献的指针。据我们所知,这是基于深度强化学习的推荐系统的第一个全面综述。

我们给出了推荐系统中深度强化学习的文献分类。在概述分类和文献综述的同时,我们讨论了其优缺点,并对未来的研究方向提出了建议。

我们阐明了基于DRL的推荐系统的新兴主题和开放问题。我们还指出了未来发展方向,这对推进基于DRL的推荐系统至关重要。

本综述的其余部分组织如下: 第2节概述了推荐系统、DRL及其集成。第3节提供了一个分类和分类机制的文献综述。第4节回顾了出现的话题,第5节指出了未解决的问题。最后,第6节为这一领域的进一步发展提供了一些有前景的未来方向。

因果性是因果之间的一般关系。此外,在诸如计算式广告、搜索引擎和推荐系统[7]等许多应用中,推断因果效应是一个基本问题。近年来,一些研究者将强化学习与学习因果关系联系起来,以提高解决序列决策问题的效果。此外,强化学习框架中的学习主体面临着集成大量异构数据的复杂环境。从我们的观点来看,因果性可以通过引入因果的方向性来改善推荐结果。用户以前的选择会影响后续的操作。这可以被视为产生推荐系统动态的干预数据。通过将RL中的策略视为干预,我们可以检测RL中未被观察到的混杂因素,并选择预期奖励的策略,以更好地估计因果效应[82]。一些研究改进了以因果知识作为边信息的RL模型。另一种工作是使用因果推理方法来实现无偏的奖励预测[34]。

离线DRL和元DRL

推荐系统通常需要处理多个场景,如联合推荐和广告,离线DRL和元DRL为同时实现多个场景提供了一个很好的方向。离线DRL是一种新的DRL范式,它可以与现有的方法(如自我监督学习和迁移学习)相结合,向现实环境中移动。

结论

在这个综述中,我们提供了一个全面的概述深度强化学习在推荐系统中的使用。我们介绍了现有研究的分类方案,并按类别进行讨论。我们还提供了这些现有的新兴主题的概述,并指出了一些有前景的方向。我们希望这一综述能够对基于DRL的RS的关键概念提供系统的理解,并为未来的研究提供有价值的见解。