AI武器未来战

点击上方“公众号”可以订阅哦!

转自:晓艳的科技坊

来源:UDN Global

作者:徐子轩

致命自主武器系统(LAWS)亦有人将之称为“杀手机器人”(killer robot)。 图/《魔鬼终结者》

11月底,联合国《特定常规武器公约》(CCW)有88个缔约成员国,群聚日内瓦,召开了政府专家小组(GGE)会议,讨论重点在于所谓的“致命自主武器系统”(LAWS)。专家们希望透过各方集思广益,探讨LAWS的未来与公约。

致命自主武器系统亦有人将之称为“杀手机器人”(killer robot),但不限于有双手双脚、可进行攻击防御的人形机器。事实上国际法或条约目前仍没有对于LAWS的确切定义,唯一比较接近各国共识的,应属2016年红十字会专家会议的结论。他们主张:“若一种武器系统可“自主”选择与攻击目标,便可称为LAWS。”

“若一种武器系统可『自主』选择与攻击目标,便可称为LAWS。”图为2000年,于德国汉诺威举办的世界博览会上展示的机器人。 图/美联社

在CCW的会议里,大多数的国家都认为,LAWS必须维持某种形式的人为控制,甚至主张应该要缔结新的公约,以禁止未来继续发展和使用LAWS。这点也得到许多非政府组织、科学家与企业家的赞同,如Tesla的执行长马斯克与人工智能公司DeepMind的创办人苏莱曼(Mustafa Suleyman)就曾与百名专家共同呼吁禁止LAWS。

有些国家采取妥协观望的立场,像德国、法国。他们认为,现在对LAWS提出具有法律约束力的条约为时过早,目前国际法和相关宣言足够控制,不如把目标转向建立行为准则或信心建立措施,这也得到部份欧盟成员的支持。由于德国先前态度倾向反对LAWS,法国较为支持,因此外界多认为德国的转变是为迎合法国,以及不愿意受到外力对其发展AI的桎梏。

LAWS是否如部分人士担心的危险?赞成与反对者的立场又有甚么不同呢?图为美国的军警机器人正检查自杀炸弹客的嘴巴。 图/美联社

明确表态应继续LAWS谈判的国家则有美国、俄罗斯、澳大利亚等五国,他们表示希望能探索开发和使用LAWS的潜在优势,并强烈反对任何新公约或政治宣言。俄国更表示,希望能缩短明年的会期,由十天减为七天,因为各国歧见一直存在,没有必要浪费时间,此议也获得中国赞同。

最后会议仅形成微弱共识,强调LAWS应该遵循《国际人道法》,在重申未来武器必须透过人为控制的立场后,各国预定于明年继续聚集探讨——那么,究竟LAWS是否有如部分人士担心的危险?赞成与反对者的立场又有甚么不同呢?

Tesla的执行长马斯克(左)与Deepmind(即AlphaGo的研发公司)的创办人苏莱曼(中)曾与百名专家共同呼吁禁止LAWS。已逝的物理学家霍金(右)也曾警告AI的危险性应谨慎应对。 图/法新社、维基共享、路透社

有意义的人为控制 VS 适当的类人判断

时间回到2014年,CCW第一次针对LAWS召开会议。从那以来,各方就对LAWS争论不休,从定义到应用,始终无法达成一致。许多国家坚持“有意义的人为控制”是AI武器的标准。这是基于潜在的风险、道德与问责要求,因此人类的生死决定不能委托给机器。

不过,部份国家——如美国和以色列——则主张应以LAWS是否能达成“适当的(appropriate)人类判断”来讨论,而非传统的人为控制。也就是说,系统在上线运作前,必须通过相关的交战规则、法规命令等原则,确保系统能“自主”做出与人类一致的决定。

他们认为AI武器不似核生物武器,一旦释放就无可挽回,且最初设计武器时,理应已加入人为控制的参数,让AI具有判断能力,因此不需要多余的控制程序。这也是所谓的美国标准,至于是否能完全按照美军规划,恐怕外界很难论断。

许多国家坚持“有意义的人为控制”是AI武器的标准,人类的生死决定不能委托给机器。不过,部份国家——如美国——则主张应以LAWS是否能达成“适当的人类判断”来讨论,而非传统的人为控制。图为美国海军陆战队,操作配备有机关枪武器的遥控机器。 图/USMC

事实上,自主武器的雏形早在当代AI观念普及前就已存在数十年。像是弹道导弹防御体系(BMD),该系统就是美军定义里的自主武器,也就是——一旦启动,无须人类干预,就可以择定目标发射交战。当然,人类可以选择取消发射导弹的决定,符合有意义的人为控制,没有人会质疑导弹系统是违反国际法的存在。

不过如前述所说,自主武器目前国际上没有一致定义,使得不少反对派因此时常将“自主”(autonomous)武器与“自动”(automated)武器搞混而混为一谈。前者一般是指可以独立判断行动的AI,后者是指输入预定程序,设定并控制其目标,让它自己行动,又可称为半自主武器。

严格来说,目前世界上并没有真正、完全的、如电影《魔鬼终结者》般的全自主武器问世(至少台面上没有)。因此德国代表也在上半年的GGE上玩着文字游戏,如此表述:“怎能禁止一些不存在的东西?”

“怎能禁止一些不存在的东西?”图为电影《机械公敌》。 图/《机械公敌》

为解决纷争,有学者正试图研拟关于自主武器的定义,关于其能力涵括了三个指标:自主移动、自主导向和自主决定。自主移动意谓系统能够自行移动、自主导向意谓系统能识别目标、自主决定则意谓系统能自行设定计划。若依此定义,目前大多数AI武器具有很高的自主移动和自主导向能力,但极少有自主决定的能力。

由于LAWS的反对者有不少都是军事门外汉,他们可能不了解,像是美国军队研发的“自动化指挥系统”(C4ISR),即是结合电子计算机运算以及人类指挥的现代化指挥体系。这套系统首重指挥(Command)与控制(Control)军队,很难想象有任何指挥官与将领愿意放弃这些核心原则,因此C4ISR的最高治军原则仍是落在人类指挥官上;LAWS支持者认为,人类对AI自主决定的方面必定也会有所限制。当然这也是人类的设想,自主AI的发展未必全如人类的规划。

再回头谈到反对者坚持“LAWS‘每个阶段’须受到有意义的人为控制”,支持LAWS一派则认为,这在实际操作上站不住脚:若依照反对者要求,LAWS运作的“每阶段”都必须透过人为控制,必要时人类得终止攻击命令。这个标准先不论终结者技术上是否能做到,就算目前也没有任何武器能“每阶段”都受人为控制,试想当人类对敌方一枪,甚至掷出长茅,武器又怎能自动停止攻击?支持派抓住反对派的语病表示,在开火前有意义的人为控制,当然也符合他们追求的控制原则,只是“每个阶段”实属不切实际。

如此看来,似乎是各方对AI技术的认知不同。目前最接近的是人类协同AI操作的远程遥控飞行器(RPAV),亦即俗称的无人机。真正完全自主的LAWS仍没有应用于战场上,只凭想象或电影小说描绘就否定其功能或许也过于武断。

07目前最接近的是人类协同AI操作的远程遥控飞行器(RPAV),亦即俗称的无人机。真正完全自主的LAWS仍没有应用于战场上。图为美国“掠夺者”无人机(Predator),多用于战场侦查及攻击行动。 图/路透社

人道与良知的难题

若从技术面着手,反对阵营似乎难以取得优势,因此现今反对者的论点多立足于国际法原则。依据《日内瓦公约》的第一附加议定书、CCW序言里的《马尔顿斯条款》(Martens clause)精神,他们强调如果交战国遇到国际法没有规范的状况,应该以“人道原则”与“公众良知”,做为各国在评估新技术时的义务性考虑。

人道原则是指即使在战时,也必须尊重人的生命和尊严,要求对他人施与人道待遇。因为人类会同情人类,因此有动力以人道方式对待彼此。此外,法律和道德判断使人类能够理解特定环境,做出经过思虑后的决策,包括在战争里最小化伤害,并防止任意与不合理的生命损失。

这些都是AI所欠缺的部分,做为无生命的LAWS缺乏同情心,无法体会人类生命价值及其丧失的痛苦。AI只能根据算法做出生死决定,而算法在复杂和不可预测的情况下效果不佳,也无法针对每种情形先行编程,最终会将人类降低为一般的生物对象,违反人道原则。

公众良知则是指公众和政府对于是非的道德准则。迄今许多团体、专家和政府都强烈反对LAWS的发展,约有26个国家支持先发制人的禁令,超过100个国家呼吁制定一项具有法律约束力的文件,以解决LAWS可能带来的威胁。

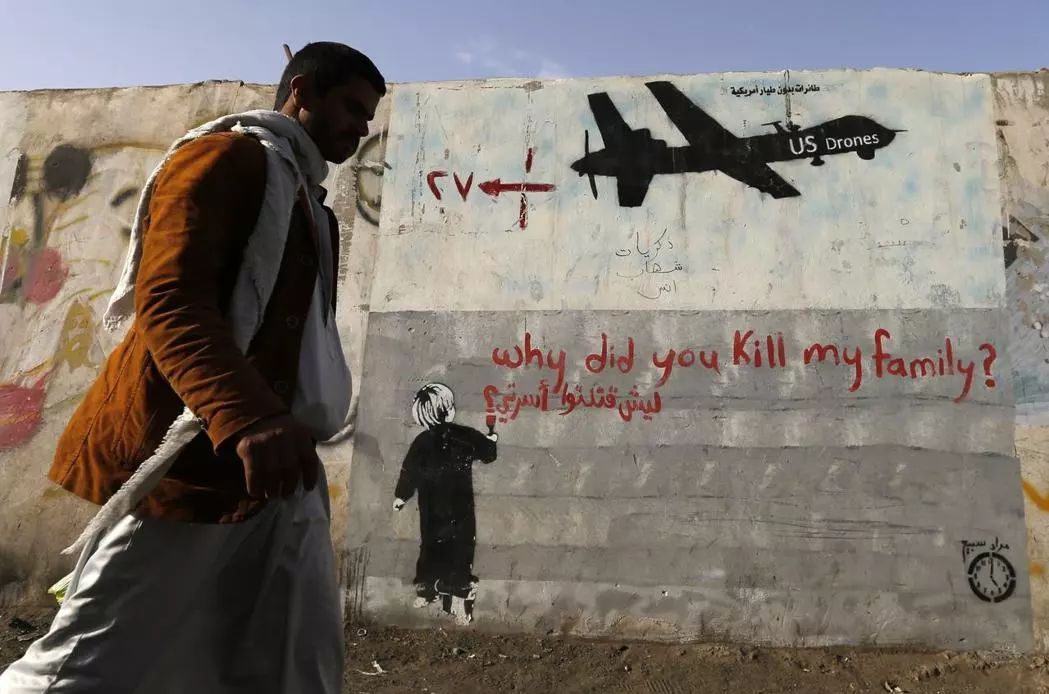

做为无生命的LAWS缺乏同情心,无法体会人类生命价值及其丧失的痛苦。图为美国于也门东南部的沙巴瓦省,发动无人机空袭后满目疮痍的场景。 图/路透社

也有专家指出,对LAWS有意义的人类控制,就是一种道德义务。像是战争时人类指挥官一旦下令攻击敌方,就有道德义务防范过度的杀戮,这点AI不能替人类做到。总的来说,多数主张表明公众良知倾向于人类控制、反对自主武器,因此LAWS也无法通过此项原则测试。

不过部份国家则有不同想法。如美国认为,武器的自主功能在军事上也可以产生人道主义的利益。因为比起人类对武器的控制,理想上AI的准确性更高,这可以帮助避免对平民的意外伤害,并降低误击友军的机率。

支持LAWS的声音指出,军事机器人也有助于人道干预,因为很多时候各国担心子弟兵受损,拒绝介入他国武装冲突。如果以LAWS代替人力,那么在阻止种族灭绝和其他大规模暴行,或者是执行国际维和任务时,都有助于减少平民与军人的伤亡。

有LAWS支持者认为,像是韩国在边界布署的SGR-A1哨兵系统,就因增加了朝鲜的侵略成本,从而减少战争的可能。 图/法新社

此外,针对LAWS反对者认为机器人会降低武装冲突的门坎,支持者也不以为然。例如韩国在边界布署的SGR-A1哨兵系统,就有论者认为这增加了朝鲜的侵略成本,从而减少战争的可能。比起人类可能会因身体或心理因素而影响作战,AI是成本更低、效果更高的威吓手段。

从上述不难发现,大多数支持禁止LAWS的国家都是发展中或低度开发国家,这些国家或多或少都有被强国干预和入侵的历史,可谓受自主武器的潜在威胁最大。像是不结盟运动和非洲集团国家,都希望在2019年CCW能谈判出具有法律约束力的文件,全面禁止LAWS。

“美军无人机”、“为什么要杀害我的家人?”大多数支持禁止LAWS的国家都是发展中或低度开发国家,这些国家或多或少都有被强国干预和入侵的历史,可谓受自主武器的潜在威胁最大。图为也门街上的壁画涂鸦。 图/路透社

然而,这类诉求不切实际。且不论各国是否会达成共识,若失去美国、俄国等自主武器大国的参与,禁令等于一纸空文;就算缔结了国际条约,也很难限制有心想拥有LAWS的国家或非国家行为者。最明显的例子即是比无人机难上百倍的核武技术,即使国际间早有《核武禁扩条约》(NPT),某些国家仍执意发展。

是故,世界各国若真想规范LAWS,或许应采取奥地利、巴西等国的提案,将战场设定在确保对LAWS关键能力的制约,进行有意义的人为控制。甚至,应明确界定自主武器的用途,商定验证各国使用这些武器的方法,并为违法者设立罚则,向国际社会表明AI不会被用于征服侵略而是防御。

军用无人机,预料会是列强国家争夺的下个军事战场。图为美军开发第一款专门用作猎杀用途的军事无人机——MQ-9死神侦察机(MQ-9 "Reaper")。 图/路透社

过去在CCW专家会议上,反对LAWS者曾经举以色列的哈比无人机(IAI Harpy),做为自主武器的案例讨论。Harpy开发于上世纪九零年代,目的在于摧毁敌方雷达系统,后来以色列出售给中国,中国又疑似以此为原型山寨产生了ASN-301无人机。

若照LAWS反对者的逻辑,凡是设计用来攻击的无人机都属违法。反对LAWS者认为,无人机应用在军事上的复杂性让人类难以处理。例如有报告指出,在巴基斯坦,美军以无人机猎杀恐怖份子及其帮手,他们宣称准确度超过99.99%,被错误归类为恐怖分子的机率仅有0.008%。机率看起来极低,但换算成人口数却是约上万人。

12有报告指出,美军在巴基斯坦以无人机猎杀恐怖份子,虽然宣称准确度超过99.99%,被错误归类的机率仅有0.008%。机率看起来极低,但换算成人口数却是约上万人。图为反战NGO团体“Codepink”在2013年在美国的“无人机展览会”场外抗议。 图/法新社

这就牵涉到责任议题。如果战争时发生违反国际法规则或道德规范的错误,谁应该负责任?是操作的士兵、下令的指挥官、编程LAWS的设计者,亦或是授权的官僚体系呢?

目前还可从涉及其中的人类究责,但未来如果AI真能完全自主,那么它必然是从经验和环境中学习,做出反映学习成果的决定。如此发展下去,设计者也无法预测与控制,更难以抓出特定人士为后果负责。

此外,反对者也认为军队多是利用黑箱算法处理数据,算法恐有偏见与谬误。现在的AI对于固定的物体,像是家具或动植物,拥有较为可靠的标记和分类能力。但如果谈到训练AI去理解复杂现象,基于数据与技术有限,可能会导致完全错误的结果。

反对LAWS者特别举例自动脸部识别,在应用上存在很多问题。麻省理工的研究指出,IBM、微软等科技巨头所设计的脸部识别算法,根据性别与种族会有不同的结果。例如研究发现,在侦测时,比较浅肤色的男性与深肤色的女性,错误率高达35%。

自动脸部识别科技在应用上存在很多问题。麻省理工的研究指出,IBM、微软等科技巨头所设计的脸部识别算法,在侦测时,肤色较浅的男性与深肤色的女性,错误率高达35%。 图/路透社

也有其他研究支持AI辨识存有偏见的结论,特别是在兵荒马乱间,涉及编程的参数不可能包罗万象,更具流动性和动态性。因此AI建议的行动方案多基于认知基础,而基础本身常常早已具有偏见。试想若应用于战场上,一些被错误认定的族裔遭受LAW攻击,会是多么严重的后果。

支持LAWS者则反驳,目前没有国家实际使用这类AI,无人机攻击仍须透过人类一定程度的控制。重点在于LAWS真正投入战场前要确保准确度,这里说的准确度并非百分百完美,只要能比人类更能减少伤亡,就是值得发展的方向。且人类很难透过战争学习,也不易传承,但AI没有此类问题,可以不断累积经验、纠正错误。

他们更强调,反对者把AI描绘成邪恶嗜杀的机器人绝对错误,他们认为技术本身没有问题,有问题的是使用者。未来的LAWS必须强调机器伦理,也就是设计者得在机器内输入和处理国际法等相关规范数据,并让AI深度学习,学到何种程度能上战场才是问题重点。

假设人类与完全自主的AI机器士兵交战,那么AI能预先编程,在达到某种确认度前不会以致命武力攻击。由于AI没有生命,可以装备足够承受火力的机甲;也没有恐惧与愤怒,不似人类会为自卫或情绪而先下手为强,可设定直到满足所有必要的条件才发动,这就是人类无法达到的地步。

无人机成本不高,非常适合当作攻击武器。饱受美国与以色列无人机威胁的巴基斯坦和巴勒斯坦,都疾声高呼要停止这种AI带来的人道灾难。图为2006年以色列无人机发动空袭,造成加萨走廊地区多人死伤。 图/路透社

然而,不可讳言的是,LAWS确实可能具备强大的武装,使得反对者主张,其同属于潜在的大规模杀伤性武器(WMD),应该与核生物武器、或是常规武器及其附加议定书等量齐观,以国际法约束。他们担心如果LAWS落入恐怖组织手中,会带来极大伤亡,而国与国之间,也可能兴起一波AI军备竞赛,危害既有的和平。

像是无人机成本不高,非常适合当作攻击武器。饱受美国与以色列无人机威胁的巴基斯坦和巴勒斯坦,都疾声高呼要停止这种AI带来的人道灾难。前几个月,以色列刚公布一份报告就指出,2014年军队因为悲剧性失误,以无人机杀伤了四名孩童。

恐怖份子似乎也纷纷展开行动。今年7月在美国墨西哥州,一名负责公安的官员住家发现有携带炸弹的无人机坠落,所幸没有构成伤害,此事被怀疑与取缔毒品有关;8月在委内瑞拉,也发生针对总统的无人机攻击,有数人因此受伤,反对政府的民兵组织也已出面承认攻击。

随着商用无人机的普及,可能会出现更多自杀性爆炸,或是以其他恐怖主义模式威胁平民。曾经盛极一时的伊斯兰国,就使用过无人机侦测与袭击,甚至被用来吸引招募对战斗有兴趣的人们。据报导指出,伊斯兰国使用的无人机成本大多在1,000美元左右,坐实了反对LAWS者把无人机称为是“穷人的智能炸弹”。

无人机是将沦为“穷人的智能炸弹”?随着商用无人机的普及,可能会出现更多自杀性爆炸,或是以其他恐怖主义模式威胁平民。图为巴勒斯坦激进武装组织“哈玛斯”(Ḥamas)手持无人机。 图/美联社

对此,支持LAWS者反驳自主武器是WMD的说法,认为攻击用途的无人机并不违反国际法。绝大多数的国家也不会禁止无人机,因为其商用价值无可限量,且阻挠人类开发技术的障碍太低,真正有意义的作法是采取管理约束行为。换言之,这属于国内执法的范畴,无须联合国公约。

目前各国多少都有关于无人机的法规,如美国联邦航空管理局(FAA)去年制定新法,要求购买者登记重量在0.55磅到55磅之间的无人机,若未依法登记将受到民事或刑事处罚;中国同样也要求重量在250公克以上的无人机实名登记,近来更规定部分特殊区域无人机操作者,必须拥有执照许可。

另一方面,军事无人机的使用并非如想象中的简单顺遂。2011年CIA的无人机在伊朗进行任务时坠毁,现在大多认为是伊朗利用黑客入侵GPS使其降落,也就是模仿发送到GPS的信号,欺骗机载接收器遵循命令。最近以色列也在领土上击落来自伊朗的无人机,并宣称伊朗透过逆向工程、复制美国的无人机。

迄今,美国仍在开发新技术,像是使用带有模式识别软件的摄影机辅助GPS导航,以确保无人机的控制。若想远程操纵,需要先进的通信系统、指挥和控制基础设施以及技术人员。以伊拉克为例,它向中国购买了不须卫星导航、价格便宜许多的无人机CH-4,只须相对短程的无线电波引导,制约了打击范围。

绝大多数的国家也不会禁止无人机,因为其商用价值无可限量,且阻挠人类开发技术的障碍太低,真正有意义的作法是采取管理约束行为。图为2017年中国国际航空航天博览会上,展示其自产的“彩虹”、“翼龙”、“云影”等无人机。 图/新华社

尽管如此,支持LAWS者也承认,无人机被滥用的威胁性越来越大。在也门内战就发现,伊朗向叛乱份子提供无人机等武器支持。这些无人机目前多用于对付地对空导弹系统和雷达数组,以数百美元的无人机换数百万美元的防御导弹再划算不过,但未来则有可能会用在摧毁车辆、船只或是军队人员。

若发生此类情形,较为经济可行的方案,是以无人机对抗无人机,这也是支持者大力疾呼的主因之一。支持者LAWS相信,即使缔结国际法禁止自主武器,对手未必会遵守规则,特别是无人机已确定是未来数十年的武器主轴,此时如果不抢占技术领导地位,必将受制于人。

值得注意的是,军用无人机有逐渐扩散的趋势。过去欧巴马政府时代,一些中东国家,如沙特阿拉伯、约旦等,向美国购买军用无人机遭拒,因而转向中国。这不仅助长了中国的武器出口,更可能因为数据的导入,有利于中国LAWS技术的进步。

美国则由于导弹科技管制建制(MTCR)限制,仅被批准出售给英国、法国等盟国,明显落后。今年川普政府则推出新政策,以便出口更多无人机与中国竞争,不难想见,未来军用无人机市场将出现美中两方激烈竞争,全球离有效管制LAWS恐怕也将越来越远。

一些中东国家因向美国购买军用无人机遭拒,而转向中国。这不仅助长了中国的武器出口,更可能因为数据的导入,有利于中国LAWS技术的进步。图为中国第十七届中国西部国际博览会上,展示的翼龙系列无人机模型。 图/中新社

注:投稿请电邮至124239956@qq.com ,合作 或 加入未来产业促进会请加:www13923462501 微信号或者扫描下面二维码:

文章版权归原作者所有。如涉及作品版权问题,请与我们联系,我们将删除内容或协商版权问题!联系QQ:124239956