自动化所Science Advances发文揭示介观自组织反向传播机制助力AI学习

作者 | 张铁林,徐波

在人工智能领域,目前人工神经网络中被广泛使用的反向传播算法(Backpropagation,BP)采用全局优化策略,这种端到端的学习方法性能卓越,但学习过程能量消耗大,且缺乏灵活性。中科院脑智卓越中心徐波、蒲慕明联合研究团队近期借助生物网络中发现的介观尺度自组织反向传播机制(Self-backpropagation,SBP),在更具效率和灵活性的类脑局部学习方法方面取得了重要进展。

SBP的发现最早可以追溯到1997年。蒲慕明团队在Nature杂志上撰文发现海马体内的神经元可以将长时程抑制(Long-term depression,LTD)可塑性自组织地传播到三个方向,分别是突触前侧向传播(Presynaptic lateral spread)、突触后侧向传播(Postsynaptic lateral spread)、反向传播(Backpropagation)[1],这个发现就是自组织反向传播神经可塑性机制(SBP)。后续研究证实,SBP现象具有普遍性,不仅覆盖更多的神经区域如视网膜-顶盖系统[2],还覆盖更多的可塑性类型[3],如长时程增强(Long-term potentiation,LTP)。该机制的发生归结于生物神经元内分子调制信号的天然逆向传递,被认为是可能导致生物神经网络高效反馈学习的关键[4]。

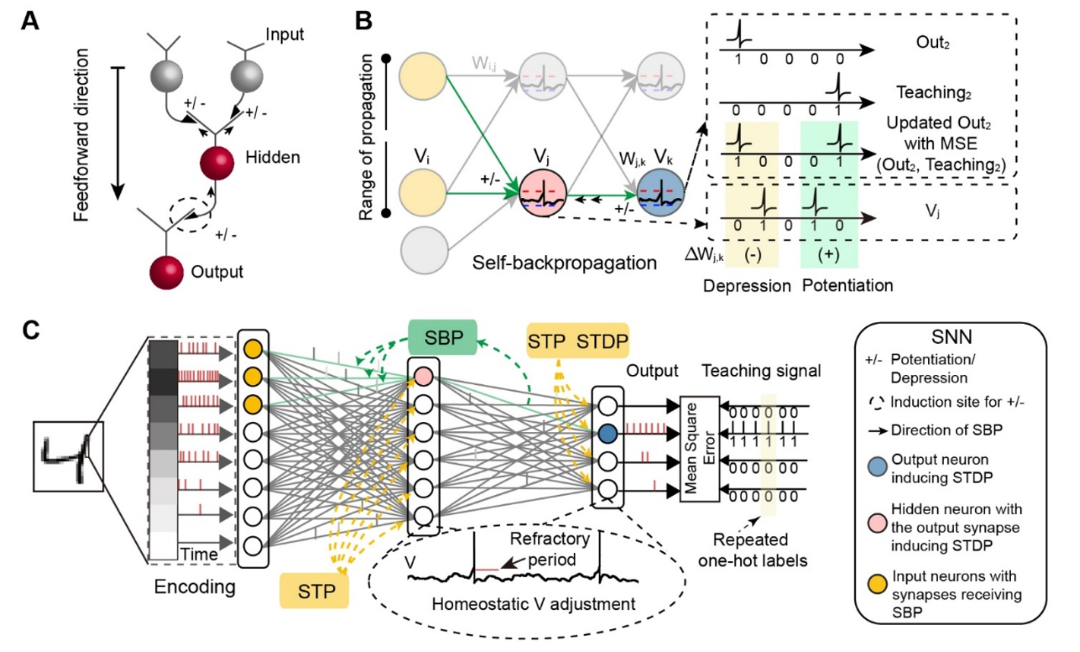

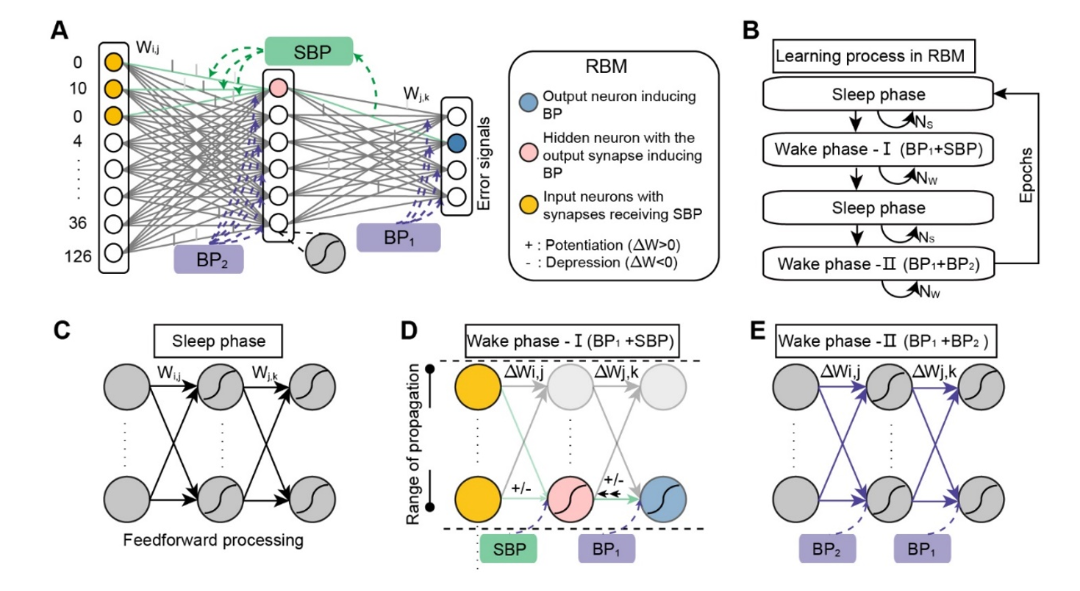

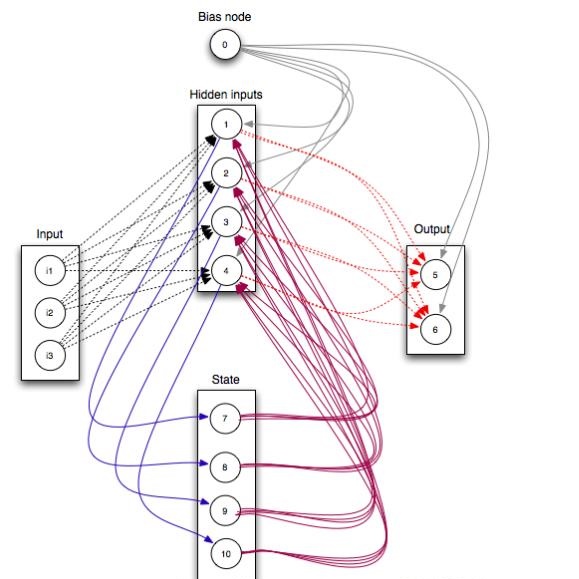

研究团队受到该机制的启发,对SBP的反向传播方向(第三个方向)单独构建数学模型(图1A),重点描述了神经元输出突触的可塑性可以反向传播到输入突触中(图1B),可塑性的发生可以通过时序依赖突触可塑性(Spike timing-dependent plasticity,STDP),也可以通过人工局部梯度调节。在标准三层脉冲神经网络(Spiking neural network,SNN)的学习过程中,SBP机制可以自组织地完成前一层网络权重的学习,且可以结合短时突触可塑性(Short-term plasticity,STP)、膜电位平衡(Homeo-static membrane potential)等,形成更强大的SNN组合学习方法(图1C)。在一类人工神经网络(Artificial neural network,ANN)如受限玻尔兹曼机网络(Restricted Boltzmann machine,RBM)的学习中(图2A),SBP机制也可以替换迭代过程中部分BP机制,实现交替的协作优化(图2B-E)。针对SNN和RBM的不同,团队又分别设置了两种不同的能量函数约束,来保证训练过程中网络参数学习的平稳性。

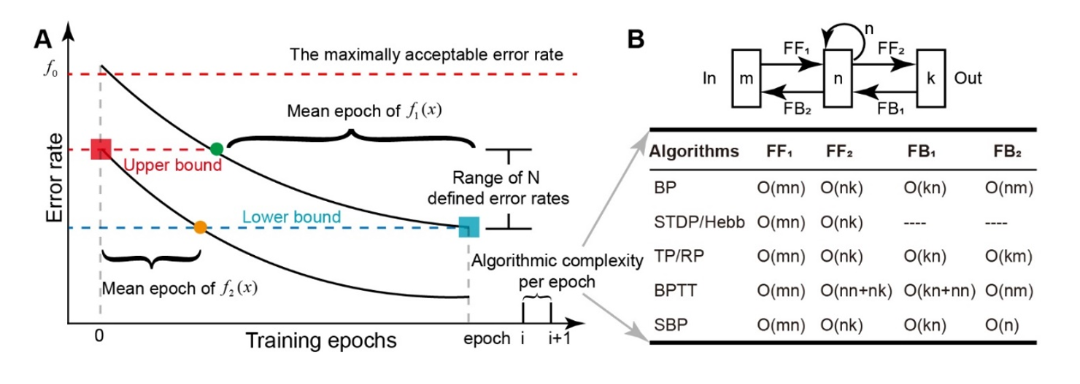

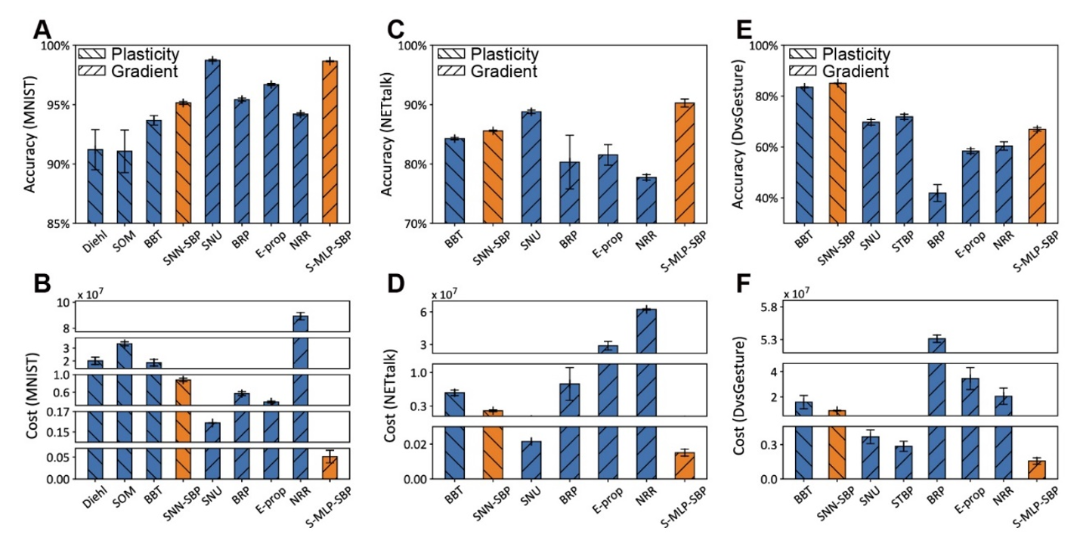

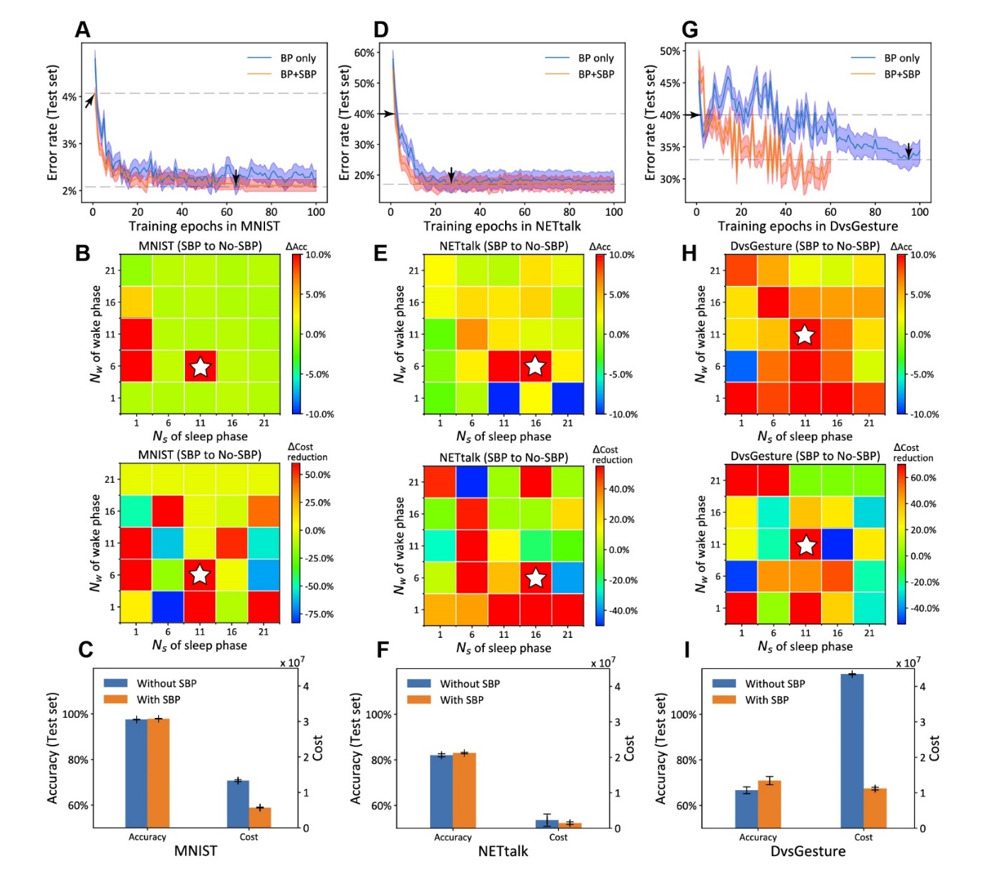

此外,研究团队针对性地提出了一种统计训练过程中能量消耗的新方法(图3)。在图片分类(MNIST)、语音识别(NETtalk)、动态手势识别(DvsGesture)等多类标准数据集上,SBP机制通过组合其它可塑性机制,实现了更低能耗和更高精度的SNN局部学习(图4)。在ANN-RBM的学习中,SBP机制也可以大量的替换BP机制实现全局和局部交叉学习,在降低计算能耗同时却不损失精度(图5)。

研究人员认为,SBP是一类介观尺度的特殊生物可塑性机制,该机制同时在SNN和ANN中获得了广泛的组合优化优势,对进一步深入探索类脑局部计算具有很大的启示性。生物智能计算的本质,很可能就是灵活融合多类微观、介观等可塑性机制的自组织局部学习,结合遗传演化赋予的远程投射网络结构,实现高效的全局优化学习效果。该工作可以进一步引导生物和人工网络的深度融合,最终实现能效比高、可解释性强、灵活度高的新一代人工智能模型。

相关工作(Self-backpropagation of synaptic modifications elevates the efficiency of spiking and artificial neural networks)于2021年10月20日在线发表于《科学》子刊《Science Advances》上。中国科学院自动化研究所类脑智能研究中心张铁林副研究员为第一作者,徐波研究员为通讯作者,程翔(博士生)、贾顺程(博士生)、蒲慕明研究员和曾毅研究员为共同作者。相关研究工作得到了国家自然科学基金委、先导B等项目的资助。

相关论文地址见:

https://www.science.org/doi/10.1126/sciadv.abh0146

▲图1. SBP在SNN中的应用。

(A)SBP可塑性机制 (B)SBP在SNN中的局部反向传播 (C)SBP和其它可塑性机制在SNN中的组合优化。

▲图2. SBP在RBM中的应用

(A)SBP和BP在RBM中的组合优化(B)SBP和BP的交替协作流程(C)RBM中的标准Sleep Phase(D)含有SBP的Wake Phase(E)含有BP的Wake Phase

▲图3. 训练能量消耗的计算方法

(A)平均迭代次数 (B)每次迭代中的算法复杂度

▲图4. 在MNIST、NETtalk、DvsGesture三个数据集上的性能对比

(A,C,E)SBP分别取得了基于梯度和基于可塑性方法的SNN最优性能

(B,D,F)SBP分别取得了基于梯度和基于可塑性方法的SNN最低能耗。

▲图5. SBP有助于RBM提升精度和降低能耗

(A-C)在MNIST数据集中,SBP可以少量降低RBM的训练误差。(A)可以同时平衡精度和能耗得到最优的Wake Phase次数(B)且可以显著降低训练能耗(C)。

(D-I)在NETtalk和DvsGesture数据集中,SBP得到了和在MNIST中类似的结论。

[1] Fitzsimonds, R. M., Song, H. J. & Poo, M. M. Propagation of activity-dependent synaptic depression in simple neural networks. Nature 388, 439-448, (1997).

[2] Du, J. L. & Poo, M. M. Rapid BDNF-induced retrograde synaptic modification in a developing retinotectal system. Nature 429, 878-883, (2004).

[3] Du, J. L., Wei, H. P., Wang, Z. R., Wong, S. T. & Poo, M. M. Long-range retrograde spread of LTP and LTD from optic tectum to retina. Proceedings of the National Academy of Sciences of the United States of America 106, 18890-18896, (2009).

[4] Bi, G. & Poo, M. Synaptic modification by correlated activity: Hebb's postulate revisited. Annual Review of Neuroscience, 24, 139-166, (2001).

欢迎后台留言、推荐您感兴趣的话题、内容或资讯!

如需转载或投稿,请后台私信。