模型只要「变大」就能直通AGI?马库斯再次炮轰:三个危机已经显现!

![]()

新智元报道

新智元报道

【新智元导读】模型只管变大,剩下的交给天意?

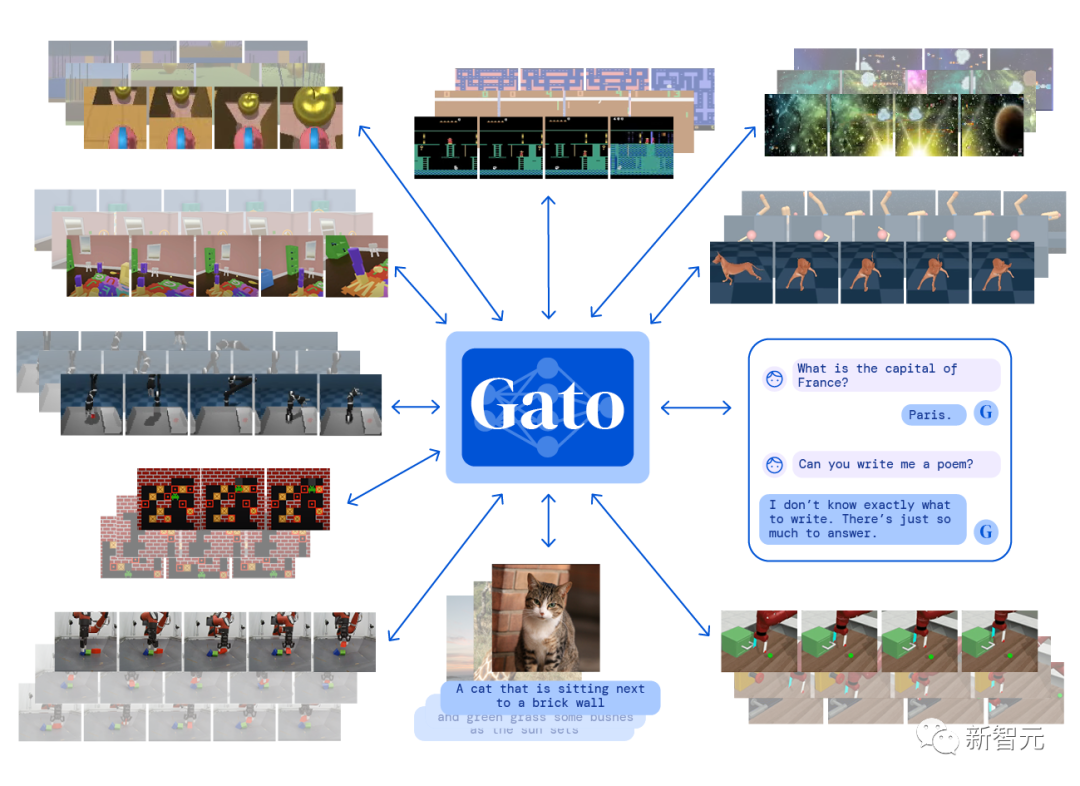

今年5月,DeepMind发布了一个多模态人工智能系统Gato,仅靠一套模型参数即可同时执行600多种不同的任务,一时引起行业内对通用人工智能(AGI)的热议。

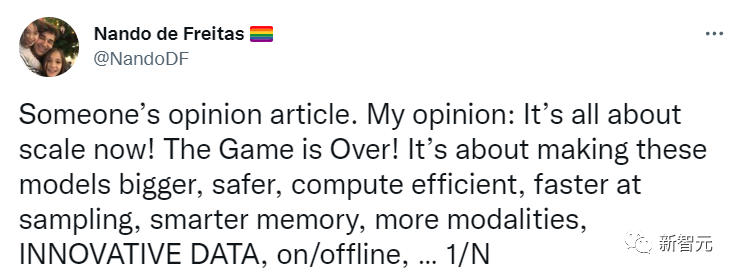

DeepMind的研究部主管Nando de Freitas当时还发了一个推特表示,只要不断提升规模(scale)就能把AI给通关了!

我们要做的只是让模型更大、更安全、计算更有效率、采样更快、更智能的存储、更多模态、在数据上创新、在线/离线等。

只要解决规模上的问题就能抵达AGI,业界需要多关注这些问题!

最近,著名AI学者、Robust.AI的创始人兼 CEO 、纽约大学的名誉教授Gary Marcus又发表了一篇博客,认为这种说法「为时太早了」,并且已经开始出现危机了!

Marcus对AI行业发展持续关注,但对AI的炒作持批判态度,曾表达过「深度学习撞墙」、「GPT-3完全没意义」等反对意见。

大模型玩不下去怎么办?

大模型玩不下去怎么办?

Nando认为,人工智能不需要进行范式转变,只需要更多的数据、更高的效率和更大的服务器。

Marcus把这个假设转述为: 如果没有根本性的新创新,AGI可能会从更大规模的模型中产生。这个假设也可以称之为「规模超越一切」(scaling- über-alles)。

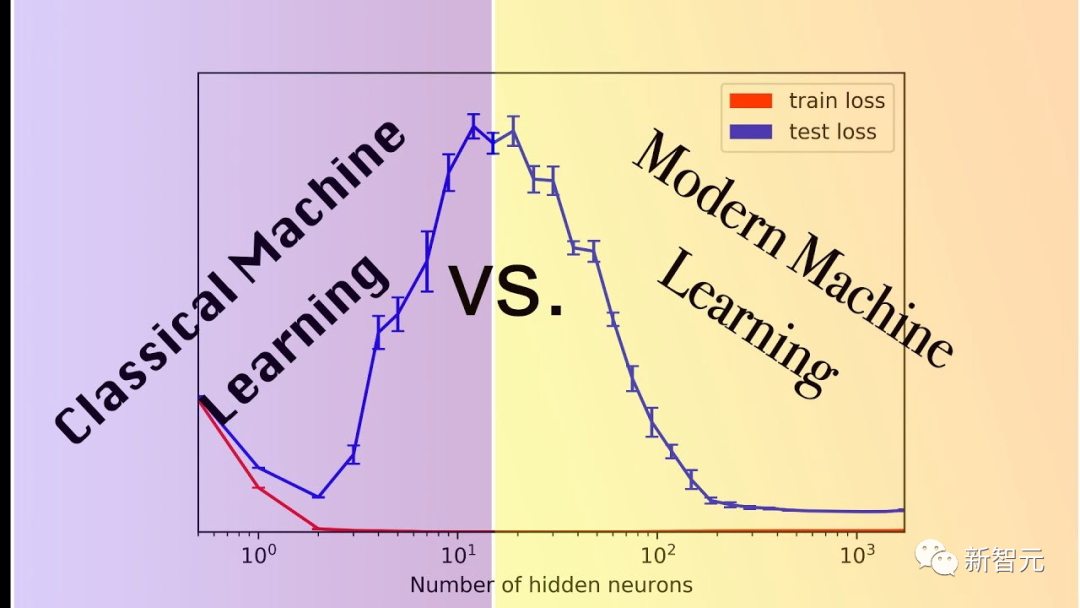

他的假设,现在通常被称为规模最大化(scaling maximalism),仍然非常流行,很大程度上是因为越来越大的模型确实性能很强,比如图像生成等任务都需要借助大模型。

但也仅仅是到目前为止。

问题在于,数月乃至数年来不断提高的一些技术,实际上远远不能达到我们所需要的那种规模。

庞氏骗局越来越多,规模带来的性能优势只是经验观察得出的结果,无法确保正确。

Marcus分享了三个最近看到的前兆,可能预示着规模最大化假说可能将要终结。

1. 世界上可能没有足够的数据量来支持规模最大化。

这点很多人已经开始担心了。

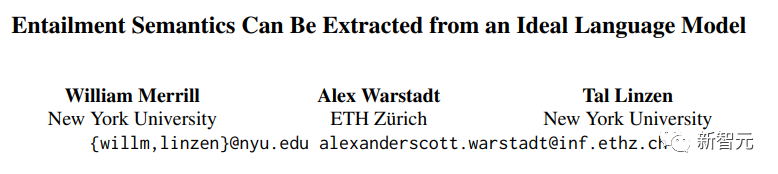

来自纽约大学和苏黎世联邦理工大学的研究人员William Merrill、Alex Warstadt和Tal Linzen最近提出了一个证明,称「目前的神经语言模型不太适合在没有大量数据的情况下提取自然语言的语义」。

论文链接:https://arxiv.org/pdf/2209.12407.pdf

尽管这个证明中包含了太多的前置假设,以至于无法被当作一个反驳证据,但是如果这个假设接近正确的话,那么在规模上可能很快就会出现真正的麻烦。

2. 世界上可能没有足够的可用计算资源支撑规模最大化。

Miguel Solano最近给Marcus寄来了一份合作撰写的手稿 ,作者认为,要想达到当前的超级基准,例如BIG-bench,将会需要消耗2022年全美国电力消耗的四分之一还多。

仓库链接:https://github.com/google/BIG-bench

BIG-bench是一个众包的基准数据集,旨在探索大型语言模型并推断其未来的能力,其中包含200多个任务。

3. 一些重要的任务可能根本无法在规模上扩展。

最明显的例子是最近由Ruis, Khan, Biderman, Hooker, Rocktäschl和Grefenstette共同完成的一项语言学任务,他们研究了语言的语用含义。

比如对于问题「你留下指纹了吗?」,收到回答可能是「我戴了手套」,其语义是「不」。

正如Marcus长期以来所主张的那样,在没有认知模型和常识的情况下让模型意识到这一点真的很困难。

规模在这类任务中基本没什么作用,即使是最好的模型也只有80.6%的准确率,对于大多数模型来说,规模的效果最多只能忽略不计。

并且,你可以很容易地想象出该任务的更复杂版本,模型的性能还会进一步降低。

更让Marcus深受打击的是,即使是像这样单一的重要任务,约80%的性能也可能意味着规模的游戏无法继续玩下去。

如果模型只是学会了语法和语义,但是在语用或常识推理方面失败了,那么你可能根本就无法获得可信任的AGI

「摩尔定律」并没有像最初期望的那样带领我们走得那么远,那么快,因为它并不是宇宙的因果定律,永远成立。

规模最大化只是一个有趣的假设,它不会让我们抵达通用人工智能,比如上述三个问题的解决将会迫使我们进行范式转换。

网友Frank van der Velde表示,规模最大化的追随者往往倾向于使用「大」和「更多」这样模糊的术语。

与人类在学习语言中使用的训练数据相比,深度学习模型用到的训练数据太大了。

但与人类语言真正语义集合相比,这些所谓的海量数据仍然微不足道,大约需要100亿人每秒生成一句话,持续300年才有可能得到这么大规模的训练集。

网友Rebel Science更是直言,规模最大化不是一个有趣的假设,而是一个愚蠢的假设,不仅会输在AI这条赛道上,而且还会死的很难看。

规模最大化过于极端

规模最大化过于极端

哥伦比亚大学哲学系讲师、牛津大学博士Raphaël Millière在「规模最大化」问题争斗最激烈时也发表了一些自己的看法。

规模最大化曾经被看作是深度学习批评家的抓手(比如Gary Marcus),随着行业内人士如Nando de Freitas和Alex Dimakis加入争论,两方吵得不可开交。

从业者的反应大多喜忧参半,但并非过于消极,同时预测平台Metaculus上对AGI实现的预测日期已经提前到了历史最低点(2028年5月) ,这也可能增大了规模最大化的可信度。

人们对「规模」逐渐信任可能是由于新模型的发布,诸如PaLM, DALL-E 2, Flamingo和Gato的成功为规模最大化添了一把火。

Sutton 的「Bitter Lesson」在关于规模最大化的讨论中抛出了很多观点,不过并非完全等价,他认为将人类知识构建到人工智能模型(例如,特征工程)中的效率低于利用数据和计算来学习的效率。

文章链接:http://www.incompleteideas.net/IncIdeas/BitterLesson.html

虽然并非没有争议,但Sutton的观点似乎明显没有规模最大化那么激进。

它确实强调了规模的重要性,但是并没有把人工智能研究中的每一个问题简化为仅仅是规模的挑战。

事实上,很难确定规模最大化的具体含义,从字面上理解,「Scaling is all you need」表明我们不需要任何算法创新或者架构变化就能实现 AGI,可以扩展现有的模型,并强制输入更多的数据。

这种字面上的解释看起来很荒谬: 即使是像 PalM、 DALL-E 2、 Flamingo或者Gato这样的模型也仍然需要对以前的方法进行架构上的改变。

如果有人真的认为我们可以将现成的自回归Transformer扩展到 AGI,那真的会让人感到惊讶。

目前还不清楚认同规模最大化的人觉得AGI需要多大程度的算法创新,这也使得从这一观点很难产生可证伪的预测。

扩大规模可能是构建任何应该被贴上「通用人工智能」标签系统的必要条件,但是我们不应该把必要误认为是充分条件。