ReadHub及近似内容识别

最近这几天,在试用 @Fenng 的新产品ReadHub(readhub.me),我个人看起来ReadHub要解决的问题比较类似于Techmeme,是一个内容的快速过滤器。Techmeme是个老古董了,从当年Web2.0热潮算起已经十年过去了,一直不算太火,但在小圈子里口碑很好,有不少大佬级的忠实读者,比如扎克伯格[1]。我估计应该有不少年轻读者没听说过Techmeme的,但我和Fenng这个年纪的,肯定都对这个事情太熟悉了,当年国外的google reader share、digg、techmeme、reddit,国内的抓虾、鲜果、无觅、豆瓣九点、玩聚,等等一大票产品,前仆后继地都在试图解决类似的信息过滤的问题。尤其是当年国内博客圈关于这类产品的blog讨论,很令人怀念的一段时光。后来差不多从11年开始,国外是reddit一骑绝尘,国内是今日头条一统江湖。我早年也是干这个的,但我不想再提了,全是泪。

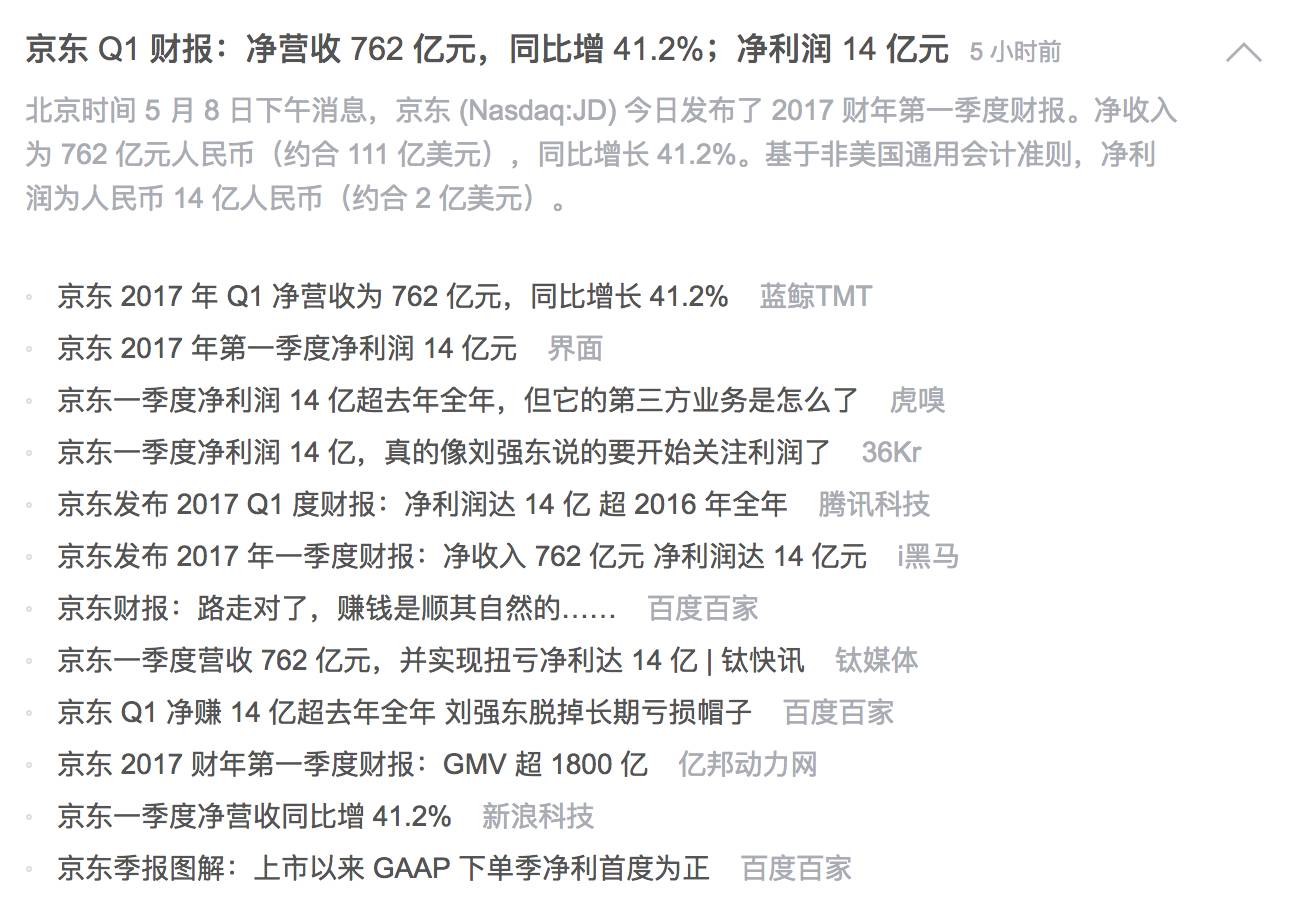

ReadHub有个重要的基础功能,就是合并意思差不多的内容,类似ReadHub下图这样的。

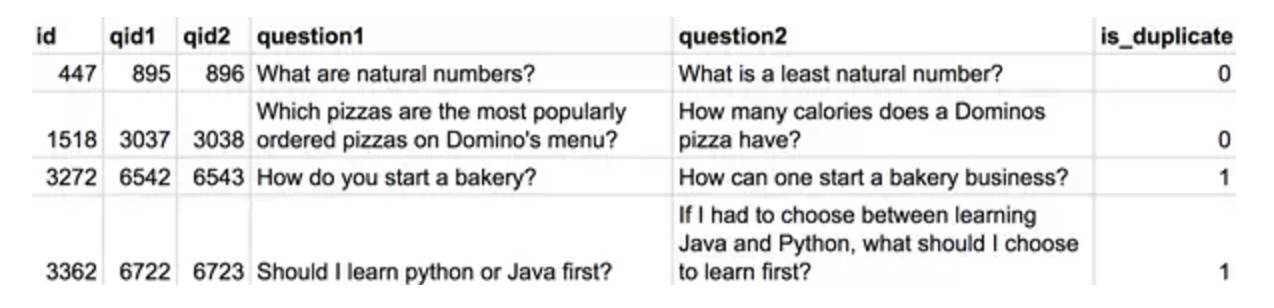

早年这些事情我都干过,所以就突然想看看类似的事情在深度学习下有没有什么新解法。搜索了一下,发现了Quora的一篇文章,“Semantic Question Matching with Deep Learning”[2],Quora现在已经不仅仅是停留在文本相似度量上了,而是要把“意图”相似的问题都识别出来,比如,“What are the best ways to lose weight?”、“How can a person reduce weight?”、“What are effective weight loss plans?” 这三个问题,都是关于“如何有效减肥”的,Quora认为这三个属于意图重复的问题,应该合并。Quora公布了一个数据集[3],包含400,000个“问题对”,并且标注好了是否重复,如下图。

所有人都可以下载这份儿数据集,训练个模型试着解一解这个问题。感兴趣的同学建议仔细读一下这篇文章。另外,Quora的机器学习平台及内容质量团队的Leader,Nikhil Garg,在QCon2016上也给出了这个问题更详细的一些资料。

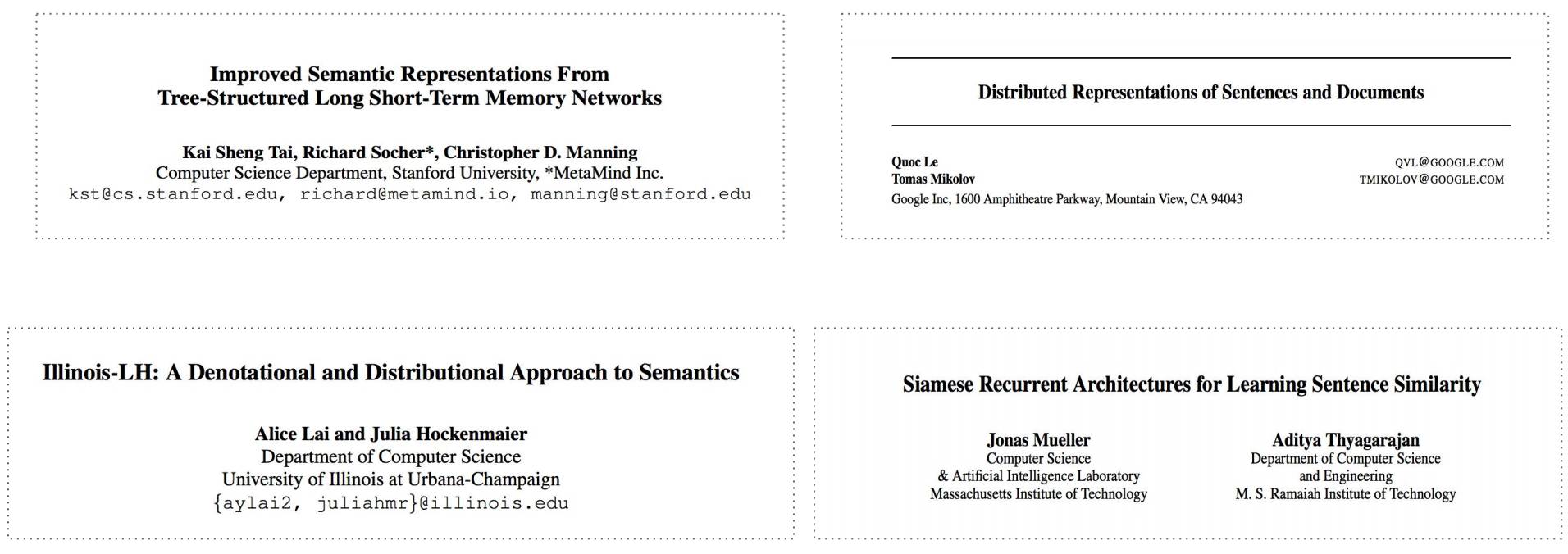

1、关于这个问题相关的最新研究进展。

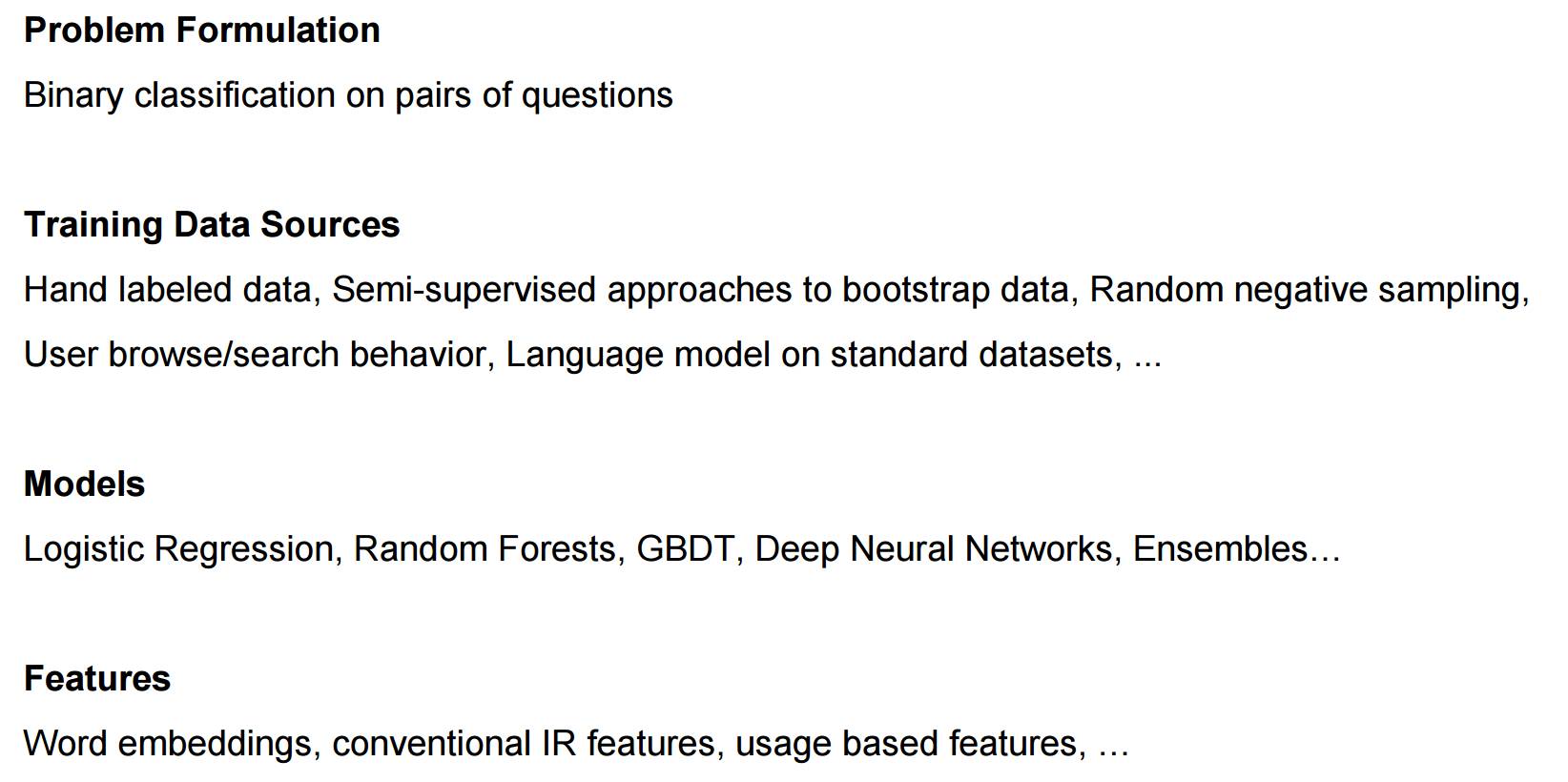

2、Quora自己的方案划重点。

Quora很看重这个事情,认为重复问题会造成下面这些不好的影响,

回答问题的“效能”被分散了。本来可以在一处集中讨论,会被重复问题分散到各处。

用户不得不做付出额外的代价,搜索并查看大量的问答页面。

近似的问答内容在用户Feed里面反复出现,体验很差。

无法提供一个统一的“最佳答案”页面给用户。不光用户体验不好,对搜索引擎排名也非常不利。

Nikhil Garg的PPT[4]还有很多料。

Duplicate Question Detection

Answer Ranking

Topic Expertise Detection

Moderation

结合ResysChina之前的文章“Quora是如何做推荐的?”一起看,效果更佳!

参考资料:

[1] https://www.buzzfeed.com/charliewarzel/meet-the-man-who-shapes-techs-narrative

[2] https://engineering.quora.com/Semantic-Question-Matching-with-Deep-Learning

[3] https://data.quora.com/First-Quora-Dataset-Release-Question-Pairs

[4] https://qconsf.com/sf2016/system/files/presentation-slides/scaling_quality_using_machine_learning_-_qcon_sf_2016.pdf

★ 猜你喜欢:「Amazon的推荐系统到底行不行?」

最后再推荐一下ReadHub(readhub.me),清爽、简单、有效率,推荐大家都去试试看,点击阅读原文即可访问。

iOS读者赞赏