预、自训练之争:谷歌说预训练虽火,但在标注数据上自训练更有效

作者:Quoc V. Le等人

机器之心编译

参与:魔王、杜伟

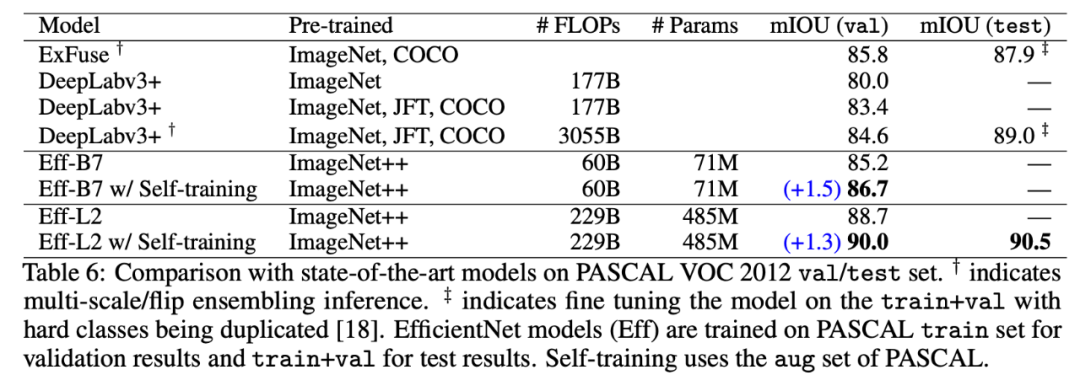

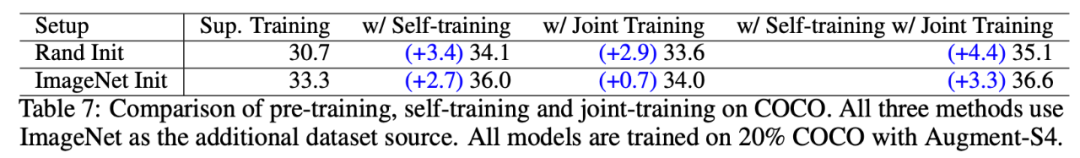

预训练是当前计算机视觉领域的主要范式,但何恺明等人先前的研究发现,预训练对目标检测和分割任务的影响有限。因而,重新探究预训练和自训练的效果成为一个非常重要的课题。在这篇谷歌团队的论文中,Quoc V. Le 等研究者发现,当具有大量的标注数据时,自训练的运行效果要优于预训练,并在 COCO 检测和 PASCAL 分割任务上实现了 SOTA 结果。

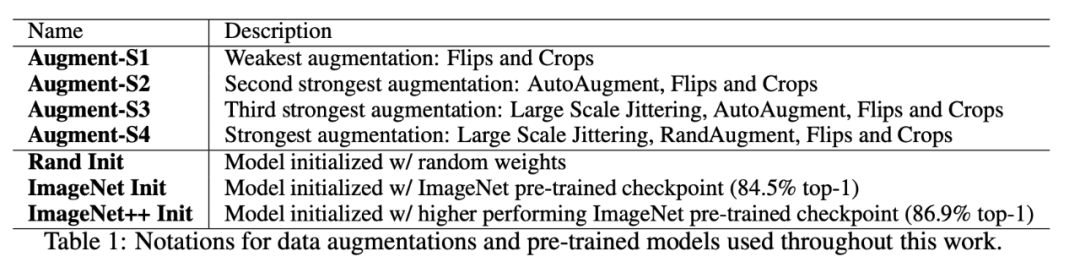

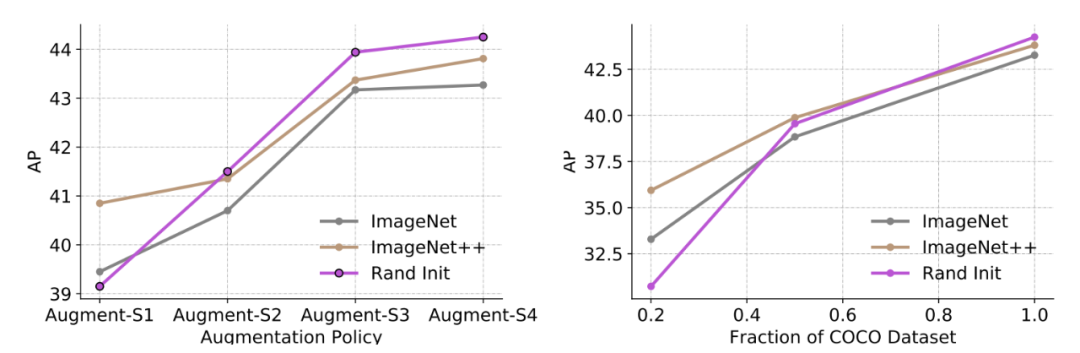

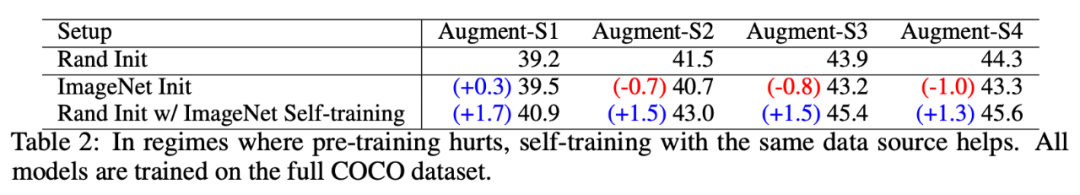

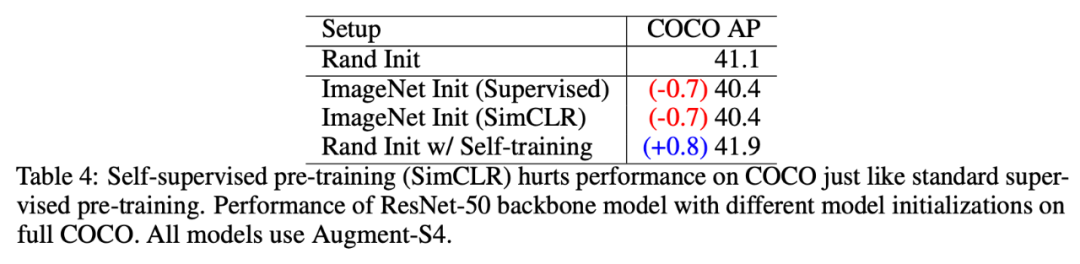

更强的数据增强和更多标注数据,却使得预训练的价值降低;

与预训练不同,在提供更强大的数据增强时,自训练通常起到积极作用,不论是在低数据机制还是高数据机制下;

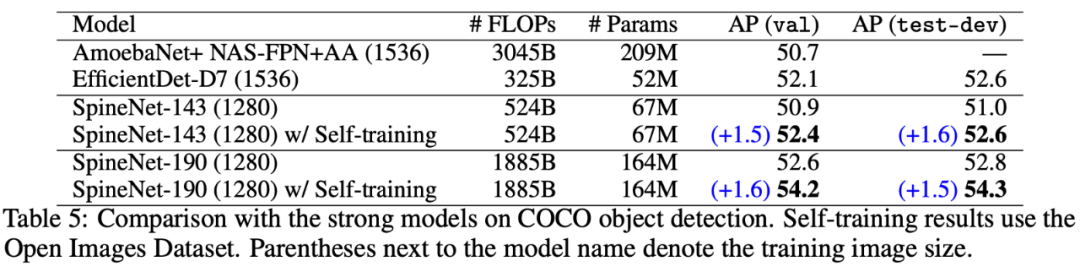

在预训练有用的情况下,自训练比预训练更有用。

灵活性:自训练可以很好地应对实验中的每一种设置,如低数据、高数据、弱数据增强和强数据增强。同时自训练对不同的架构(ResNet、EfficientNet、SpineNet、FPN、NAS-FPN)、数据源(ImageNet、OID、PASCAL、COCO)和任务(目标检测、分割)都有效;

通用性:对于预训练失败或成功的场景,自训练都能够应对;

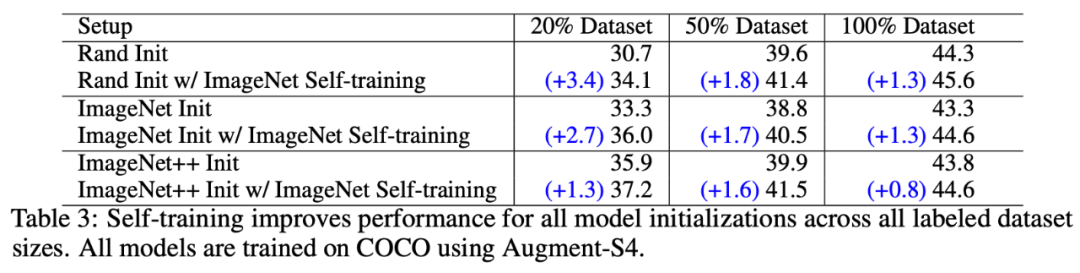

可扩展性:在使用更多标注数据和更好模型时,自训练也能实现优秀的性能。

登录查看更多

相关内容

Arxiv

6+阅读 · 2018年6月7日

Arxiv

10+阅读 · 2018年5月10日