基于深度学习的艺术风格化研究【附PDF】

关注本公众号

回复“廖菁”获取报告PDF

报告人介绍

廖菁

香港城市大学计算机科学系 助理教授

廖菁博士,获浙江大学和香港科技大学双博士学位;毕业后曾工作于微软亚洲研究院,担任视觉计算组研究员,主要研究方向为计算机图形学、计算机视觉、图像视频处理等;现任香港城市大学计算机科学系助理教授。

报告内容

基于深度学习的艺术风格化研究的主要目的在于探索AI的创造力,通过利用AI从一些人类创造的样本和数据中学习,获得艺术再创作的能力。本次报告主要分享AI在绘画和摄影方面的再创作能力的一些探索。

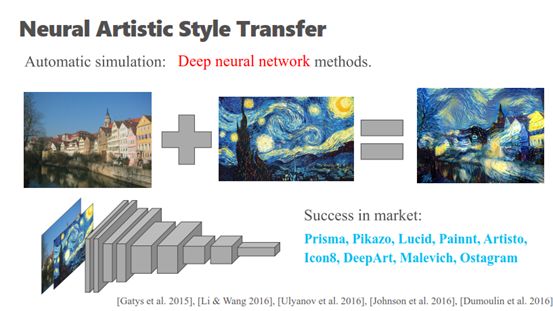

现在已经有很多APP实现了利用AI进行艺术再创作的功能。例如,2016年苹果的销售榜冠军的APP,Prisma,这款APP将用户给定的一张照片转换成一些预设的风格,达到了一种很酷的滤镜的效果;再有一些APP可以把艺术滤清的效果应用到视频上;甚至一些APP可以通过学习用户绘制的线绘图,实现预测的功能;除此之外,有些APP还提供了一些譬如现稿上色和填充纹理这些便于艺术家进行艺术创作的工具;

前段时间的电影《至爱梵高》,是一部由125位艺术家花费6年时间,通过逐帧去模拟梵高的绘画风格所完成的;今天能否通过AI来自动的学习这些艺术风格,而不是需要人来学习以及临摹,是一个重要的研究方向。

艺术风格迁移是指通过深度神经网络将一种图像的风格转换到其他图像上的工作,例如,利用深度神经网络学习梵高的星空的绘画技法,并自动的应用到其他图像(例如照片)上,使其他图像的风格与梵高的星空的艺术风格一致。

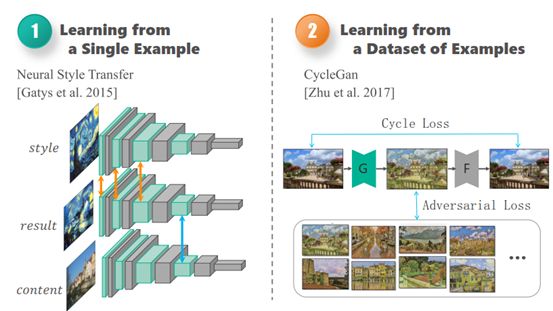

实现艺术风格迁移主要包括从单张图片中学习和从一组图片组成的数据集中学习两种形式,其中从单张图片中学习的开创性工作是在2015年由Gatys提出,叫做neural style transfer;主要思想是利用已经在imagenet上预训练好的一些经典的图像识别网络,例如(VGG16/VGG19、googlenet、resnet等),图像识别网络具有一个重要的特点,网络层级越高,与图像识别任务无关的信息被过滤的越多,例如图像的风格信息,网络越集中提取图像的语义信息,因此利用这个特性,实现图像的风格和内容的分离,继而完成重组,进行图像风格的转化;

但是从单张图片学习的效果有限,例如网路从单张图片中学习梵高画星空的技法无法直接应用到梵高自画像,为了克服这个问题,从多张图片组成的数据集中学习的方法被提出,其中一种典型的工作是基于GAN实现图像的艺术风格化迁移,GAN主要由一个生成网络和一个判别网络构成,生成网络用于生成与指定艺术风格接近的图像,判别网络用于区别生成的图像和真实的艺术风格图像,基于这样的对抗性训练的方式让生成器生成出来的结果逐步地接近指定艺术风格。

本次分享主要分成三个方面:

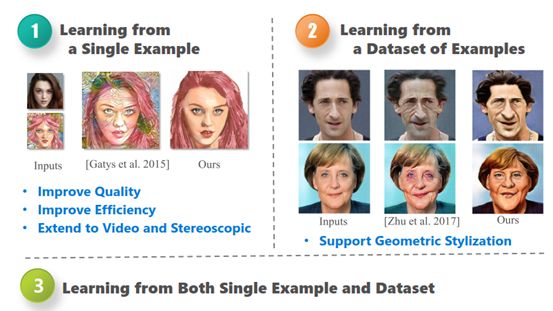

第一个方面从单张图像学习出发,提出使转化效果更好的新方法,以及如何设计网络结构提升转化速度,然后将图像的风格转化,扩展到视频以及立体视觉的图像和视频上;

第二个方面重点介绍如何让网络从多张图片组成的数据集中学习的同时,实现几何形变,现有的一些方法,例如Cycle-gan只能学习图像表征上面的一些风格,不支持几何形变,然而几何变形在艺术创造当中是非常重要的;

最后介绍如何融合单张图像学习和多张图像学习这两种形式,使网络既能通过单张图像学习的方式给用户一定的交互性,让用户控制生成的图像样子,同时保持网络从多张图像学习的能力。

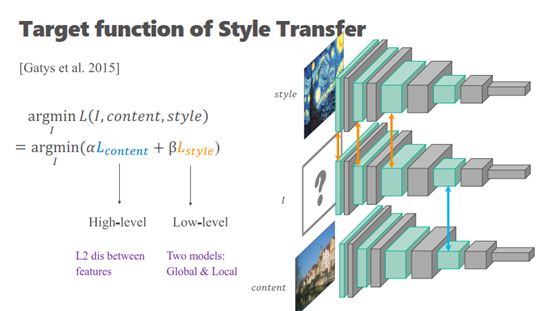

下面逐一介绍这三个方面的工作,先看第一个方面的工作,重点关注这类型的学习方式生成的图像质量;这方面的传统做法,包括2015年gatys提出的方法,正如前面所说,图像识别网络的高层学习到图像的内容信息,例如语义,类别等比较高层的信息,底层学习到的特征图主要对应图像颜色,纹理,笔刷等比较底层的信息,根据这个性质,利用深度图像识别网络可以实现图像的内容和风格的分离;

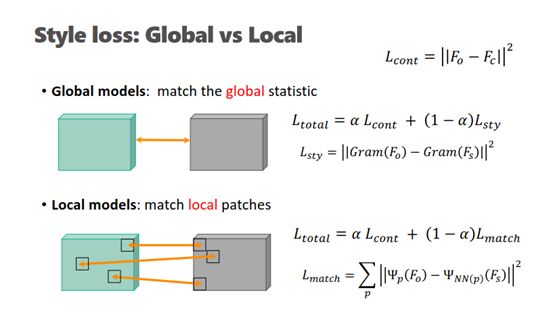

首先输入两种图像到网络中,一张图片称为内容图像,网络学习这张图像的内容信息,另一张是风格图像,网络学习这张图像的风格,最后需要保证生成的图像经过这个网络,得到的高层信息与内容图像经过网络得到的高层信息一致,如蓝色线所示,底层信息和风格图像经过网络得到的底层信息一致,如橘黄色线段所示,基于这个思路,让网络学会生成特定艺术风格的图像;具体实现中,高层特征的相似性主要通过L2距离约束;而底层特征的相似性实现主要包括全局相似和局部近似两种约束形式;

全局相似衡量图像之间统计意义上的相似性,跟局部对应没有关系;局部近似主要通过统计两个特征图的局部图像块之间的相似性。这两种方式分别与图形学里面纹理合成的参数化模型和非参数化模型相似,主要区别在于深度网络提高了提取的图像特征的表达性;原始的纹理合成的作用对象是图像空间,这里转移到了特征图空间。因此,全局相似和局部近似的区别与纹理合成中的这两种方式区别是一致的。

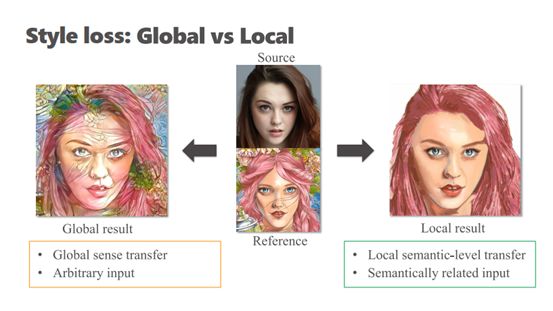

由于全局相似模型学习的是图像的整体信息,要求生成的图像整体上和指定风格的图像相似,会造成将很多背景上面的纹理分布到脸上去的情况;而局部近似是为每个小块找最合适的图像块,最后生成的效果,会把画眼睛的这种方式学习到眼睛上面,把画嘴巴的方式学习到画嘴巴上面,克服了全局相似的缺点,但是由于需要为每一个小块找对应的最合适的图像块操作,前提要求两张图像是有对应,因此需要输入的两幅图像对应,例如都是风景图,全局相似则不需要这种限定。

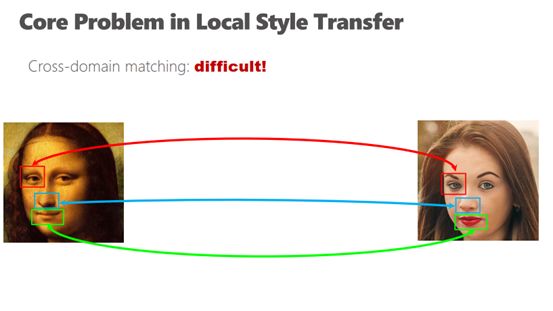

当两幅艺术作品其中一幅是画,另一种是照片,由于画和照片之间的颜色和纹理差异巨大,直接利用局部近似模型实现转换难度很大,为了解决这个问题,提出了一种新的基于局部近似的方法。

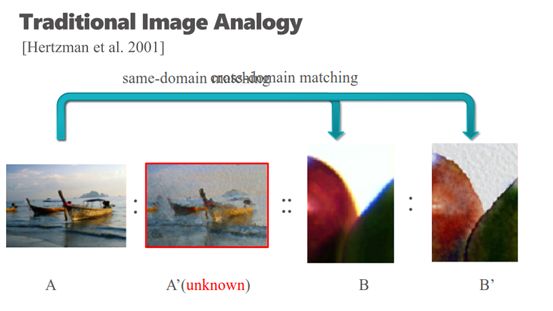

Hertzman在2001年的一项工作通过借助另外一张水粉画对应的照片实现了照片和水粉画之间的风格转换,这样引入中间图映射的思想降低了照片和水粉画之间之间映射的难度,但是该方法的局限性在于需要有额外的照片和对应的水粉画图像对的数据集,现实情况下很难获取到满足条件的图像对。

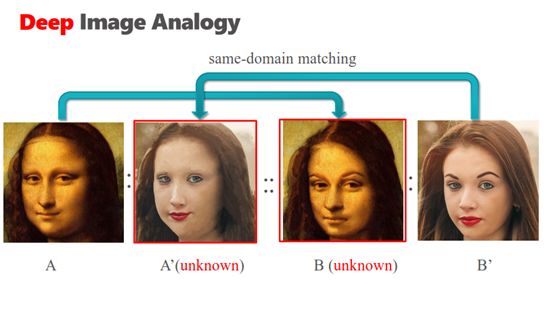

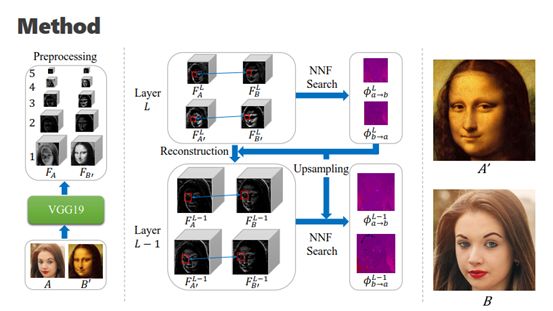

受到这项工作的启发,为了实现蒙娜丽莎和照片之间的风格转换,需要得到蒙娜丽莎的照片,但是现实中无法获取到蒙娜丽莎对应的真实的照片,由于深度神经网络的高层特征与风格无关,只和内容有关,因此蒙娜丽莎的画和蒙娜丽莎的照片在网络最高层的特征是相等的。

所以从最高层开始,两张桥梁图片A’和B的特征近似等于A和B’的特征,并在这四个特征中每一个域domain之间根据NNF的方式得到特征对齐的映射函数,然后通过高层的映射函数给底层的特征融合提供指导,进一步优化底层的映射函数,最终实现从最高层到底层的逐步优化实现最终的风格迁移。

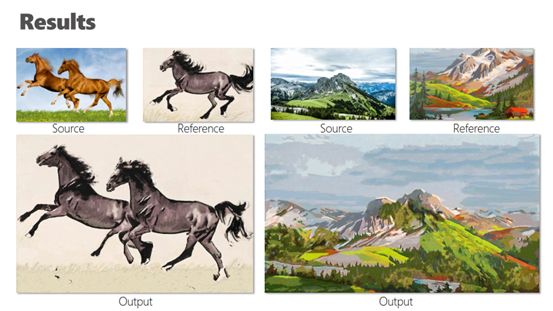

最终的效果图对原画的保真度更好,但是基于局部相似的模型需要输入的内容和风格图像语义一致,例如上图中内容图像是马,风格图像也必须是马。

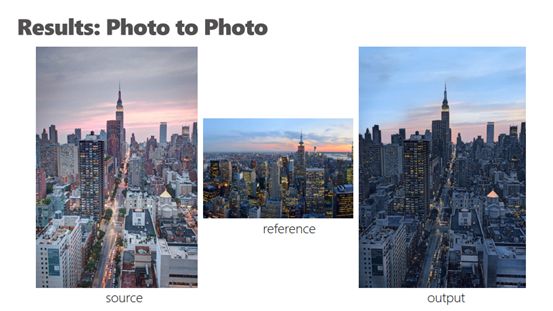

在实现摄影作品的图像转换时,局部方法需要加一个约束,之前的方法是把图像里面一个patch整个粘贴过来,但是这样会失去这一张图原来的细节的保真度,因此需要每一个patch之间的颜色转换满足一个仿射变换约束,避免转换过程中的走样。

将一幅图像打乱既满足全局模型,也满足局部模型,因此通过向局部模型中加入参数约束patch的使用次数实现全局模型和局部模型的融合。当参数极大的时候近似约束patch只能使用一次,这样模型与全局模型近似;如果这个参数极小的话,相当于对patch使用次数没有约束,模型近似是一个局部模型。

通过设定一个软约束实现了模型的自适应,不再需要输入的内容和风格图像语义上的一致性条件,同时达到了近似局部模型的效果。

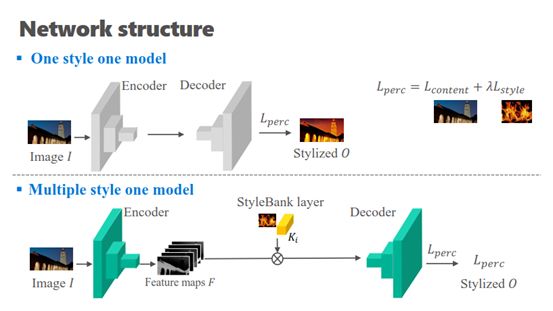

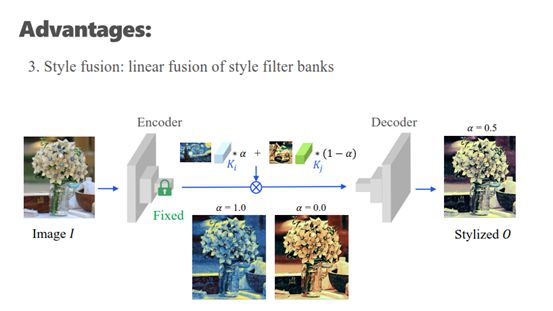

为了提高模型预测时的速度,提出styleBank layer,训练时分成两个支路。 一条支路不加styleBank layer,网络通过Encoder-Decoder结构重建网络的输入图像;另一条加入T个styleBank layer,每个styleBank layer是代表特定风格的kernel,整个网络以T+1的模式进行。测试时选择需要的风格进行测试。

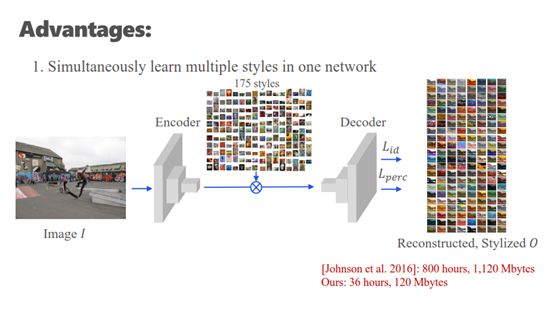

整个网络的设计类似于插件,允许同时训练不同的Style,我们试过同时训练175个Style。传统的方法用800多个小时才能训练好,而这种方式只需要36小时

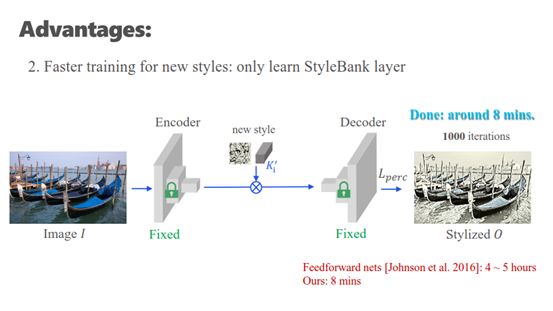

同时风格非常容易更新,固定两个主网络,只训练特定的styleBank layer,只需要8分钟就可以新增加一个style。但是训练整个网络的话,需要4-5个小时。

网络也便于通过风格之间的插值创造新的风格。

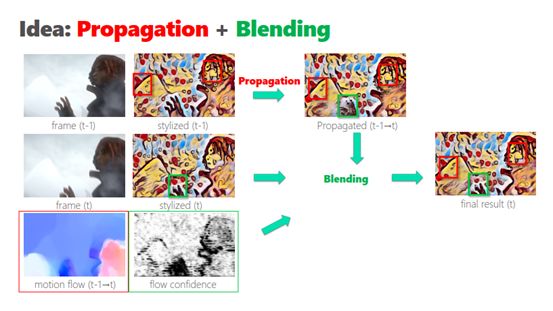

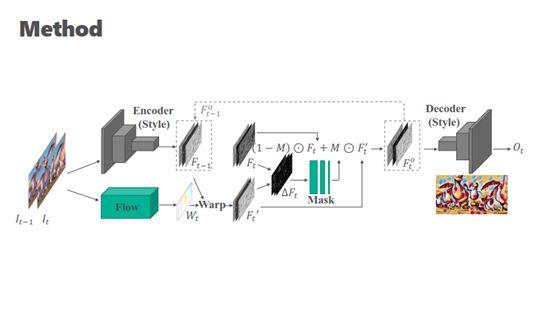

当对视频进行风格转换时,逐帧处理视频帧会因为没有建立帧与帧之间的联系造成抖动和跳动,为了得到稳定的生成结果,向网络中加入时间上的约束,融合两帧之间的光流和置信度信息。

同样时间约束可以用到立体视觉中,得到左右眼更加一致的虚拟体验。

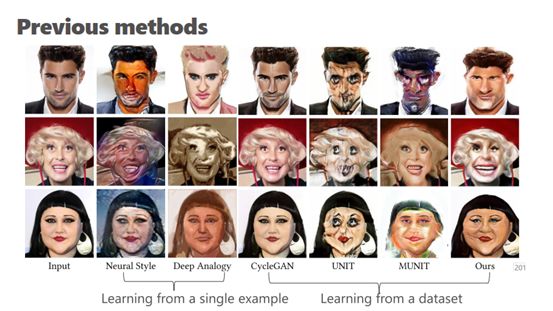

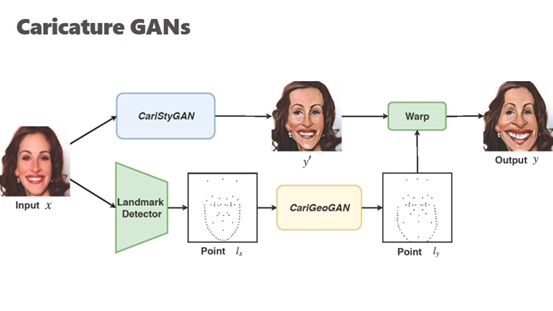

下面介绍第二个方面的工作,现有的基于GAN的方法很难同时完成图像的风格迁移和几何夸张,为了实现风格迁移和几何夸张的统一,提出Caricature GAN。

Caricature GAN网络结构主要包含两个GAN子网络,一个子网络主要学习图像风格迁移,另一个子网络学习几何夸张。

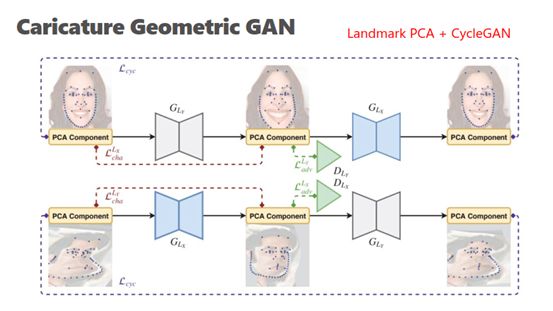

学习几何夸张的GAN子网络是一个类似cyclegan的结构, 区别在于网络的输入是通过PCA降维得到的一系列人脸表征关键点。

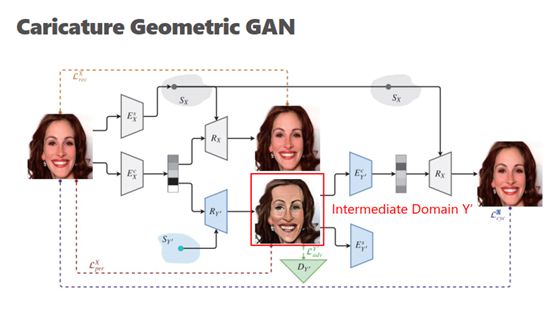

学习风格迁移的GAN子网络主要是一个类MUNIT结构,实现了图像内容表征和风格表征之间的分离。

两个自网络通过几何形变(warp)来联通。通过这样的结构,很好的融合了图像风格迁移和几何夸张的效果。

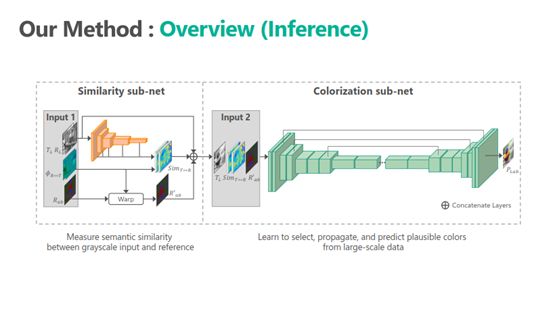

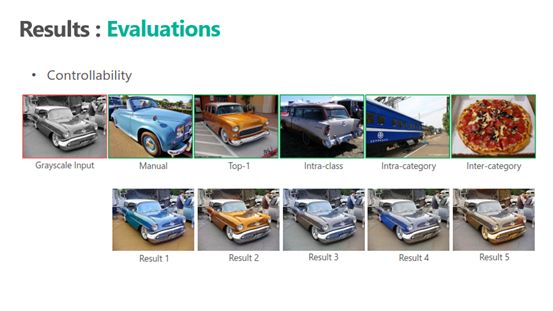

接下来介绍第三个方面的工作,主要利用单张图像和数据集实现黑白图像的自动上色;

网络由两个子网络构成,第一个子网络衡量黑白图像和单张参考图像的相似性,第二个网络从数据集中学习通用的上色技巧。

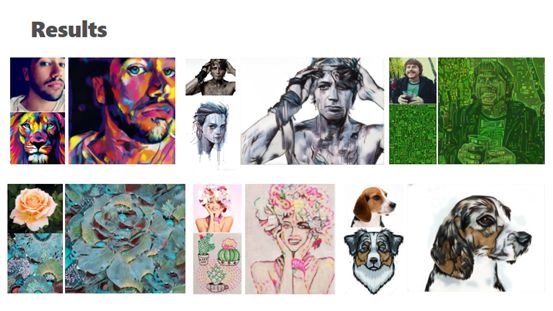

最后的效果图。

Reference

[1] visual Attribute Transfer through Deep Image Analogy,In Siggraph 2017

[2] Neural Color Transfer between Images,In TOG 2018

[3] Arbitary Style Transfer with Deep Feature Reshuffle,In CVPR 2018

[4] styleBank:An Explicit Representation for Neural Image Style Transfer,In CVPR 2017

[5] Coherent Online Video Style Transfer,In ICCV 2017

[6] Stereoscopic Neural Style Transfer,In CVPR 2018

[7] CariGANs:Unpaired Photo-to-Caricature Translation,In Siggraph Asia 2018

[8] Deep Exemplar-based Colorization,In Siggraph 2018

@中国图象图形学学会CSIG

版权声明

本文版权归《中国图象图形学学会CSIG》,转载请自行联系。

点击下方阅读原文了解课程详情

历史文章推荐:

基于深度学习的图像超分辨率最新进展与趋势【附PDF】

t-SNE:最好的降维方法之一

年龄估计技术综述

从Word Embedding到Bert模型—自然语言处理中的预训练技术发展史

SFFAI分享 | 曹杰:Rotating is Believing

SFFAI分享 | 黄怀波 :自省变分自编码器理论及其在图像生成上的应用

AI综述专栏 | 深度神经网络加速与压缩

SFFAI分享 | 田正坤 :Seq2Seq模型在语音识别中的应用

点击下方阅读原文了解课程详情↓↓

若您觉得此篇推文不错,麻烦点点好看↓↓