【模式国重】计算机视觉重要研究进展

模式识别国家重点实验室

关注

引言

计算机视觉是研究用计算机来模拟人或生物视觉系统功能的学科,其目的是基于图像让计算机能够感知和理解周围世界,具体地说,就是对图像或视频数据中的场景、目标、行为等信息进行识别、测量和理解等。计算机视觉是人工智能的重要研究领域之一。

计算机视觉的前提和基础是成像技术。早在公元前鲁国时代,墨子就已经发现了小孔成像。之后直到19世纪,尼埃普斯(Joseph Nicéphore Nièpce)和达盖尔(Louis-Jacques-Mandé Daguerre)等发明了照相机。随后同世纪,惠斯登(Wheaston)发明了镜面立体装置(mirror stereoscope),证实了双眼视差现象:两个2D图片可以引起3D立体感觉。20世纪40年代,吉布森(Gibson)提出了光流的概念,并提出从二维平面的光流场可以恢复3D空间运动参数和结构参数的假说。20世纪60年代起,Ulf Grenander从数学的角度,整合代数、集合论和概率论,提出Analysis-by-Synthesis的思想,为计算机视觉奠定了重要的开创性的理论基础。同时期在视觉模式识别研究中,傅京孫(King-Sun Fu)提出了句法结构性的表达与计算,支撑了自底向上或自顶向下的视觉计算过程。20世纪70年代,马尔(David Marr)力图用计算机模拟人的视觉过程,使计算机实现人的立体视觉功能。马尔的视觉计算理论立足于计算机科学,并系统地概括了当时心理学、神经科学等方面的重要成就,其重要特征在于使视觉信息处理的研究变得更加严密,把视觉研究从描述的水平提高到有数学理论支撑且可以计算的层级,从此标志着计算机视觉成为了一门独立的学科。自从马尔视觉理论提出之后,计算机视觉得到了快速蓬勃的发展。虽然马尔视觉理论框架存在有不足,时至今日马尔视觉理论依然一直占据着计算机视觉的中心地位。依据马尔计算视觉理论框架,计算机视觉分为底层的图像特征提取与处理,中层的三维计算机视觉,以及高层的物体识别与场景理解。由于马尔视觉理论的系统性和主导性,过去几十年来的重要研究进展,多数集中在该理论框架之下。

2012年ImageNet大规模图像分类挑战赛中,采用的卷积神经网络(CNN)模型的深度学习方法带来了巨大的突破。其后基于深度学习的人脸识别等被广泛应用于各行各业。伴随着计算资源、人工智能的迅猛发展和实际应用的大量需求,马尔视觉理论曾经存在争议的地方有了更明确的解析。例如,对马尔视觉提出批评的“主动视觉”(Active Vision)和“目的和定性视觉”(Purpose and Qualitative Vision)的学者认为视觉过程必然存在人与环境的交互,认为视觉要有目的性,且在很多应用中不需要三维重建过程。但是,随着深度学习与人工智能发展对计算机视觉发展的促进,当今二维视觉的系列任务已经不能满足实际的应用需求,各种深度相机不断出现,二维视觉任务正在往三维拓展,越来越多的三维点云分析与处理的工作正在大量涌现,逐渐验证了马尔视觉理论的正确性。现阶段专用人工智能得到了充足的发展,未来将逐渐迈向通用人工智能的研究阶段。通用人工智能要求有“时间”、“空间”、“推理”的计算能力,马尔视觉理论框架正具备了前二者的能力,再融入“推理”,马尔视觉理论未来将会成为通用计算机视觉智能的基石。而对过去这个框架下的重要研究进展的了解对未来研究的指导也将具有重要意义。

本报告在对过去计算机视觉领域的研究进展进行分析总结的基础上,提炼出对学科发展和应用技术产生了重要影响或推动力的13项研究进展进行介绍。这些重要研究进展体现在计算成像学、初期视觉、图像增强与复原、图像特征提取与匹配、多视几何理论、摄像机标定与定位、三维重建、目标检测与识别、图像分割、图像场景理解、图像检索、目标跟踪、行为与事件分析等方面。

1. 计算成像学

自由空间中传播的光线携带着三维立体世界丰富的信息,是人类感知外部世界最重要的介质和载体之一。光是一种高维信号,不仅自身具有波长𝜆、传播时间𝑡等属性,在自由空间传播过程中还具有位置和方向属性,包括三维坐标(𝑥,𝑦,𝑧)和角度(𝜃,𝜙)。计算成像(Computational Imaging)学结合计算、光学系统和智能光照等技术,将成像系统采集能力与计算机处理能力相结合,创新性地将视觉信息处理与计算前移至成像过程,提出新的成像机制,设计新的成像光路,开发新的图像重构方法,能够在视觉信息的维度、尺度与分辨率等方面实现质的突破,使得对光信号进行高维高分辨率的采样成为可能。

1936年,Arun Gersun开始研究光线在空间中的分布,首次提出了“光场”(Light Field)的概念,用于描述光在三维空间的辐射特性。1991 年 Adelson等人进一步拓展和完善了光场的理论,提出了全光函数(Plenoptic Function),用一个 7D 函数表征光线的空间分布,即𝑃(𝑥,𝑦,𝑧,𝜃,𝜙,𝜆,𝑡)。1992 年 Adelson 等人在全光理论的基础上研制了光场相机原型。忽略光线在传播过程中的衰减(省略𝜆、𝑡),Gortler 等人提出了流明图(Lumigraph)的概念,进一步忽略𝑧,将7D全光函数降维成 4D,即仅用(𝑥,𝑦)和(𝜃,𝜙)四个维度表示一条光线,包含了光线的空间和角度信息。1996年,Marc Levoy和Pat Hanrahan将光场引入计算机图形学,提出了光场渲染理论(Light Field Rendering),并对四维光场进行了双平面参数化。2005年5月,麻省理工学院、斯坦福大学、微软研究院的研究人员在麻省理工学院召开了首届计算摄影学(Computational Photography)研讨会。自2009年,IEEE计算摄影学国际学术会议(IEEE International Conference on Computational Photography)每年举行。斯坦福大学博士吴义仁(Ren Ng)在毕业论文中详细地描述了家用级光场相机的硬件、软件问题和其解决方案,2006年创立创立Lytro公司,并发布了Plenoptic 1.0手持式光场相机,随后又有Raytrix、Pelican等多家公司发布了光场相机,提出了多种不同的光场成像结构。光场理论发展的同时,过去的数十年间国内外各种各样的光场成像设备被研制和开发出来,特别是多种类型的工业级和消费级光场相机相继问世,比较有代表性的光场成像设备设计结构包括:光场采集支架(Light Field Gantry)、相机阵列(Camera Array)、微透镜型光场相机(Microlens-Based Light Field Camera)和可编码孔径相机(Programmable Aperture Camera)。近年来,光场成像技术多被用于VR/AR等沉浸式体验设备。同时,光场成像技术也被用在显微观测中,美国麻省理工学院和奥地利维也纳大学的研究人员使用光场显微镜第一次可在毫秒时间的尺度上,产生整个斑马鱼幼虫大脑的3D影像,相关成果发表在Nature Methods期刊。

相对传统光学成像,光场成像技术是重大技术革新,以其多视角、大景深、多聚焦成像等突出特性为模式识别、计算机视觉等学科的发展与创新带来了新机遇,目前已经在深度估计、三维重建、自动重聚焦、合成孔径成像、分割、识别等视觉任务中得到了应用。除了经典视觉任务外,光场成像还在视觉里程计 (Visual Odometry)、场景光流估计(Scene-Flow Estimation)、相机转动(Camera Rotation)估计和视频防抖(Video Stabilization)、全景拼接(Panoramic Stitching)等视觉任务中得到了一定程度的应用。

除了光场相机以外,考虑光线空间位置和传播方向的成像技术还有编码成像、散射成像、全息成像等典型代表。从光线传播的时间、相位维度进行光场的采集,则有单光子成像、飞行时间(ToF)成像等手段,而从波长、光谱层次进行研究,则衍生出可见光、近红外、高光谱等多种成像技术,另外还有利用光线的波动属性进行成像,例如偏振成像等。

2. 初期视觉

人类的视觉信息处理包括初期视觉和高层视觉,初期视觉主要通过分析输入的视觉信号变化来获取物体的位置、形状、表观和运动等信息,基本不涉及场景信息的语义理解。类似于人类的视觉信息处理过程,计算机视觉也分为初期视觉和高层视觉,其中的初期视觉主要涉及视觉信息预处理和编码,具体包括图像滤波、边缘提取、纹理分析、立体视觉、光流、图像增强与复原等方面的研究内容。是否具有物体识别、行为分析、事件解译等语义理解能力是区分初期视觉和高层视觉的主要依据。

图像滤波是图像预处理的主要手段之一,目的是突出图像中的有效信息、压制不需要的其他信息。根据滤波的操作域不同,图像滤波可以分为空域滤波和频域滤波;根据滤波操作的计算特性不同,图像滤波可以分为线性滤波和非线性滤波;根据滤波的目的不同,图像滤波可以分为平滑滤波、形态学滤波、双边滤波、引导滤波等。高斯滤波是最常用的线性滤波器,Gabor滤波器符合人类视觉初级视皮层的信息处理特性,在图像特征提取中应用较多,双边滤波和引导滤波具有良好的边缘保持特性,并不会影响其他非边缘区域的滤波效果,相对双边滤波而言,引导滤波更加高效,而且可以保持更多类型的图像结构。在图像滤波思想上发展出了局部图像特征,其中,LBP和Haar是两个具有深远影响的局部图像特征,前者利用相邻像素之间的灰度大小关系进行特征编码,具有良好的光照鲁棒性和判别能力,在人脸识别、纹理分析中发挥了重要作用,而后者通过定义一系列矩形区域,通过它们的平均像素差进行判别分析,结合adaboost特征选择算法,是人脸检测领域里程碑式的工作,也广泛应用于其他目标的检测任务中。图像增强和复原技术是基于图像滤波发展而来的,早期的方法集中在滤波器设计上,如维纳滤波、约束最小二乘滤波、Lucy-Richardson解卷积算法等。在2000年之后,以正则化方法和字典学习为代表的稀疏编码方法因其出色的性能表现逐渐成为主流,如针对图像去噪问题的BM3D算法、LSC算法、FOE模型等,以及针对图像去模糊问题的TV正则化算法、L1正则化算法等。目前,也出现了基于深度学习的图像增强和复原方法。边缘提取的早期研究中,主要是根据边缘的物理特性,设计相应的滤波器进行图像滤波,代表性工作是canny边缘算子;在2000年以后,这种根据设计者经验设计的滤波方法逐渐被基于学习的方法所替代,如PB和gPB;近年来,深度学习进一步促进了边缘检测技术的发展,最早的工作有DeepContour和DeepEdge,以及可端到端训练的边缘检测算法HED,目前较好的方法是RCF。在立体视觉和光流这类基于匹配对应的初期视觉问题中,基于马尔科夫随机场将全局约束信息进行建模的方法是深度学习出现之前比较有代表性的一类方法,该方法利用通常利用图割、信念传播、动态规划等算法对构造的极小化问题进行求解。对于立体匹配问题,基于全局优化的方法通常速度较慢,半全局和基于特征的局部方法更加实用,其中,半全局块匹配算法(SGBM)在速度和精度方面具有良好的折中。解决光流问题的基本假设是运动的颜色恒常性,可以为变分法、基于区域的方法、基于特征的方法、频域处理方法,以及最近出现的基于CNN的方法。在深度学习出现之前,变分法在光流的发展中占主导地位,大部分性能优秀的光流算法都属于变分法的范畴,基于颜色恒常性基本假设形式化优化目标函数中的数据项,同时辅于平滑性约束,最终通过求解最优化问题得到光流解。最近兴起的基于CNN的光流计算通过一次网络的前向运算得到输入图像的光流,因此更加高效,计算速度是传统方法的几十倍,具有很大的潜力,比较有代表性的工作是FlowNet系列、SpyNet、TVNet、PWC-Net。

初期视觉的研究产生了广泛的影响,如从图像滤波发展出来的图像卷积是卷积神经网络的核心组件,光流计算是视频行为分析中是最基本的处理方法,基于立体视觉技术发展出来的RGBD相机作为传统图像传感器的重要补充在许多应用中发挥重要作用,图像超分辨率和视频去模糊技术已经在各类摄像类数码产品中广泛使用。

3. 图像增强与复原

图像增强与复原是图像处理领域研究的一类经典问题。在图像的成像、保存和传输过程中,受各种外在因素的影响,图像会产生不同类型的质量退化问题。图像增强和复原主要研究如何基于图像先验和图像退化模型,提升图像的视觉质量或恢复图像的原本面目。图像增强与图像复原又略有区别。前者通常以提升图像的视觉质量为最终目的,常常作为后续图像处理与分析过程的预处理步骤。而后者则以恢复图像本来面目为目标,因此复原过程往往需要考虑图像的退化机理,并构建图像质量退化模型。经典的图像增强与复原问题包括图像去噪、图像去模糊、图像去雾、去雨、去阴影、图像超分辨率以及图像几何畸变校正等。需要指出,由于退化模型的不适定性,图像增强与复原问题通常涉及一类逆问题的求解,是典型的不适定问题。图像的增强与复原不存在统一的处理方法,常需要根据具体问题,针对图像质量退化模型和可利用的图像先验构造恰当的求解方法。

早期的图像增强与复原方法主要包括各种滤波方法。由于噪声与图像内容通常具有不同的频谱,因此可在不同的谱段上分别处理,从而保证在去除噪声的同时尽量不损害图像内容。这类方法主要针对图像去噪和去模糊等问题,代表性的方法包括中值滤波、同态滤波、维纳滤波、约束最小二乘滤波、加权最小二乘法、Lucy-Richardson解卷积算法等。随后,以正则化和字典学习为代表的稀疏编码方法因其出色的性能表现逐渐成为图像复原方法的主流。从贝叶斯观点来看,正则项对应图像的先验分布,因此,图像复原的好坏与选取的图像先验关系密切。与滤波方法相比,稀疏编码提供了一种更为精确、有效的手段来刻画图像先验,往往能够取得非常优异的表现。这一时期针对图像去噪和去模糊问题,涌现出大量的研究工作和性能优异的算法,如针对自然图像去噪的Fields of Experts (FOE)模型、Block-Matching 3D (BM3D)算法、基于K-SVD的图像去噪算法,以及针对图像去模糊问题的TV范数、L1范数以及Lp范数正则化算法等。近年来,随着深度学习热潮的兴起,基于数据驱动的、可端到端学习的图像复原方法逐渐获得研究者青睐。受益于神经网络强大的模型表示能力,研究者尝试用深度神经网络来隐式的刻画图像先验以及图像退化模型。通过将其纳入生成对抗网络框架,从而将图像复原问题转化成一个图像生成问题。该方法的优势在于可将多种类型的图像增强与复原问题纳入一个统一的计算框架来处理。未来,图像复原问题仍将是一个有待继续深入研究的问题。相关领域知识的有效嵌入以及高效便捷计算模型的构建仍将是图像增强与复原研究关注的重点。

由于图像增强与复原研究涉及不适定问题的求解以及高维空间中图像先验的表示与学习等多个问题,该研究也从客观上推动了图像稀疏编码、图像深度编码、图像先验表示与正则化学习等研究的进展。此外,作为图像处理领域中的一个经典研究问题,图像增强与复原也成为新的图像表示理论与算法研究的试金石。作为提升图像视觉质量的一种有效手段,图像增强与复原在底层视觉、计算成像、文字识别、虹膜识别、指纹识别、人脸识别、目标跟踪、视频监控等众多领域获得了广泛的应用。

4. 图像特征提取与匹配

图像特征提取和匹配的目的是对不同图像中相同或相似的基元建立对应关系,基元也称为图像特征,常用的图像特征包括点、直线/曲线、区域,因此根据使用的特征不同,图像特征匹配又分为点匹配、直线/曲线匹配、区域匹配,而从图像中自动提取这些特征的过程也称为图像特征提取。相对来说,点匹配的应用最广,更受研究人员关注。点匹配又可分为稠密点匹配和稀疏点匹配。稠密点匹配的任务是建立图像之间逐像素的对应关系,广泛应用于立体视觉、光流、运动场估计等计算机视觉任务中。特征点匹配包括特征点检测、特征点描述、匹配模型的鲁棒估计三部分内容,旨在建立图像之间的稀疏点对应关系。

对于稠密点匹配,早期工作主要是局部匹配与全局优化相结合的方法,比较有代表性的工作是基于图割的方法和基于信念传播的方法,目前的研究重点则集中在利用深度学习解决该问题。相对于稠密点匹配,特征点匹配应用更广,是主流的特征匹配方法。其中的特征点检测算法用于检测图像上的角点和斑点,以使得不同图像中的相同点能被重复检测,这是进行特征点匹配的基本前提。早期的Harris角点检测算法一直使用至今,并产生了许多改进算法,而FAST角点检测算子则是快速特征点检测的首选算法;斑点检测算法中比较有代表性的工作是SIFT特征点检测算法以及基于积分图技术对它的改进算法SURF。特征点描述的目的是根据特征点周围的图像信息建立一个向量对其进行表达,以建立不同图像间相同特征点的对应关系,分为基于专家知识设计的方法和基于学习的方法。基于分块梯度方向直方图设计的SIFT算法是基于专家知识设计的诸多特征描述方法中的杰出代表,在其基础上改进的著名特征描述方法还有SURF,其在后来的二进制局部特征(如ORB,BRISK等)出现之前的很长一段时间,一直都是作为SIFT在速度要求高的场合的替代算法,同样获得了广泛的应用。随着深度学习的兴起,特征点描述领域在2017年基本完成了从基于专家知识设计的方法到基于深度学习的方法的转变,利用卷积神经网络强大的特征表达能力基于成对的匹配/不匹配图像块自动学习得到区分能力强、鲁棒性好的特征描述子。目前,面向特征描述使用较多的网络结构是L2Net。此外,将特征点检测和特征点描述两个具有内在关联的任务统一起来用深度网络求解是目前流行的方法,代表性工作有LIFT、RF-Net、D2Net、R2D2。鲁棒的模型估计研究从包含错误匹配点的点匹配集合中计算出真实变换模型的方法,广泛使用的方法是RANSAC。此外,如何对特征点匹配结果进行误匹配去除一直都受到研究人员的关注,主要有基于图匹配的方法和基于运动一致性的方法,如GMS、CODE,近年来,也出现了一些利用深度学习进行错误特征点匹配过滤的方法,总体思路是将一对匹配特征点看做一个四维向量,研究深度学习方法以四维向量集合作为输入,挖掘集合中不同点之间的上下文关系,推理得到误匹配特征点。

图像特征提取和匹配产生了广泛的影响,如受SIFT启发出现的HoG特征则在目标检测领域产生了重要影响,是深度学习出现之前目标检测领域的首选特征;局部图像特征点提取和描述直接催生了基于词袋模型的图像表示研究,是前深度学习时代图像分类、识别的主要方法;以图像特征点匹配为基础的全景图像拼接技术已经走进了千家万户,在日常生活中得到广泛使用;此外,特征点匹配还广泛应用于三维重建、视觉定位、摄像机标定等三维计算机视觉任务,在增强现实、基于视觉的定位、城市数字化、自动驾驶等新兴应用中发挥着重要作用。

5. 多视几何理论

多视图几何是计算机视觉研究中几何视觉(Geometric Computer Vision)所使用的基本数学理论,主要研究在射影变换下,不同视角二维图像对应点之间,以及图像点与三维场景、相机模型之间的几何约束理论和计算方法,进而实现通过二维图像恢复和理解场景的三维几何属性。多视图几何建立在严格的代数和几何理论之上,并发展出了一系列解析计算方法和非线性优化算法,是三维重建、视觉SLAM、视觉定位等三维几何视觉问题所使用的基本数学理论。多视图几何研究的代表人物包括澳大利亚国立大学的R. Hartely、英国牛津大学的A. Zisserman、法国国家信息与自动化研究所的O. Faugeras等学者,2000年由R. Hartely和A. Zisserman合著的著作《Multiple View Geometry in Computer Vision》对这方面的研究工作做出了比较系统的总结。可以说,多视图几何的理论研究在2000年左右已基本完善。

多视图几何主要研究两幅图像对应点之间的对极几何约束(Epipolar Geometry),三幅图像对应点之间的三焦张量约束(Tri-focal Tensor),空间平面点到图像点或多幅图像点之间的单应约束(Homography)等。多视图几何的核心算法包括三角化、八点法估计基本矩阵、五点法估计本质矩阵、多视图因式分解法、基于Kruppa方程的相机自标定等解析计算方法,以及以捆绑调整(Bundle Adjustment)为代表的迭代优化方法。多视图几何中最核心的理论是从1990年至2000年左右建立起来的分层重建理论。分层重建的基本思想是在从图像到三维欧氏空间的重建过程中,先从图像空间得到射影空间下的重建(11个未知数),然后将射影空间下的重建提升到仿射空间(3个未知数),最后将仿射空间下的重建提升到欧氏空间(5个未知数)。在分层重建理论中,从图像对应点进行射影重建,就是确定射影空间下每幅图像对应的投影矩阵的过程;从射影重建到仿射重建,在于确定无穷远平面在射影重建下(某个特定射影坐标系)的对应坐标向量;从仿射重建到度量重建,本质上在于确定相机的内参数矩阵,即相机的自标定过程。由于任何一个几何视觉问题最终都可以转化为一个多参数非线性优化问题,而非线性优化的困难在于找到一个合理的初值。待优化的参数越多,一般来说解空间越复杂,寻找合适的初值越困难,所以,如果一个优化问题如能将参数分组分步优化,则一般可以大大简化优化问题的难度。分层重建理论由于每一步重建过程中涉及到的未知变量少,几何意义明确,因此算法的鲁棒性得到了有效提高。

多视图几何和分层重建是计算机视觉发展历程中的一个重要的理论成果,其本身的理论框架已经构建的比较完善。随着相机制作水平的提高,传统小孔成像模型下的相机内参数通常可以简化为只有焦距一个内参数需要标定,且焦距的粗略数值通常可以从图像的EXIF头文件中读出,因此相机的内参数通常可以认为是已知的。此时基于两幅图像之间的本质矩阵约束,通过五点法可以求解两幅图像之间的外参数(旋转和平移向量),进而直接进行三维重建,而不再需要分层进行重建。尽管如此,多视图几何和分层重建由于其理论的优美性和数学的完备性,其在计算机视觉尤其是几何视觉领域仍然是不可或缺的。

6. 摄像机标定与视觉定位

摄像机的参数包括内参数与外参数。内参数包括焦距、纵横比、斜参数、主点等,属于相机的内在属性。外参数是指摄像机的运动参数,包括摄像机运动的旋转矩阵与平移向量。对摄像机内外参数的求解可以统称为摄像机标定。对摄像机机外参数求解,又可以称为摄像机定位或视觉定位。

摄像机内参数标定分为基于先验信息的标定和自标定。首先介绍基于先验信息标定方法:1986年Tsai提出了利用三维标定物的两步法。由于三维标定物的制作要求工艺较高,且容易发生遮挡,1999年,Zhang提出了基于二维棋盘格的标定法,该方法简单易用,在工业界与学术界被大家广泛使用。自标定方法中,最重要的方法是1992年Faugeras提出的基于Kruppa方程的自标定法,通过图像之间的匹配点,计算出图像之间的基本矩阵,则可建立相机内参数的方程。通常基于先验信息的标定是线性问题,而自标定都是非线性的。由于Kruppa方程的原理简单,方程容易建立,如何求解这类非线性问题也曾吸引了很多研究者。当相机参数较少时,Kruppa方程也可转化为线性问题。之后,有比较重要影响的自标定方法是1997年,Triggs提出的基于绝对对偶二次曲面的自标定方法,其中需要射影重建,比Kruppa方程的自标定要复杂一些,但是可以避免一些退化的出现。基于绝对对偶二次曲面的自标定方法的重要性还体现在当相机自标定后,可以在射影重建的基础上自然过渡到度量重建上。

摄像机定位可以分为两大类,环境信息已知的方法和环境信息未知的方法。环境信息已知主要是PnP问题的研究,环境信息未知主要是SLAM (Simultaneous Localization and Mapping)的研究。PnP的研究最早起源于1841年。1841年及1903年Grunert Finsterwalder及Scheufele 研究得到P3P问题最多有4个解,P4P问题有唯一解。之后,开启了PnP问题的系列研究。1999年Quan和Lan给出P4P、P5P的近似线性方法。当n大于等于6,PnP问题是线性的,最早的有影响力的该问题求解方法当属Abdel-Aziz和H. M. Karara于1971年提出的直接线性变换法,目前使用最多的有效的处理方法是Lepetit等于2008年给出的EPnP方法。SLAM最早由Smith和Cheeseman于1986年提出,并于1995年在机器人研究研讨会上被正式命名。SLAM技术具有重要的理论意义与应用价值,被许多学者认为是移动机器人实现真正自主的关键,甚至称其为自主移动机器人界的圣杯。在2002年,Andrew Davison 首次实现了单目实时的SLAM系统MonoSLAM,其中采用了滤波的方法。从此机器人采用单目相机进行实时定位成为可能,也为单目相机下进行增强现实打下了重要的基础。随着计算机硬件的发展以及多视几何理论的逐渐成熟,2007年,Klein和Murray提出了PTAM(Parallel Tracking and Mapping),拚弃之前滤波方法的主流框架,提出并实现了基于多视几何理论的跟踪与建图过程的并行化。之后广泛流行的Mur-Artal and Tardós 提出的ORB SLAM,正是在PTAM的框架基础上修改而成。不考虑特征点,而是考虑图像的梯度信息,直接基于图像的光度一致性,2014年Engel等人提出了直接法的SLAM,不需要提取特征点、不需要计算描述子,达到了一个较高的跟踪速度。最近几年,也出现一系列的深度学习的视觉定位方法,代表性的工作有Tateno等于2017年提出的CNN-SLAM,Bloesch等于2018年提出的CodeSLAM,Xue等2019年提出的引入记忆模块的VO方法。与传统方法相比,基于深度学习的方法具有较高的鲁棒性能。

摄像机内参数标定是计算机视觉的基础,很多应用都是以标定内参数作为前提。摄像机定位是机器人、无人驾驶、增强现实、虚拟现实中的关键技术,具有广泛的应用价值,不仅可以应用于工业领域,也可以在消费级领域中具有广阔市场,吸引了大量的研究与关注。

7. 三维重建

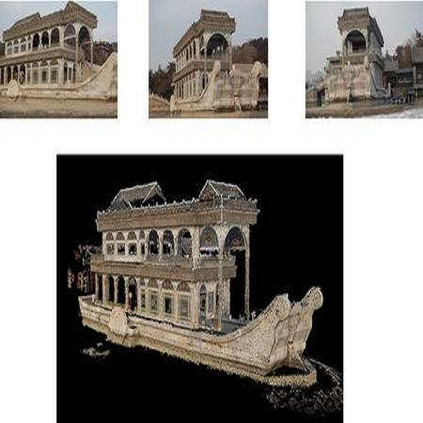

三维重建旨在通过多视角二维图像恢复场景三维结构,可以看作相机成像的逆过程。最早的三维重建理论在1982年由D. Marr在其视觉计算理论中提出,Marr认为人类视觉的主要功能是复原三维场景的可见几何表面,即三维重建问题,同时Marr还提出了从初始略图到物体2.5维描述,再到物体三维描述的完整计算理论和方法。Marr认为这种从二维图像到三维几何结构的复原过程是可以通过计算完成的,这一视觉计算理论是最早的三维重建理论。从1990年至2000年左右,以射影几何为基础的分层重建理论的提出,使三维重建算法的鲁棒性得到了有效提高。分层重建理论构建了从射影空间到仿射空间,再到欧氏空间的计算方法,具有明确的几何意义和较少的未知变量,是现代三维重建算法的基础理论。近年来,随着大规模三维重建应用需求的不断提升,三维重建的研究开始面向大规模场景和海量图像数据,主要解决大场景重建过程中的鲁棒性和计算效率问题。

通过多视角二维图像恢复场景三维结构主要包括稀疏重建和稠密重建两个串行的步骤。稀疏重建根据输入的图像间特征点匹配序列,计算场景的三维稀疏点云,并同步估计相机内参数(焦距、主点、畸变参数等)和外参数(相机位置、朝向)。稀疏重建算法主要包括增量式重建和全局式重建两类:增量式稀疏重建从两视图重建开始,不断添加新的相机并进行整体优化,渐进式的重建出整个场景和标定所有相机;全局式稀疏重建首先整体估计所有相机的空间朝向,之后整体计算所有相机的位置,最后通过三角化计算空间稀疏点云。在稀疏重建中,最后一步都需要使用捆绑调整算法(Bundle Adjustment)对所有相机参数和三维点云位置进行整体优化。捆绑调整以所有三维点重投影误差平方和最小化为优化目标,是一个高维非线性优化问题,也是决定稀疏重建结果质量的核心步骤。在稀疏重建完成后,稠密重建根据稀疏重建计算的相机位姿,逐像素点计算密集空间点云。稠密重建的主要方法包括基于空间体素的方法、基于稀疏点空间扩散的方法、基于深度图融合的方法等。基于体素的方法首先将三维空间划分为规则三维格网(Voxel),将稠密重建问题转化为将每一个体素标记为内和外的标记问题,并通过图割算法进行全局求解,得到的内外体素交界面即为场景或物体的表面区域。基于特征点扩散的方法以稀疏点云为初始值,采用迭代的方式,通过最小化图像一致性函数优化相邻三维点的参数(位置、法向等),实现点云的空间扩散。基于深度图融合的方法首先通过两视图或多视图立体视觉计算每幅图像对应的深度图,然后将不同视角的深度图进行交叉过滤和融合得到稠密点云。近年来,深度学习方法也开始逐步应用于深度图计算中,其基本思想是首先利用共享权重的卷积神经网络来提取图像的特征,然后利用平行平面假设,将从邻域图像中提取出的特征通过单应性矩阵转换到当前图像不同深度的前平面,随后通过计算不同深度之间的方差将不同深度的特征融合在一起,再通过三维卷积进行深度求精,最后得出当前图像的深度图。

除了通过多视角二维图像计算场景三维结构外,计算机视觉领域还发展了一系列通过图像明暗、光度、纹理、焦点等信息恢复场景三维结构的方法,一般统称为Shape-from-X。从明暗恢复形状(Shape from Shading)的方法通过建立物体表面形状与光源、图像之间的反射图方程,并在场景表面平滑性约束的假设下,通过单幅图像的灰度明暗来计算三维形状。从光度立体恢复形状(shape From Photometric Stereo)的方法同样基于反射图方程,但使用多个可控光源依次改变图像明暗,从而构造多个约束方程,可以使三维形状的计算更加精准可靠。从纹理恢复形状(Shape From Texture)的方法利用图像中规则且重复的纹理基元在射影变换下产生的尺寸、形状、梯度等变化情况来推断场景结构,但该方法受限于场景纹理先验,在实际应用中使用较少。从焦点恢复形状(Shape from Focus)的方法利用透镜成像中物体离开聚焦平面引起的图像模糊(散焦)现象,利用聚焦平面或物体的运动,以及图像中的检测到的清晰成像点,来推断每个像素点到相机光心的距离。

三维重建理论和方法是伴随着诸多应用领域的需求而不断发展的,如机器人环境地图构建和导航、城市级航拍三维建模、文化遗产三维数字化保护等等。尤其对于大规模复杂场景的三维建模,由于图像传感器低成本和采集方便的特性,往往成为这类应用的首选。比如在地理信息领域,基于航拍倾斜摄影的三维建模已经在很多场合替代了传统的航空激光雷达建模。近年来,随着图像三维重建算法鲁棒性和计算效率的进一步提高,其在室内建模与导航、无人驾驶高精地图构建等领域的应用也在不断拓展。

8. 目标检测与识别

目标检测与识别长期以来一直是计算机视觉与模式识别领域的重要研究任务之一,为解决更复杂任务例如目标分割、行为分析、事件理解、视觉语言交互等奠定了基础。具体而言,目标识别需要对于图像视频中出现的人或目标预测出其相应的类别,而目标检测则需要在识别出目标类别的基础上进一步预测目标在图像中的位置。

传统目标识别方法通常采用两阶段的方式。1)特征提取与编码:从图像视频中提取具有判别性的局部特征,该局部特征通常是基于人类先验设计的特征描述子,代表性方法有SIFT、Gabor、LBP和SURF。此外还有一类基于物体几何形状分析的方法,能够对包括旋转、缩放等比较大的运动变化以及目标形状特征失真或缺损情况都比较鲁棒,代表性方法有GHT、CTT和形状上下文方法等。在局部特征的基础上通常会进行特征编码,进一步强化特征的表示能力,代表性方法有BOW和稀疏编码方法等。2) 训练分类器:学习从视觉特征到类别的映射,代表性方法有SVM。或者也可以采用度量学习和模板比对的策略来找到与查询样本接近的样本的类别。这两个阶段的模型是相互独立学习的,在第一阶段通常不会用到类别等监督信息。自2012年以来,以CNN为代表的深度学习模型采取端到端的联合特征学习和分类器学习,即由数据驱动学习适用于分类的判别特征表示。最具有代表性的一系列深度学习模型包括AlexNet、VGGNet、GoogleNet、ResNet、DenseNet、SENet等,取得远超传统方法的性能。基于深度学习的算法在2012-2017年间不断刷新目标识别任务的最好结果,并且最终在百万级图像数据库ImageNet上取得了超过人类的识别性能。自此,通用目标的识别问题基本上已经被解决,相关技术也广泛用于实际场景例如人脸识别、植物识别、动物识别等。目前研究者们更多关注如何基于小型学习网络进行高效率目标识别,代表的模型包括MobileNet、ShuffleNet、IGCNet等。

早期的目标检测算法大多针对某个具体的目标类别,如人脸检测、行人检测。其中,针对人脸检测问题提出的Adaboost算法在其他特定类别的目标检测问题中也得到了较为广泛的应用。在Adaboost之后,一直到2014年基于深度学习的R-CNN方法出现,基于可变形部件模型DPM成为最具有代表性的多目标检测方法。但是传统目标检测算法缺陷却是明显的:1)基于滑动窗口的区域选择策略没有针对性,时间复杂度高且冗余度高;2)手工设计的特征对于目标多样性变化不够鲁棒。2014年之后,目标检测全面进入深度学习时代,基于深度学习的目标检测算法对于之前基于手工特征结合DPM的方法产生了质的飞跃,目前可分为基于目标候选框提取的两阶段目标检测算法和基于回归的单阶段目标检测算法。著名的Fast R-CNN、Faster R-CNN、FPN、Mask R-CNN、Cascade R-CNN系列方法都属于前者,相对于单阶段目标检测算法他们的精度更高,但是运行速度却慢。单阶段目标检测算法是2016年兴起的方法,比较具有代表性的工作有SSD、YOLO、以及RetinaNet系列算法。此外,如何将这两类目标检测算法进行有机结合在近些年也开始受到关注,相关技术被广泛用于生物医学图像分析、交通安全等领域。

9. 图像分割

与目标检测和识别任务不同,图像分割是更具有挑战性且最近发展非常快的一个任务。图像分割的目的是将图像视频分成各具特性的区域并提取出感兴趣目标,他可以看作是目标检测任务的进一步延展,即不仅需要识别出图像视频中出现的目标,还需要定位目标位置并将其轮廓分割出来。图像分割发展至今包括四种主要任务类型:1)普通分割,即将分属不同目标的像素区域分开,不区分类别,例如前景狗的区域与背景区域草地的区域分割开;2)语义分割(Semantic Segmentation),即在普通分割的基础上判断每块区域的类别,包括可数的things(如狗)和不可数的stuff(如草地);3)实例分割(Instance Segmentation),即在语义分割的基础上给每个可数的things(目标)编号,例如一个目标是汽车A,另一个目标是汽车B;4)全景分割(Panoptic Segmentation),语义分割和实例分割的结合,既分割可数things和不可数stuff的不同语义,同时也给每个可数的things编号。

传统的很多图像分割算法通常基于像素点的值、颜色、纹理等信息来度量不同像素之间的相似性进而判断各个像素的类别都是无监督的,例如阈值分割法、区域生长法、边缘检测法、特征聚类法、直方图法、区域生长法等。分水岭算法是一种代表性的分割方法,该方法将图像的灰度值的高低视为“山峰”与“山谷”,通过对不同“山谷”区域不断注入不同标签的“水”,并且在相邻“山谷”之间的“水”汇合之处增加“分水岭”以实现区域分割。尽管这些算法的速度都比较快,但是对于比较复杂的视觉内容容易产生分割区域不完整、漏分割等问题。为了缓解这些问题,Normalized Cut把图像所有像素建模为一个图,并通过最大流/最小割算法来获得两个不相交的子集,分别对应于图像的前景像素集和背景像素集,即相当于完成了图像分割。另外一类常用方法是主动轮廓(Active Contour)算法,他通过设计能量泛函使得自变量包括用连续曲线表达的目标边缘,从而使分割过程转化为能量泛函最小化问题。该方法包括参数主动轮廓和几何主动轮廓两种实现途径,代表方法分别有Snake和Level Set。此外,在深度学习兴起之前还有很多基于概率图模型的图像分割方法,代表性的有MRF、CRF、Auto-Context等。

在2012年深度学习兴起之后,多种CNN的扩展模型也被应用到了图像分割领域。语义分割具有里程碑意义的模型是全卷积网络FCN, 他通过将全连接操作全部替换为卷积操作来高效地进行逐像素类别预测,从而避免了CNN中的将二维特征图压缩成一维向量所带来的空间信息丢失。为了同时保证准确率和输出图像分辨率,U-Net、DeconvNet、SegNet、HRNet等模型应用跨层关联模式逐渐融合低层信息来恢复输出预测,而Deeplab、PSPNet等模型引入空洞卷积的操作使得输出预测保持较大的分辨率。随着图像分割的精度大幅提升,分割的效率也逐渐吸引了很多注意力,其中,ICNet、BiSeNet等方法通过设计多分支网络结构大幅提升了模型的推理效率。

实例分割既需要分割出物体的语义,同时定位出不同的实例,其中具有里程碑意义的模型是Mask-RCNN,他在目标检测算法Faster-RCNN的基础上增加了用于分割目标的分支,从而在每个检测框内进行语义分割。但是,目标检测算法中的ROI操作限制了输出分割图像的精度。所以,随着目标检测和语义分割方法的发展,FOCS、SOLO、CondINS等方法提出抛开ROI直接输出更高精度的分割图。全景分割结合了语义分割和实例分割的特点,既需要分割不可数的stuff,又需要分割数可数things的不同实例。该任务2018年刚被提出,虽然较新,但是已经吸引了越来越多的研究人员投身其中。PanopticFPN、UPSNet、OANet、Panoptic-Deeplab等模型主要依赖于语义分割算法分割stuff,实例分割算法分割thing,再融合两者的输出得到最终的全景分割图。

尽管目前学术界还在深入研究精细化图像分割的算法,但是相关技术已经在行人分割、病灶分割等诸多领域得到实际应用。此外,图像分割技术也广泛作为其他复杂视觉内容理解任务例如步态识别、行人再识别等的前处理操作,他的分割鲁棒性直接决定了后续任务的最终性能。因此,研究复杂背景、遮挡、模糊等复杂情况下的鲁棒图像分割是亟待解决的问题。

10. 图像场景理解

图像场景理解是比较宽泛的概念,所涉及的关键技术主要包括场景解析、语义描述等,近年来都得到了快速发展。

场景解析:场景解析是给予图像中每一个像素相应的目标类别标签,亦称为图像语义分割。不同于粗放的图像识别,场景解析是高层级,精细化的图像分析和识别任务,通过像素级的目标类别标签,可轻易获得图像中目标的位置、轮廓和类别。场景解析技术难点是如何将高层次的目标语义与低层次的轮廓融合起来,进而得到高分辨率、精细的解析结果。高层次的目标语义需要深层次特征和较大感受野实现宏观概念的抽取,但同时低层次的轮廓则需要浅层高分辨特征和较为有限感受野以保证锐利的边缘。当前主流的场景解析技术主要基于全卷积神经网络(FCN),大致分为两类:1) 编码解码模型(Encoder-Decoder Model)。U-Net、DeconvNet、GCN、RefineNet、DFN等模型通过在低分辨率高层语义特征的基础上逐步引入浅层高分辨率特征来恢复高分辨率精细的解析结果。2) 扩张卷积模型(Dilated Convolution Model)。DeepLab、PSPNet、PSANet等场景解析技术通过空洞卷积或者扩张卷积(Dilation Convolution)来保证输出高分辨率的高层语义特征。场景解析能够给出精细化的图像分析和识别结果,在自动驾驶、自主机器人、监控视频等精细化定位和操作领域,需求尤为突出。

语义描述:虽然当前大部分视觉研究仍关注在检测、分割、识别等经典的视觉任务上,但人们发现人类的视觉系统在处理信息时,往往是与听觉和语言系统协同工作的,这样才能将视觉感受到的信息加工、抽象成为高层级的语义信息。语义描述是计算机视觉技术前沿研究领域,具体研究问题是根据给定图像,给出一段描述性文字,力图符合人类给出的描述标签。当前图像语义描述起源于著名华人科学家李飞飞博士策划的视觉基因组(visual genome)计划,目标是把图像和语义结合起来。当前的图像语义描述技术是联合卷积神经网络(CNN)和递归神经网络(RNN)的一种新型网络。语义描述被认为是当前感知智能向认知智能发展的开端,不仅是跨模态模式识别的典型问题,同时具有广阔的应用前景。语义描述改变了计算机视觉与自然语言处理、语音识别等学科相对独立的状态,提供了一种新的图像场景理解的研究范式。当前图像描述的技术难点主要集中在两个方面:语法的正确性,映射的过程当中需要遵循自然语言的语法,使得结果具有可读性;描述的丰富程度,生成的描述需要能够准确描述对应图片的细节,产生足够复杂的描述。为求解上述问题,学者们引入了注意机制(Attention)、对抗生成网络(GAN)等技术,试图生成更加贴近人类自然语言的图像语义描述。

11. 图像检索

图像检索(Image Retrieval)是为了在输入查询图像时在包含丰富视觉信息的海量图像库中方便、快速、准确地查询并筛选出用户所需的或感兴趣的一些相关图像。检索的主要步骤依次为用户输入查询(Query)、查询分析、索引&词库、内容筛选、结果召回和结果排序及展示。查询经常常包含文字、颜色图、图像实例、视频样本、概念图、形状图、素描、语音、二维码以及多种形式的组合。为了更好地给出用户需要的图像,检索系统会使用相关性反馈和交互式反馈,充分利用用户提供的反馈信息(如浏览记录、点击记录、再次搜索等),从而更好地理解用户的表达搜索意图以得到更好的搜索结果。图像检索方法按照描述图像内容方式分为:基于文本的图像检索和基于内容的相似图像检索。此等人的研究内容包括图像自动标注、图像特征提取与表示、特征编码与聚合、大规模搜索。

图像自动标注是指针对图像的视觉内容,通过机器学习方法自动给图像添加反映其内容的文本特征信息(如颜色、形状、区域属性标注、概念类别等)的过程。经过图像自动标注,图像检索问题可以转化为技术已经相对较成熟的文本信息处理问题。图像自动标注依据标注模型的不同主要包括基于统计分类的自动图像标注、基于概率的图像自动标注和基于深度学习的图像自动标注等。基于统计分类的方法将每个图像的语义概念作为一类进行分类,自动图像标注转化为多分类问题。基于概率建模的方法尝试推断图像和语义概念之间的相关性或联合概率分布。深度学习方法适合对图像高层语义特征进行自动学习并对海量图像进行分类标注。

图像特征提取和表达是基于内容的图像检索的初始阶段。模识分类和视觉目标识别中常用的特征提取和表达方法(如SIFT、SURF、Bag-of-Words、CNN等)也可用于图像检索。由于浮点特征计算图像相似度/距离复杂度高、存储空间大,而二进制特征存储高效,汉明距离计算复杂度低,基于二进制特征和哈希方法受到了广泛关注。哈希是在保留图像或视频的相似性条件下将高维数据编码为二值化表达。传统方法需要将浮点特征编码成二进制特征,例如谱哈希等;深度学习方法则是直接学习和输出二进制特征表达,如基于汉明嵌入的紧致特征表达、二进制哈希编码、深度监督哈希、深度离散哈希等。为了降低原始特征维度灾难带来的影响,特征编码和聚合是基于内容的图像检索的第二阶段,主要是基于特征提取阶段得到的图像特征进行聚类并生成编码本,有利于构建倒排索引,可以分为小规模编码本,大规模编码本。根据编码方法不同,小规模编码本包含基于稀疏编码的特征聚合(Bag of Words, BoW)、局部聚合向量(Vector of Locally Aggregated Descriptors, VLAD)、Fisher向量编码。大规模编码本包括层级K均值和近似K均值。在进入深度学习时代后,前期的工作采用卷积神经网络与传统编码聚合方法相结合的思路,如CNN+VLAD、CNN+BoW、Fisher编码+CNN等。后期研究人员则提出了各种面向图像检索任务的端到端训练深度卷积神经网络,这时候就不再需要显式编码或聚合步骤。代表性工作包括基于孪生网络和对比损失的视觉相似性学习、受VLAD启发的NetVLAD等。二进制编码也是特征编码的重要部分,主要进展包括数据独立哈希和数据依赖哈希。数据独立哈希代表性工作有随机预测哈希、局部敏感哈希、加权最小独立置换局部敏感哈希等。数据依赖的哈希算法需要使用训练数据学习哈希函数,对数据敏感,一般分为无监督、半监督和有监督哈希。由于深度学习强大的特征学习能力和端到端的学习哈希函数能力,一批相关哈希算法越来越受到重视,代表性工作包括卷积神经网络哈希、深度正则相似比较哈希、深度监督哈希、跨模态深度哈希、基于排序的语义哈希等。深度无监督哈希方法不需要任何标签信息,而是通过特征的距离获得相似性信息,主要分为三类:相似性移除的深度哈希、基于生成模型的深度哈希和基于伪标签的深度哈希。近年来多模态深度哈希技术吸引了大量研究兴趣,代表性工作包括多种跨模态哈希和跨模态深度哈希、自监督对抗哈希、深度多层次语义哈希等。

对于大规模图像搜索的快速查找技术包括查找优化(如建立倒排索引,通过优化检索结构进行性能优化,不改变向量本身)和向量优化(通过将高维浮点向量映射为低维向量或映射到汉明空间,减少计算复杂度和存储空间)。查找优化方法分为最近邻查找和近似最近邻查找。最近邻查找代表性工作是KD树、基于查询驱动迭代最近邻图搜索的大规模索引法等。近似最近邻通过减少搜索空间,大幅度提高效率,找到近似最近距离的匹配目标,常用的方法有局部敏感哈希、倒排文件索引、倒排多索引、面向深度特征的非正交倒排多索引等。向量优化方法是将特征向量进行重映射,将高维浮点向量映射到其他空间,映射后的向量可以使用更高效的方式进行距离计算。哈希算法是其中最有代表性的技术。

此外,图像检索在相关性的定义方面有许多外延,包括语义相关、纹理相关、表观相关等。为了更好地获得图像检索结果,排序算法和重排序算法经常被应用于图像检索系统中。为了更好地与用户进行交互或者广告推荐商业化,检索结果的合理展示也是各大互联网公司非常重视的一块。总的来说,图像检索推动了计算机视觉、模式识别、机器学习等领域的发展。其技术得到了广泛的应用,包括百度、谷歌、微软的搜索引擎,阿里、京东、拼多多等的电子商务中的商品垂直搜索,IBM的医疗辅助等。

12. 视觉跟踪

从最一般的意义上讲,视觉跟踪就是要在整个图像序列中的每帧图像里,通过算法确定指定目标的状态。在第一帧中的待跟踪物体的状态由人或者其它算法确定。目标状态通常包括其中心在图像中的位置、恰好包围住物体的矩形框和该矩形框的旋转角度等。对于在被跟踪过程中形变剧烈的物体,有时会用多个矩形框来共同近似表示其位置和姿态等状态,也可以利用多边形或者图像分割算法将物体包围框中的像素分为目标像素和背景像素,以提高被跟踪物体的标示精度。跟踪算法种类繁多。可以按照算法是在线还是离线跟踪物体来划分。所谓在线跟踪,就是指算法只能利用在当前及其之前时刻的图像来定位物体,而离线跟踪则是指算法可以利用整个视频来确定其中任意一帧中物体的状态。显然,在线跟踪相对难度更大,当然应用也更为广泛。跟踪算法也可以根据是否事先知道被跟踪物体或其种类来划分。如果跟踪算法只能利用物体在初始帧中的信息,则通常被称为无模型(model free)跟踪问题,如果能事先知道被跟踪物体或者其种类,就可以首先搜集大量的相关样本,然后设计并训练跟踪器,以便在跟踪物体时减少误判,从而显著提高跟踪性能。跟踪算法还可以按照需要在一帧图像中跟踪单个目标还是多个目标来划分。单目标跟踪算法一般由表观模型、运动模型和搜索策略构成,而多目标跟踪算法通常由在同一帧中的多物体定位和在相邻帧间的相同物体关联两部分组成。从实际应用考虑,跟踪算法还可以进一步按照背景或摄像机是否静止、是否进行三维跟踪以及是否需要跨摄像机跟踪等来进一步细分。跨摄像机跟踪往往针对特定类目标,更多地涉及到高效目标检测、重识别或者多对多匹配问题。

对于最基础的单目标视觉跟踪,从所采取的技术手段上讲,跟踪算法经历了由最初的基于生成式物体模型的仿射对应和卡尔曼滤波与粒子滤波方法,到二十世纪末至二十一世纪初在物体建模中引入判别性方法,再到二十一世纪第二个十年中的基于相关滤波的方法以及基于深度网络的跟踪算法。在大数据支持下,相关滤波方法与深度特征的结合,以及在深度网络跟踪器中引入相关滤波,在极大地提升跟踪算法定位性能的同时,也使算法具有较高的处理帧频。随着相关滤波跟踪算法研究的不断深入,相关滤波理论本身也取得了一系列突破。相关滤波的高速性能也不再仅仅依赖于快速傅里叶变换。基于回归网络的跟踪算法在近几年中备受关注。这种算法直接对物体搜索区域或粗糙的物体状态进行回归,得到精细的物体状态。基于元学习的跟踪算法当前取得了最好的精度和速度的平衡。这种算法通过元学习的方式训练深度网络,使跟踪器模板可以快速适应物体模板和周围背景,因此有较强的的判别力和鲁棒性。

视觉跟踪是计算机视觉中的一个非常困难而又应用广泛的基础性问题。当前的跟踪算法,往往大量借鉴计算机视觉中其它领域,特别是目标检测领域中的技术,并使之适应于视觉跟踪的特定问题。

13. 行为与事件分析

行为与事件分析是高层计算机视觉的重要任务。行为分析是利用计算机视觉信息(图像或视频)来分析行为主体在干什么,相对于目标检测和分类来说,人的行为分析涉及到对人类视觉系统的更深层的理解。事件是指在特定条件或外界刺激下引发的行为,是更为复杂的行为分析,包括对目标、场景及行为前后关联的分析。事件分析是行为分析的高级阶段,能够通过对目标较长时间的分析给出语义描述。之前的行为识别可以是事件分析的基础,但事件分析也具有其特殊性,仅仅依赖于前述的行为识别并不能较好地解决事件分析。行为与事件分析的核心任务是对其分类,但不局限于分类,还涉及在空间、时间对其定位及预测。根据行为/事件中涉及的人的个数可将其分为个体行为/事件和群体行为/事件。

行为分析主要开始于二十世纪七十年代,该任务的一般流程包括两个步骤:一是特征提取去除视频中的冗余信息,二是利用分类、比对等学习方法进行识别分析。早期的研究主要局限于简单、固定视角且已切分好后的动作,基于全局特征表示的方法是早期行为识别方法中最具代表性的方法,典型方法是首先利用背景差分获得人体轮廓,然后累加这些差分轮廓生成运动能量图(MEI)或者运动历史图(MHI),利用模板匹配法对该视频中的行为进行分类;或者提取每帧中的轮廓信息,采用线性动态变换、隐马尔可夫模型等进行时序建模,利用状态空间法进行识别。然而,基于全局特征表示的方法依赖于背景分割并且对噪声、角度、遮挡等都很敏感,无法很好的分析复杂背景下的复杂行为和事件。本世纪初,大量基于局部特征表示的方法出现,克服了全局特征方法存在的一些问题,对视角变化、光照变化、人的表观变化和部分遮挡具有一定的不变性,取得了更好的效果。这类方法的流程是局部区域提取、局部特征提取、局部特征编码与池化、分类器学习。局部区块通常采用密集采样或者在时空兴趣点周围采样得到,其中时空兴趣点是视频中运动发生显著变化的时空位置,并假设这些时空位置对人体行为识别非常关键。局部特征描述子表示的是图像或者视频局部区块的特征,典型的有梯度直方图、光流直方图、尺度不变描述变换(SIFT)、SURF特征、运动边界直方图MBH、轨迹特征tracklet等。局部特征需要再经过编码和池化才能得到整个视频的特征描述,最常见的特征编码方式有视觉词包模型、矢量化(VQ)、稀疏编码、费舍尔向量、以及局部条件约束线性编码(LLC)、以及局部聚合描述向量VLAD等。而此时最常用的分类方法是SVM结合多核学习、度量学习等方法。近十年以来基于深度学习的方法在各种各样的视觉任务中取得了突破,也被广泛应用于行为分析任务中。基于卷积神经网络的行为识别方法采用卷积网络分别从视频的RGB和光流两个通道(two streams)描述视频序列,最后使用两个通道的加权平均结果作为对整个视频的预测结果。基于三维卷积神经网络的方法将2D卷积神经网络直接扩展到3D卷积神经网络,将整个视频作为整体输入到3D深度卷积神经网络中,实现端到端的训练。基于递归神经网络的方法对视频每帧上提取的深度特征在时间序列上建模,例如先用卷积网络提取底层视觉特征,然后使用LSTM对底层视觉特征进行高层级建模。很多方法通过增加空间、时间或通道注意力模块,使网络关注到更有判别性的区域。也有方法利用图卷积神经网络建模高层特征及特征的关系,来提高模型的表达能力,然而由于人体骨架数据的结构显著性,图卷积神经网络在基于骨骼数据的行为识别中使用更为广泛。最后,这些基于神经网络的方法,往往会融合基于密集运动轨迹方法进一步提升最后的性能。

对于群体行为分析,除了上述方法即整体性方法外,另一些学者提出了基于个体分割的群体行为分析框架,大致是将多人交互的行为过程分解为多个人单独的动作过程,再采用一些高层的特征描述和交互识别的方法得到最终的交互结果。行为的发生时间一般都很短,目前的视频行为分析方法大都适用于不同的拍摄视角和场景,对视角、场景变化具有一定的不变性。然而事件却往往持续时间长,存在跨摄像机事件分析的需要,如多摄像头下的大场景监控环境。大范围场景多摄像机下的复杂事件通常涉及多个相互联系的行为单元,不同的行为单元的时空依存关系,目前直接进行关联行为分析的研究比较少,而跨摄像机网络中基于特定行人进行检索的行人重识别、行人追踪、不同姿态/环境下人像身份的识别等技术是跨摄像机领域当下的研究热点,通过这些技术将跨摄像头下的行为单元进行关联,从而可进一步进行事件分析。

行为与事件分析是极具挑战性的任务,不仅包含对视频中静态目标的感知也包括对动态变化的分析。目前,从基于时空兴趣点局部特征描述的方法等到基于神经网络的方法,行为与事件分析的性能得到了显著提高。对于复杂现实场景的大样本下,已能够达到较高水平。这给行为与事件分析带来了更广阔的应用空间,包括智能视频监控、机器人视觉系统、人机交互、医疗护理、虚拟现实、运动分析及游戏控制等。比如篮球/足球等体育视频中的运动行为检测,老人病患者等监控视频中行为识别和预测,公共安全场景下暴力事件、群体行为分析与预警等。

[模式识别国家重点实验室允许非商业用途的转载。转载时应保证内容与原文一致,声明“本文得到模式识别国家重点实验室(公众号: 模式识别国家重点实验室)授权发布”,并添加原文链接。]