深度学习框架下群组行为识别算法综述

群组行为识别目前是计算机视觉领域的一个研究热点,在智能安防监控、社会角色理解和体育运动视 频分析等方面具有广泛的应用价值. 本文主要针对基于深度学习框架下的群组行为识别算法进行综述. 首先,依据群 组行为识别方法中“是否包含组群成员交互关系建模”这一核心技术环节,将现有算法划分为“无交互关系建模的群组 行为识别”和“基于交互关系描述的群组行为识别”两大类. 其次,鉴于“无交互关系建模的群组行为识别方法”主要是 聚焦于如何对“群组行为时序过程的整体时空特征的计算和提纯”进行设计的,故本文从“多流时空特征计算融合”“个 人/群体多层级时空特征计算合并”“基于注意力机制的群组行为时空特征提纯”3 类典型算法进行概述 . 再次,对于 “基于交互关系建模的群组行为识别”,依据对交互关系描述方法的不同,将其归纳为“基于组群成员全局交互关系建 模”“基于组群分组下的交互关系建模”和“基于关键人物为主的核心成员间交互关系建模”3种类别分别概述. 然后, 对群组行为识别相关的数据集进行介绍,并对不同识别方法在各个数据集的测试性能进行了对比和总结. 最后,分别 从群组行为类别定义的二元性、交互关系建模的难点与不足、群组行为数据集弱监督标注和自学习、视角变化以及场 景信息综合利用等方面概述了几个具有挑战性的问题和未来研究的方向.

https://www.ejournal.org.cn/CN/10.12263/DZXB.20211359

1 引言

群组行为包括“视频中多个人做相同动作”和“多 数人协作完成某一复杂行为”两种情况,而群组行为识 别的任务则是通过对视频序列中组群成员运动特征的 感知、计算、提纯,并归纳出稳定的、鲜明的模式,进而 再通过分类归纳得出代表整个组群典型行为特征的群 组行为类别以及每个成员的行为类别. 近年来,它已经 成为计算机视觉、人工智能等领域的热点课题,其在体 育赛事分析、异常行为检测及预警、实时人群场景的视 频分类等方面具有重要价值 . 由于群组行为本身具有 复杂性和多样性,以及视频据在采集过程中也会受到 视角变化、成员彼此遮挡、复杂场景中无关人员干扰等 因素的影响,如何设计高效的识别方法成为了该课题 的难点.

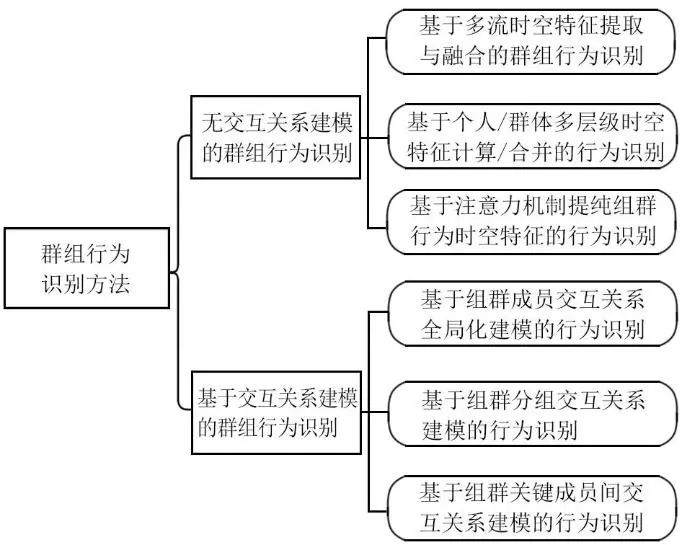

群组行为识别主要包含两个过程,即群组时空特 征描述和行为属性分类,而群组时空特征描述是最关 键的一步 . 鉴于群组行为是多人协同合作完成的复杂 行为,其时空特征的核心应该是成员之间的交互关 系,因此,本文依据群组时空特征描述算法中是否包 含“组群成员之间交互关系建模”这一核心环节,将 群组行为识别方法分为“无交互关系建模的群组行 为识别”和“基于交互关系建模的群组行为识别”两 大类 .

“无交互关系建模的群组行为识别方法”的主要思 想是把群组行为过程视为一个时序整体,这类算法主 要聚焦于如何对该“视频时序整体的时空特征进行 计算和提纯”,本文将从“多流时空特征计算融合” “个人/群体多层级时空特征计算合并”“基于注意力 机制的群组行为时空特征提纯”3 类典型算法特点 进行归纳和概述 . 另外,对于“基于交互关系建模的 群组行为识别”算法,依据交互关系建模方法的不 同,将现有文献归纳为“基于组群成员交互关系的全 局化建模”“基于组群分组下的交互关系建模”和“基 于关键人物为主的核心成员间交互关系建模”3 种类 别分别概述 . 简明起见,上述这些群组行为识别方法的 归纳分类用图1展示.

图1 群组行为识别算法的总体分类

2 无交互关系建模的群组行为识别

“无交互关系建模的群组行为识别”实际上是一种 相对“粗放的方法”,表现在其缺少了对“群体成员之间 细腻的彼此互动”这一环节的描述,而仅仅是对整体场 景的时空特征变化进行了刻画. 具体地,主要是对输入 图像序列的场景外观、组群成员的姿态、成员运动光 流、帧间时间序列依存关系等信息进行提取,并通过 分类器对获得的整个群组行为的时空特征进行分类 和识别 . 在深度学习框架下,这种群组行为识别方法 主要是通过 CNN,LSTM以及其变形体设计出不同的算 法框架,旨在解决“整体组群的时空特征的计算和提 纯”. 故本文将现有的对应算法概括为“多流时空特征计 算融合”“个人/群体多层级时空特征计算合并”“基于注 意力机制的群组行为时空特征提纯”3 个类别,现分述 如下.

2.1 基于多流时空特征提取与融合的群组行为识别

组群场景信息是多样的,有些信息是相互补充的,因而,利用多种时空特征信息的组合可以达到全面对群组行为特征建模的效果.这种思路主要是应用在早期的群组行为算法中,典型的就是多流架构特征计算与聚合的识别方法.

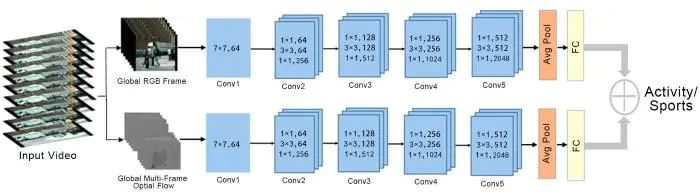

为充分利用组群场景的外观信息和运动信息,Simonyan等[1]提出了一种双流网络,其包含空间流支路和运动流支路,如图2所示,其中,空间流支路对RGB图像信息进行处理,主要提取外观特征,运动流对光流数据进行学习和训练,从而提取到运动信息,再将得到的两支路的信息进行融合处理,由于其两条支路提取的不同信息能够互为补充,从而起到丰富组群时空特征的作用,进而达到群组行为有效识别的目的.

图2 基于双流网络框架的群组行为识别[1]

由于双流网络模型简单,便于训练,许多学者使用并发展了它,实现了更多不同特征类别的融合,并应用于群组行为识别中.Borja-Borja等[2]通过一种行为描述向量(Activity Description Vector)得到LRF(Left Right Frequency)图像和UDF(Up Down Frequency)图像的数据,并分别输入到ResNet网络中进行深度特征的提取,最后,将两种特征融合后通过分类器实现群组行为分类.Zalluhoglu等[3]提出了一种利用多个区域提取信息的多流卷积神经网络体系结构,首先将视频序列分为带有背景信息的RGB图像、只包含特定人员的RGB图像信息(Region)和光流序列3种数据;其次,将带有背景信息的RGB图像输入到空间CNN(Convolutional Neural Network)网络,将特定人员(Region)区域图像输入到空间局部CNN网络(Spatial Region Stream CNN)中;同时将光流信息输入到时间局部CNN网络(Temporal Region CNN)和时间CNN网络(Temporal CNN)中;再将Region数据分别输入到空间域CNN网络和时间域CNN网络中的池化层中,从而进一步确定对应的成员和帧;最后提取视频序列的空间信息和时间信息,并将4种CNN网络所提取的时空信息进行融合后,由分类器得到群组行为类别.

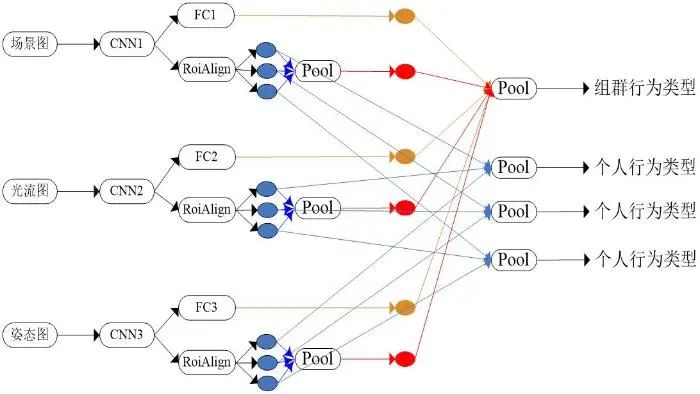

鉴于组群外观和光流运动信息易受到光照变化、相机运动等背景因素的影响,组群成员的姿态关节数据逐渐成为被推崇的鲁棒特征选项.这主要是因为人体姿态可以利用关节点的位置进行刻画,并通过坐标的变化表示姿态的不同,不易受拍摄角度、特征尺度等外界因素的影响,显示其鲁棒性更强而被开发利用.Azar等[4]利用多流卷积网络(Multi-Stream Convolutional Network)对姿态、RGB空间、光流特征进行融合,如图3所示,首先利用CNN1,CNN2和CNN3分别对场景图、光流图和姿态图提取3种特征,其次借助RoiAlign对个体的外观信息、运动信息和姿态信息进行提取,同时,利用全连接层提取整体场景语境表征、运动语境和姿态语境表征,最后对个体特征、整体语义特征分别进行池化操作,实现了不同模态的多流特征融合的群组行为识别.

图3 基于多流网络的群组行为识别[4]

此外,为了更好地获取群组行为的帧间时序依存信息,王传旭等[5]提出了一种基于多流架构与长短时记忆网络的模型,将全局RGB数据和全局光流数据通过全局LSTM(Long Short-Term Memory)提取全局时空信息,将局部RGB数据和局部光流数据通过局部LSTM提取局部时空特征,并将两种时空特征融合从而得到更加全面的群组特征.

概而言之,多流时空特征融合实现群组行为识别的算法,优点是每个支路网络简单,并且在内容上能互为补充,可以全面地描述组群场景的时空特征.但每一支路常常要预先分开训练,这样会造成整体网络架构训练时间耗费过长;此外,这种多支路网络的训练对数据集规模有一定的要求,如果数据集有限,往往难以收敛或者造成过拟合,故这种多流架构模型的泛化性较差.因此,为了既能提取不同的时空特征,又能方便网络训练,研究者们提出了能提取个人/群体多层级特征的网络结构,不仅可以获得多语义群组信息,还可以提升模型的泛化能力.

2.2 基于个人/群体多层级时空特征计算/合并的群组行为识别

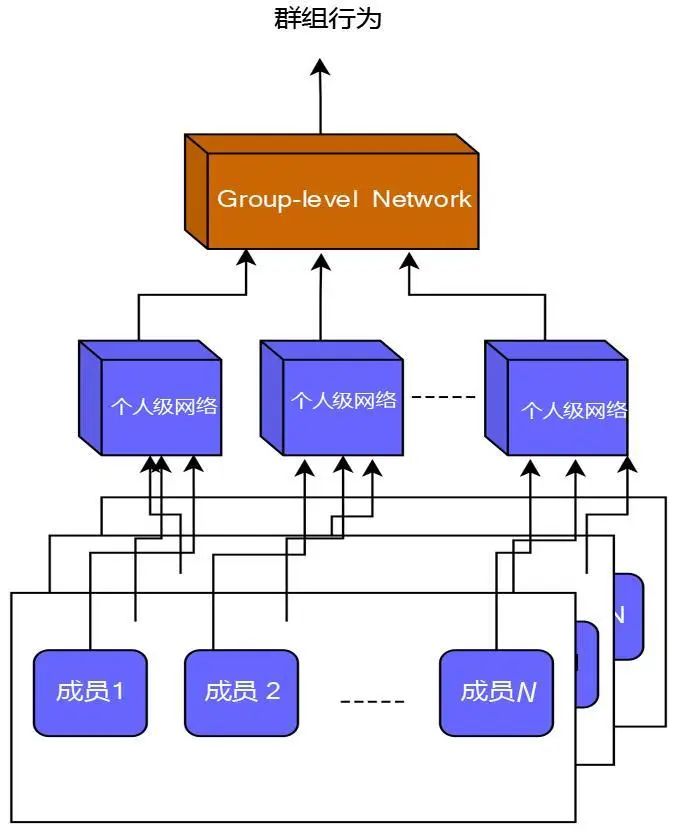

这类算法的设计原理可以概括为如图4所示的逻辑结构图,鉴于群组行为是由多个成员个体协同完成的,于是,先将每个成员的信息输入到个人级网络中得到个人级特征,再将每帧中个人级特征聚合到组群级网络中得到群组时空特征,最后利用分类器识别群组行为.

图4 基于层级网络结构的群组行为识别

典型地,Ibrahim等[6]通过两阶段分层深度时间模型(Hierarchial Deep Temporal Model)实现群组行为识别,首先在第一阶段通过个人级LSTM模拟每个个体的轨迹和动作;然后在第二阶段中通过小组级LSTM将个体特征进行结合,构成群组特征,建立了人-人、人-群组两种层次的模型,最后针对高层组群特征实现行为识别.Tsunoda等[7]将分层LSTM模型用于对足球运动群组行为的识别中,该模型由CNN层和两层LSTM(即LSTM1和LSTM2)组成,其中CNN层提取单人特征,包括成员外观特征和每个人位置信息以及足球位置信息的级联,LSTM1层提取“球-人之间距离”以及“人-人之间距离”,LSTM2负责集成场景中成员的时序特征;最后由分类器实现了五人制足球群组行为属性的识别.鉴于LSTM可以很好地捕捉序列的长时间依赖,Kim等[8]提出了一种基于显著子事件的判别组群上下文特征(Disentangled Graph Collaborative Filtering,DGCF)模型来识别群组行为,首先依据视频序列(包含bounding box)得到每帧内每个成员的位置信息,并计算成员速度和方向获得个人和子组信息,从而得到每一帧的信息;然后为了提取整个视频帧的特征,引入了GRU(Gate Recurrent Unit)网络进行逐层群组行为特征提取,从而实现群组行为的分类.

除了利用LSTM/GRU网络,GAN(Generative Adversarial Networks)网络也被用于层次结构的群组行为识别.Gammulle等[9]提出了一种基于LSTM结构的多级顺序生成对抗性网络,该算法首先利用LSTM获得“成员级”和“场景级”的时序特征,经过门控融合单元将上述特征进行聚合,并将其作为GAN的生成器输入,由生成器预测当前时序过程的单人和群组行为属性;另外,生成器的预测结果与“场景级”的时序特征经过另一路门控融合单元聚合,由鉴别器对生成器的群组行为预判结果的真伪进行甄别和反馈,最终达到平衡时,得到当前的群组行为判断结果.

另外,由于语义信息对群组行为识别更具有指导性的作用,Li等[10]提出了一种基于语义的两层结构的群组行为识别模型:第一层为标题生成层,即利用CNN分别提取光流和RGB特征,并借助LSTM对其序列和光流、RGB信息生成语意标题;第二层为行为预测层,该层也是利用CNN和LSTM对标题进行推理从而生成群组行为识别标签.

上述多层递次的模型不断迭代应用,不仅可以逐层提纯和融合每层的特征,还能够进一步剖析群组行为内部潜在的高层次语义关系,达到提升群组行为识别精度的效果.但其相对于轻量级数据集(集体行为数据集[11]和排球数据集[6])由于样本数据量不丰富,而无法保证训练过程中的鲁棒性;再则,这种层次结构越高意味着网络深度越大,对设备的要求也就越高,因此,能够设计一种高效轻量级的组群时序特征提纯模型对群组行为的识别会更有意义,这样就催生了注意力机制下的组群时空特征描述算法.

2.3 基于注意力机制提纯群组行为时空特征的行为识别

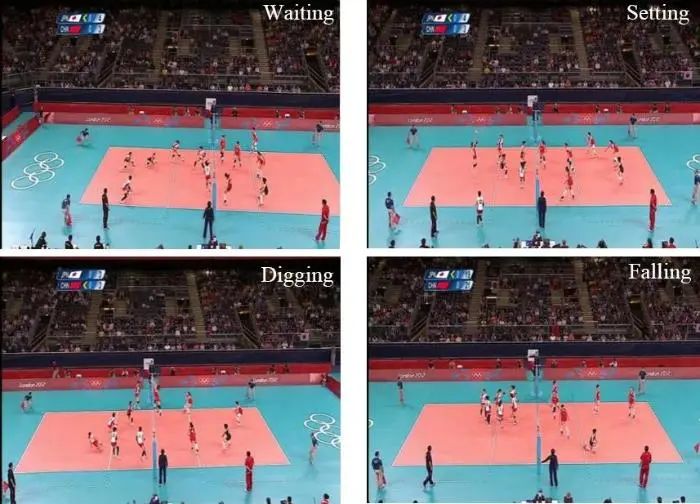

群组行为分为两种,如图5所示,一种是大多数人做的相同的动作(图5(a)),另一种是多人协同完成一种行为(图5(b)).针对后者,群组行为往往并不是由场景中的所有人都参与完成的,而是仅仅由少数的关键人参与并决定的,而那些与群组行为无关的人及动作则会干扰对群组行为的推断,即在图5(b)中“扣球”行为中,并非双方全体球员都参与了这次行为,相反,仅仅由“二传手”和“扣球手”两人来完成的.因此,剔除团队中无关的人物,确定团队中关键人物成了群组行为识别的重要方法,即群组行为中的关键人物注意力机制.

图5 两种群组行为类型比较

(a) 大多数人做相同动作“Walking”实现的群组行为 (b) 由少数人参与并决定的群组行为

随着深度学习的发展,注意力机制已在图像识别、字幕识别[12]、机器翻译[13]、人体行为识别[14,15]等领域取得了良好的效果,也为群组行为识别提供了新的思路.Ramanathan等[16]引入注意力机制,通过BiLSTM计算每个个体的行为对群组行为的影响和重要程度,从而区分不同的个体行为在群组行为中发挥的作用.Karpathy等[17]等通过RNN(Recurrent Neural Network)网络实现对视频序列中人物的跟踪及对时变权重的自动学习,提取每个BiLSTM和轨迹信息,通过注意力获取关键人的信息.Lu等[18]提出了一种基于时空注意力机制的GRU模型,通过基于姿势的注意力机制捕捉到每个成员重要的关节点,并通过第一阶段的GRU网络实现对个人动作的识别,然后借助群组级的池化策略找到空间中重要成员并提取时间序列信息,使用时间注意力机制找到关键帧,从而得到最终的群组行为类别.Tang等[19]通过CCG-LSTM模型捕捉与群组行为相关人的运动,并通过注意力机制量化个体行为对群组行为的贡献,通过聚合LSTM聚合个人运动状态,从而实现对群组行为类别的判断.王传旭等[20]将注意力机制、CNN网络和LSTM网络结合从而提取群组中关键成员的时空信息.

基于注意力机制的群组行为识别方法,不仅能够考虑到所有人的特征,同时还可以依据每个成员在不同时间点上对群组行为的贡献程度,进行空间上和时间上的特征优化,剔除了与群组行为无关的人和帧,有效提纯了组群信息,提高了识别精度.

上述3种架构下的无交互关系建模群组行为识别算法主要是对场景中组群的整体特征进行多线索/多层级的提取和融合,旨在获得组群全面的、显著的行为描述,实现较好的识别效果.但该类方法所提取的信息仍然局限于组群宏观的整体底层特征描述及其融合,缺乏对群组内部成员之间协同并存、彼此依存关系这一核心信息的挖掘,即缺少成员之间交互关系的建模,最终限制了其识别精度的提升.

3 基于交互关系建模的群组行为识别

与单人行为识别方法不同,群组行为是由多人共同参与完成的,因此,群组行为识别不仅要考虑个体行为、空间位置等信息,还要重点考虑群体中人与人的交互信息.本文定义群组的交互关系是指群体成员之间互动关系总和,它表现为某一行为过程中的成员间彼此影响、相互制约,并通过该彼此关联信息把整个组群交融成一个整体.上述无交互关系建模的群组行为识别算法只是从整体上对群组时空特征进行描述,忽略了运动过程中人与人之间的互动关系.因此,随着群组行为识别研究的深入,建立并推理群组中的交互关系成了群组行为建模的核心任务.本节依据交互关系建模方法的不同,将其归纳为“基于群组成员交互关系全局化建模的行为识别”“基于群组分组交互关系建模的行为识别”“基于群组关键成员间交互关系建模的行为识别”3种类别分别概述.

4 群组行为数据集及不同算法实现性能的分析比较

随着对群组行为识别技术不断深入地研究,群组行为数据集也相继推出.目前,用于群组行为识别的经典数据集如表1所示.

表1 群组行为识别数据集

| 数据集名称 | 视频数量 | 片段数量 | 个人标签种类 | 群组标签种类 | 时间 | 视频来源 | 视频类型 |

|---|---|---|---|---|---|---|---|

| NUS-HGA[47] | — | 476 | — | 6 | 2009年 | Youtube | 监控数据集 |

| BEHAVE[48] | — | 174 | — | 10 | 2009年 | Youtube | |

| CAD | 25 | 2 500 | 6 | 5 | 2009年 | Youtube | |

| CAED | 30 | 3 300 | 8 | 6 | 2011年 | Youtube | |

| nCAD | 32 | 2 000 | 3 | 6 | 2012年 | Youtube | |

| Volleyball | 55 | 4 830 | 9 | 8 | 2016年 | Youtube | 运动数据集 |

| NCAA Basketball | 257 | 6 553 | — | 11 | 2016年 | Youtube | |

| C-sports | 257 | 2 187 | 5 | 11 | 2020年 | Youtube | |

| NBA dataset | 181 | 9 172 | — | 9 | 2020年 | Youtube |

新窗口打开| 下载CSV

表1列出了群组行为识别的相关数据集.不难发现,随着群组行为数据集的规模不断扩大,数据集的种类也不断更新,为群组行为识别未来的发展提供了可靠的数据支撑,下面将重点介绍其中几个典型的数据集.

4.1 集体行为数据集及扩展数据集

CAD(Collective Activity Dataset)数据集包含由低分辨率手持相机收集的44个视频剪辑,共有2 500个片段,如图12所示.其包含6类个人动作标签,即NA,Crossing,Queuing,Walking,Talking,Waiting,同样包含5类群组行为标签,即Crossing,Queuing,Walking,Talking,Waiting.由于相机在采集数据集时角度是固定的,背景是静态的,动作变化也是缓慢的,数据集相对较小,通常会使用早期的深度学习网络来评估.在实验过程中,一般将70%作为训练集,其余作为验证集和测试集.

图12 CAD数据集中的2个群组行为类别举例

(a) “Waiting”群组行为 (b) “Moving”群组行为

鉴于CAD数据集规模较少,因此,提出CAED(Collective Activity Extended Dataset)数据集对其进行了拓展.该数据集将Walking动作从CAD中移除,并补充了两个新的动作类型,分别是Dancing和Jogging,因此,CAED数据集共有6种行为标签,分别是Crossing,Queuing,Dancing,Talking,Waiting,Jogging.每个人都分配有一个行为标签,每一帧图像也包含一个群组行为标签.

同样,nCAD(new Collective Activity Dataset)数据集依然是CAD数据集的扩展,包含了6个集体行为类别(Crossing,Queuing,Dancing,Walking,Waiting,Jogging),8种姿势标签(right,right-front,

在集体行为数据集中,集体行为的属性主要是依据大多数人的行为来进行判断的,即大多数人的行为标签即为群组行为标签.

4.2 排球数据集VD(Volleyball Dataset)

群组行为的定义并非仅仅是对大多数人做相同行为的描述,而更多的是对组群成员协同完成复杂行为的刻画.为此,为了评估深度学习模型的泛化性,许多学者对运动数据集进行了提升,最常用的运动数据集为排球数据集(VD)[49~51].该数据集是基于公开的Youtube排球比赛视频收集而成的,如图13所示,共有4 830帧,55段视频.对于每一帧,每个人都被赋予一个动作类型(Waiting,Setting,Digging,Failing,Spiking,Blocking,Jumping,Standing,Moving),同时包含每组的群组行为类型之一(right-pass,right-spike,right-set,right-winpoint,left-pass,left-spike,left-set,left-winpoint).由于相机采集数据集时为可调的,故视频中参与者的运动变化相对适中.通常该数据集的72%用于训练,28%用于验证和测试.

图13 排球数据集中的4个群组行为类别举例

图13为排球数据集,主要展示了数据集中的4种群组行为类型:“左扣杀”“右赢球”“右扣杀”和“右发球”.而在排球数据集中,排球运动为所有人共同完成或关键人的动作决定,因此,其群组行为的标签为关键人的行为标签.

4.3 NBA数据集(NBA Dataset)

大多数用于群组行为识别的数据集对个人和群组行为都进行了标注,但NBA数据集则仅有视频级标注,并没有单人级的标注信息,其更适合于弱监督下的群组行为识别[52].该数据集包含了9 172个视频剪辑,共包含了9种群组行为:2p-succ,2p-fail-off,2p-fail-def,2p-layup-succ,2p-layup-fail-off,2p-layup-fail-def,3p-succ,3p-fail-off,3p-fail-def.在实验过程中,通常将该数据集的83%作为训练集,17%则作为测试集.

4.4 C-Sports数据集(Collective Sports Dataset)

现有体育运动数据集大多数是只针对一种运动进行分类,其种类有限,缺乏多样性,无法支持复杂和有代表性的模型的训练,为此,Zalluhoglu等[53]提出了一种新的群组行为数据集——Collective-Sports数据集(简称“C-Sports”),有效解决了现有数据集存在的局限性问题,该数据集中包含11个团体体育运动标签(A.Football,Basketball,Dodgeball,Football,Handball,Hurling,IceHockey,Lacrosse,Rugby,Volleyball,Waterpolo)和5种群组行为标签(Gather,Dismissal,Pass,Attack,Wander),其中数据集的80%作为训练集,20%则作为测试集,如图14所示.

图14 C-sports 数据集中的不同群组行为类别举例

图14中,从左到右、从上到下,运动类别分别为美式足球、篮球、躲避球、足球、手球、投掷、冰球、长曲棍球、橄榄球、排球、水球,其群组行为类型为“gather”“pass”“wander”“dismissal”“wander”“dismissal”“attack”“wander”“gather”“gather”“wander”.

4.5 典型群组行为识别方法性能的比较和分析

本文分别从无交互关系建模的群组行为识别方法和基于交互关系建模的群组行为识别算法对群组行为进行了阐述,并对相关数据集进行了介绍.为了验证各种算法在不同数据集上的性能,表2和表3对其进行了展示.其中,OF表示光流图像,代表相邻时间图像之间的瞬时速度;Pose代表姿态信息;“—”表示为没有进行实验;其百分比表示每类算法在该数据集上的平均精确度MPCA.

表2 无交互关系建模的群组行为识别方法在不同数据集下的性能比较

| Method | Date | Input | CAD | CADE | UCL Courtyard | Volleyball | NBA dataset | Multi-camera Futsal Game dataset |

|---|---|---|---|---|---|---|---|---|

| Choi[54] | 2012 | RGB | 80.2% | 83.0% | — | — | — | — |

| DLM[55] | 2012 | RGB | 78.4% | — | — | — | — | — |

| SIM[56] | 2015 | RGB | 83.40% | 90.23% | — | — | — | — |

| Zappardino[49] | 2021 | RGB+OF | — | — | — | 91.00% | — | — |

| XU[28] | 2020 | RGB+OF | 91.2% | — | — | 93.49% | — | — |

| GLIL[29] | 2020 | RGB | 94.40% | — | — | 93.04% | — | — |

| LARG[40] | 2019 | RGB | 92.60% | — | — | 91.00% | — | — |

| DRGCN[57] | 2020 | RGB | 89.60% | — | — | 92.20% | — | — |

| STPS[45] | 2018 | RGB | 95.70% | — | — | 90.00% | — | — |

| GAIM[58] | 2020 | RGB | 90.60% | 91.20% | — | 91.90% | — | — |

| CRM[59] | 2019 | RGB | 94.20% | — | — | 93.04% | — | — |

| SAM[52] | 2020 | RGB | — | — | — | — | 47.50% | — |

新窗口打开| 下载CSV

表3 基于交互关系建模的方法在不同数据集下的性能比较

| Method | Date | Input | CAD | CADE | UCL Courtyard | Volleyball | NBA dataset | Multi-camera futsal game dataset |

|---|---|---|---|---|---|---|---|---|

| Canon[7] | 2017 | RGB | — | — | — | — | — | 63.40% |

| Gavrilyuk[60] | 2020 | RGB | 80.60% | — | — | — | — | — |

| Region based multi-CNN[3] | 2019 | RGB,OF | 88.9% | — | — | 72.40% | — | — |

| SRNN[61] | 2018 | RGB | — | — | — | 89.90% | — | — |

| MCN[62] | 2018 | RGB,OF,Pose | 95.26% | — | — | 90.42% | — | — |

| Ibrahim[6] | 2016 | RGB | 81.50% | — | — | 51.50% | — | — |

| Wang[63] | 2017 | RGB | 89.40% | — | — | — | — | — |

| PCTDM[37] | 2018 | RGB | 92.20% | — | — | 88.10% | — | — |

| StagNet[26] | 2018 | RGB | — | 90.20% | 86.90% | 89.90% | — | — |

| Lu[18] | 2019 | RGB | — | — | — | 91.90% | — | — |

| Tang[19] | 2019 | RGB | 93.00% | — | — | 90.70% | — | — |

| MLS-GAN[9] | 2018 | RGB | 91.20% | — | — | 92.40% | — | — |

| Lu[64] | 2021 | RGB | 91.31% | — | — | 92.35% | — | — |

新窗口打开| 下载CSV

表2所示的为基于无交互关系建模的方法,通过对场景信息、运动信息等组群整体信息的提取,实现群组行为的识别.不难发现,大部分输入仍旧为RGB图像,取得了一定的效果,但算法MCN[9]除了RGB信息外,还引入了光流、姿态两路视觉信息,这3路特征信息最后经过池化融合后作为场景组群的时空特征,在CAD数据集上获得了95.26%的高平均识别精度,同时在Volleyball数据集也获得了90.42%的较高平均识别精度.

另外,表2中MLS-GAN[9]提出的基于LSTM结构的多级顺序生成对抗性网络,利用两个层次的“成员级”和“场景级”时序特征,经过门控融合单元聚合后,再利用GAN生成器对该融合特征进行单人和群组行为属性预判;另外鉴别器对生成器的群组行为预判结果的真伪进行甄别和反馈,最终达到平衡时,得到当前的群组行为判断结果,由于该算法经过GAN网络的多次矫正优化,在Volleyball数据集获得了92.40%的较高平均识别精度.

相比之下,表3中的算法通过对群组交互关系进行了提取和分析,细化了群组行为特征,在相同的数据集上平均识别精度均有明显提高.其中,算法XU[28]利用两个层级模块重点挖掘和充分利用了成员交互关系,具体地,将成员外观特征和位置信息输入到关系模块(Relational model)获得初始交互关系表达,然后,该特征与光流特征分别输入到Relation-GRU和Opt-GRU模块,两者融合得到帧级交互关系描述,最后利用注意力机制进行时序特征聚集,将不同权重的帧级特征整合视频级表示,作为分类器输入实现群组行为的识别.可见正是由于该算法对交互关系进行多层次提取融合,才得到了组群时空特征的精准表示,在Volleyball实际上取得了93.49%的高平均识别精度.另外,GLIL[29]在CAD和Volleyball数据集都取得了94.40%和93.04%较高平均识别精度,主要是得益于提出的GLIL(Graphical LSTM-In-LSTM)网络架构,它被形象地比喻为“宿主-寄生”体系结构,“寄生”模块是负责建立每个成员之间的交互关系建模,而“宿主”模块负责群体级行为建模,即将多个成员运动信息根据其对群体行为的贡献,选择性地整合并存储到“宿主”中,实现对全局交互关系的关键时空特征的选择和提纯,保障了较高的识别精度.

总的说来,通过对群组交互关系的提取和分析,可以达到细化群组行为特征的效果,使得在相同的数据集上相比较粗狂的无交互关系建模的方法,平均识别精确度都会有提高,因此,基于交互关系的群组行为识别的方法从整体上优于无交互关系的群组行为识别.

除此之外,从两个表格中发现,大多数算法是基于CAD和Volleyball数据集进行研究的,其识别效果大多数在80%以上.但也能发现,每种数据集仅能表示某一类的群组行为,缺乏多样性.因此,研究者们不断引入NBA,BFH[65]和C-Sports等数据集以便应用其他场景中.然而这些新数据集的引入并没有达到经典数据集的识别效果,在群组行为识别的效率和识别精度都有待提高.

5 总结与展望

5.1 总结

本文首先对群组行为识别的研究背景和研究意义进行了阐述,然后依据群组行为识别方法中是否包含“成员交互关系建模”,将其分为无交互关系建模的群组行为识别和基于交互关系建模的群组行为识别两大类;最后,介绍了相关的数据集以及两类群组行为识别方法在不同数据集下的性能比较.下面进一步对这两类算法的各自优势进行总结.

(1)无交互关系建模的群组行为识别方法可以从视频序列提取场景特征并进行识别.其中,基于多流网络的群组行为识别,能够通过不同信息的互相补充,从而丰富群组特征;基于层次结构的群组行为识别,能够通过逐层聚合获得群组特征;而基于注意力机制的方法,能够抑制场景中的冗余信息,从而提取群组中重要的时空特征.这3类算法的先进性总的说来是逐步提升的.

(2)交互关系为群组行为的关键信息,因此,通过捕获群组行为过程中的交互关系,能进一步细化群组特征. 其中,基于整体交互关系建模的群组行为识别能够提取并推理成员整体的交互关系,从而为群组行为识别提供全面的关系特征;基于分组交互关系建模的群组行为识别通过对群组成员进行分组关系建模并融合,能够化整为零,从而达到“分而治之”的效果;基于以关键人物为核心的交互关系建模的群组行为识别方法,能够捕获群组中关键成员以及与其密切相关的其他成员的特征、以及他们的交互关系,抑制与群组行为无关成员的信息,从而降低了群组行为识别过程中的噪声干扰,提高了群组行为识别效率.上述这3类算法的先进性总体上也是逐次进步的.

综上,无交互关系建模方法只是对场景整体信息进行笼统地提取而实现群组行为识别,其缺陷就是忽视了群组成员间的交互关系,使得其组群时空特征更多地只关注了底层特征,缺少高层交互以及语义特征的刻画;而基于交互关系建模的群组行为识别则更加细化了成员之间的互动以及语义表达,因此,它优于无交互关系建模的群组行为识别方法.

另外,基于交互关系建模实现群组行为识别的方法也有其不足,可以归纳为两点.其一是需要较多底层特征的支持,因为交互关系建模主要是两两成员间(pair-wise)的交互关系描述,除了基本的CNN/LSTM时空特征外,还需要成员的位置信息、运动轨迹、邻域上下文信息等信息,以便构建成员彼此之间关系[21],但这些信息需要多目标跟踪算法作为底层特征提取的保障,但是这些底层算法的精度却是有限的,因此,导致成员间交互关系的精度不高;其二表现为多层级交互关系的冗余,具体地,交互关系除了上面的两两之间交互关系外,往往还需要构建不同子组群之间的交互关系,以及最后融合为整个组群的交互关系特征,上述多层级上的交互关系是有交集的、非正交的,而最后融合得到的不同特征间集合也难以保证彼此的独立性,故这类交互关系信息不是最简洁的.上述这两个缺点会一起制约交互关系组群特征的区别性和显著性,进而影响群组行为识别精度的提升.

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复“GARA” 就可以获取《深度学习框架下群组行为识别算法综述》专知下载链接