深入理解推荐系统:超长用户行为序列建模

-

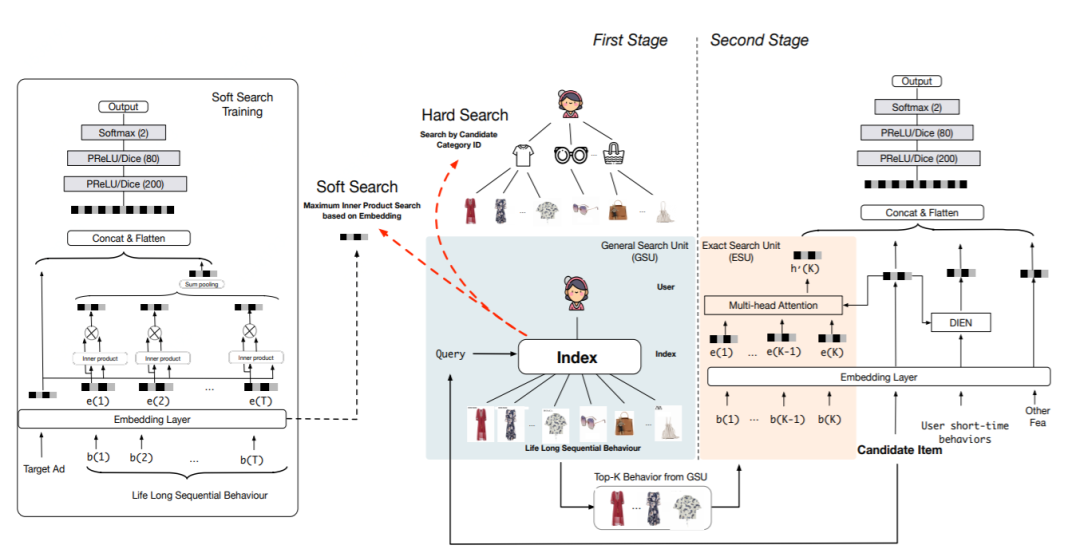

提出SIM建模长序列用户行为数据,两阶段的串行的机制设计使得SIM能够更好地建模lifelong序列行为数据; -

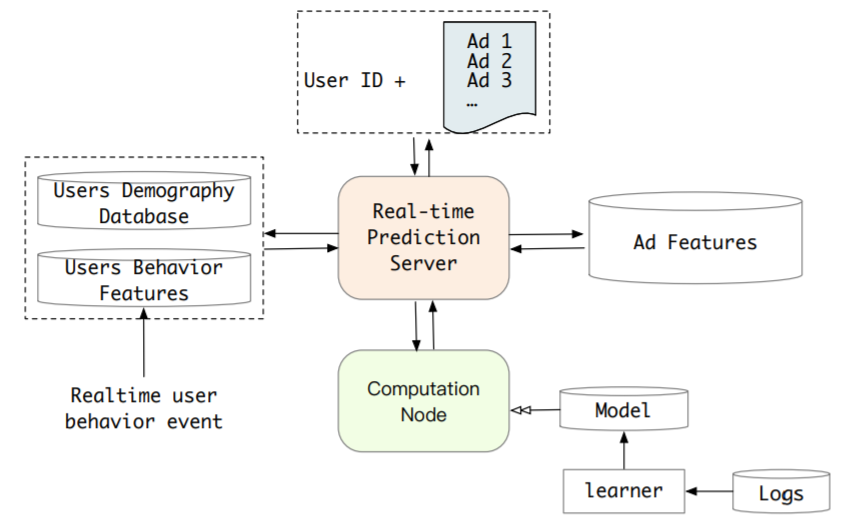

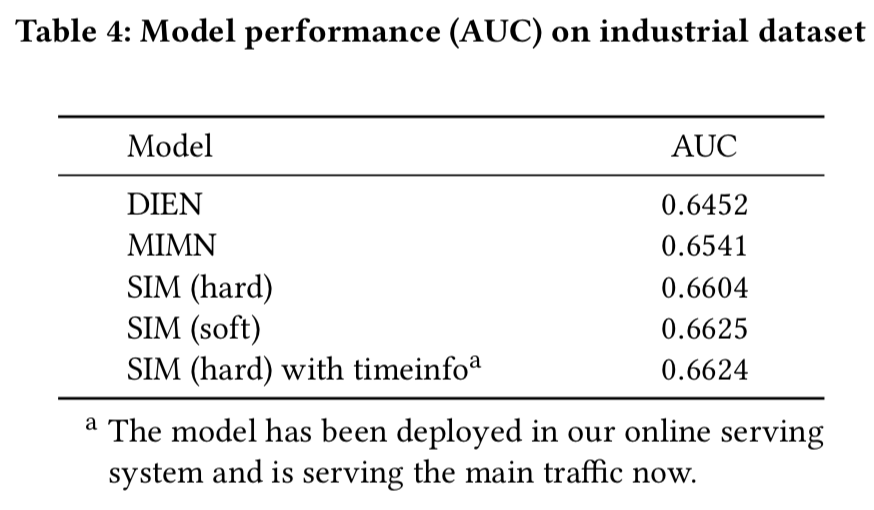

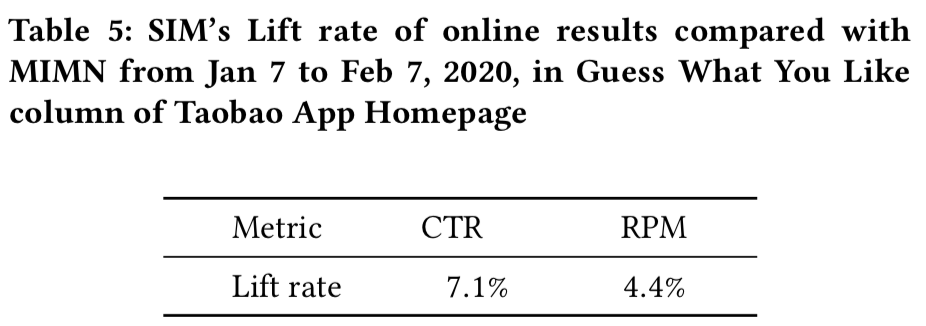

介绍了在大规模工业系统中部署SIM的实际经验,SIM已经部署在阿里展示广告系统上,带来了7.1%CTR和4.4%RPM的提升; -

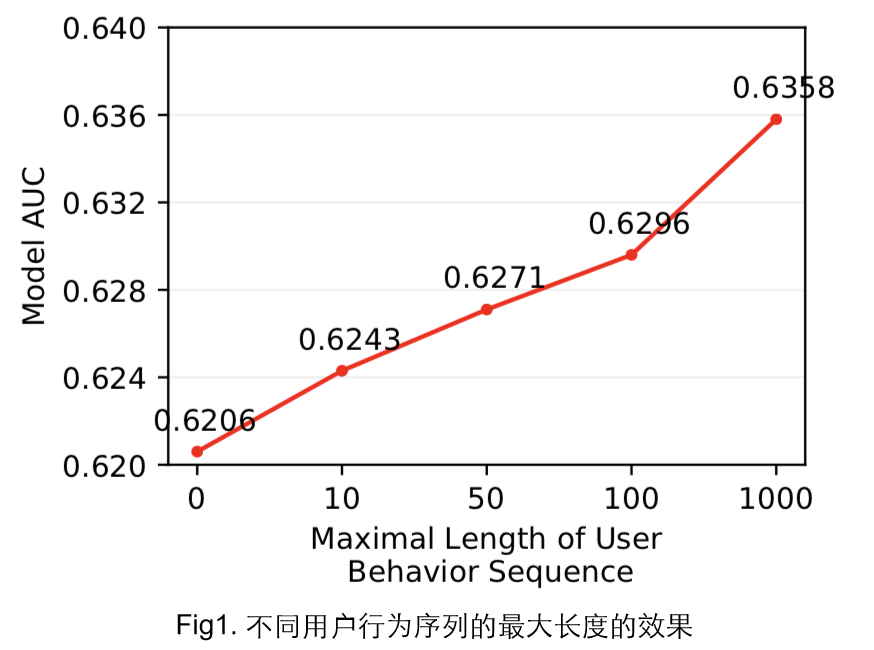

SIM推动用户行为长度最大到达54000,比MIMN提高了54倍。

-

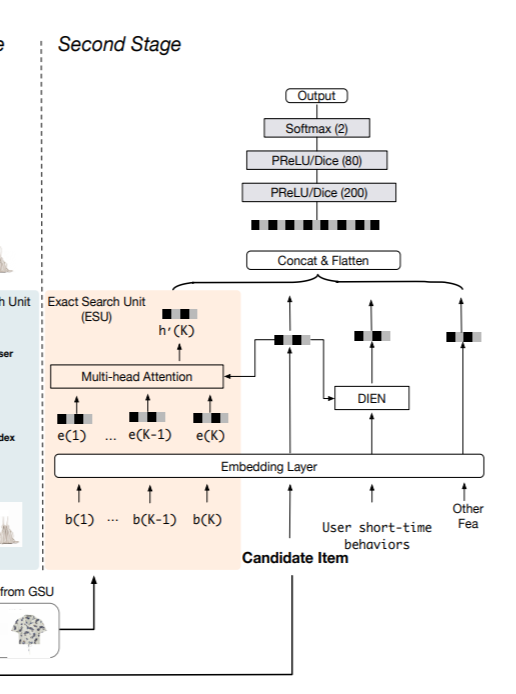

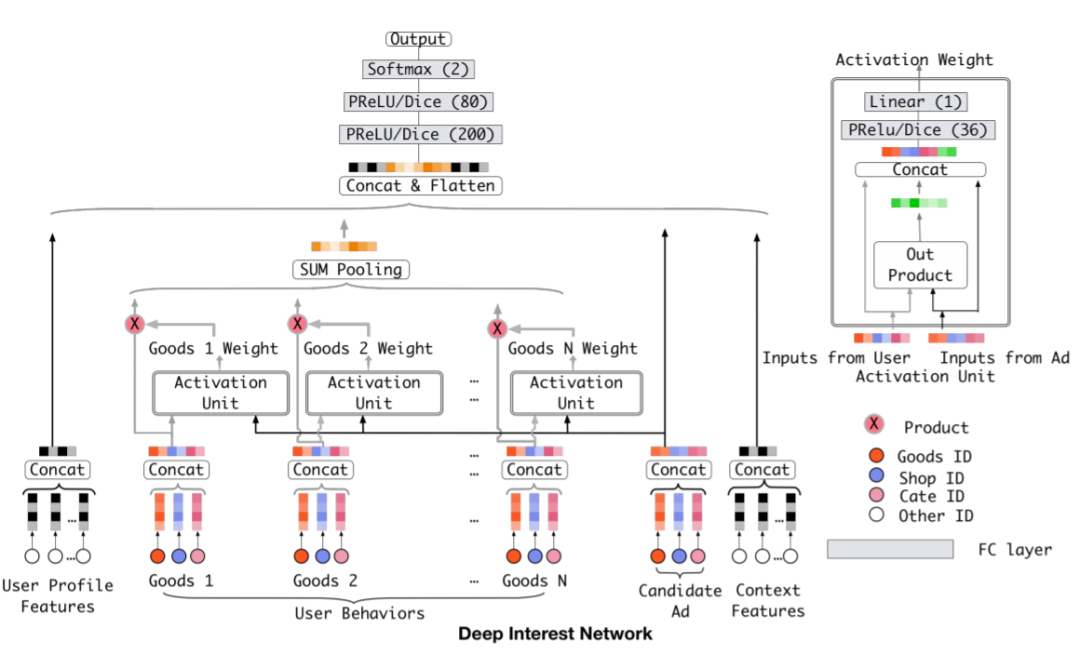

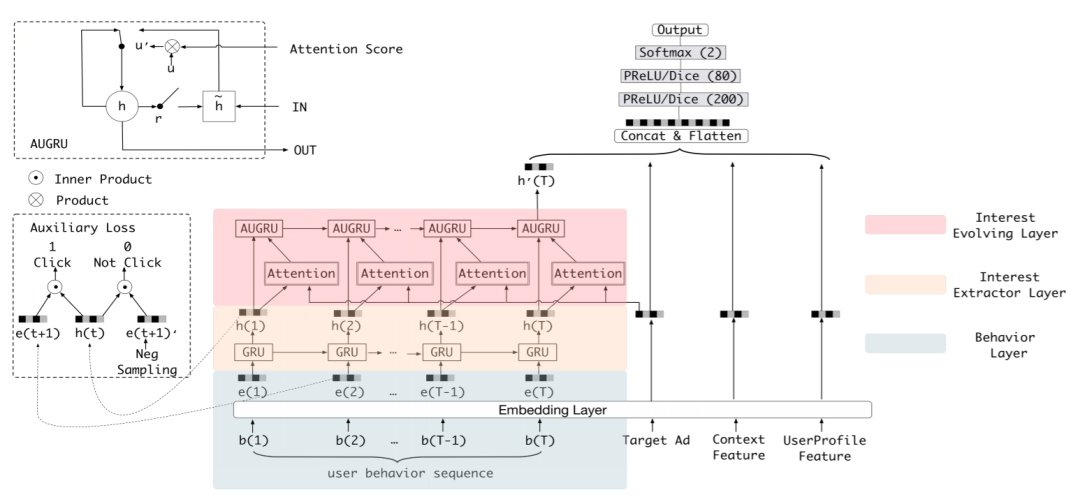

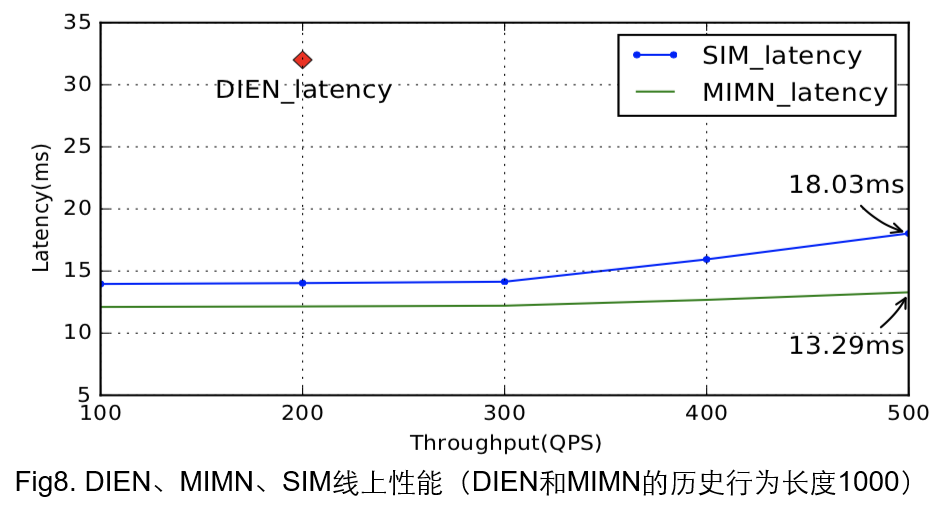

一种是考虑效果DIN和DIEN,优点:考虑候选广告和用户行为的关系(Attention等),使用与候选item相关的行为建模出用户对于当前候选的兴趣,即可以建模出用户对不同候选item的兴趣;缺点:用户行为不能太长,serving的性能和线上存储。 -

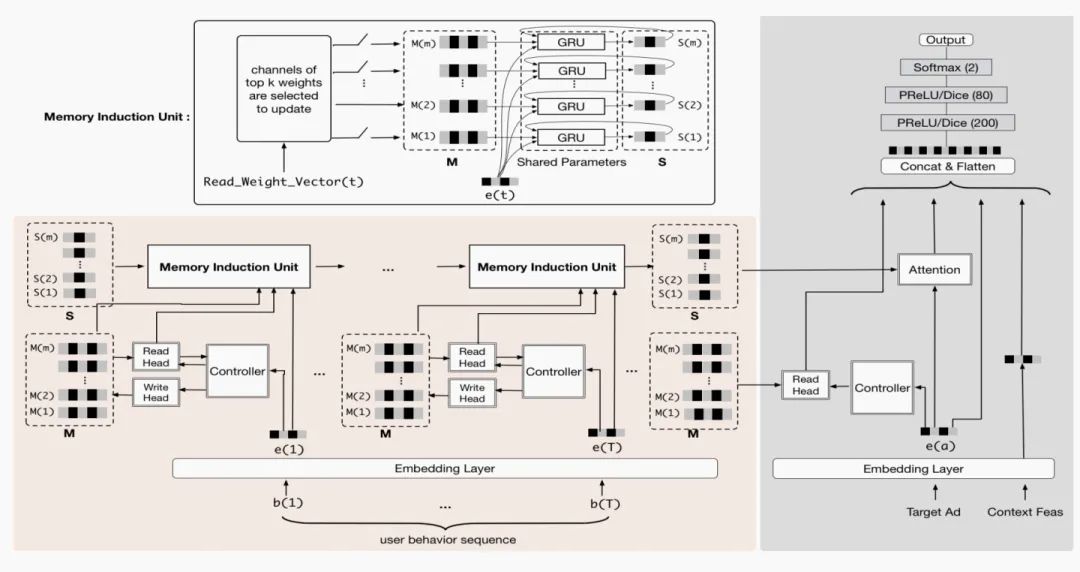

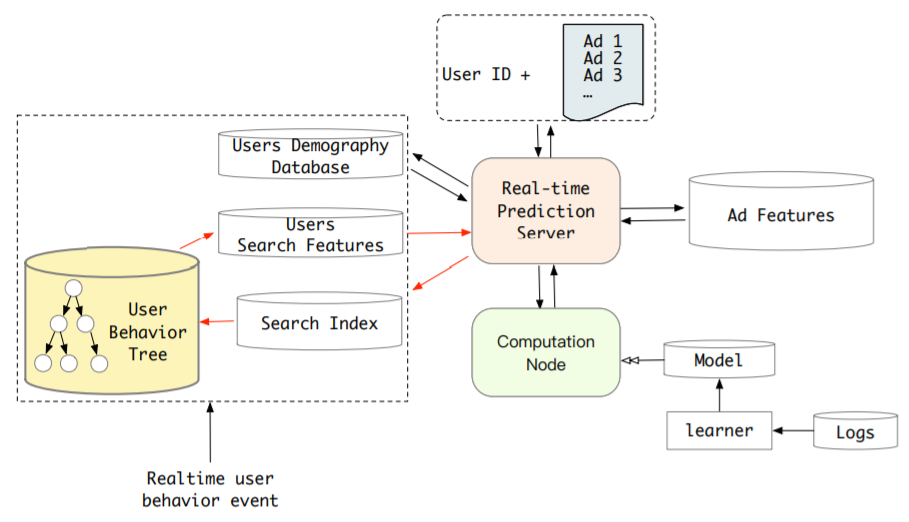

另一种是考虑性能MIMN,优点:将用户兴趣建模和ctr预估解耦,在用户兴趣建模方面,借鉴memory network的思路,使用两个矩阵M和S分别存储用户兴趣的信息和用户兴趣演化的信息,线上进行ctr预估时,只需要读取两个固定大小矩阵。因为兴趣矩阵可以提前计算好,所以不会对线上耗时造成较大的影响。缺点:固定大小的memory 矩阵表达信息是有限的,如果想建模更长的用户行为序列,memory-based的方法会面临表达能力有限,难以过滤噪声,建模随时间信息遗忘的问题。UIC&MIMN解耦了兴趣建模和在线CTR预估的计算,建模用户兴趣时模型无法获取和使用待预估的候选item的信息。

-

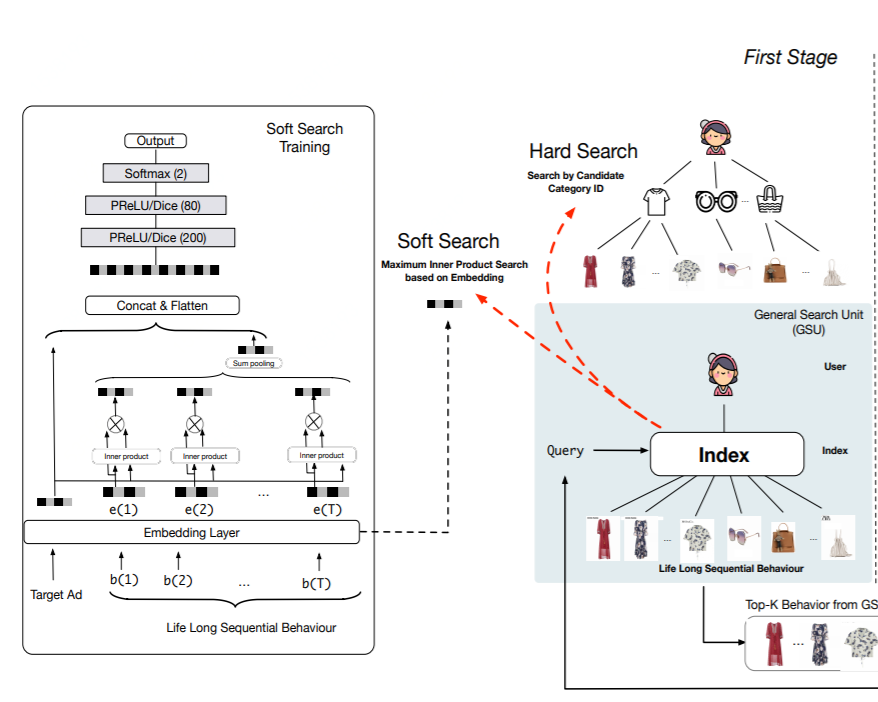

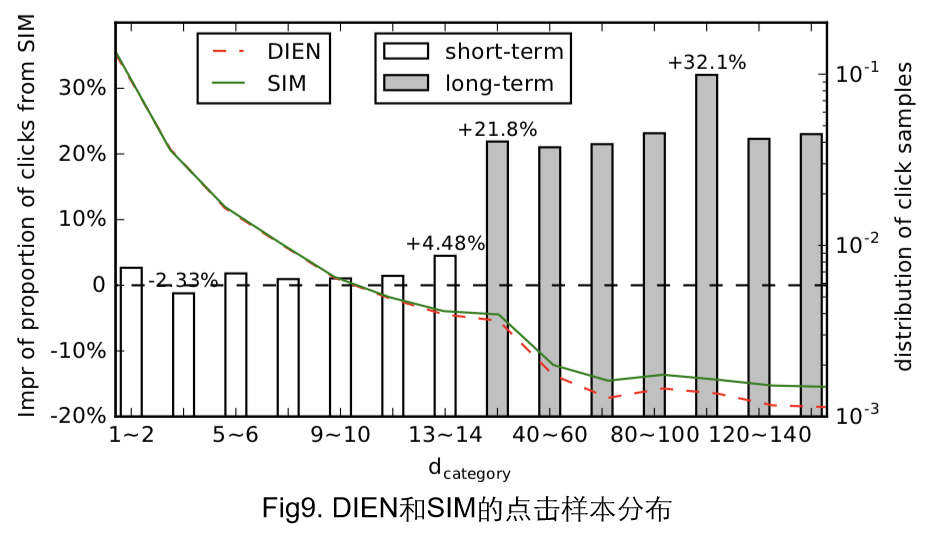

Hard Search,无参的方式。直接选出与候选item同类目的用户行为。这样做的原因是电商场景下,item天然具有层级结构,所以直接选出同类目的行为也是合理的。 -

Soft Search,用参数化的方式,对用户行为和候选item进行向量化,然后用向量检索的方式检索出Top_K个相关的行为(实现方法有Maximum Inner Product Search (MIPS)的方法ALSH)。文中提到因为长期用户行为的分布和短期用户行为的分布不一致,直接使用ctr模型中,短期行为学习到的embedding矩阵,会造成一定的误导,所以对于Soft Search中需要用到的embedding矩阵要单独搭建模型,进行训练。训练数据为超长的用户行为序列,作为ctr的一个辅助任务联合训练,如果行为过长,需要随机采样。

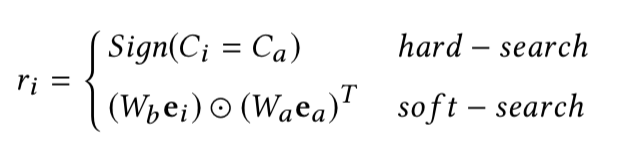

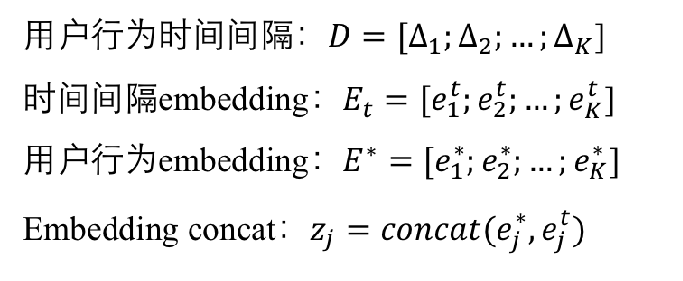

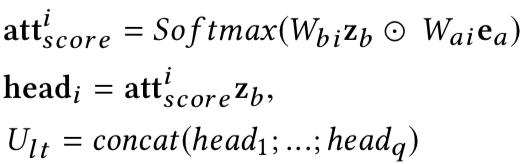

给定用户行为集合B=[b_1; b_2; ,,, ; b_T] ,其中b_i是第i个用户行为, T是用户行为的长度。GSU为每个行为b_i计算关于候选商品的相关性分数 r_i,然后根据r_i选择Top-K相关的行为得到行为序列 B^*。hard-search和soft-search不同点是r_i的计算公式:

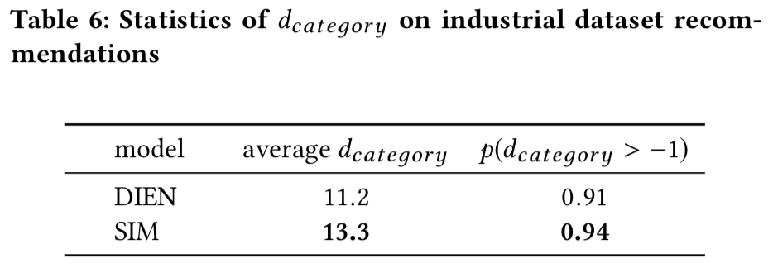

在工业数据上,Hard Search可以覆盖Soft Search中75%的行为,线上考虑性能使用了Hard Search。

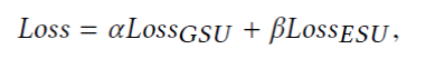

最后,其中第一阶段和第二阶段是采用交叉熵 loss 联合学习。Loss 函数如下:

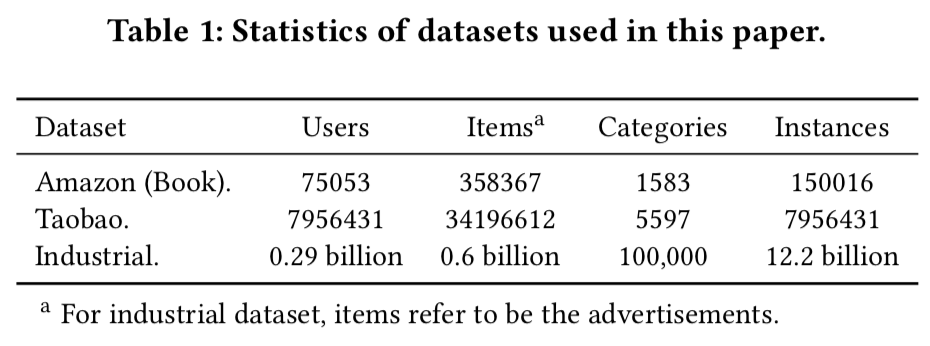

数据集 |

最大长度 |

短期行为 |

长期行为 |

Amazon(Book) |

100 |

最近10个 |

前90个 |

Taobao |

500 |

最近100个 |

前400个 |

Industrial |

30%超过10000,最大54000 |

近14天 |

180天 |

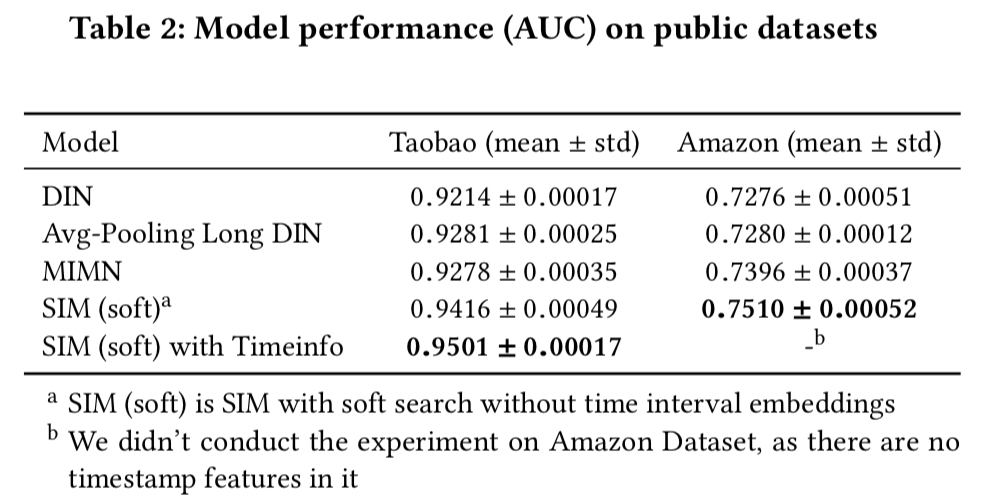

Avg-Pooling Long DIN,直接将长期用户行为Embedding avg-pooling与其他特征embedding拼接。SIM相比其他使用长期用户行为的模型提升比较多,分析原因是因为MIMN和Avg-pooling Long DIN将长期行为建模成固定长度的向量,难以获取用户多样的兴趣使用时间信息也有一定的帮助。

实验(公开数据集结果,其中optimizer为Adam,lr为0.001,FCN为200*80*2)

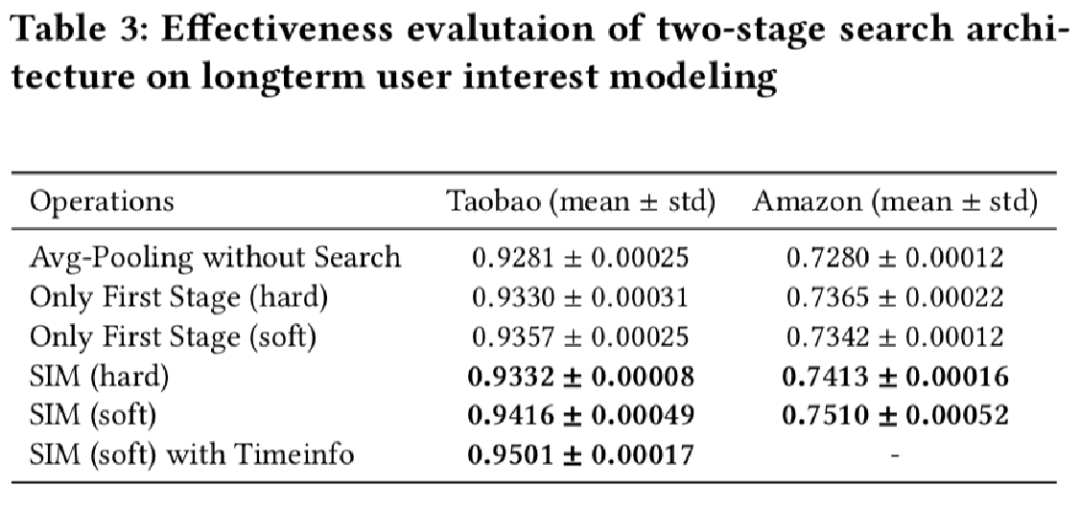

实验(公开数据集结果-消融实验)

消融实验验证两阶段搜索框架的有效性,Only first stage(Soft)内积相似度top50,有搜索的要优于没有进行搜索的 => 长期行为存在噪音,进行初步搜索是有必要的。两阶段搜索优于只有第一阶段搜索的 => 精确的建模与候选item相关的用户长期兴趣对ctr预估是有帮助的。

由于微信平台算法改版,公号内容将不再以时间排序展示,如果大家想第一时间看到我们的推送,强烈建议星标我们和给我们多点点【在看】。星标具体步骤为:

(1)点击页面最上方"AINLP",进入公众号主页。

(2)点击右上角的小点点,在弹出页面点击“设为星标”,就可以啦。

感谢支持,比心

推荐阅读

征稿启示| 200元稿费+5000DBC(价值20个小时GPU算力)

完结撒花!李宏毅老师深度学习与人类语言处理课程视频及课件(附下载)

模型压缩实践系列之——bert-of-theseus,一个非常亲民的bert压缩方法

文本自动摘要任务的“不完全”心得总结番外篇——submodular函数优化

斯坦福大学NLP组Python深度学习自然语言处理工具Stanza试用

关于AINLP

AINLP 是一个有趣有AI的自然语言处理社区,专注于 AI、NLP、机器学习、深度学习、推荐算法等相关技术的分享,主题包括文本摘要、智能问答、聊天机器人、机器翻译、自动生成、知识图谱、预训练模型、推荐系统、计算广告、招聘信息、求职经验分享等,欢迎关注!加技术交流群请添加AINLPer(id:ainlper),备注工作/研究方向+加群目的。

阅读至此了,分享、点赞、在看三选一吧🙏