7 Papers & Radios | 南加大游戏AI玩转《毁灭战士》;少样本NLP元学习综述

参与:杜伟、楚航、罗若天

本周的重要论文有南加大开发的玩转《毁灭战士》游戏的 AI 智能体,以及Salesforce 研究者的少样本 NLP 元学习综述。

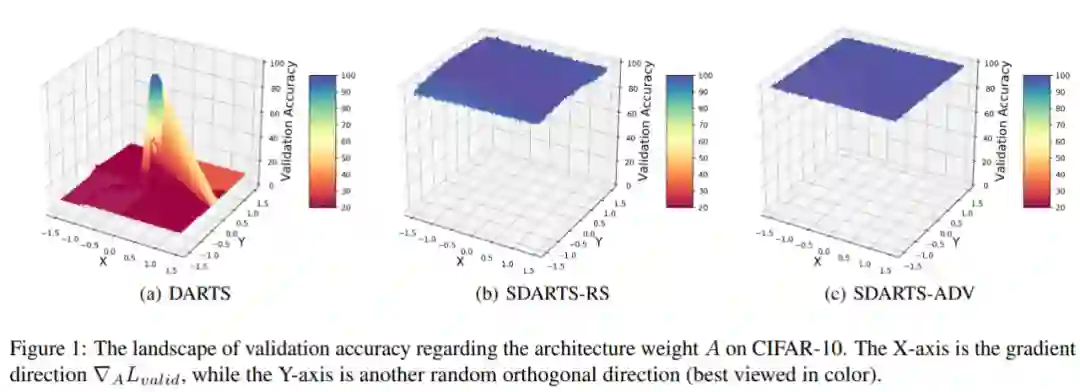

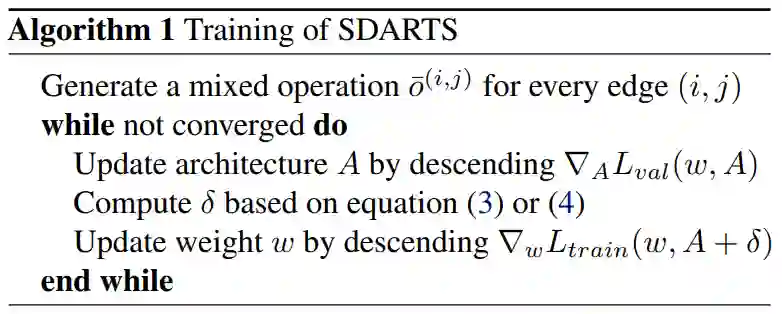

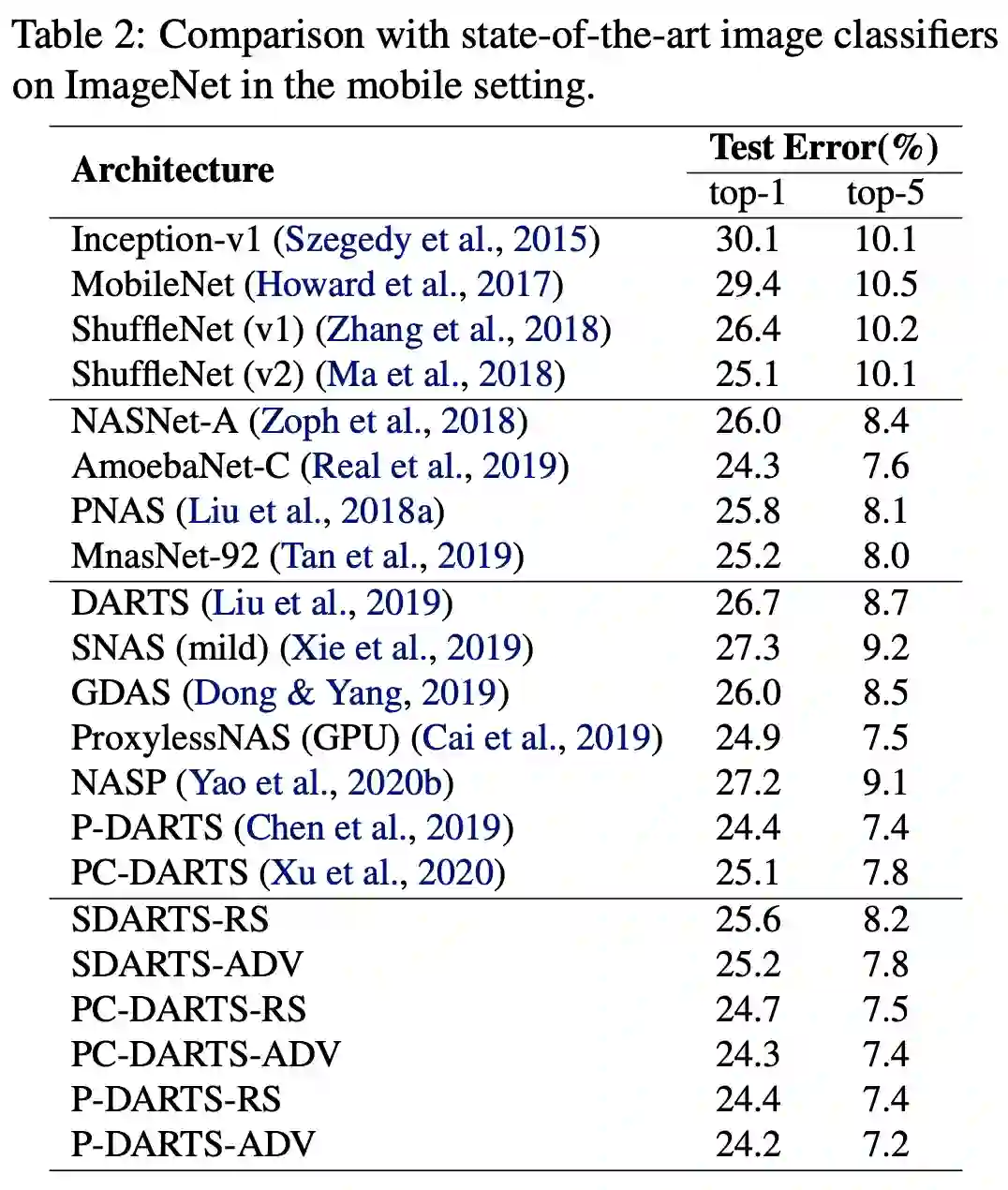

Stabilizing Differentiable Architecture Search via Perturbation-based Regularization

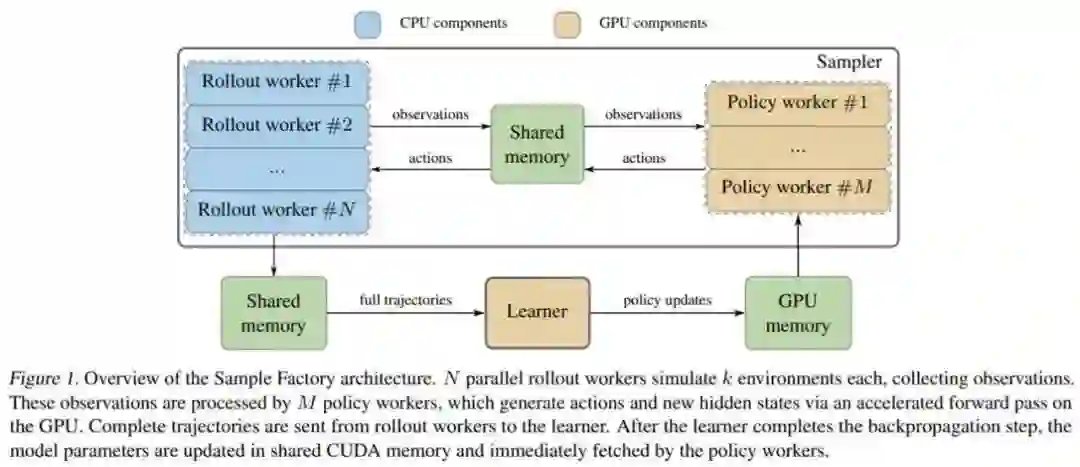

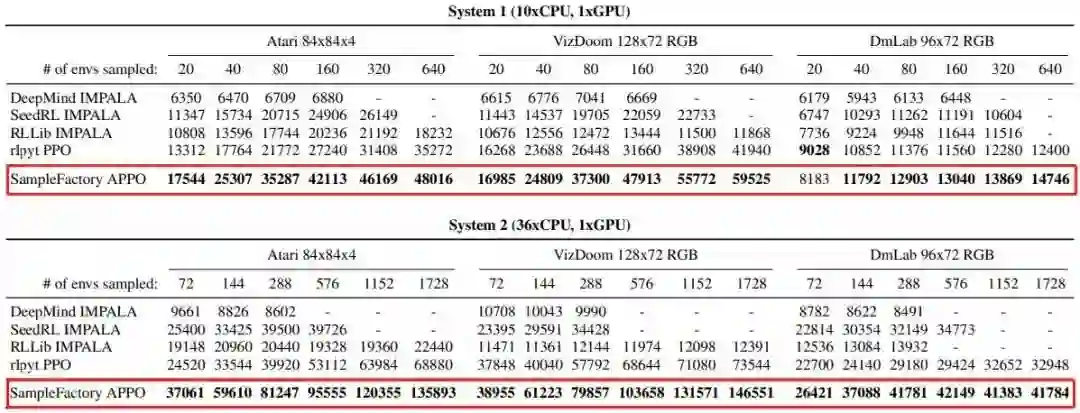

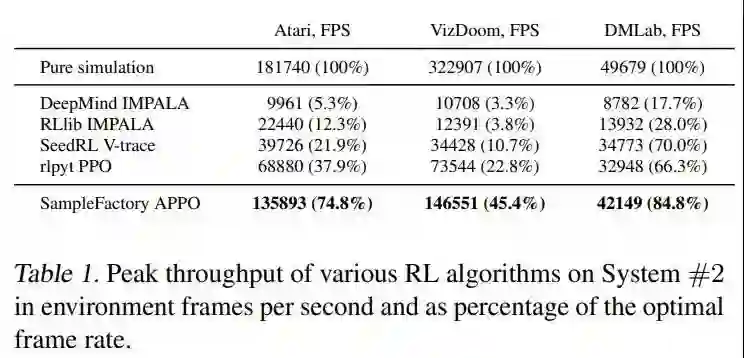

Sample Factory: Egocentric 3D Control from Pixels at 100000 FPS with Asynchronous Reinforcement Learning

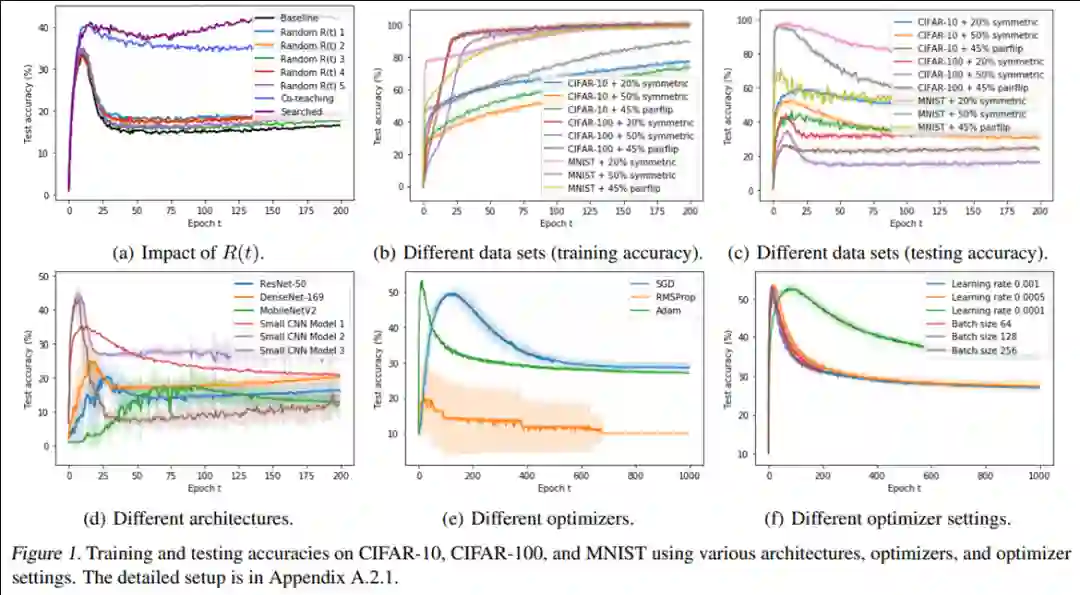

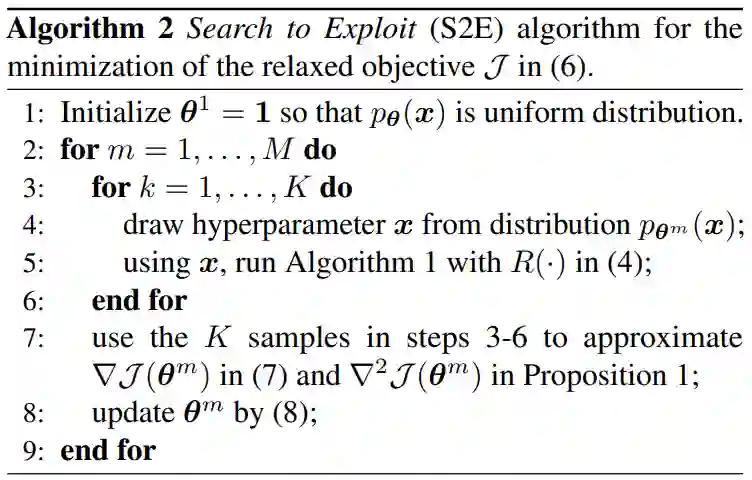

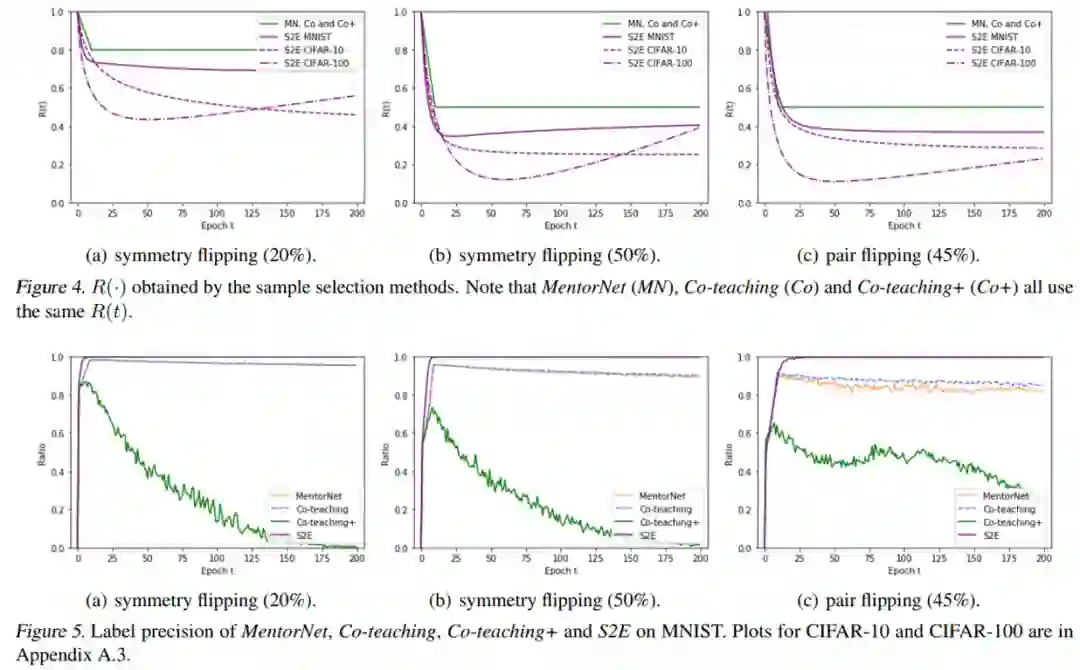

Searching to Exploit Memorization Effect in Learning with Noisy Labels

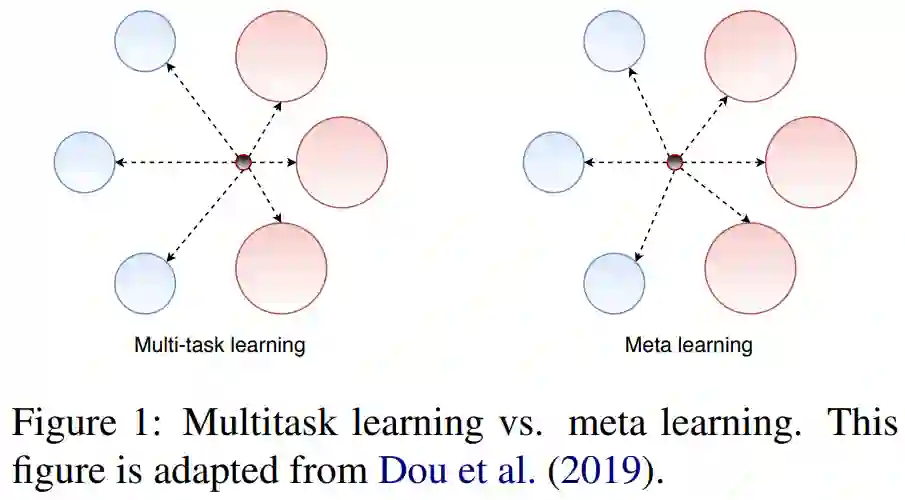

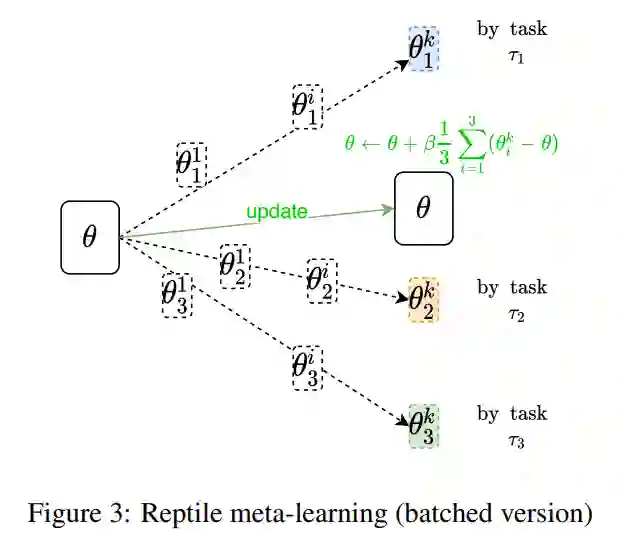

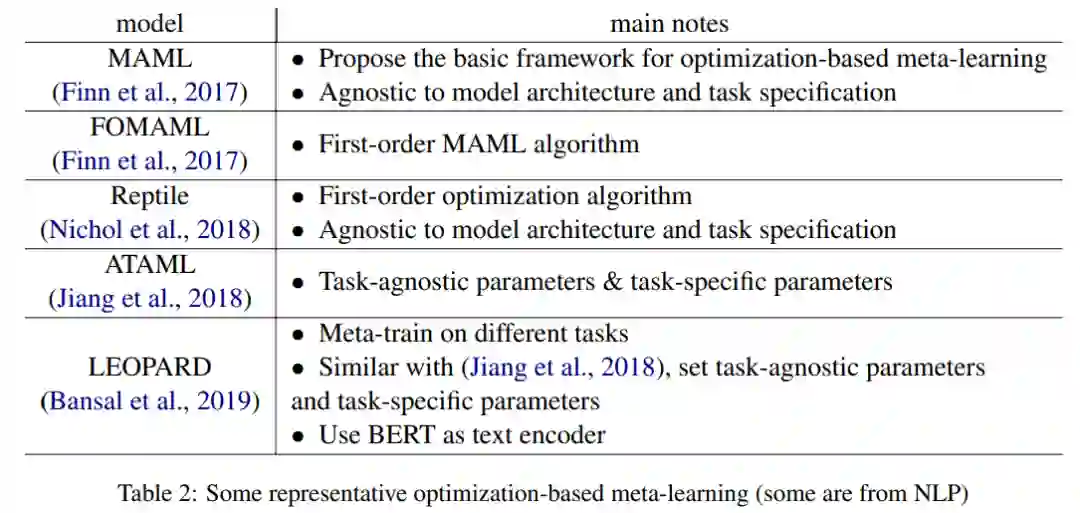

Meta-learning for Few-shot Natural Language Processing: A Survey

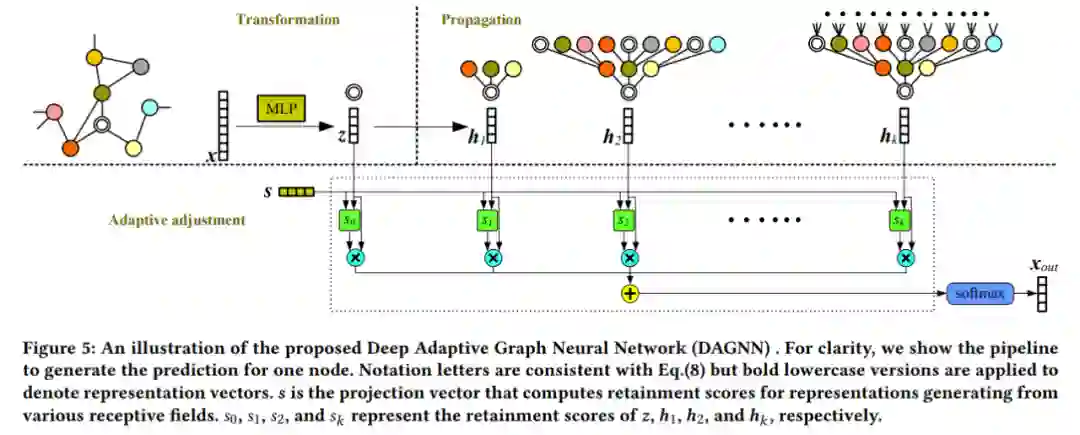

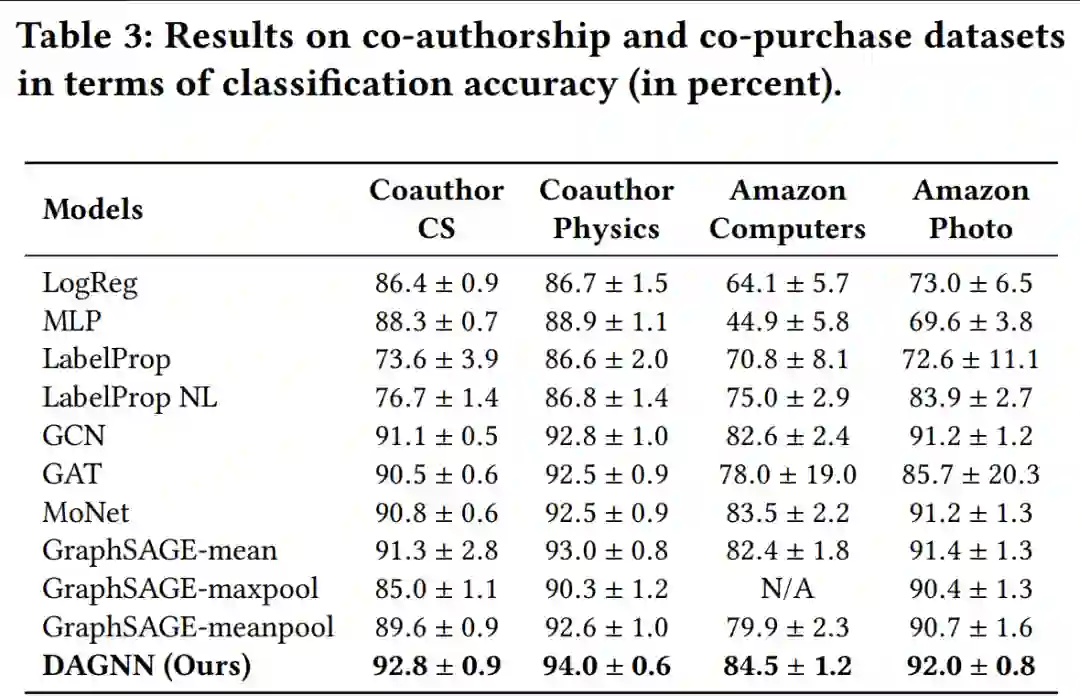

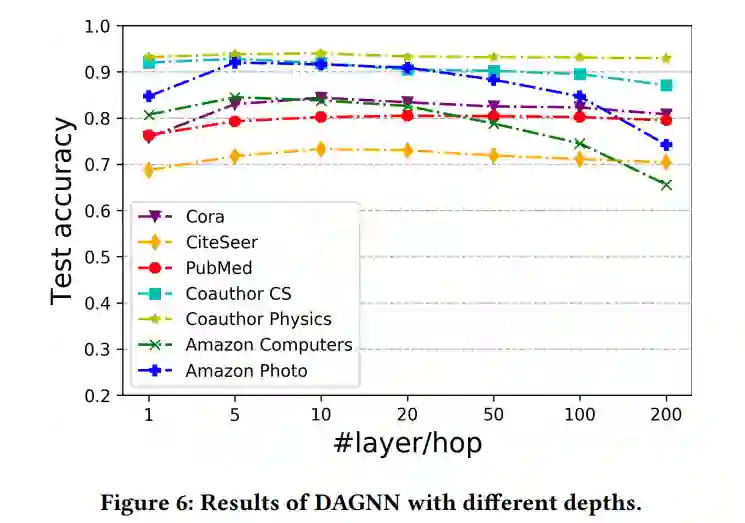

Towards Deeper Graph Neural Networks

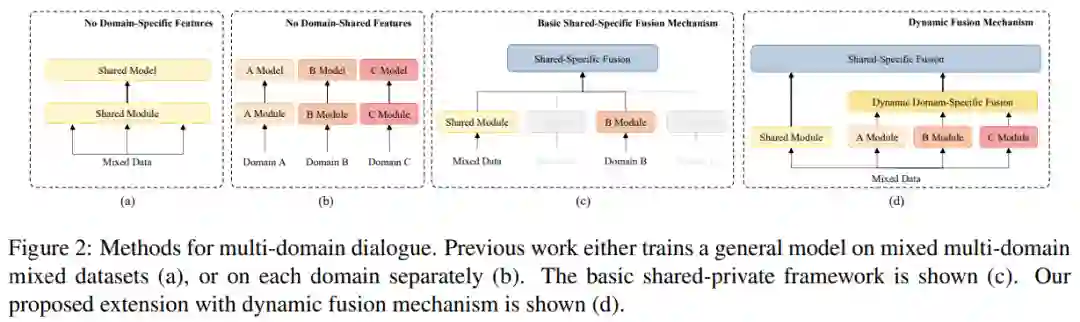

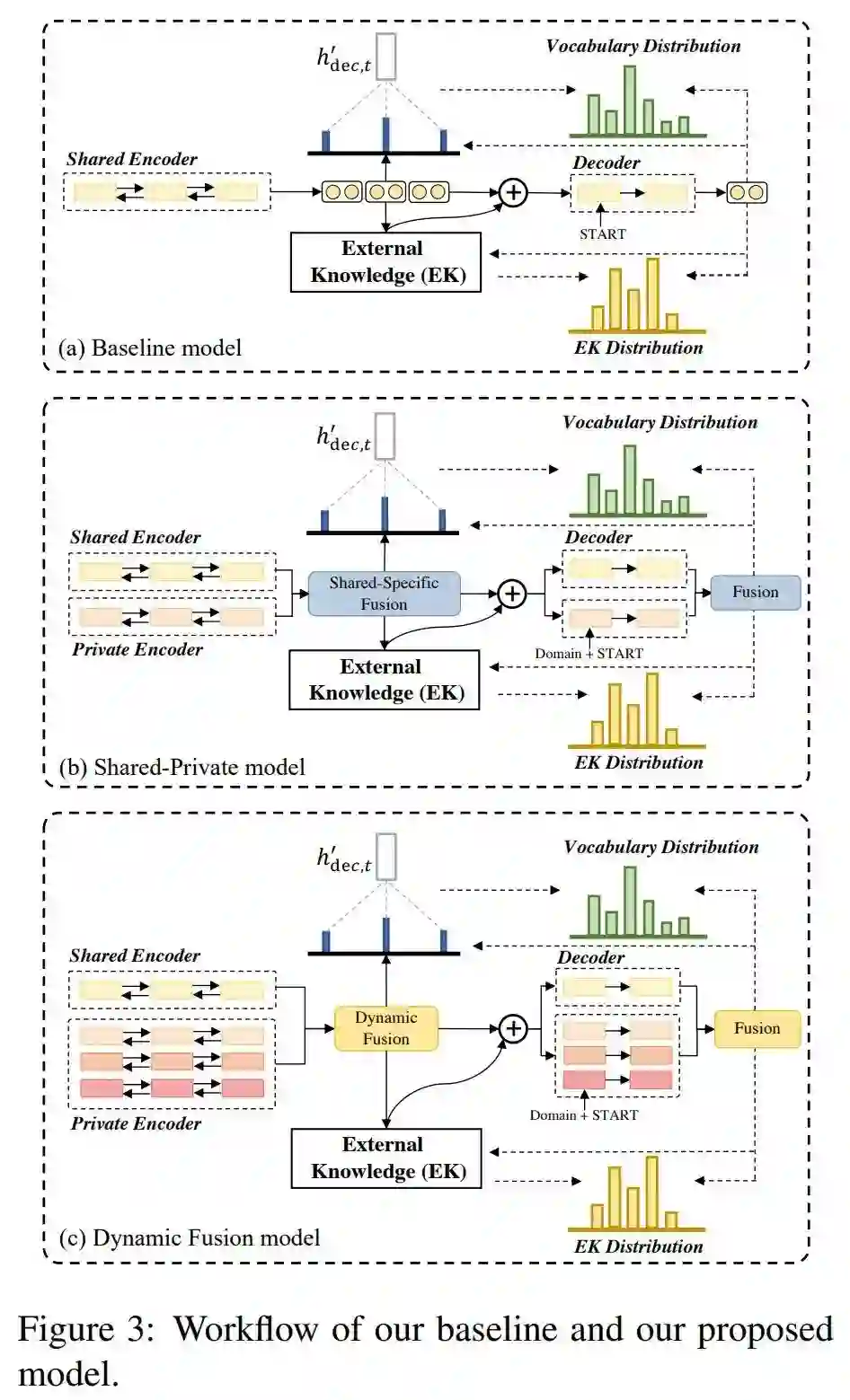

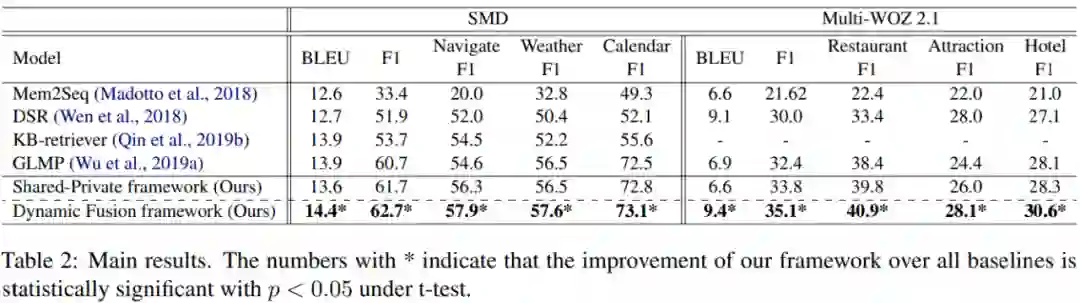

Dynamic Fusion Network for Multi-Domain End-to-end Task-Oriented Dialog

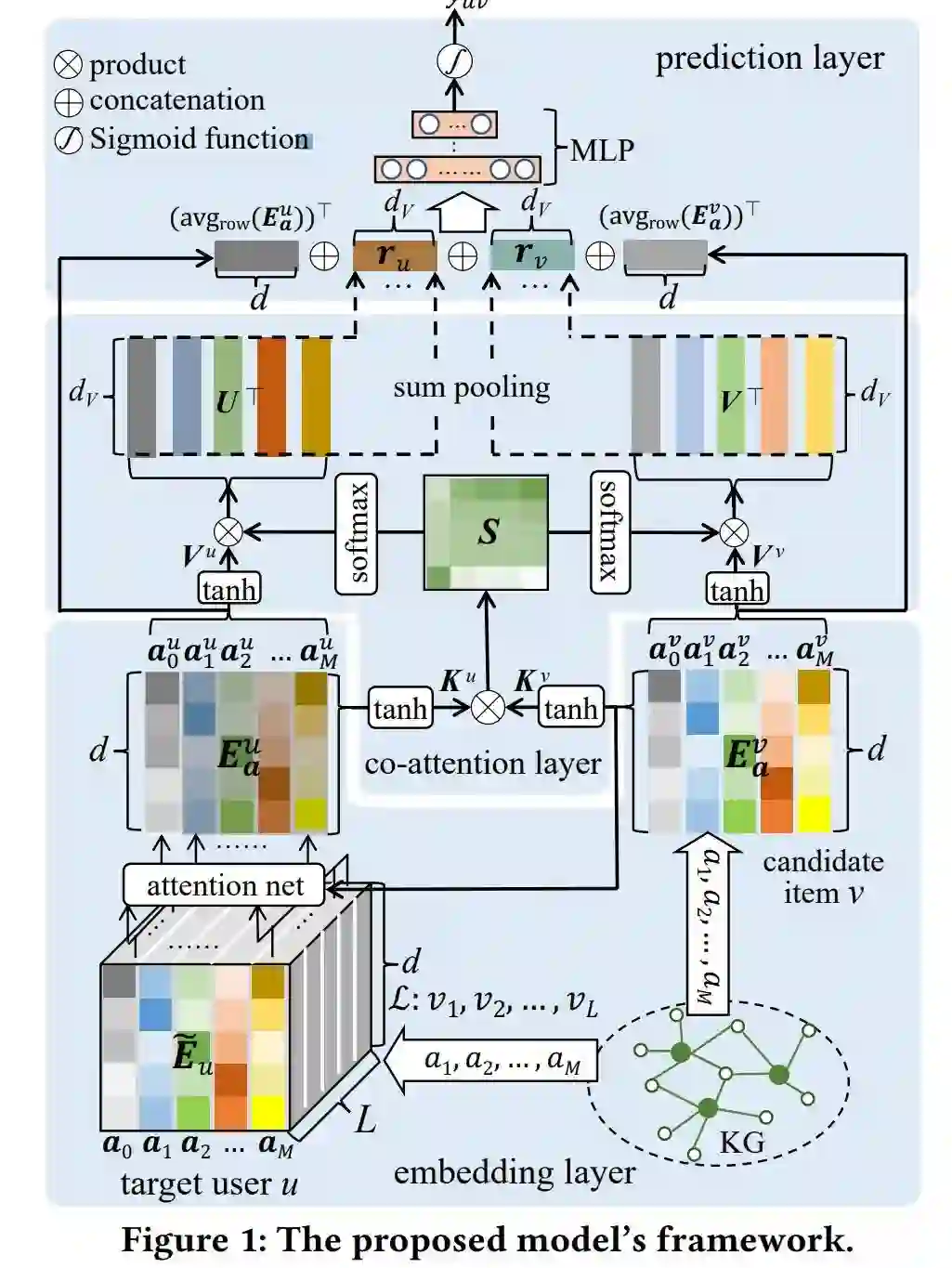

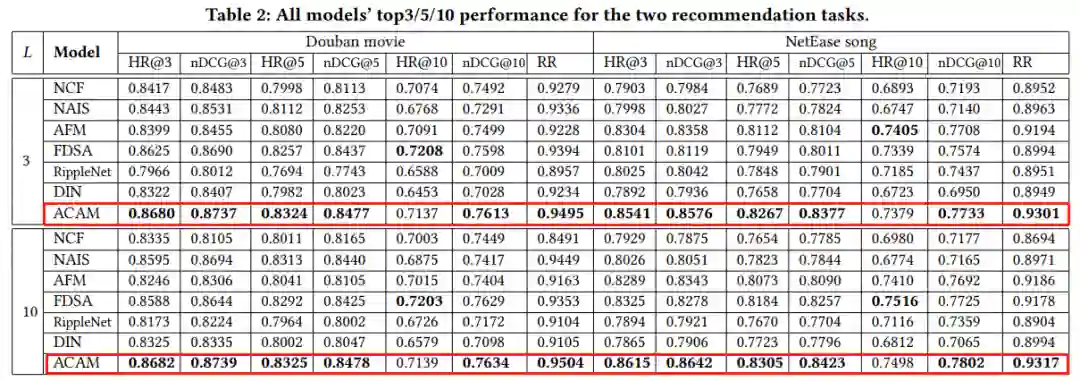

A Knowledge-Enhanced Recommendation Model with Attribute-Level Co-Attention

ArXiv Weekly Radiostation:NLP、CV、ML 更多精选论文(附音频)

作者:Xiangning Chen、Cho-Jui Hsieh

论文链接:https://arxiv.org/pdf/2002.05283.pdf

作者:Aleksei Petrenko、 Zhehui Huang、Tushar Kumar、Gaurav Sukhatme、Vladlen Koltun

论文链接:https://arxiv.org/pdf/2006.11751.pdf

作者:Quanming Yao、Hansi Yang、Bo Han、Gang Niu、James T. Kwok

论文链接:https://arxiv.org/abs/1911.02377

作者:Wenpeng Yin

论文链接:https://arxiv.org/abs/2007.09604

作者:Meng Liu、Hongyang Gao、Shuiwang Ji

论文链接:https://arxiv.org/abs/2007.09296

作者:Libo Qin、Xiao Xu、Wanxiang Che、Yue Zhang、Ting Liu

论文链接:https://www.aclweb.org/anthology/2020.acl-main.565.pdf

作者:Deqing Yang、Zengcun Song、Lvxin Xue、Yanghua Xiao

论文链接:https://arxiv.org/pdf/2006.10233.pdf