对抗人脸识别的一个新方法:隐藏身份、随机换脸

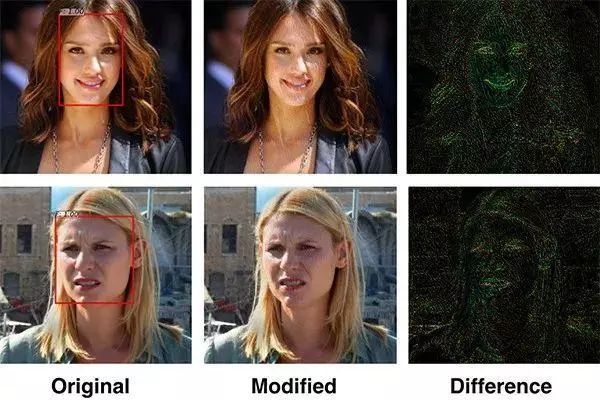

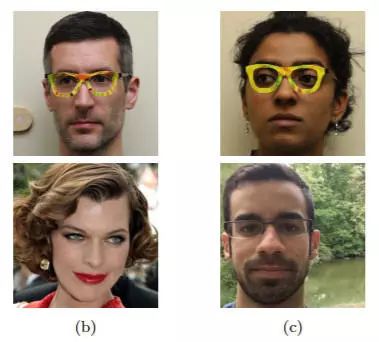

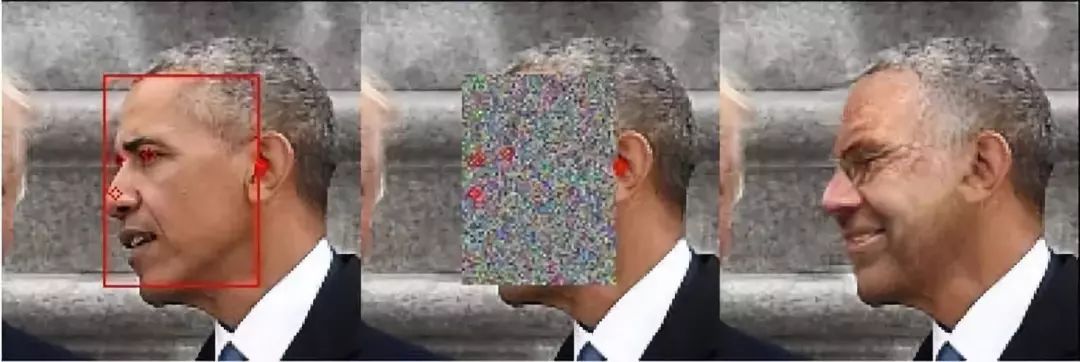

隐藏身份的「换脸」

不同人脸匿名方式的对比,从左到右依次为:原图,DeepPrivacy 模型的遮挡后的输入,马赛克,高斯模糊,DeepPrivacy 模型输出

相关研究比较

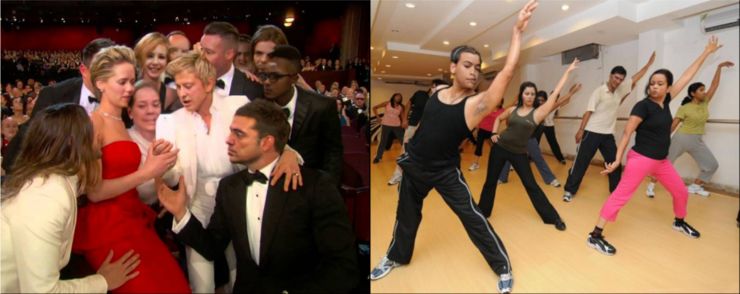

另一些人脸匿名化结果 —— 左图大家本来可能熟悉,现在就难认出来了

一些讨论

更多内容

专访俞栋:多模态是迈向通用人工智能的重要方向

「LSTM之父」 Jürgen Schmidhuber访谈:畅想人类和 AI 共处的世界 | WAIC 2019

历年 AAAI 最佳论文(since 1996)

一份完全解读:是什么使神经网络变成图神经网络?

点击 阅读原文 获得打包论文资源

登录查看更多

相关内容

专知会员服务

63+阅读 · 2020年4月19日