【邱锡鹏老师CIPSATT2020教程】自然语言处理中的预训练模型,149页ppt

邱锡鹏老师在CIPS ATT2020关于《自然语言处理预训练语言模型》的干货报告教程!

邱锡鹏教授

邱锡鹏,复旦大学计算机科学技术学院教授,博士生导师。于复旦大学获得理学学士和博士学位。主要从事自然语言处理、深度学习等方向的研究,在TACL、ACL、EMNLP、AAAI、IJCAI等国际权威期刊、会议上发表60余篇学术论文,并获ACL2017杰出论文奖,CCL 2019最佳论文奖。开源中文自然语言处理工具FudanNLP作者,FastNLP项目负责人。2015年入选首届中国科协人才托举工程,2018年获中国中文信息学会“钱伟长中文信息处理科学技术奖青年创新一等奖”,2020年入选由清华—中国工程院知识智能联合研究中心和清华大学人工智能研究院联合发布的“2020年度AI 2000人工智能全球最具影响力提名学者”。

https://xpqiu.github.io/

自然语言处理中的预训练模型

论文:【复旦大学】最新《预训练语言模型》2020综述论文大全,50+PTMs分类体系,25页pdf205篇参考文献

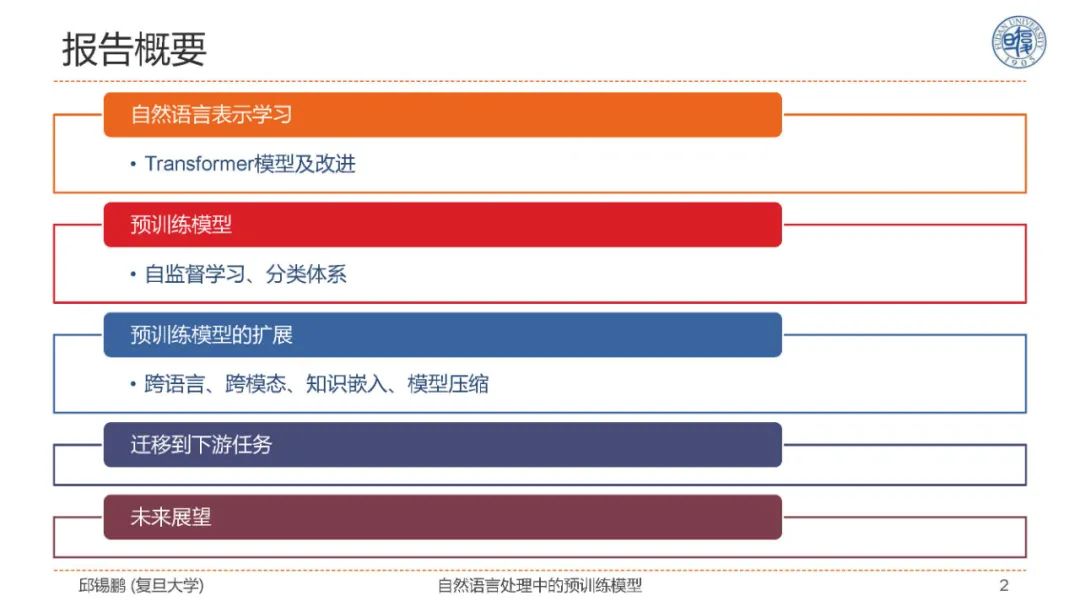

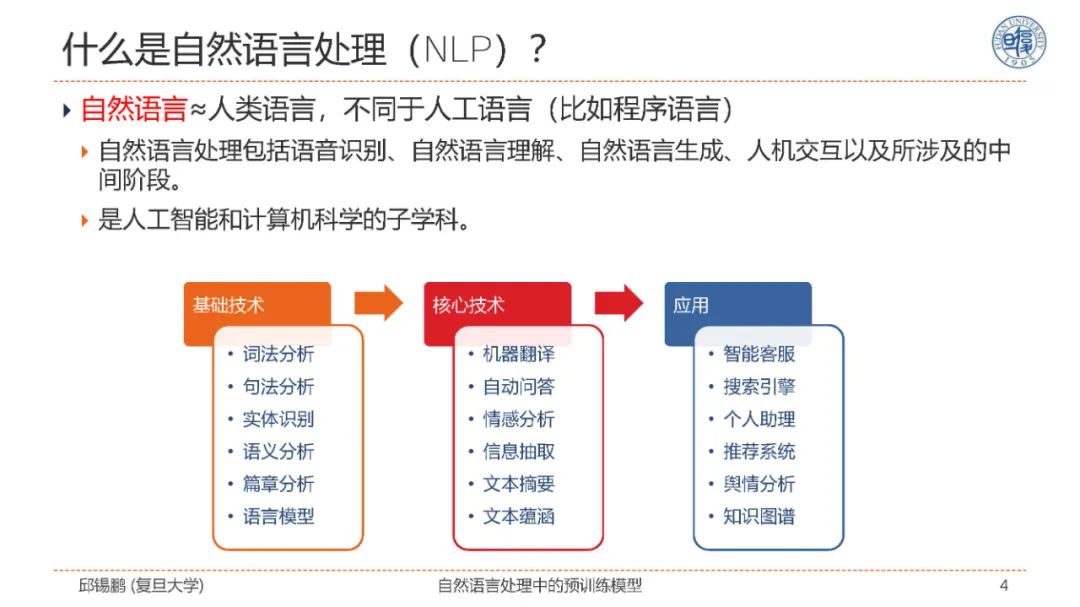

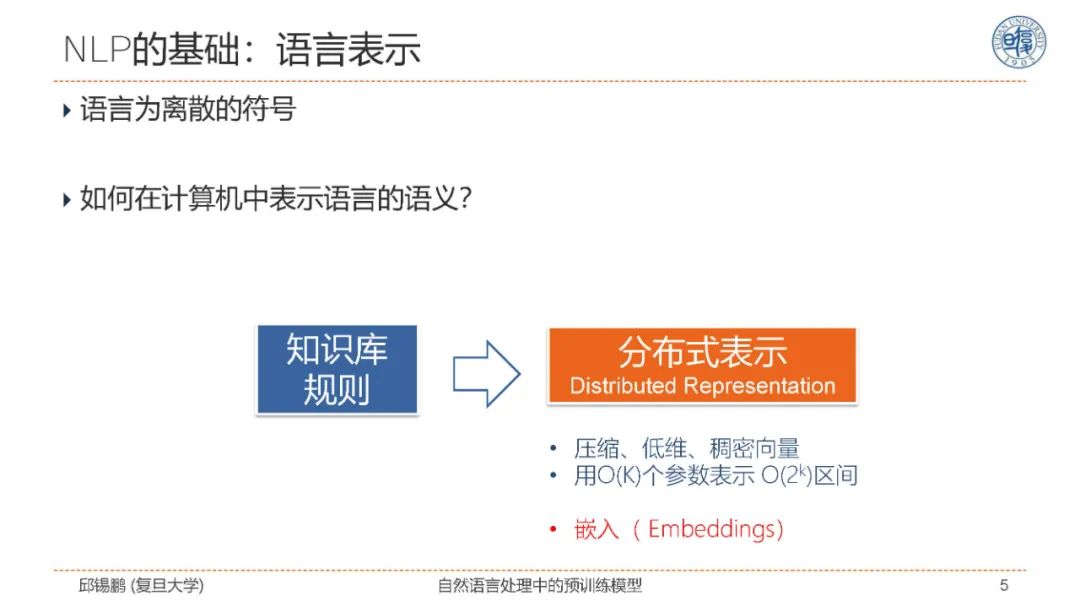

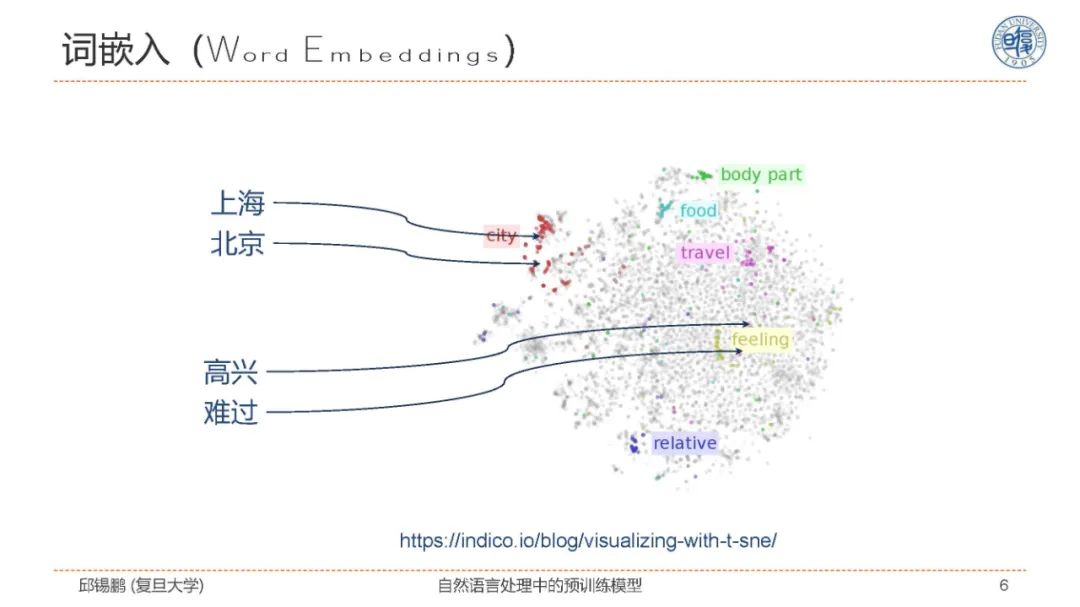

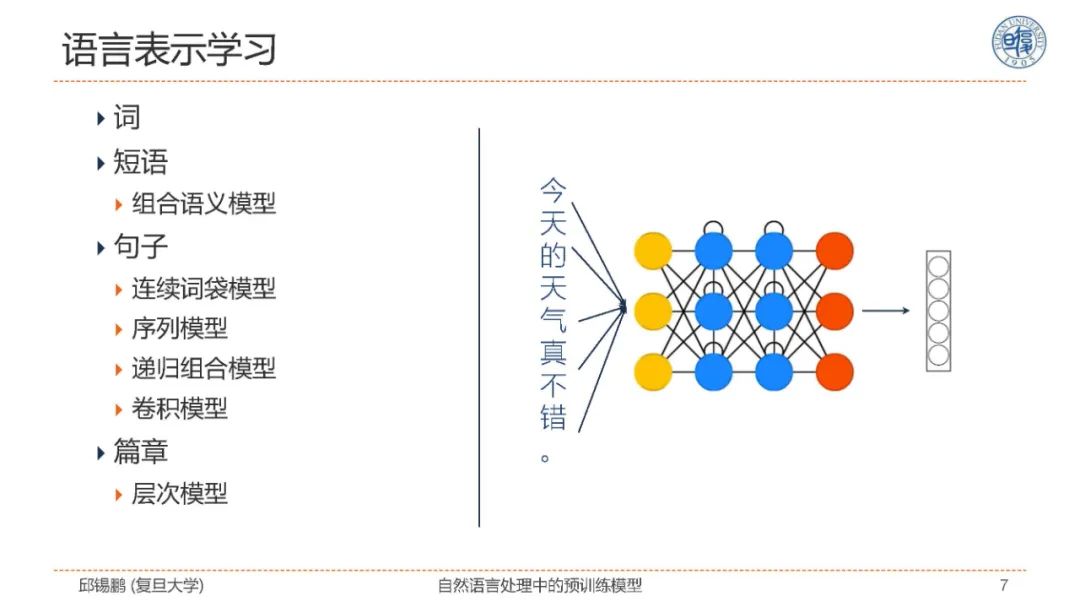

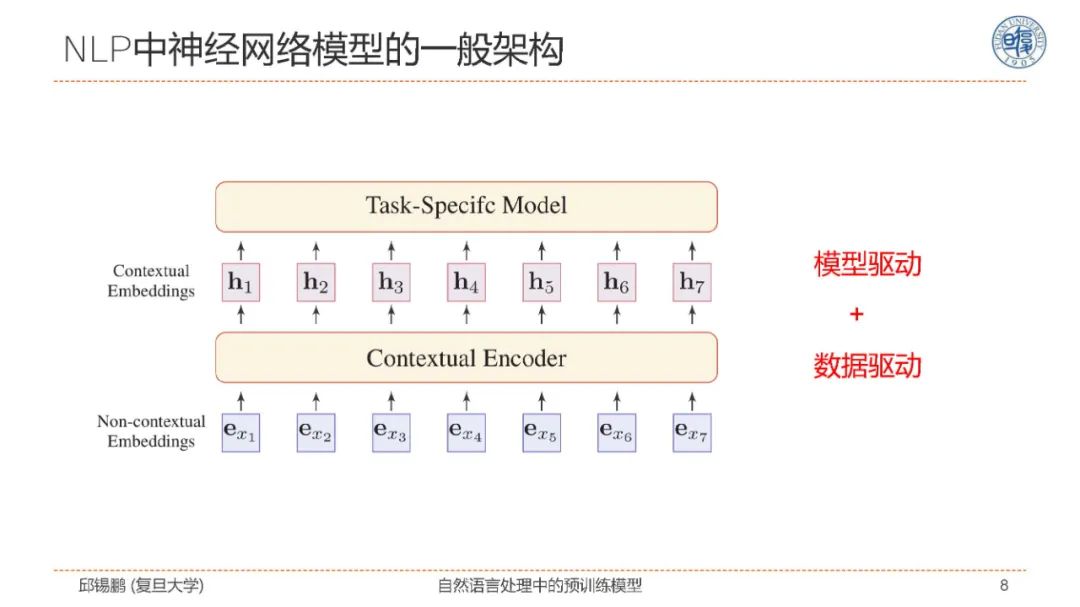

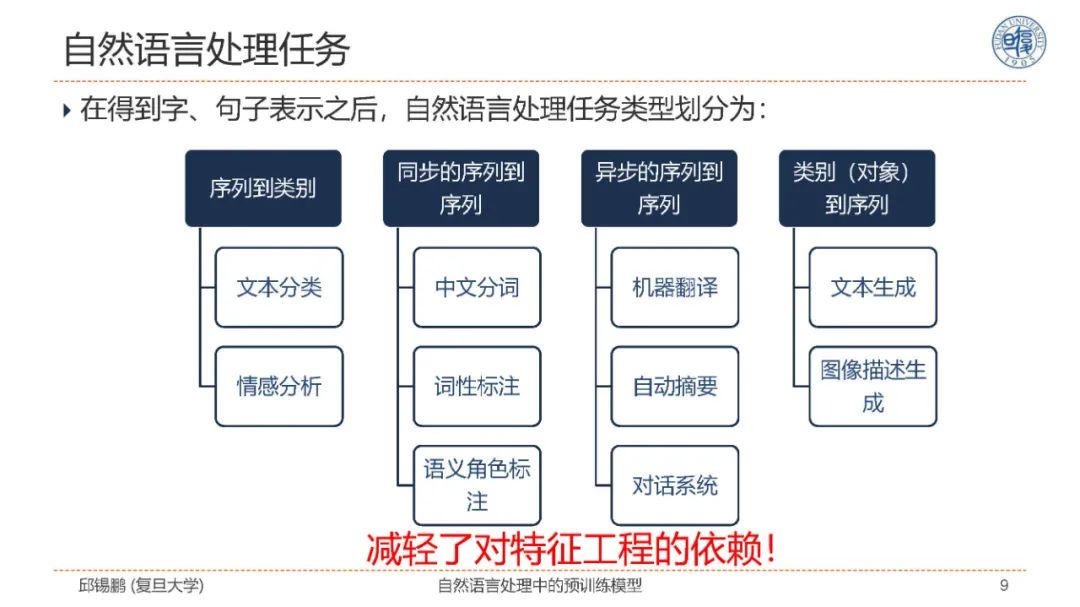

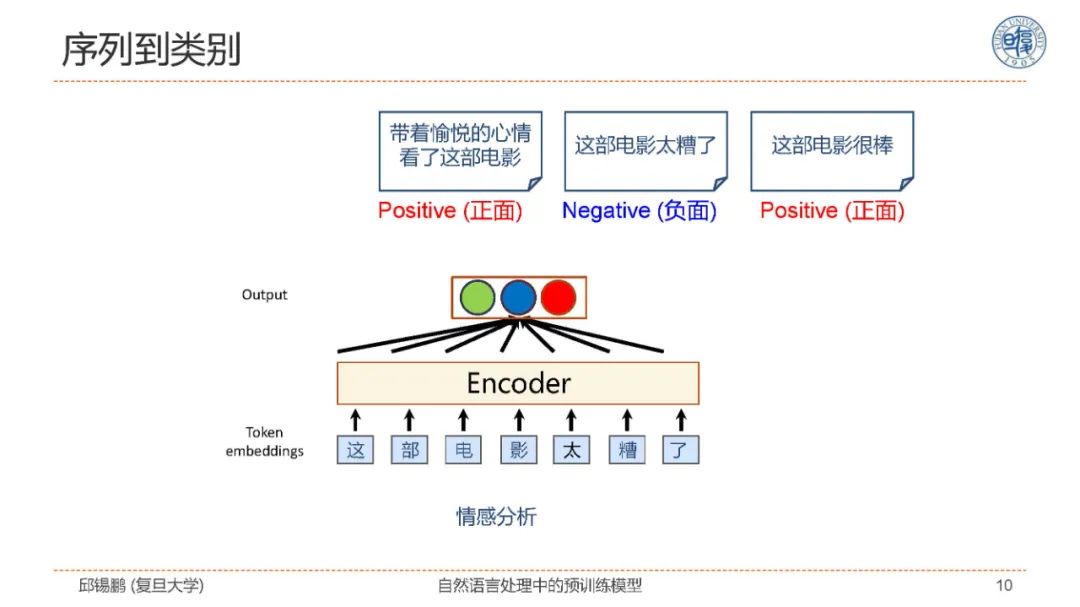

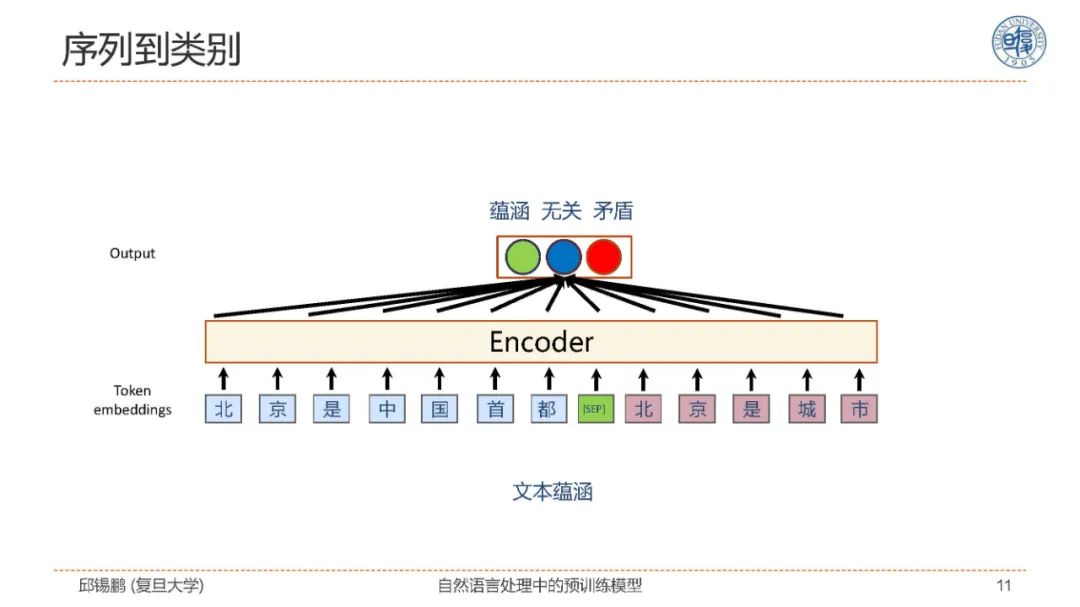

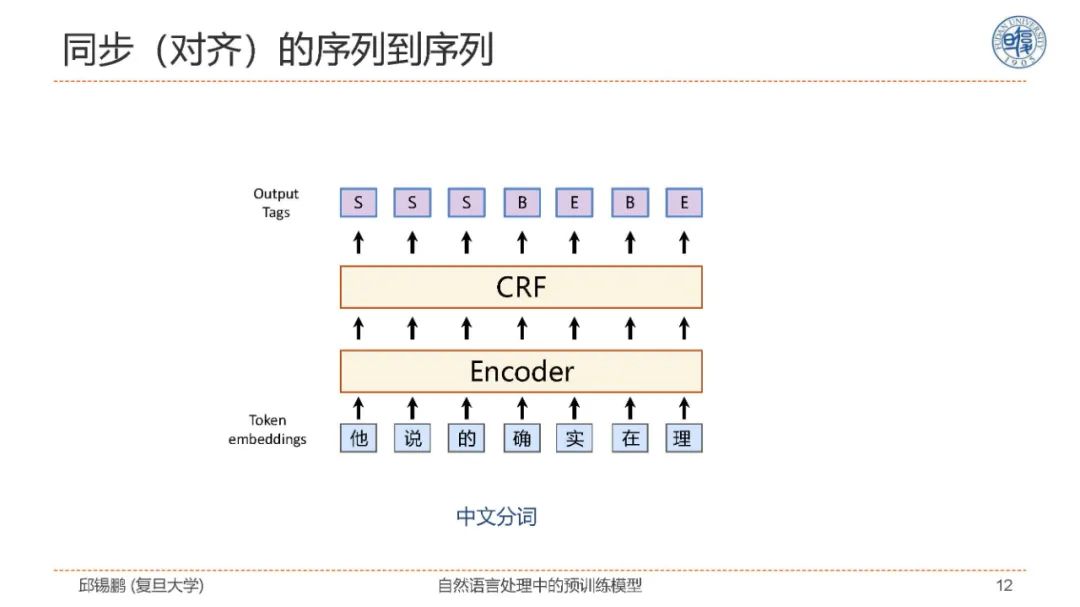

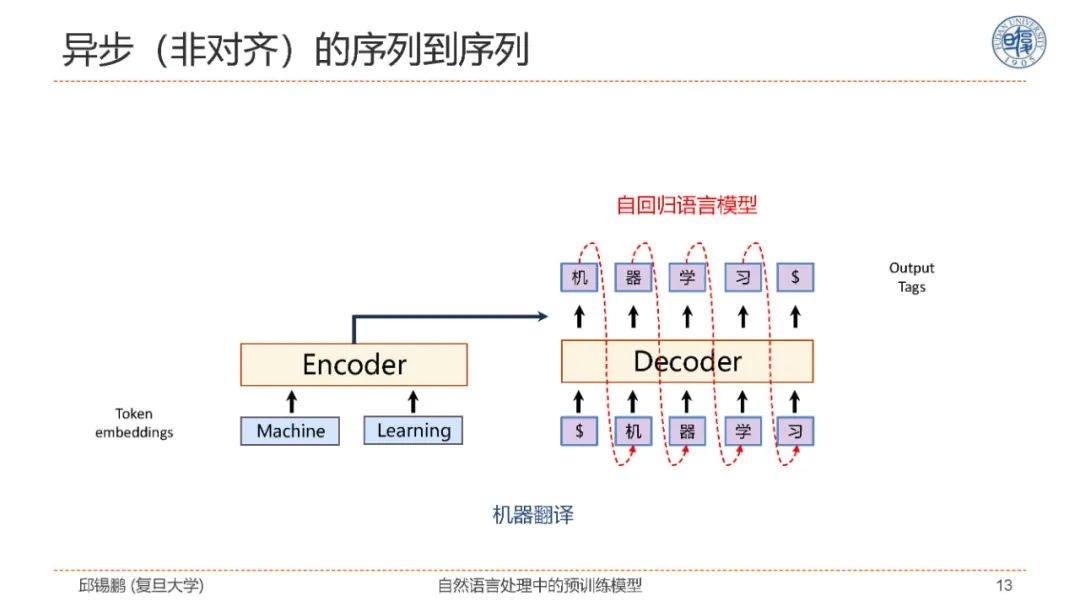

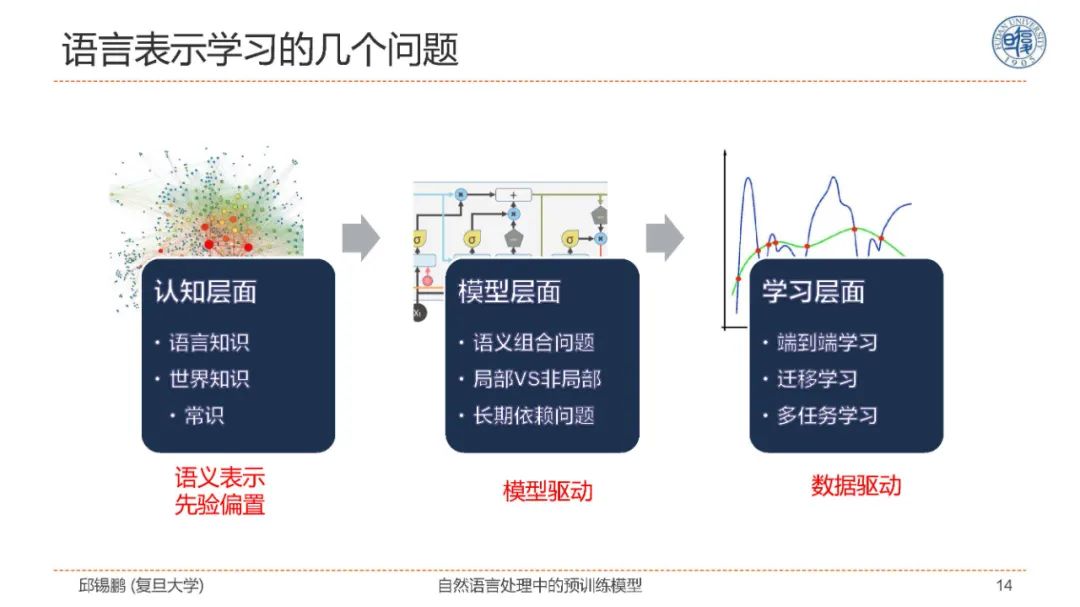

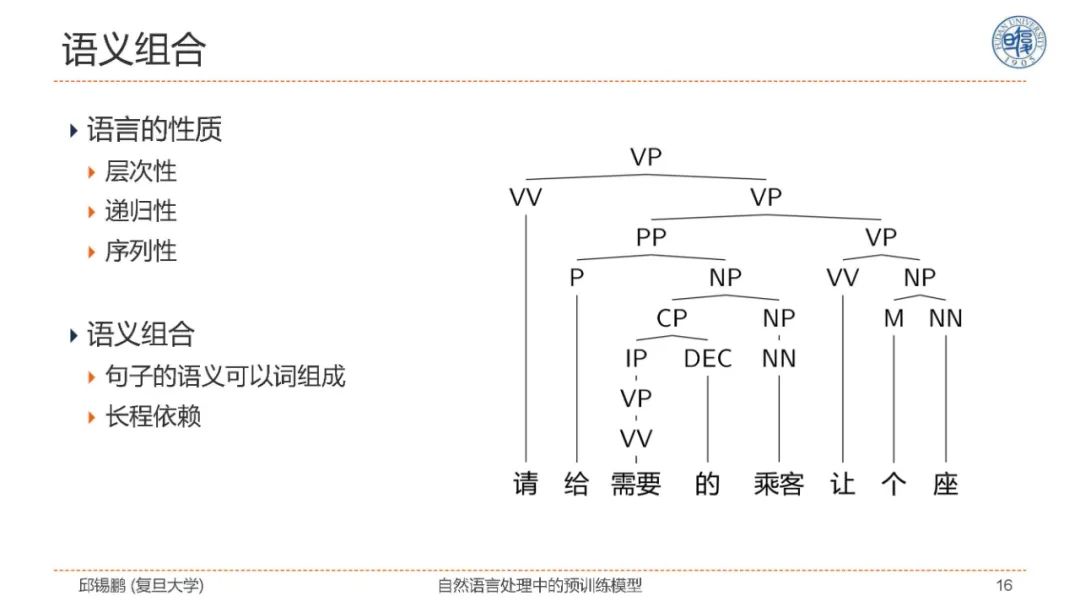

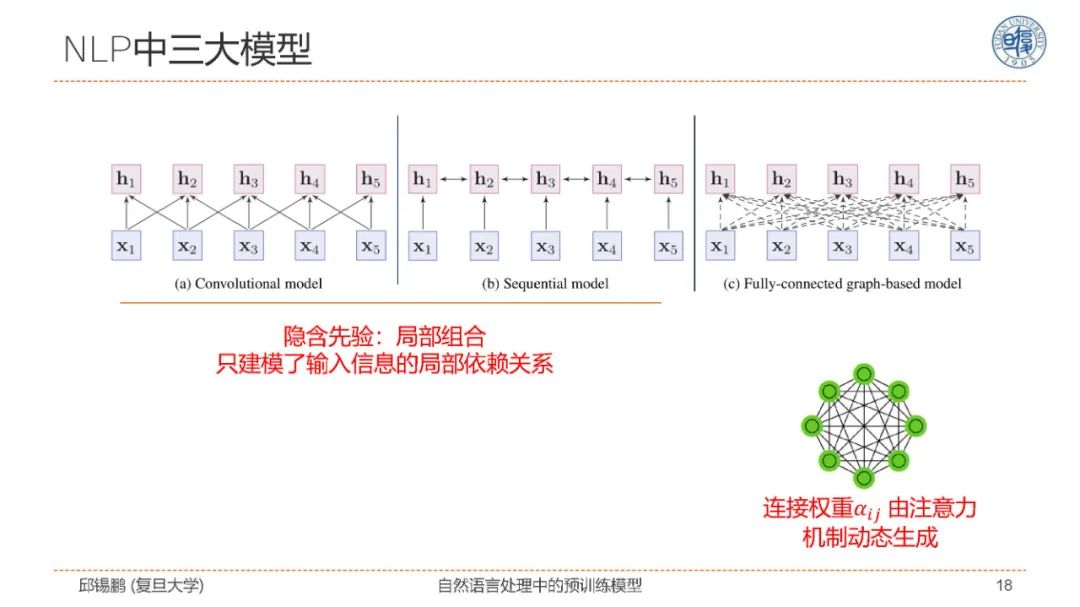

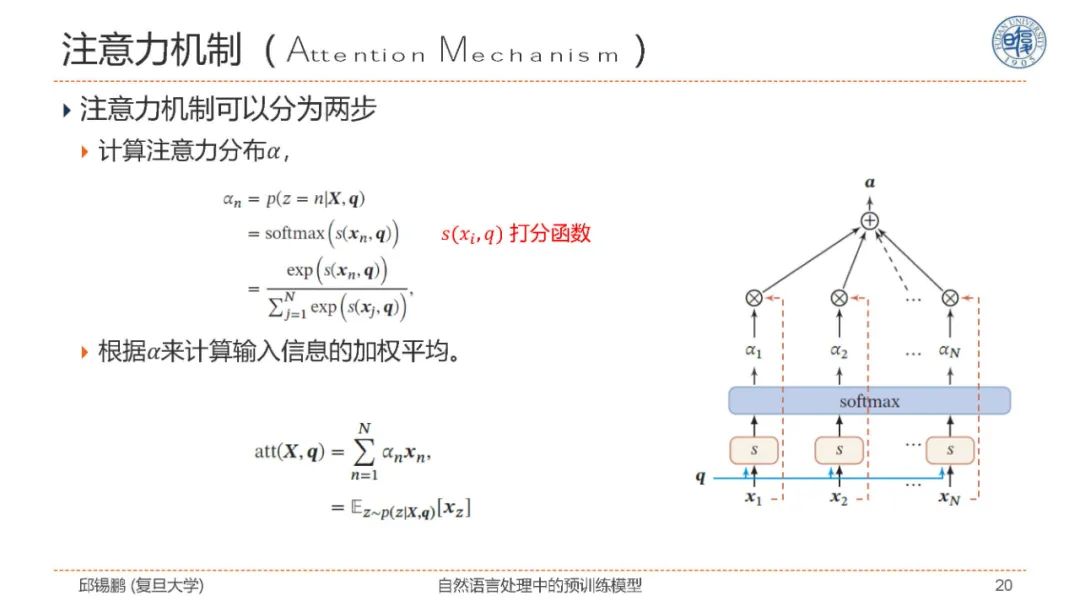

目前预训练模型在自然语言处理领域取得了广泛的成功。本报告的内容主要涵盖以下4部分内容:1)预训练模型的原理介绍,包括模型结构、学习准则、发展历程等;2)预训练模型的迁移方法:包括如何通过任务转换、多步迁移、改进精调等方法来进一步提高预训练模型在下游任务上的性能;3)预训练模型的改进模型:包括知识嵌入模型、多模态模型、多语言模型、语言特定模型、领域特定模型和模型压缩等;4)对预训练模型及其未来发展趋势进行展望。

视频:

https://hub.baai.ac.cn/view/3868

Slides:

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复“PTM149” 可以获取《【邱锡鹏老师CIPSATT2020教程】自然语言处理中的预训练模型,149页ppt》专知下载链接索引