AlphaGo “人肉臂”黄士杰首度公开演讲:Zero 版本并未到达极限,加入 DeepMind 这四件事对我影响最大

“我没有想过一个名词能获得所有人的认同,从政治人物、科学家、企业家、到学生甚至是小孩,都觉得这件事明天会发生,这场完美风暴的引爆点是 AlphaGo ,黄士杰可能自己都没想过,他那只帮机器下棋的手,改变了这个世界 —— 让大家相信或忧虑机器会超越人类”,Google 台湾董事总经理简立峰说。

人工智能,是简立峰口中的完美风暴、AlphaGo 则是这一波 AI 风潮的最佳代言人,那么黄士杰呢?他是 DeepMind 资深研究员,是与人类顶尖棋手对弈时代 AlphaGo 执棋的“人肉臂”,更重要的是,他还是开发这个神秘大脑的关键人物之一。

11 月 10 日,黄士杰应台湾人工智能年会之邀赴台演讲。演讲主题为《 AlphaGo—— 深度学习与强化学习的胜利》,这也是他首次公开演讲。

不久前,在 DeepMind 发表了《 Mastering the game of Go without human knowledge 》的最新论文后,黄士杰曾在 Facebook 写下: AlphaGo Zero 是完全脱离人类知识的 AlphaGo 版本。这也就是取名为 AlphaGo Zero 的原因 —— AlphaGo 从零开始。

黄士杰在演讲上强调,DeepMind 的目标是要做通用人工智能,也就是强人工智能。但他同时认为,对 DeepMind 来说,强人工智能还是很遥远的,现在最强的学习技能仍然在人类大脑中,有人说强人工智能要到 2045 年才会出现,有人说至少还要 100 年,黄世杰的回答是:“大家不要太担心,电影还是电影。”

从 DeepMind 为什么开始做围棋一直到最新的 AlphaGo Zero ,见证了这一切的他称:“这几年好像在做梦”。

以下为演讲内容整理(原文略有删改):

“人因梦想而伟大”,是我加入( DeepMind )五年后最大的体会,这段经历对我个人最大的影响就是对 AI 的认识不断加深。DeepMind 团队卧虎藏龙,精神非常强。

当 AlphaGo 结束时,我的老板过来跟我说:“ Aja(黄士杰英文名),AlphaGo 已经完成所有一切我们希望它该完成的任务,所以我们要再往前迈进”。这群高手都有一个清楚的远大目标,就是做出通用人工智能 —— 解决 AI ,把世界变得更好。

我从小就喜欢下棋,棋艺业余六段,再往上就是职业等级。回顾加入 DeepMind 这五年及 AlphaGo 的发展历史,有四件事对我意义非常大,第一件是在韩国赢了李世石,那天 Demis Hassabis( DeepMind 的 CEO )在推特上写着:“赢了,AlphaGo 登上月球”。

我们最初没想过会做出这么强的 AlphaGo ,当初是抱持着“探索”的心理开始的。开发过程很辛苦,连过圣诞节时,AlphaGo 都还在自我对弈,同事也都还在工作。

所以对我们来说,AlphaGo 赢了就像阿姆斯特朗登上月球一样:“这是我的一小步,却是人类的一大步。”

第二是操作 AlphaGo Master 在网络上取得 60 连胜,第三是在中国乌镇比赛打赢柯洁。我参加了两次人机大战,两次的气氛都非常不一样。

在韩国,我们都可以深深感受到李世石的巨大压力,感觉他是为人类而战,第二次在乌镇的气氛倒是满愉快,大家是一种建设性而不是对抗性的气氛。

第四是 AlphaGo Zero 的诞生,DeepMind 把所有人类围棋知识抛弃掉,只给规则让它从头开始学。我回想起我在师大念博士班时开发 Erica 围棋电脑程序,每天写程序、解 Bug 、做测试到半夜的日子,但 AlphaGo Zero 把我之前做的这些事全部取代,完全不需要我的协助。

于是有同事问我,AlphaGo Zero 把你过去十几年在计算机上做的研究一点一点的拿掉,还远远超越你,你有什么感觉?一开始我心情有点复杂,但后来想想这是“趋势”。

如果我让 AlphaGo 有所阻碍的话,那我确实应该被拿掉,AlphaGo 99% 的知识经我之手,它到达这一步其实是我从事计算机围棋研究非常好的收尾,我已经非常满足了。

AlphaGo 怎么开始的?其实是三组人马走在一起串起来的结晶,第一条线是 Demis Hassabis 和 DeepMind AlphaGo 项目负责人 David Silver,第二条线是我,第三条线是 Google Brain 的两位人员 Chris Maddison 和 Ilya Sutskever。

Demis Hassabis 和 David Silver 是在剑桥大学时的同学并一起创业。他们为什么想做围棋呢?当年 IBM 深蓝赢了西洋棋世界冠军卡斯巴罗夫,就只剩下围棋是人工智能最大的挑战。

因此他们一直就希望做出很强的围棋程序,这是他们的梦想。一开始,研究人员是将西洋棋的技术放进围棋,但这失败了,2006 年蒙特卡洛树出来之后,围棋程序提升到业余三段,但离职业水平还是有极大的差距。

当我开发出的 Erica 在 2010 年的「计算机奥林匹亚」获得 19 路围棋的冠军时,我使用的硬件是 8 cores 、Zen 用了 6 台 PC 、美国的 Many Faces of GO 是用 12 cores ,其他对手都是用大机器,但小虾米却赢了大鲸鱼。

不久,Demis Hassabis 就写了一封信问我要不要加入,面试时他们告诉我,他们的梦想就是强人工智慧。隔年,我就加入了 DeepMind。当我们开始做 GO Project 时,大家都有一个共识 —— 不复制 Erica ,因为没有意义,我们决定要把深度学习应用进来。

我们怎么判断深度学习可以用在围棋上呢?如果说人看一个棋盘,几秒内大概可以知道下哪里会是好棋,这种任务神经网络就办得到,但如果要想好几分钟后怎么走,那神经网络就可能办不到。当初我们就有这么一个直觉:要以深度学习建构策略网络。

AlphaGo 的主要突破是价值网络。有一天 David Silver 跟我说他有这样一个想法,当时我还有点质疑。我们把策略网络做出来后,胜率就提高到 70 - 80%,后来加入了 David Silver 提出的价值网络,要让机器进行不断左右互搏的自我学习。一开始不太成功,但当过了一个月后,我们克服了 over fitting 的问题,AlphaGo 的胜率大大提升到 95% ,而这也是后面 AlphaGo Zero 的主要核心。

后来老板说:“要跟人类面对面下棋,就得跟樊麾老师比赛。”,我记得,当樊麾第二盘棋输了之后,他说:“我要出去走走”,因为现场只有我和他说中文,我就说:“我陪你”,他回答:“不用,我自己透透气“。

樊麾回来后,他不再觉得这东西很可怕,而是很正面也很期待,因此他后来也变成了 DeepMind 团队的一员。

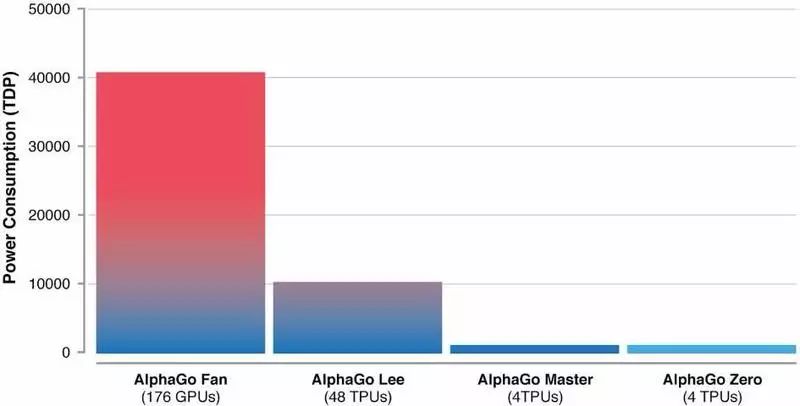

我们选择公开发表了这个研究的论文,因为科学的精神就是互相分享,希望推动整个研究领域进步。之后,加入 Google 也为我们带来了很大帮助,特别是硬件方面,从 GPU 到 TPU 都没有后顾之忧。但 TPU 对我们有极大帮助,把胜率提高了很多。

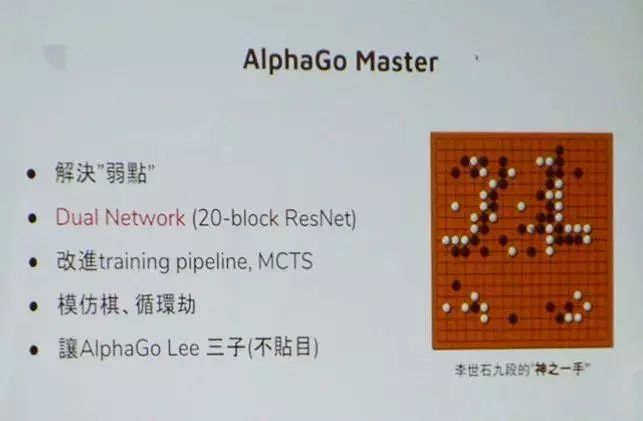

另外,大家不要忘记 AlphaGo 在跟李世石比赛时,第四盘棋输的很惨,我当时想说,我自己来下都比较好。尽管最后我们赢了,但回去后就一定要解决这个弱点,不是只解决当初第四盘的弱点,必须全面性地解决,否则以后还是没有人敢用 AI 系统。进化后的版本就是 AlphaGo Master 。

我们是怎么解决的呢?还是用深度学习跟强化学习的方法,而不是用人类知识方法。

我们把 AlphaGo 的学习能力变强,从神经网络加深。从 13 层变成了 40 层,并改成 ResNet 。

把 2 个网络(决策网络、价值网络)结合成 1 个网络,让 AlphaGo 的直觉和判断同时得到训练,更有一致性。

改进训练的 pipeline 。

解决了模仿期、循环期等特别情况。

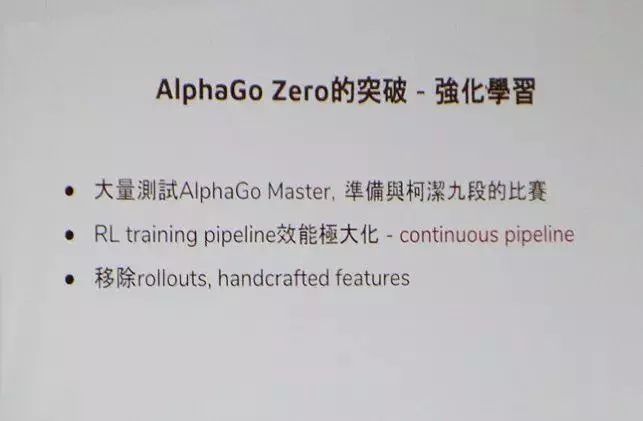

AlphaGo Zero 是连我们自己都很惊讶的版本,因为它第一步就是把所有人类知识的部分都抛掉,它是脱离“人类知识”,不是脱离“规则知识,我们一样是给要它 19 X 19 的盘面训练。

从零开始的 AlphaGo 还真的是全部乱下、彻底乱下,所以最初我们预期 AlphaGo Zero 应该是赢不了 AlphaGo Master ,后来我们用了一些方法把卡住的地方解决了,没想到 AlphaGo Master 进一步超越原先的版本,3 天就走完人类几千年围棋研究的历程。深度学习跟强化学习的威力真是太大。

AlphaGo Zero 用了 2000 个 TPU 、训练了 40 天。第 40 天还没有到达其极限,但因为我们机器要做其他事情就停下了,所以它还有很大的潜力。

AlphaGo Zero 论文的目的不是要做出很强的程序,也没有想要跟人类知识比较、或是讨论人类知识有没有用这些问题,而是想证明程序不需要人类知识也可以拥有很强的能力。

我观察到,计算机围棋 AI 的价值在于帮助人类或棋手扩展围棋的理论和思路,未来 AI 是人类的工具,跟人类合作,而非跟人类对抗。强人工智能还是 Far Away ,现在最强的学习技能仍在人类的脑袋里。

(以上为演讲全文)

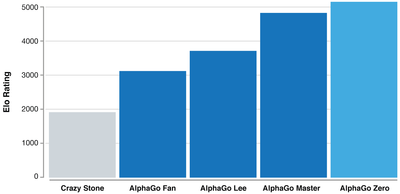

和此前的 AlphaGo 版本相比,AlphaGo Zero 的主要成果如下:

AlphaGo Zero 从零开始自我学习下围棋。

仅仅 36 小时后,AlphaGo Zero 靠着自我学习,就摸索出所有基本且重要的围棋知识,达到了与李世石九段对战的 AlphaGo v18(也就是 AlphaGo Lee )的相同水平。

3 天后,AlphaGo Zero 对战 AlphaGo v18 达到 100% 的勝率。

不断进步的 AlphaGo Zero 达到了 Master 的水平。Master 即年初在网络上达成 60 连胜的 AlphaGo 版本。

40 天後,AlphaGo Zero 对战 Master 达到近 90% 胜率,成为有史以来 AlphaGo 棋力最强的版本。

过去,DeepMind 在训练 AlphaGo 时,先让机器看 20 - 30 万个棋谱,累积一定的人类知识后开始进行自我对弈,自我对弈到达一定程度后机器就有机会赢过人类,因为机器可以在数个礼拜内就下几百万盘,它的经验比人多得多。

黄士杰指出:“ AlphaGo 成功的背后是结合了深度学习( Deep Learning )、強化学习( Reinforcement learning )与搜索树算法( Tree Search )三大技术。”

简单来说,当时的 AlphaGo 有两个核心:策略网络( Policy Network )、评价网络( Value Network ),这两个核心都是由卷积神经网络所构成。

具体而言,首先是大量的棋谱被输入到“策略网络”中,机器会进行监督式学习,然后使用部分样本训练出一个基础版的策略网络,以及使用完整样本训练出进阶版的策略网络,让这两个网络对弈,机器通过不断新增的环境数据调整策略,也就是所谓的强化学习。

而“策略网络”的作用是选择落子的位置,再由“评价网络”来判断盘面,分析每个步数的权重,预测游戏的输赢结果。当这两个网络把落子的可能性缩小到一个范围内时,机器计算需要庞大运算资源的负担减少了,再利用蒙特卡洛搜索树于有限的组合中算出最佳解。

不过,到了 AlphaGo Zero ,DeepMind 则是让它“脑袋空空” —— 没有输入任何棋谱,让机器自己乱玩。

也就是说,从一个不知道围棋游戏规则的神经网络开始,没有任何人类指导或人类智能的参与,仅仅通过全新的强化学习算法,让程序自我对弈,自己成为自己的老师,在这过程中神经网络不断被更新和调整。

没想到的是,机器训练的时间更短,但却更聪明。例如,AlphaGo Zero 在 3 天内进行过 490 万次自我对弈,就达到了先前击败李世石的程度,但之前他们训练与李世石对战的 AlphaGo 却花费了长达数个月的时间。

另外,AlphaGo Zero 21 天就达到了在乌镇围棋峰会打败柯洁的 AlphaGo Master 的水平。

责任编辑:刘海星