![]()

来源:phys

编辑:雅新

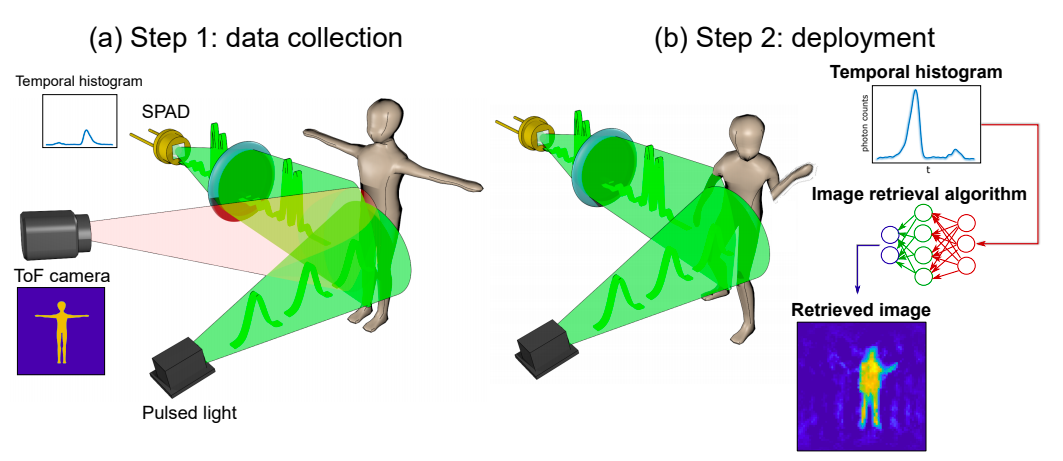

【新智元导读】近日,由格拉斯哥大学研究员Alex Turpin带领的研究团队开发了一种全新的3D成像方法:通过捕获有关光子的时间信息而不是空间坐标来成像。

近日,由格拉斯哥大学计算科学学院数据科学研究员Alex Turpin博士带领的研究团队研究团队开发了一种崭新的3D成像方法:

通过捕获有关光子的时间信息而不是其空间坐标来成像。

这种方法通过利用AI将时间转换成三维空间的视觉,可以帮助汽车、移动设备和健康监护仪器等提高360度的认知能力。

此项研究「Spatial images from temporal data」目前已在Optica杂志上发表。

![]() 论文链接:

https://arxiv.org/pdf/1912.01413.pdf

论文链接:

https://arxiv.org/pdf/1912.01413.pdf

在我们生活中,照片和视频通常是通过使用数字传感器捕获光子(光的构建基块)来制作的。比如,数码相机由数百万个像素组成,这些像素通过检测空间每个点的光的强度和颜色来形成图像。

然后,通过在拍摄对象周围放置两个或更多摄像机可以从多个角度对其进行拍摄,或者通过使用光流扫描场景并将其重构三维来生成3D图像。

无论哪种方式,我们拍摄的照片和视频仅通过收集场景的空间信息来构建图像。

而研究人员此次是通过有关光子的时间信息来生成3D图像,他们是如何做到的呢?

他们的实验过程是使用了一个简单且廉价的单像素检测器,该检测器经过调整可充当光子的秒表。

这个检测器仅记录由瞬间激光脉冲产生的光子从任意给定场景中的每个物体反弹并到达传感器所需的时间。物体距离越远,每个反射光子到达传感器所花费的时间就越长。

有关场景中反射的每个光子的时间信息,研究人员称为时间数据,收集在一个非常简单的图形中。

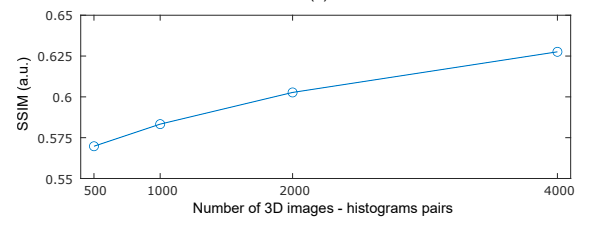

然后,借助复杂的神经网络算法将这些图转换为3D图像。研究人员通过向团队展示数千张团队人员在实验室中移动和携带物体的常规照片,以及同时由单像素检测器捕获的时间数据来训练算法。

最终,网络已经足够了解时间数据与照片的对应关系,从而仅凭时间数据就可以创建高度准确的图像。

在验证原理的实验中,尽管使用的硬件和算法有可能每秒产生数千张图像,但研究人员设法从时间数据中以约10帧/秒的速度构造了运动图像。

Turpin 博士表示,我们手机中的相机通过使用数百万个像素来形成图像。如果仅考虑空间信息,则仅凭单个像素创建图像是不可能的,因为单像素检测器没有任何信息。但是,这样的检测器仍然可以提供有关时间的有价值的信息。我们设法做的是找到一种新方法,可以将一维数据,即简单的时间测量,转换成运动图像,该图像代表任何给定场景中空间的三个维度。

与传统图像制作不同的最重要方式是,该团队的研究方法能够将光线与整个过程完全解耦。

Turpin 说道,「我们有信心该方法可以适用于能够用短脉冲探测场景并精确测量回波的任何系统,以全新的方式使用时间而非光来可视化世界」。

当前,神经网络创建图像的能力仅限于经过训练以从研究人员创建的场景的时态数据中挑选出来的能力。

但是,通过进一步培训甚至使用更高级的算法,可以学习可视化各种场景,从而扩大其在现实世界中的潜在应用。

Turpin 补充说,「收集时间数据的单像素检测器体积小、重量轻、且价格便宜,这意味着它们可以轻松地添加到现有系统中,比如自动驾驶汽车的摄像头,以提高寻路的准确性和速度。它们可以增强移动设备中现有的传感器,比如 Google Pixel 4,这些传感器已经具有基于雷达技术的简单手势识别系统。」

参考链接:

https://www.gla.ac.uk/news/headline_733364_en.html

https://phys.org/news/2020-07-imaging-pictures.html

![]()

论文链接:

https://arxiv.org/pdf/1912.01413.pdf

论文链接:

https://arxiv.org/pdf/1912.01413.pdf