AI先驱Sejnowski称:梯度是深度学习的“秘诀”!

作者:Tiernan Ray是IT外媒ZDNet的撰稿人。

对于机器学习先驱Terry Sejnowski来说,随机梯度下降(SGD)这种数学技术是深度学习的“秘诀”,而大多数人没有真正明白它的真正意义。

在加利福尼亚州拉霍亚建成索尔克研究所(Salk Institute)庭院的混凝土广场的尽头,有一个离太平洋仅数百英尺的陡坡。

有时人们会驾乘滑翔伞从高处观赏这个陡坡。如果不那么冒险,他们可以沿着一条蜿蜒的小道走下去,一直通到底部。

在这里很适合思考“随机梯度下降”这个数学工具,这种技术可谓是当今AI界机器学习这一分支的核心。

几十年来,Terry Sejnowski一直在探索梯度下降。Sejnowski领导索尔克研究所的一个团队研究所谓的计算神经科学,他曾是效力谷歌的Geoffrey Hinton的导师,Hinton是今年因在机器学习计算领域的杰出贡献而获得ACM图灵奖的三位获奖者之一。他常与Facebook的Yann LeCun和蒙特利尔大学机器学习研究所(MILA)的Yoshua Bengio交流想法,他俩与Hinton一同获得了图灵奖。

Terry Sejnowski在位于加利福尼亚州拉霍亚的索尔克研究所的办公室。“数学家们发现,人们在随机梯度下降方面的所有想法都是错误的。”

本周,我与Sejnowski在他那间书快堆到天花板的办公室围绕AI作了一次深入广泛的探讨。一个有趣的主题脱颖而出,那就是整个AI界刚刚开始了解梯度下降这个影响深远的现象。

Sejnowski说:“数学家们发现,人们在随机梯度下降方面的所有直觉认识都是错误的。”

想明白个中原委,有必要Sejnowski给我们上一堂简史课。他非常适合这项任务,撰写了一本关于这个主题的著作:《深度学习革命》,这本书一半是回忆录,一半是科学课程。

Sejnowski回忆起AI从20世纪50年代诞生后至今取得了多大的进展。AI界“基于规则”的研究人员(这些人采用基于逻辑和符号处理的方法)几十年来一直努力使他们的方法奏效,但以失败告终。他们的失败却为八九十年代另一种学派:联结学派(connectionists)悄然取得进展提供了机会,这个学派的领军人物包括Sejnowski、Hinton、LeCun和Bengio。联结主义在Naughts取得了惊人的成功,后被重新命名为深度学习。

加利福尼亚州拉霍亚索尔克研究所的Louis Kahn’s广场俯瞰数百英尺的陡坡

失败的逻辑系统与深度学习之间的区别在于规模。不像基于规则、基于逻辑的方法,随着计算机的功能越来越强大、数据越来越丰富,联结学派的神经网络能够扩展,以处理越来越庞大的问题。规则无法扩展,而从数据中学习可以扩展。余下的就是历史,至少对Sejnowski而言是这样。

“瞧,那些追求逻辑的人有50年的时间来证明这种方法无法扩展。而现在,我们有30年(从80年代到今天)来证明它[联结主义]确实可以扩展。”

“在这里,至少对于一些模式、对于模式识别、对于强化学习等而言,我们拥有可扩展的东西。”

虽然大数据和不断增加的计算资源使这一切成为可能,但要不是渐变那神秘的底层原理,一切都无法扩展。

他说:“事实证明,随机梯度下降就似乎如同秘诀。”

“它有一些特别的地方。”

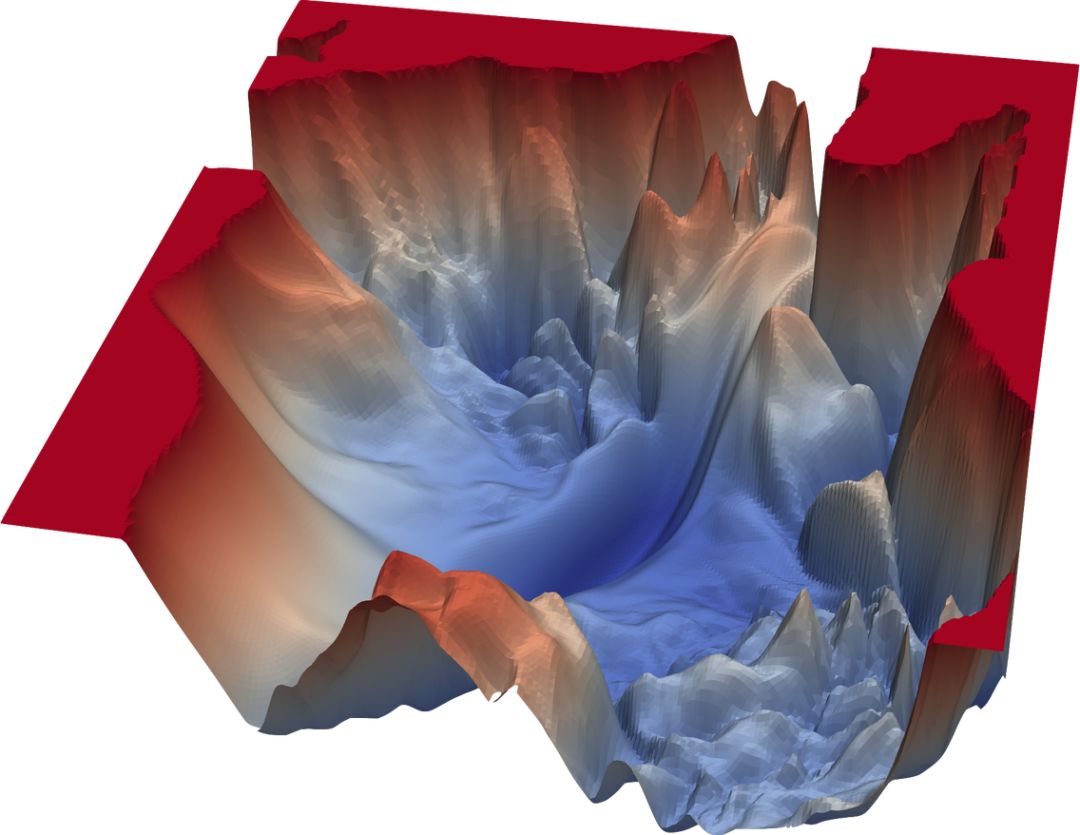

神经网络的误差可以视作人们试图找到最低点的山谷,如该图中所示。沿着这条山谷寻找那个最低点在机器学习中名为随机梯度下降。在下降中发现趋于较小误差的几个点后,人们可能困在虚假的成功点、局部最小值或所谓的鞍点(saddle point)。(图片来源:https://arxiv.org/pdf/1712.09913.pdf)

梯度下降是神经网络的一种优化方法。神经网络有所谓的权重,权重决定了神经网络的任何一个部分对网络生成的最终答案有多大的贡献。

为了找到合适的权重组合,神经网络通过搜索类似于山谷的几何坐标构成的曲面(landscape)来调整那些权重。神经网络响应数据、重复调整权重,以便找到一条从山谷顶部(表示最大误差)到山谷最低点(表示神经网络所能实现的最小误差量)的路径。

如果像从拉霍亚的悬崖跳下一样容易,这个过程对于计算机来说很简单。相反,随机梯度下降就像穿行于一片未经探索的山坡,试图找到最快捷的下山路径。

Sejnowski认为,由于梯度下降只是一个数学构件,表明搜索解决方案时所发生情况的几何模型,整个AI界刚开始了解这种搜索的神秘机理。

上世纪80年代,麻省理工学院(MIT)的科学家Marvin Minsky嘲笑穿行于这个梯度只不过是“爬坡”。(梯度下降倒过来就像是爬升到准确度最高的顶峰。)在Minsky看来,这是一种不起眼的搜索,根本不像真正的学习,根本代表不了真正的智能。时至今日,深度学习遭到类似的抨击。

Sejnowski认为,不过,随着越来越强大的计算能力揭示梯度的方方面面,这种抨击并没有未明白什么在慢慢地受到关注。

他说:“这是我们发现的,Minksy可能永远也想不到,因为他沉浸于小问题组成的低维度世界;如果有一个庞大的空间里面有数十亿个参数,你就无法真正探索发生了什么。”

已经发现的是,人们对于梯度下降的认识通常是错误的。

在简单的神经网络搜索中,在只有两三个维度的几何图形中,寻找山谷底部的那个最低点一路上到处是错误的转弯,名为虚假局部最小值(spurious local minima),就像是实际上是谷底的山脊。

深度学习能够通过结合更大的数据集、更多的网络层和“drop out”等技术来克服那些局部最小值,drop out是指从网络中修剪权重。

然而Sejnowski的观点是,局部最小值这个陷阱内部是可能非常强大的东西。随着数学因更强大的计算机模型而变得更复杂,所有那些错误的转弯开始形成更有意义的东西。

Sejnowski解释道:“如果你有100万个维度,你在下降,来到一个山脊或之类的地方,即使一半维度在上升,另一半维度却在下降!所以你总能找到离开的路子。你永远不会困于山脊”,至少不会永久困于山脊。

按这个观点,经典的统计陷阱“过拟合”数据(导致局部最小值)实际上看似坏事实为好事。

Sejnowski说:“事实证明,过参数化并不是高维空间的错误。实际上,它为你提供了可用于学习的自由度。”

Sejnowski说,就连像线性回归这么简单的东西也呈现一种奇怪的新形式,可能是无限规模的梯度。线性回归本身并不是机器学习,而只是一种基本的统计法。

梯度正引领那些研究深度学习的数学家发掘宝贵知识,这些宝贵知识有一天会组成机器学习理论,Sejnowski对此充满信心。

“梯度是这些高维度空间的几何形状,关键是它们是如何组织的以及你从空间中的一个地方到达另一个地方的方式。”

对于当前的机器学习研究,有一个直接的影响:更精确的东西不太可取,而不是更可取。

他说:“如果你使用一种处理起来更精确的更高级的优化技术,效果反而不是一样好。”

“因此,一种干扰性的优化技术有其特殊之处,你拿来小批量任务,它并不沿着完美的梯度下降,而是沿着近似下坡的方向下降。”

Sejnowski说,AI界“刚开始探索”梯度下降的奥秘。“我们有管用的技术,但实际上不知道它为什么管用。”

“一旦我们知道它为什么管用,就能够制造出还要高效、功能强大得多的机器。”

深度学习社群欢迎加入,群主微信:guanhongyan1023(备注任职单位+职位,否则不予通过)

相关阅读:

深度学习框架格局剧震:Caffe2 代码全部并入 PyTorch

“洞见未来”的机器人:依赖于动态神经平流(DNA)这项新的深度学习技术(附视频、论文)

深度学习重大突破:具有学习能力的深度学习软件,不需要在云端运行的服务器

量子计算被泼了冷水:理论物理学界泰斗称其在可预见的未来搞不出来