中文任务全面超越!可持续学习的语义理解框架ERNIE真有那么好? | Q推荐

2019 年 3 月,百度正式发布 NLP 模型 ERNIE,其在中文任务中全面超越 BERT 一度引发业界广泛关注和探讨。

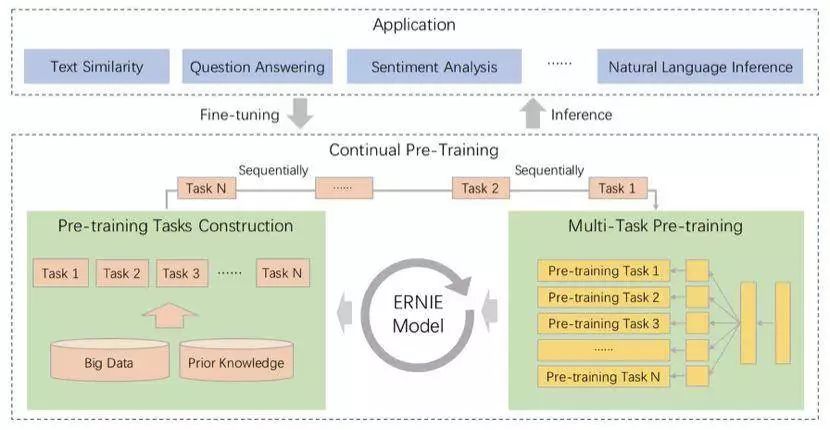

7 月,百度 ERNIE 再升级。发布持续学习的语义理解框架 ERNIE 2.0,及基于此框架的 ERNIE 2.0 预训练模型。

该框架支持增量引入词汇 (lexical)、语法 (syntactic) 、语义 (semantic) 等 3 个层次的自定义预训练任务,能够全面捕捉训练语料中的词法、语法、语义等潜在信息。这些任务通过多任务学习对模型进行训练更新,每当引入新任务时,该框架可在学习该任务的同时,不遗忘之前学到过的信息。这也意味着,该框架可以通过持续构建训练包含词法、句法、语义等预训练任务,持续提升模型效果。

9 月 21 日上海·百度上海研发中心,9 月 22 日深圳·百度国际大厦,百度 AI 快车道——百度艾尼(ERNIE)即将开课,课程将围绕持续学习语义理解框架 ERNIE 的详解和实战应用进行。来自百度的明星讲师,将给大家详细讲解 ERNIE 的实现原理、优势以及在真实场景中的应用案例,并通过现场实践和交流环节,让大家能在真实应用中快速用 ERNIE 取得更好效果!

业内领先的语义理解预训练模型,刷新多个中英文 NLP 基础任务、应用任务的效果

少量训练数据即可达到良好效果,训练便捷,效果提升迅速

支持多倍效果无损压缩,并有多种性能优化方案以满足应用需求

完善的中文应用场景技术服务支持,产业 NLP 应用实践持续锤炼

干货满满的现场,行业 A 级的导师,还有一群志同道合的小伙伴,还在等什么?两场活动分别限额免费 30 人!赶快扫描下方二维码或者点击阅读原文报名参加吧!

登录查看更多