【伯克利马毅老师】深度学习基本原理:从数学第一原则出发的深度网络,71页ppt与视频

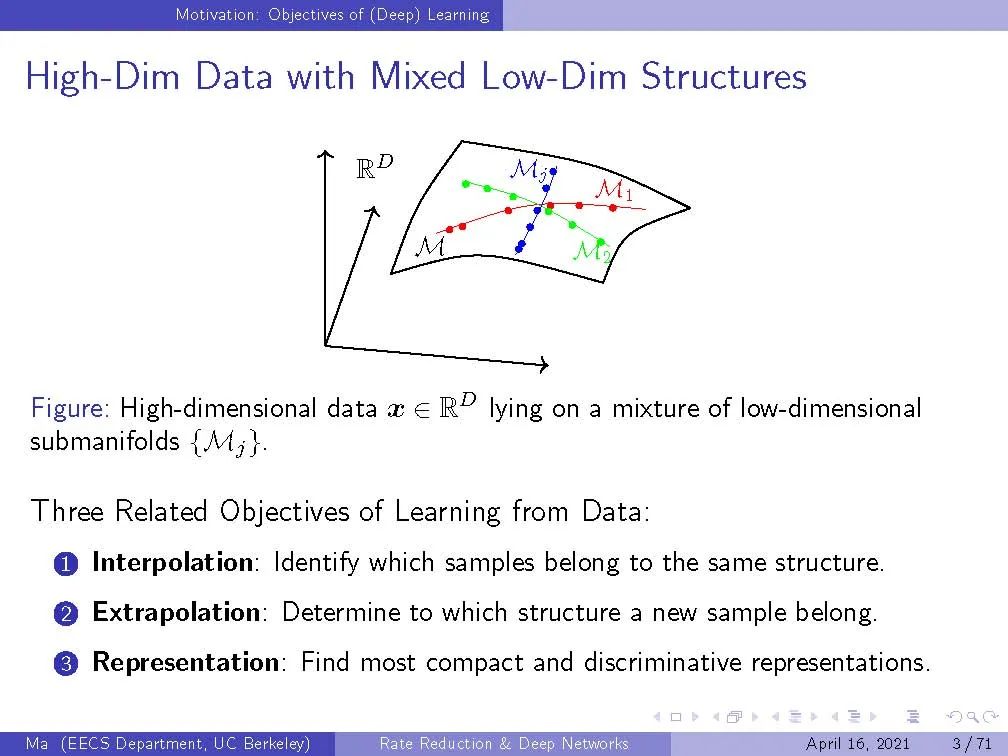

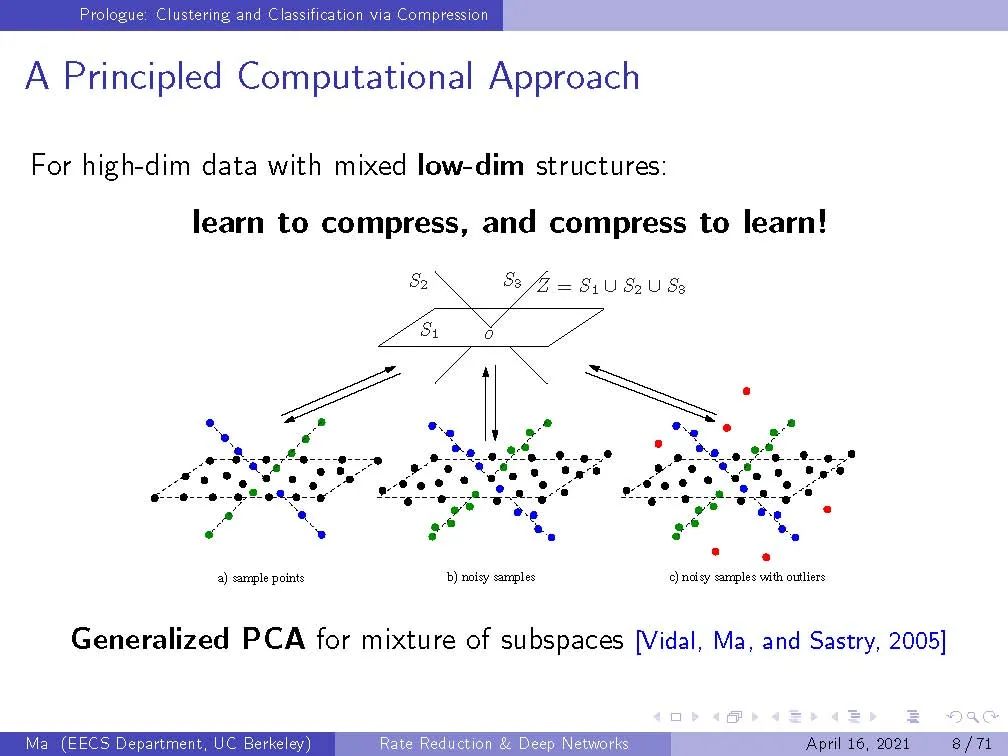

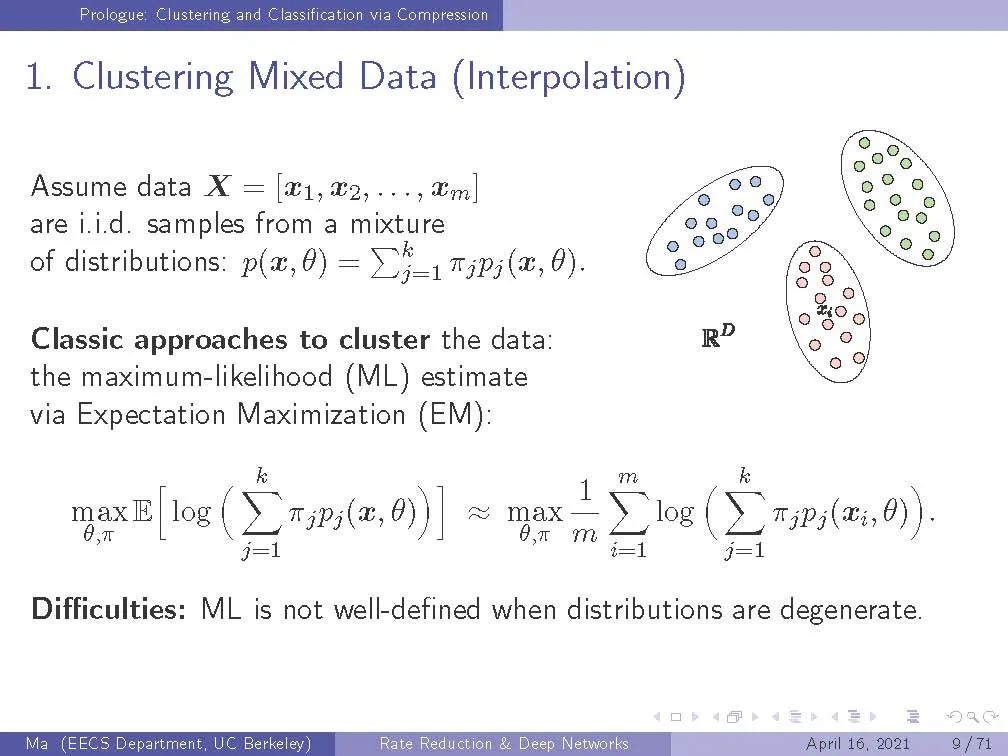

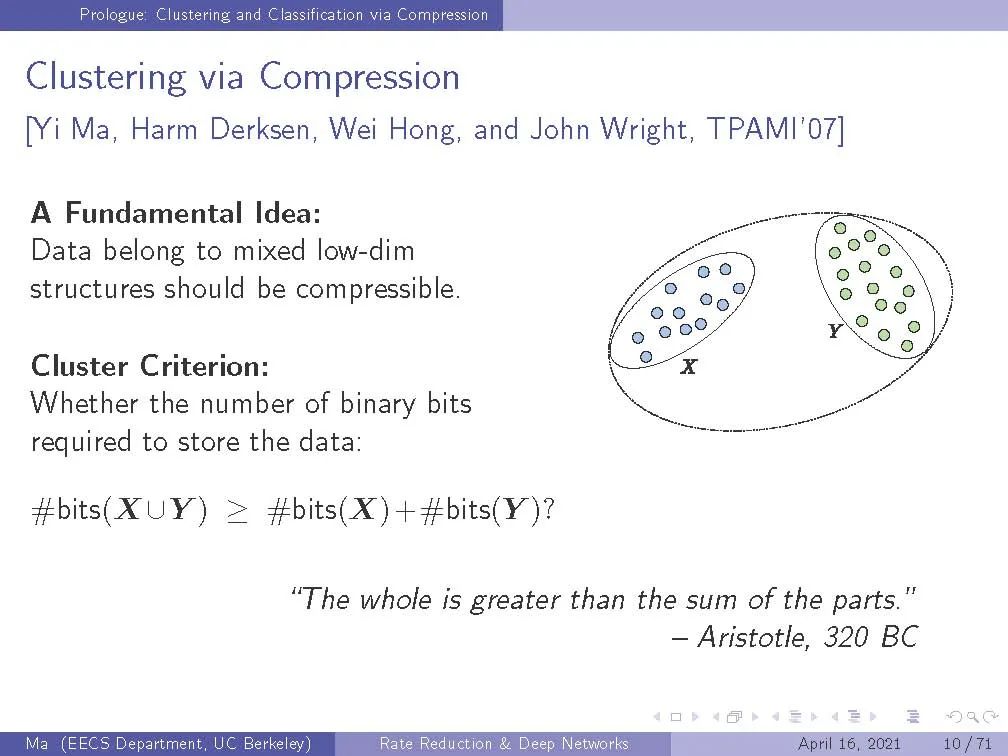

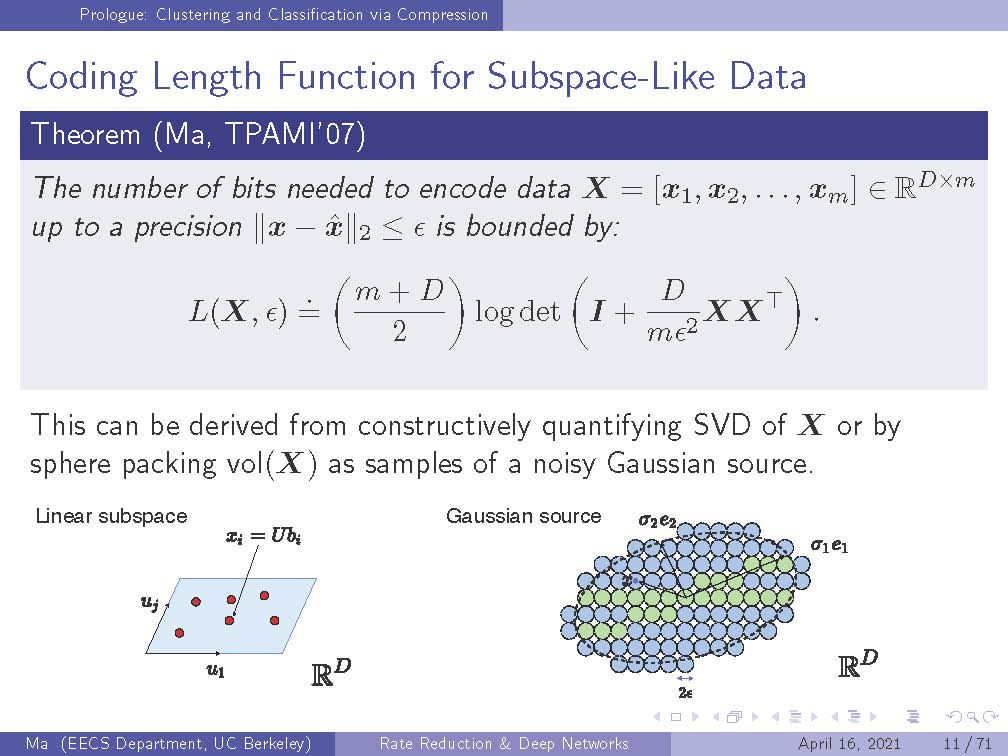

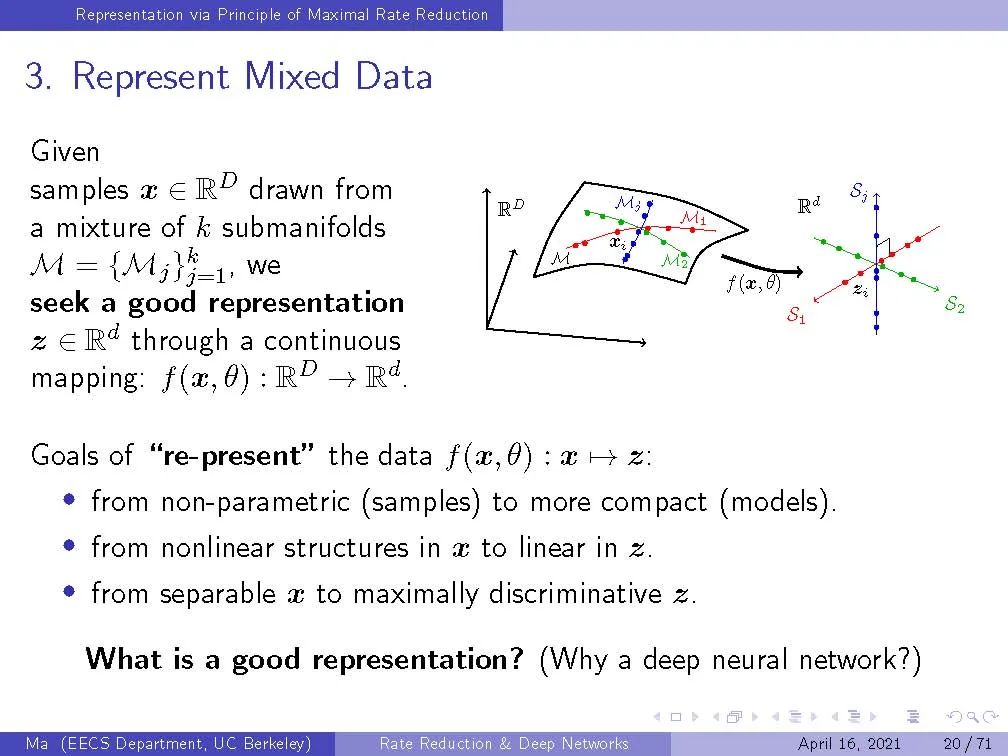

在这次演讲中,我们从数据压缩(和群不变性)的角度提供了对深度(卷积)网络的完全“白盒”解释。特别地,我们展示了现代的深层架构、线性(卷积)算子和非线性激活,甚至所有的参数都可以从最大化速率缩减(具有群不变性)的原则推导出来。网络的所有层、操作符和参数都是通过前向传播明确构建的,而不是通过后向传播学习。因此得到的网络的所有组件称为ReduNet,具有精确优化、几何和统计解释。这种原则性的方法也有一些令人惊讶的地方:它揭示了类可分离性的不变性和稀疏性之间的基本权衡;它揭示了深层网络和群体不变性的傅里叶变换之间的基本联系-频谱域的计算优势(为什么是尖突神经元?);这种方法还阐明了正向传播(优化)和反向传播(变异)的数学作用。特别地,这样获得的ReduNet 可以通过前向和后向(随机)传播进行微调,都是为了优化同一目标。这是与Berkeley的Yaodong Yu, Ryan Chan, Haozhi Qi ,现在谷歌研究中心的You Chong博士,以及哥伦比亚大学的John Wright教授共同完成的。

https://cmsa.fas.harvard.edu/wp-content/uploads/2021/04/Lecture_Ma-1.pdf

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复“DNFP” 就可以获取《【伯克利马毅老师】深度学习基本原理:从数学第一原则出发的深度网络,71页ppt与视频》专知下载链接

登录查看更多