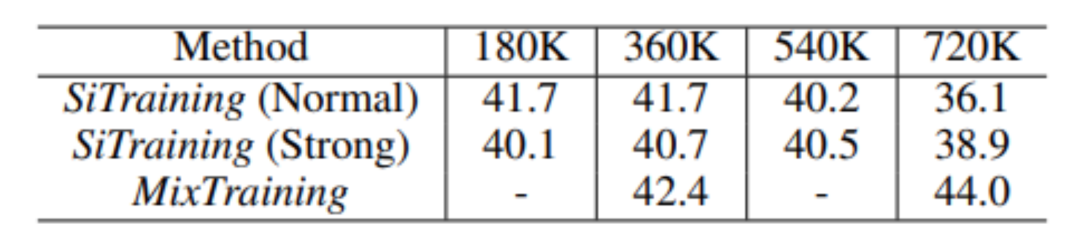

NeurIPS 2021 | 寻MixTraining: 一种全新的物体检测训练范式

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复“BOMT” 就可以获取《NeurIPS 2021 | 寻MixTraining: 一种全新的物体检测训练范式》专知下载链接

登录查看更多