【AAAI2020图灵奖得主YannLecun】自监督学习Self-Supervised Learning是未来 ,44页ppt

【导读】在最新AAAI2020的邀请嘉宾报告上,Facebook人工智能总监、图灵奖得主Yann Lecun给了自监督学习的报告《Self-Supervised Learning 》,44页ppt,介绍了深度学习面临的挑战,自监督学习的光明前景,基于能量学习的因变量模型,介绍最新自监督学习的进展与问题,是非常值得看的报告。

链接地址:

https://aaai.org/Conferences/AAAI-20/invited-speakers/

Yann LeCun

在人工智能研究领域,Yann LeCun、Geoffrey Hinton 和 Yoshua Bengio一直被公认为深度学习三巨头,一起获得2018年图灵奖。

Yann LeCun,自称中文名“杨立昆”,计算机科学家,被誉为“卷积网络之父”,为卷积神经网络(CNN,Convolutional Neural Networks)和图像识别领域做出了重要贡献,以手写字体识别、图像压缩和人工智能硬件等主题发表过 190 多份论文,研发了很多关于深度学习的项目,并且拥有14项相关的美国专利。他同Léon Bottou和Patrick Haffner等人一起创建了DjVu图像压缩技术,同Léon Bottou一起开发了一种开源的Lush语言,比Matlab功能还要强大,并且也是一位Lisp高手。(Backpropagation,简称BP)反向传播这种现阶段常用来训练人工神经网络的算法,就是 LeCun 和其老师“神经网络之父”Geoffrey Hinton 等科学家于 20 世纪 80 年代中期提出的,而后 LeCun 在贝尔实验室将 BP 应用于卷积神经网络中,并将其实用化,推广到各种图像相关任务中。

Yann LeCun 也是Facebook人工智能研究院院长,纽约大学的 Silver 教授,隶属于纽约大学数据科学中心、Courant 数学科学研究所、神经科学中心和电气与计算机工程系。加盟Facebook之前,Lecun已在贝尔实验室工作超过20年,期间他开发了一套能够识别手写数字的系统,叫作LeNet,用到了卷积神经网络,已开源。他在 1983 年在巴黎 ESIEE 获得电子工程学位,1987 年在 Université P&M Curie 获得计算机科学博士学位。在完成了多伦多大学的博士后研究之后,他在 1988 年加入了 AT&T 贝尔实验室(AT&T Bell Laboratories /Holmdel, NJ),在 1996 年成为 AT&T Labs-Research 的图像处理研究部门主管。2003 年,他加入纽约大学获得教授任职,并在 NEC 研究所(普林斯顿)呆过短暂一段时间。2012 年他成为纽约大学数据科学中心的创办主任。2013 年末,他成为 Facebook 的人工智能研究中心(FAIR)负责人,并仍保持在 NYU 中兼职教学。从 2015 到 2016 年,Yann LeCun 还是法兰西学院的访问学者。

自监督学习 Self-Supervised Learning

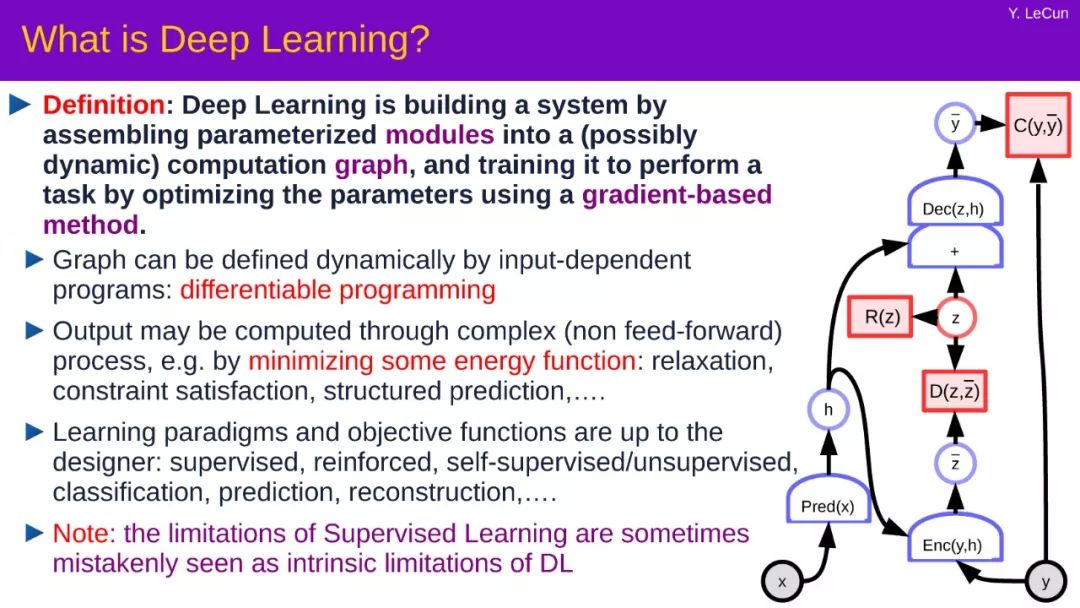

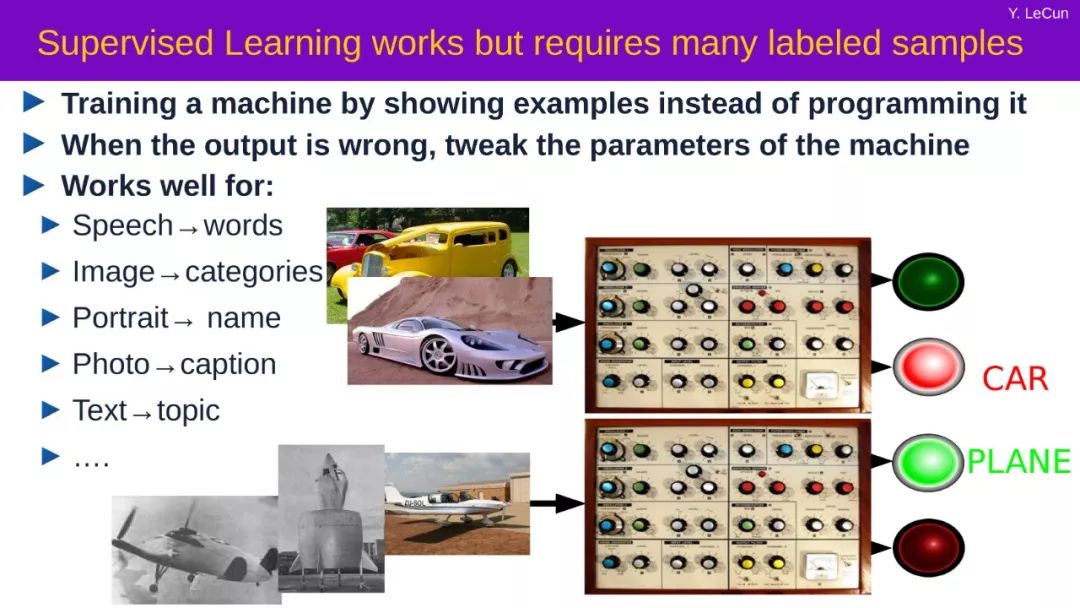

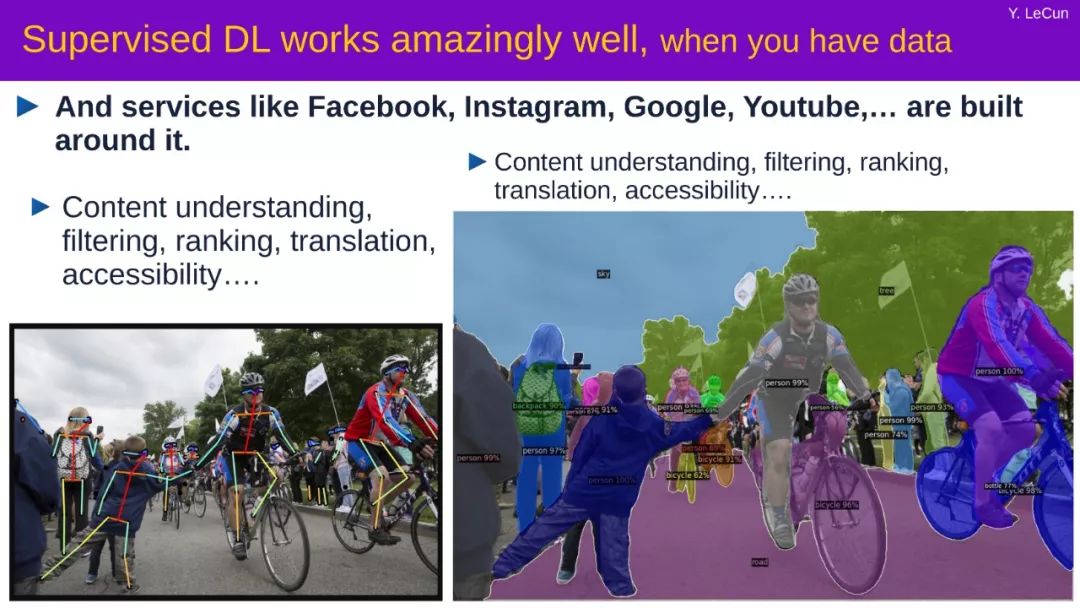

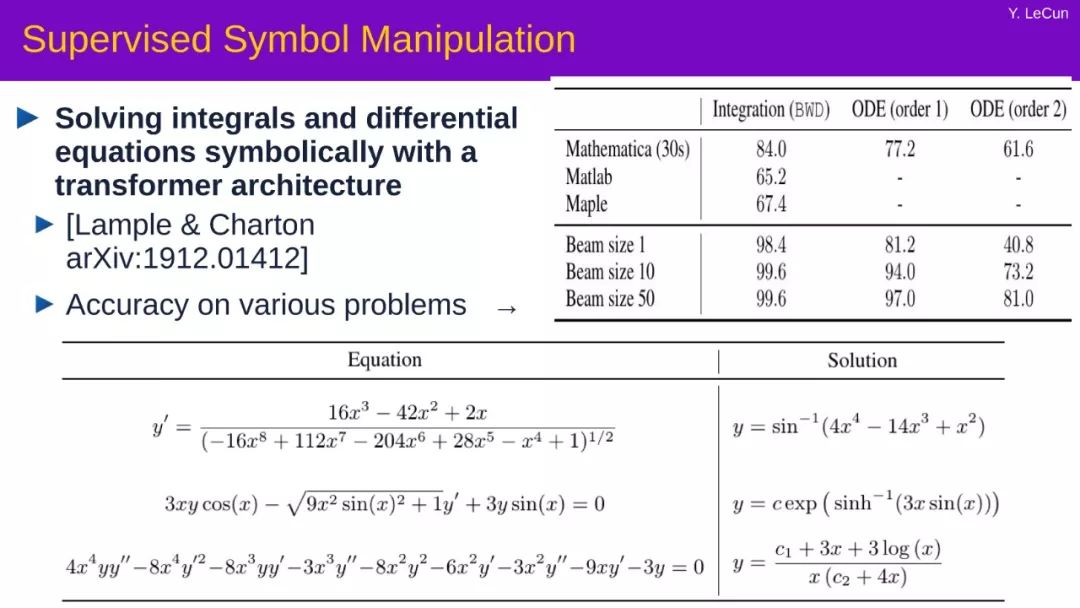

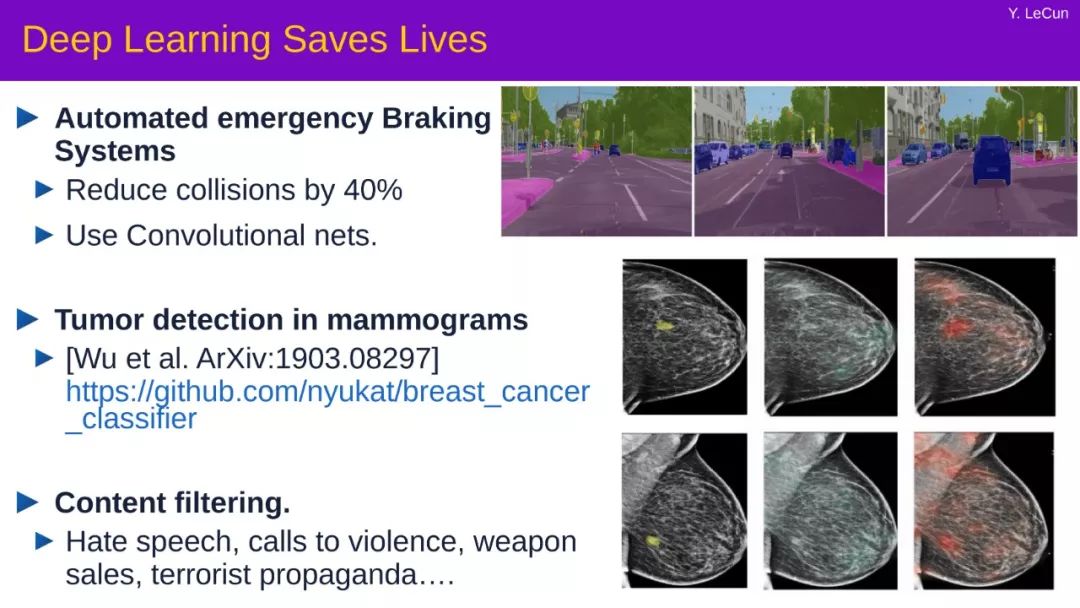

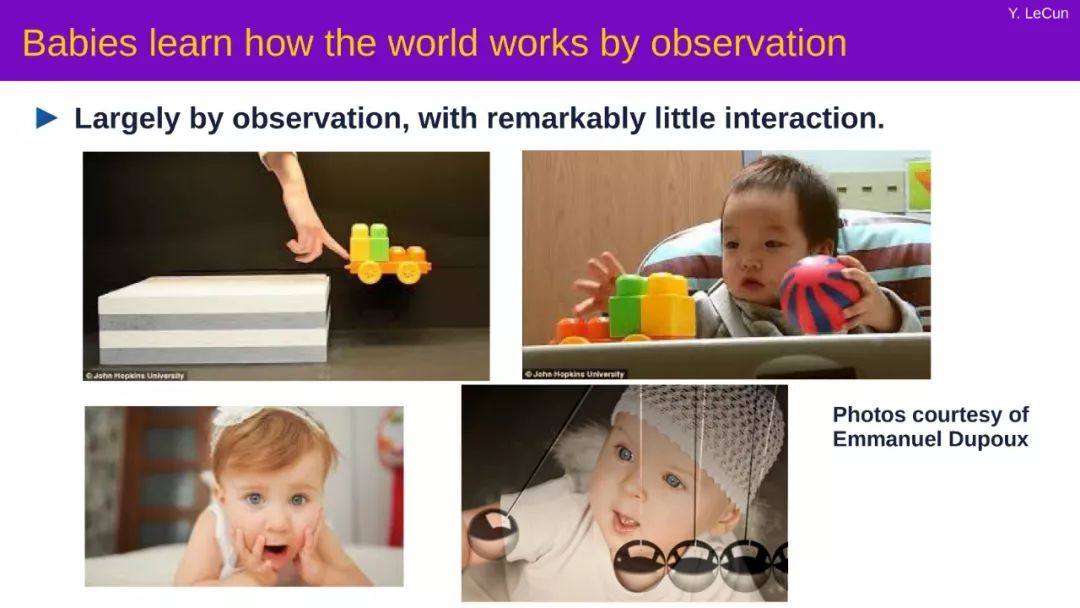

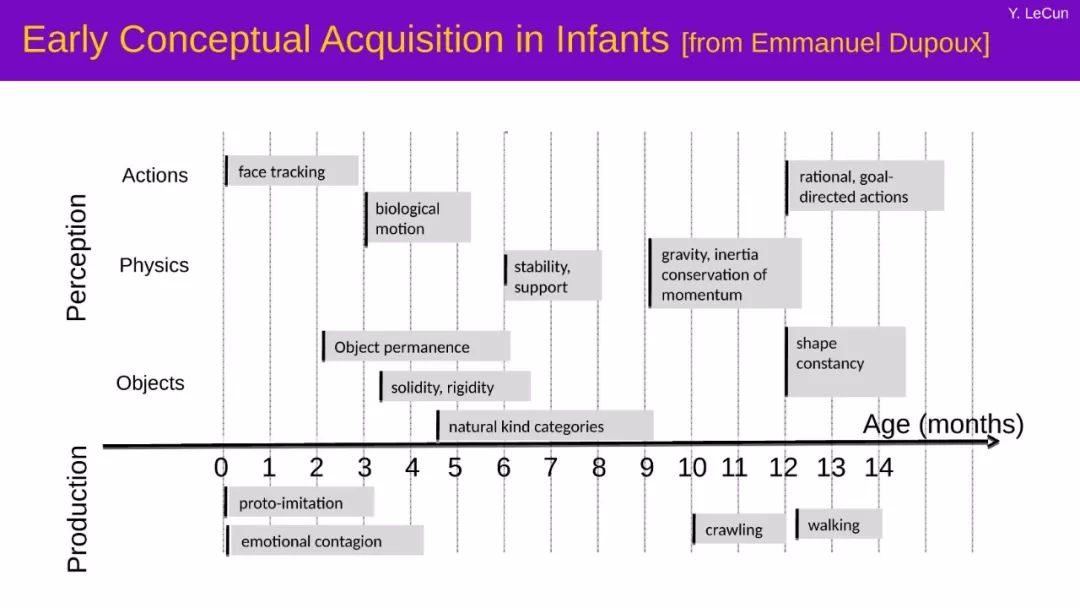

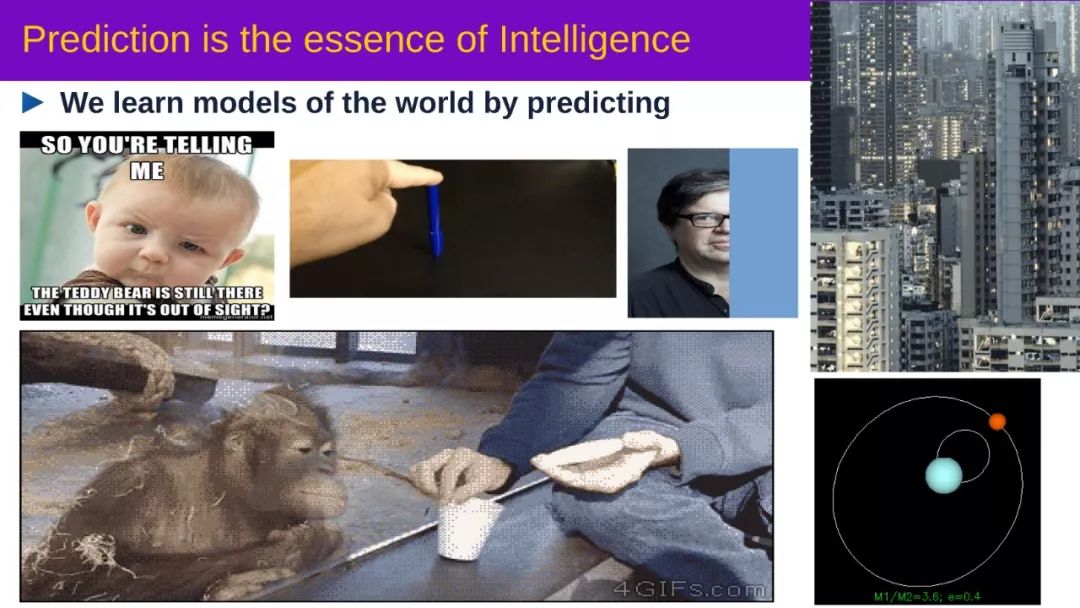

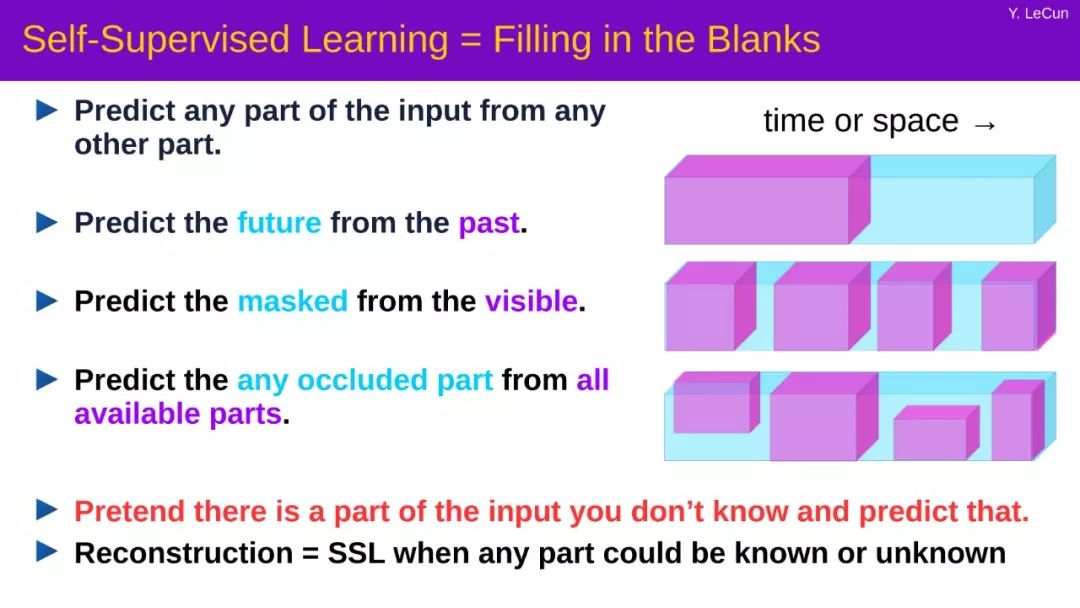

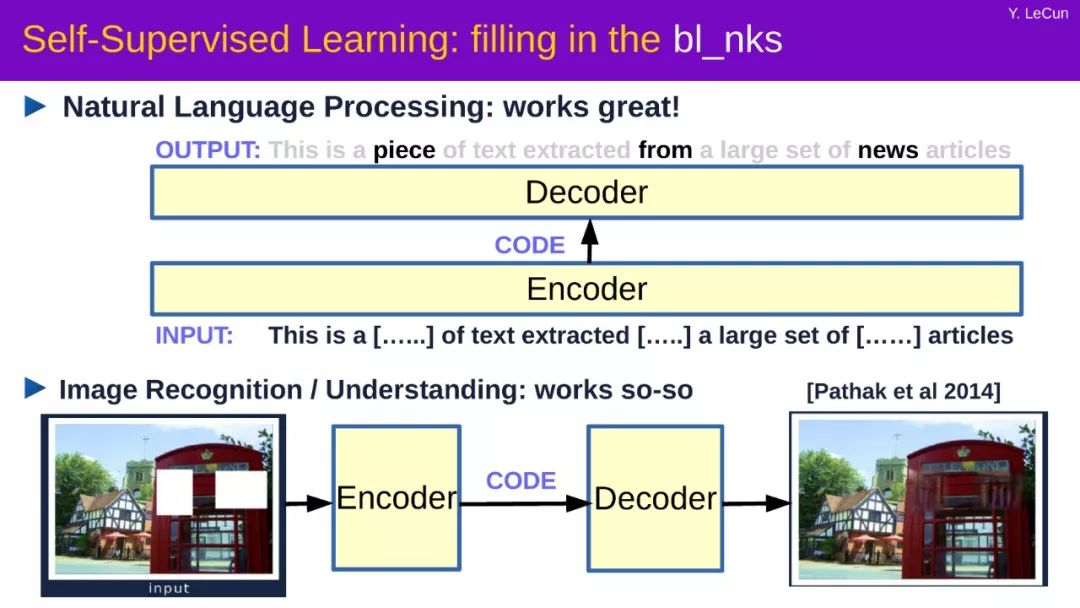

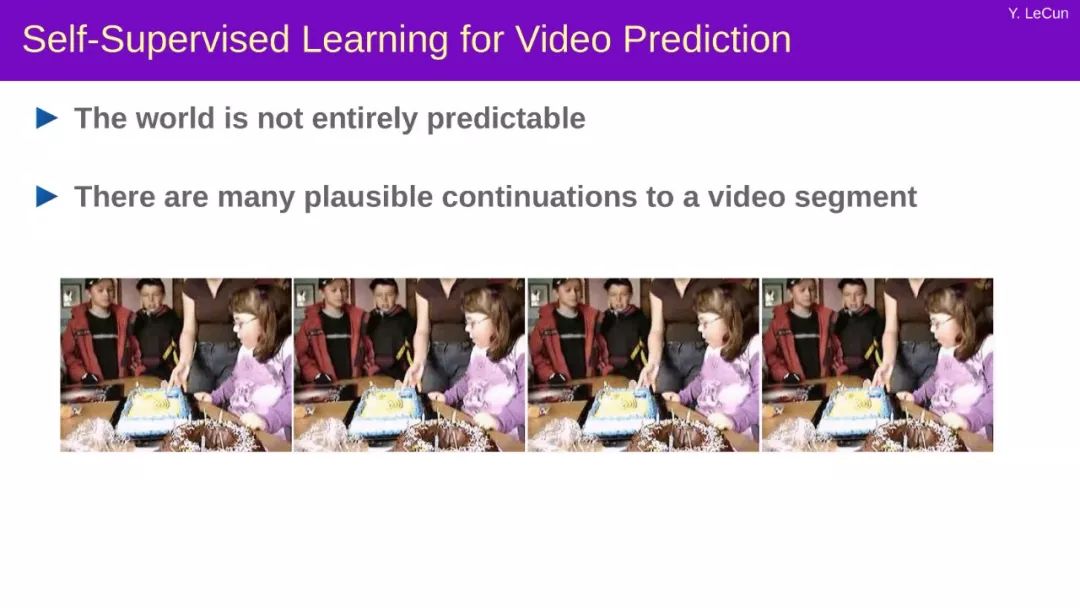

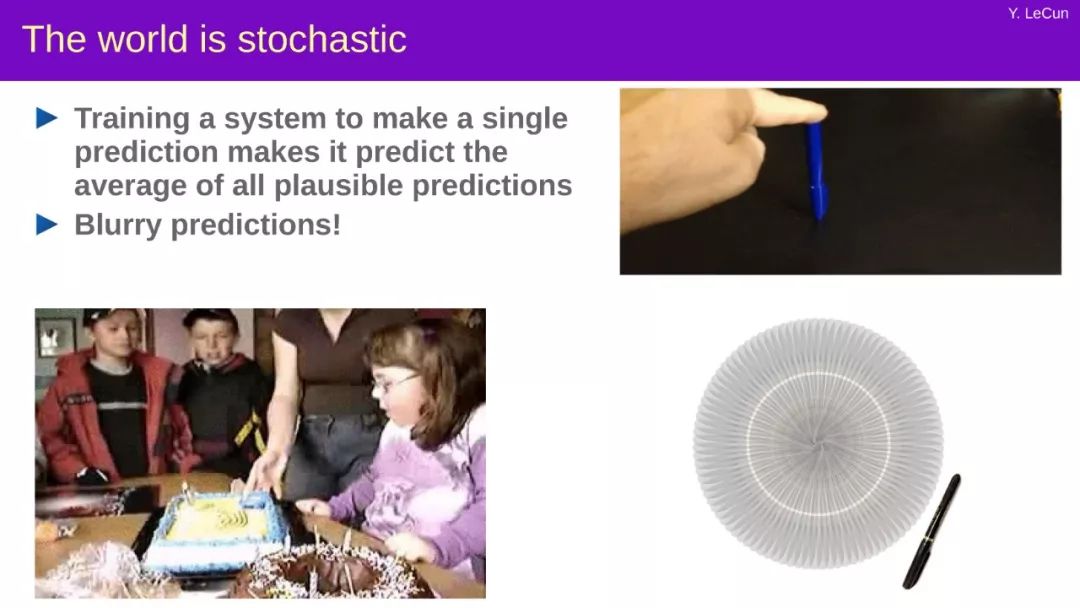

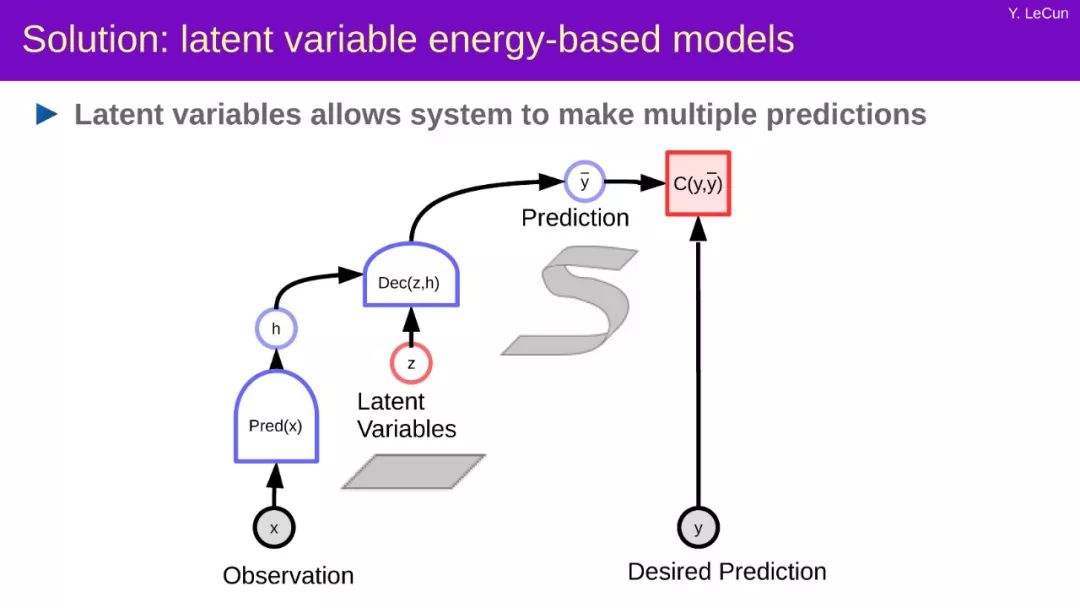

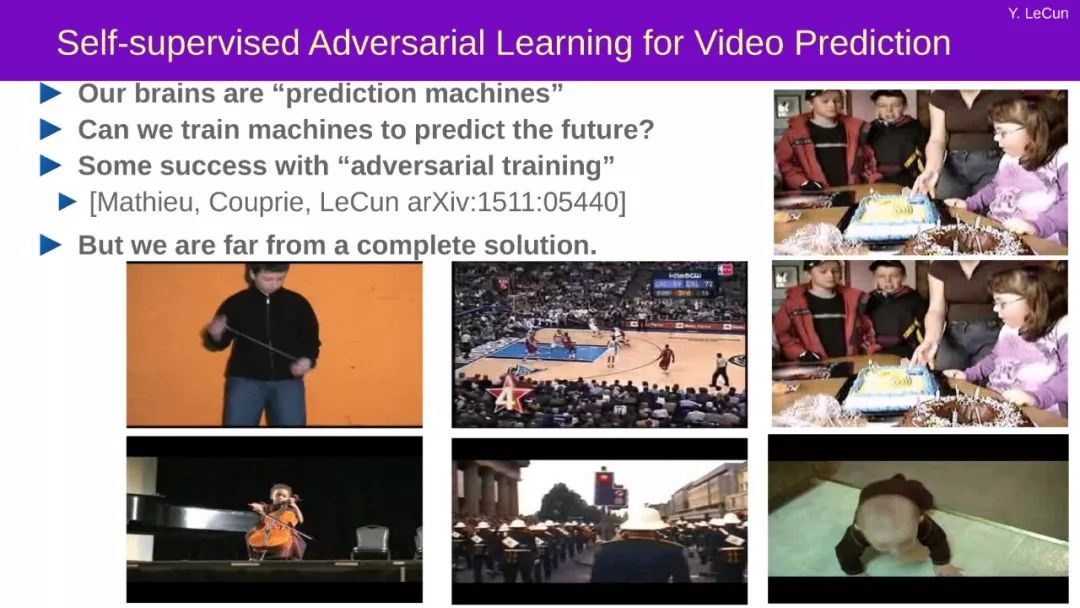

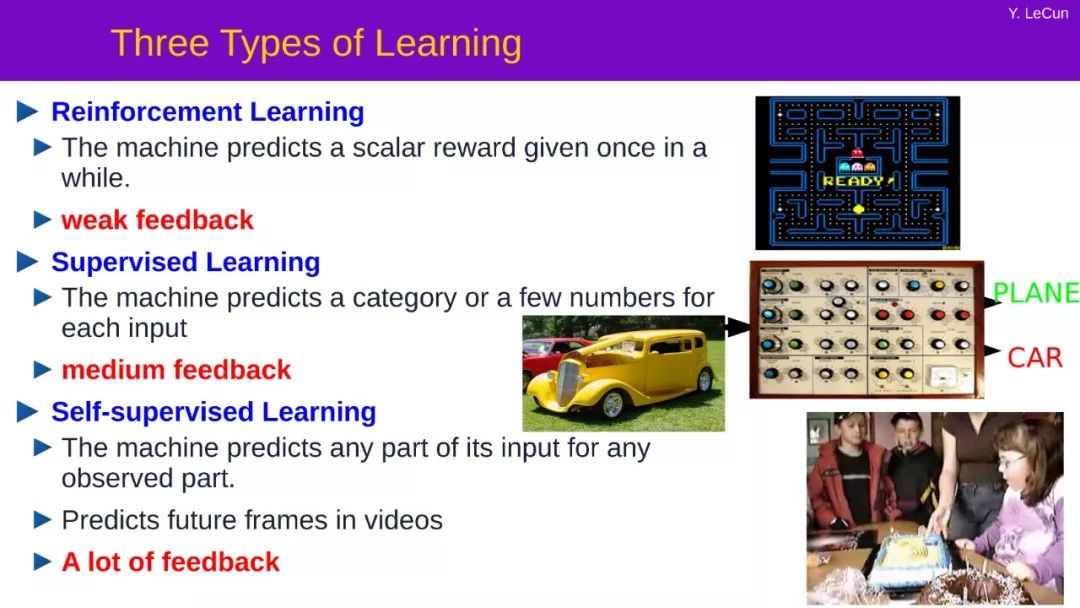

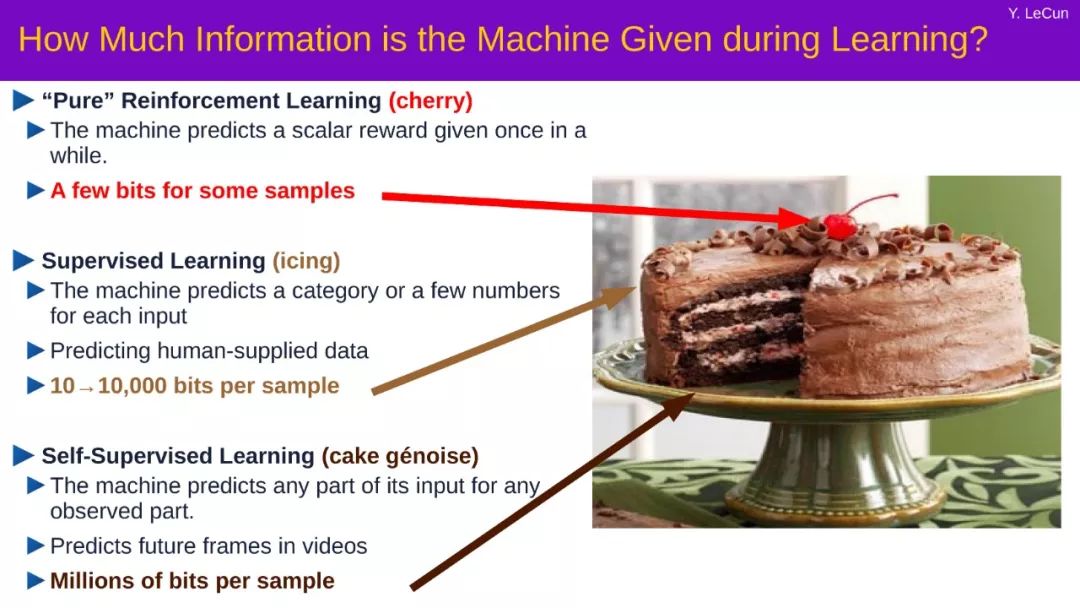

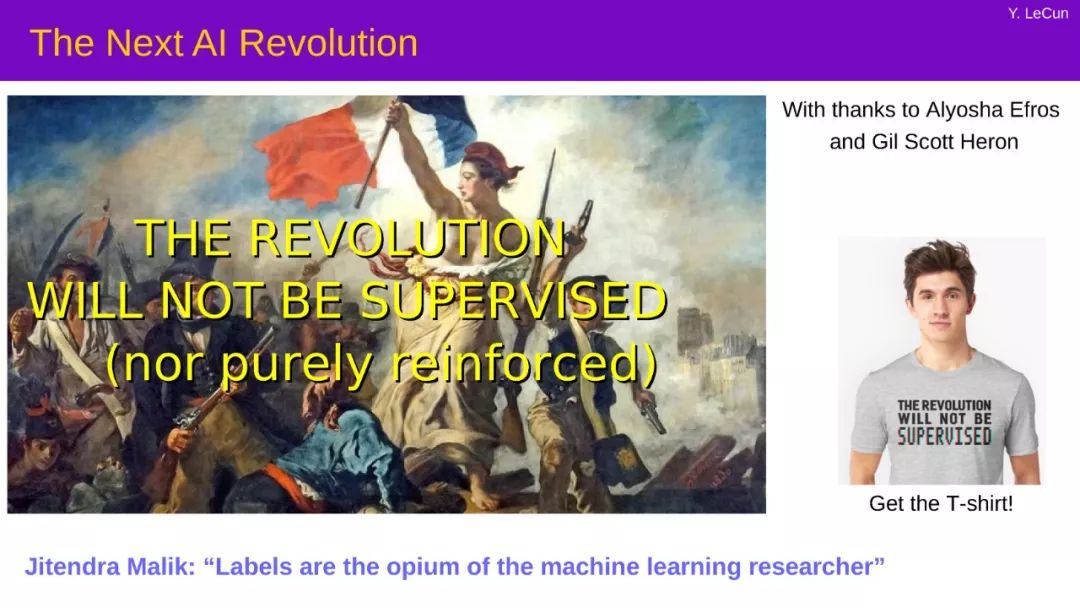

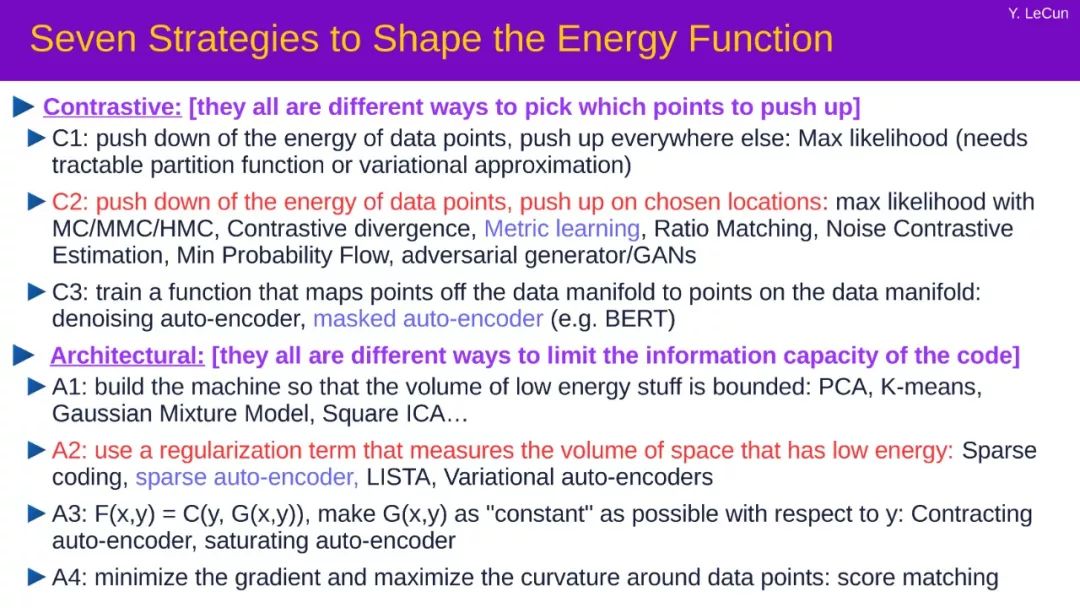

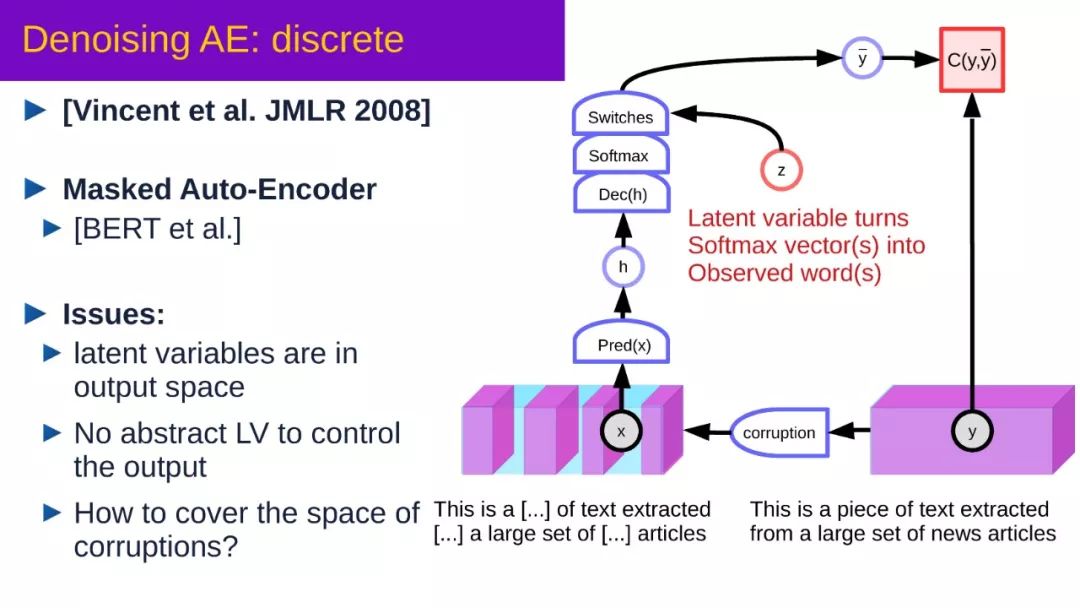

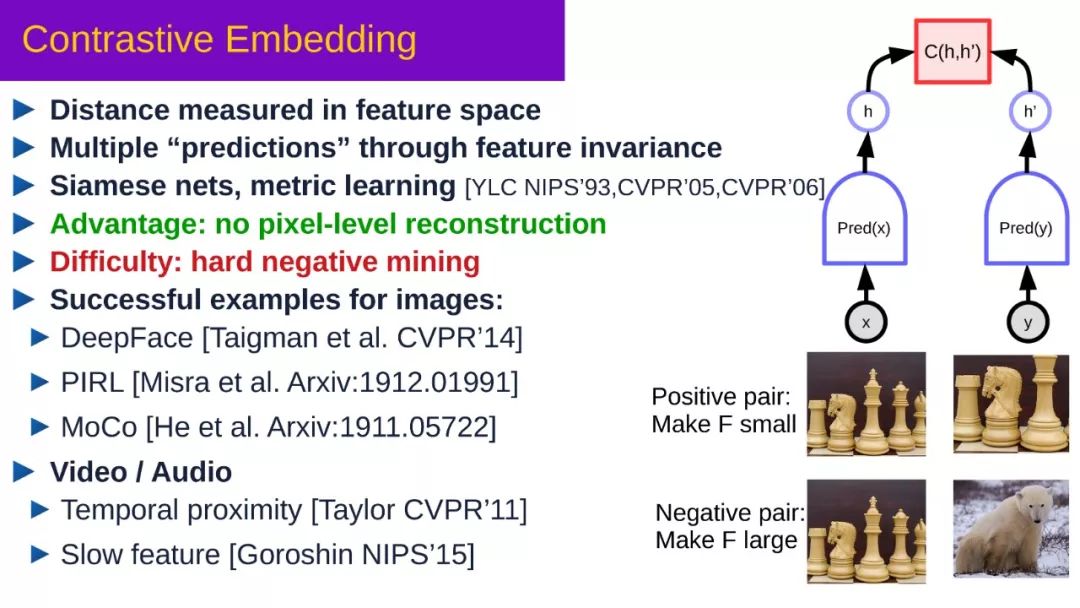

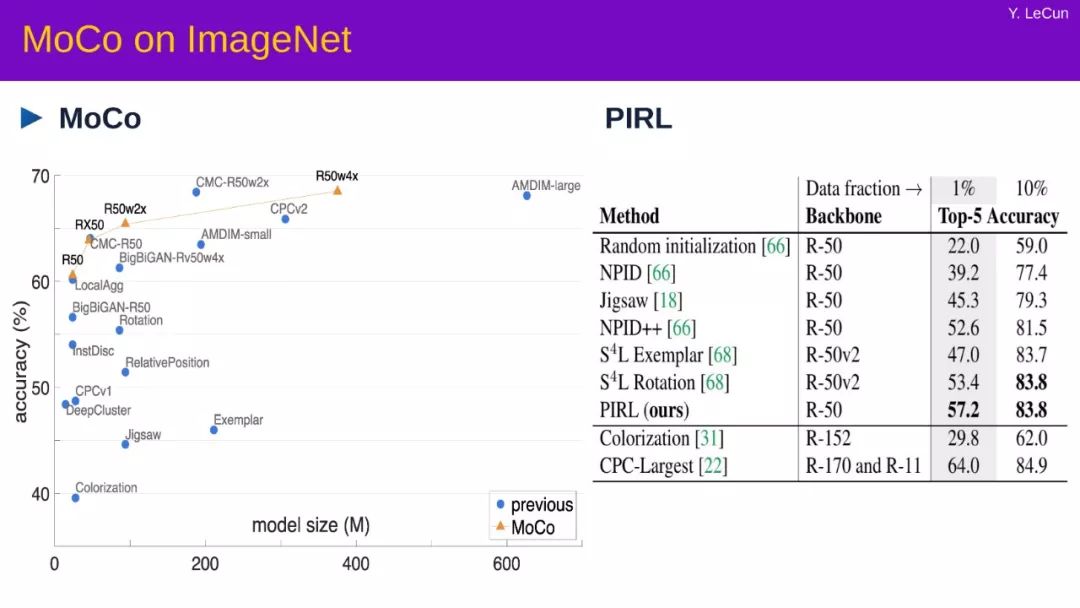

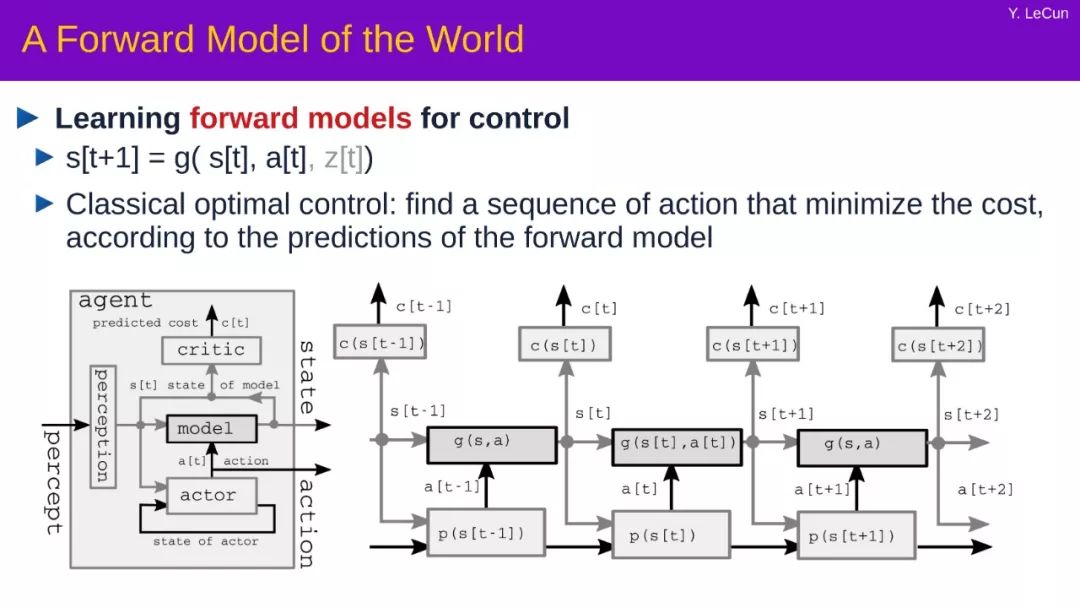

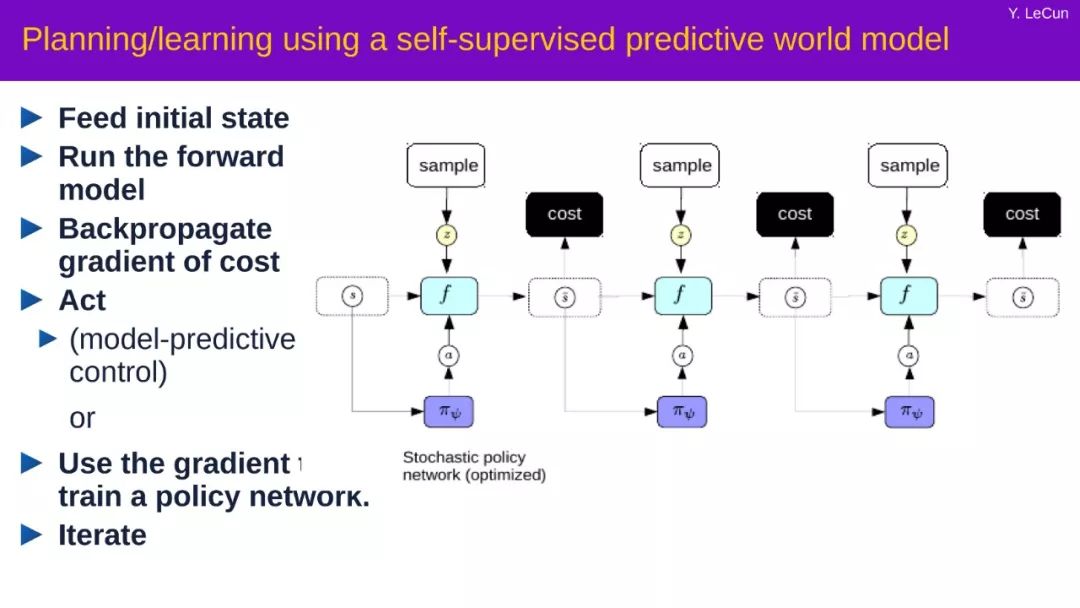

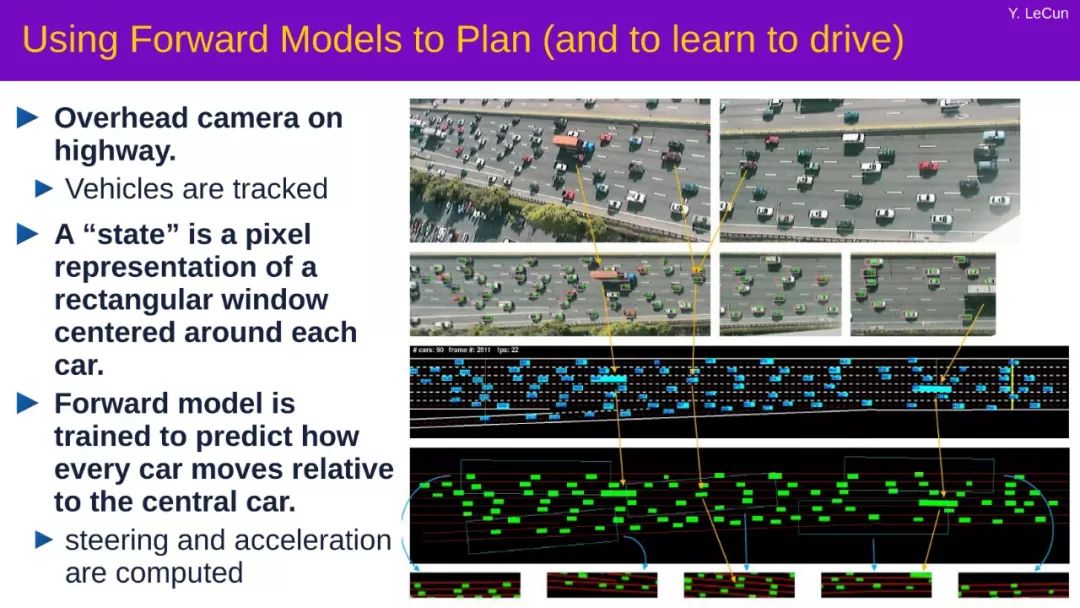

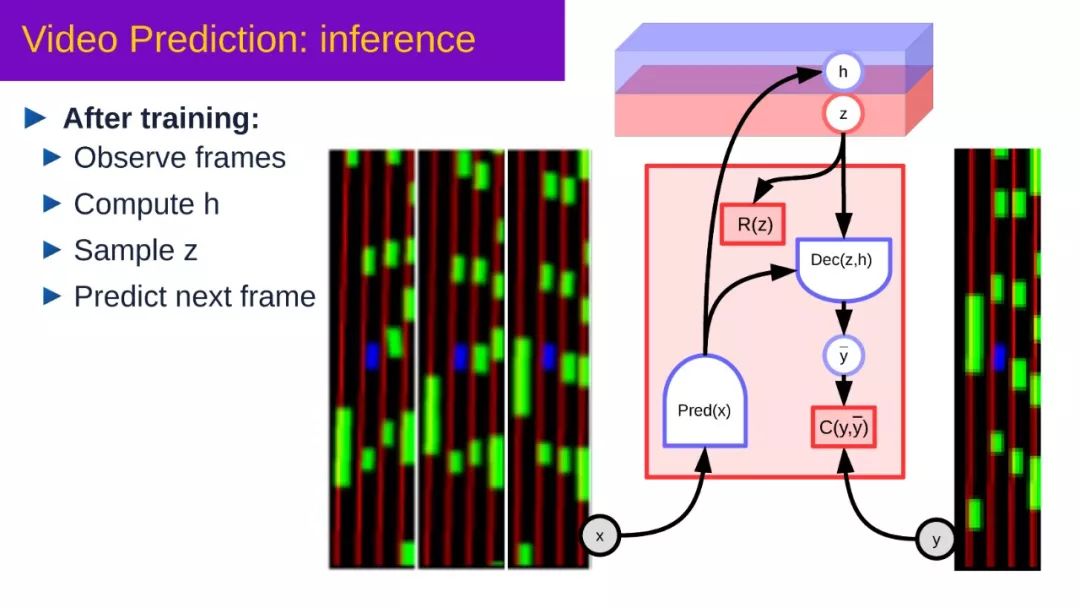

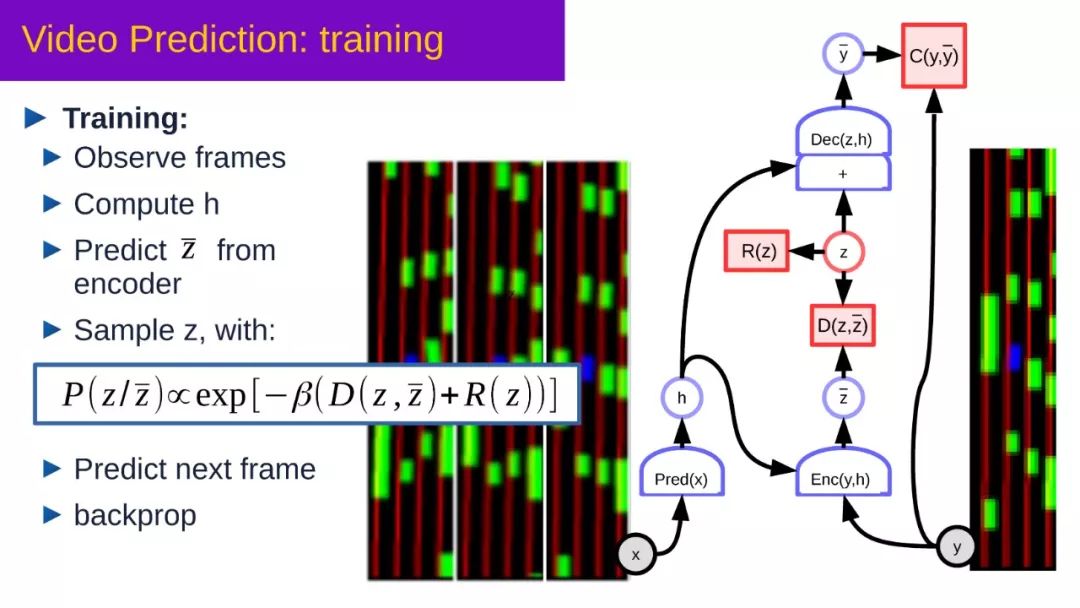

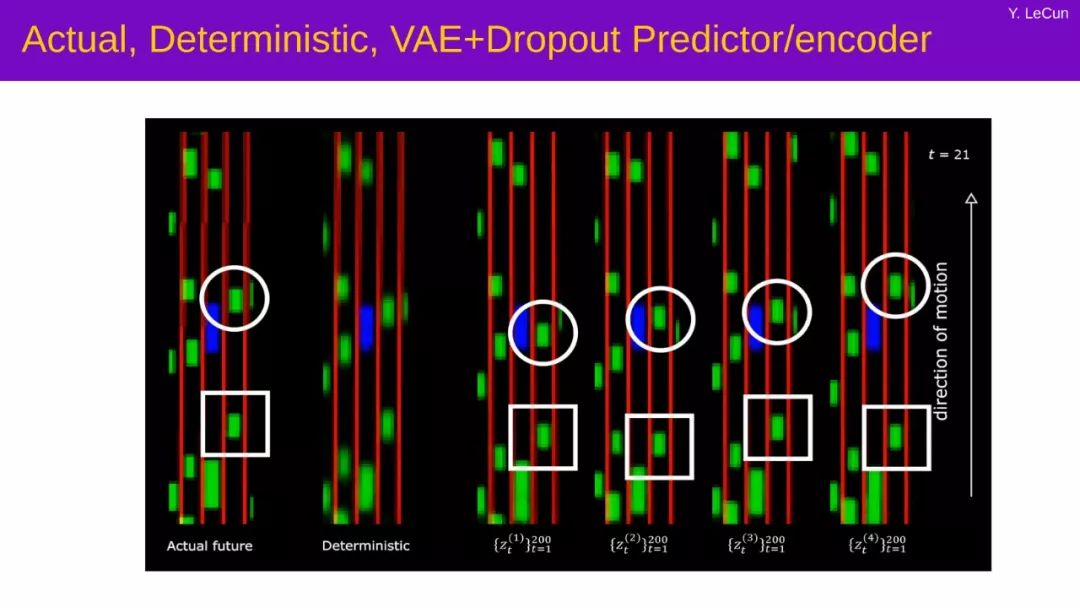

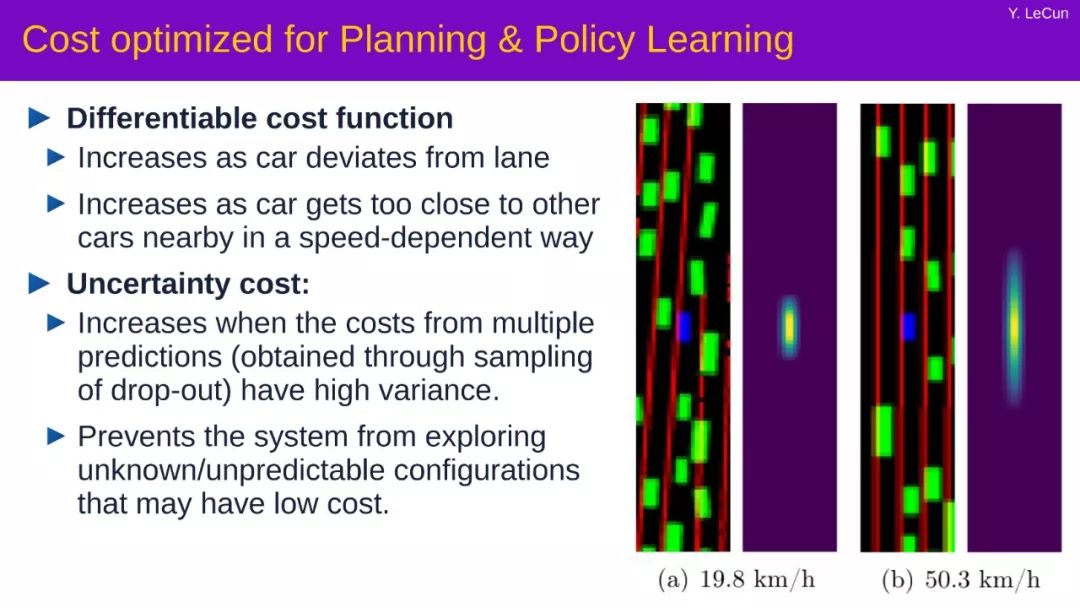

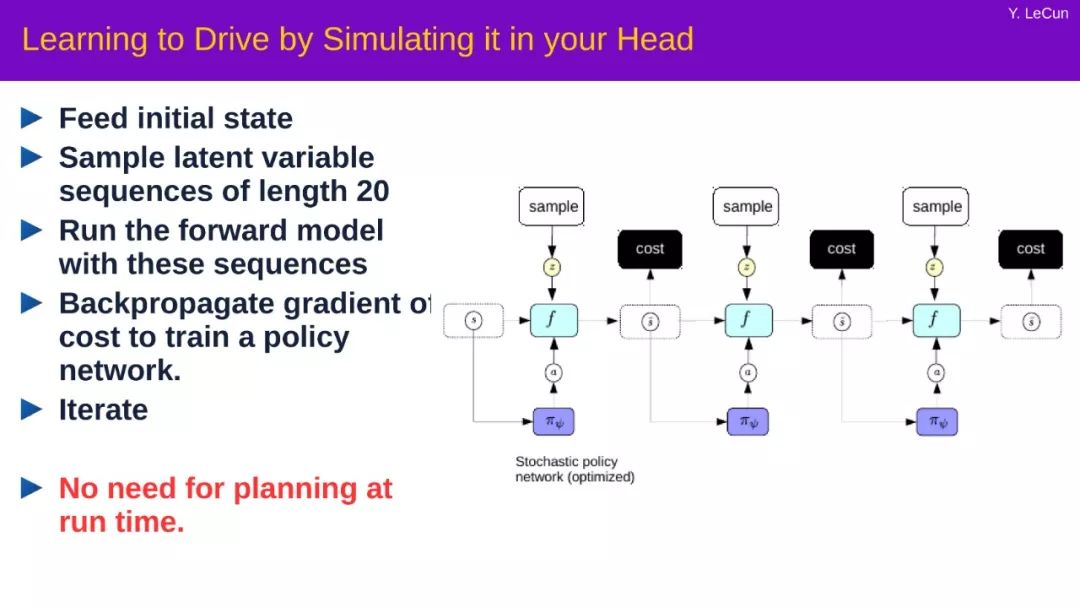

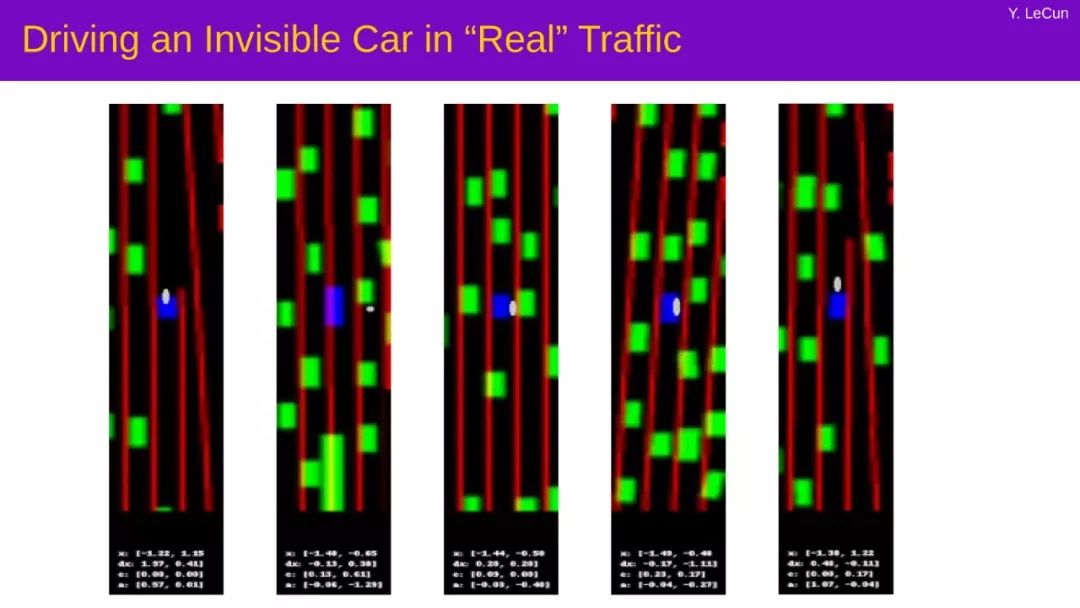

计算机感知、语音识别和自然语言处理的最新进展几乎都是建立在有监督的深度学习的基础上的,在这种学习中,机器预测需要人类提供的标注。如今,DL系统已经成为搜索引擎和社交网络内容过滤和检索、医学图像分析、驾驶辅助以及许多科学领域的核心。但是,最好的机器学习方法仍然需要比人类和动物学习多得多的数据或与环境的交互。我们如何让机器像动物和人类一样,通过独立于任务的观察来学习关于世界如何运作的大量背景知识?一种有前途的方法是自监督学习(SSL),即机器从输入的其他部分预测输入的一部分。SSL已经在离散领域带来了巨大的进步,例如语言理解。问题是如何在音频、图像和视频等高维连续域中使用SSL。

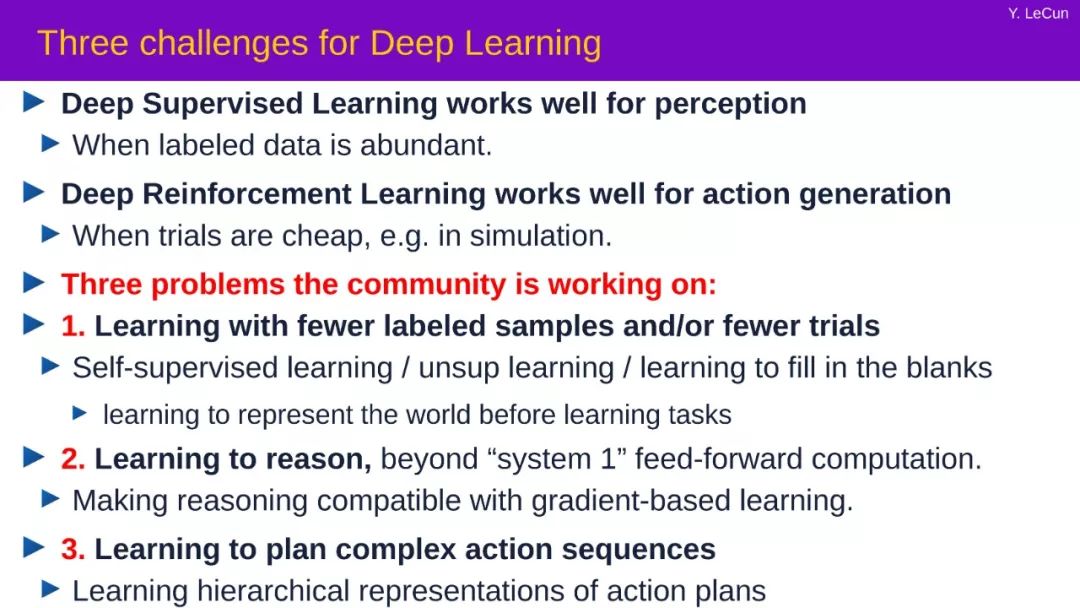

当标签数据充足时,针对于感知的监督学习才会有不错的效果

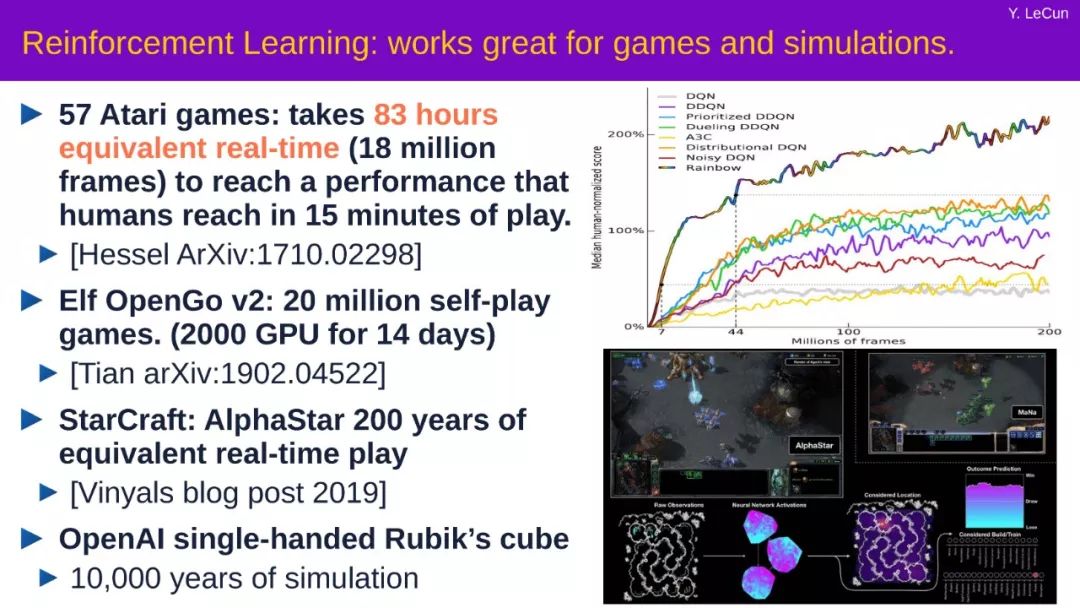

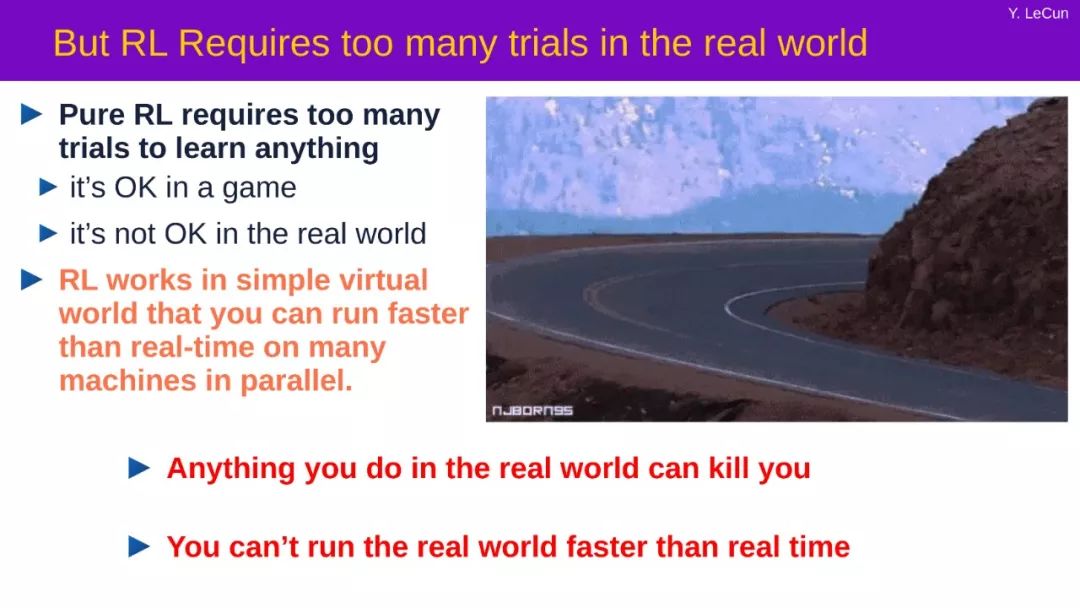

当实验成本低廉的时候(如在模拟实验中)强化学习才可以有较好的效果

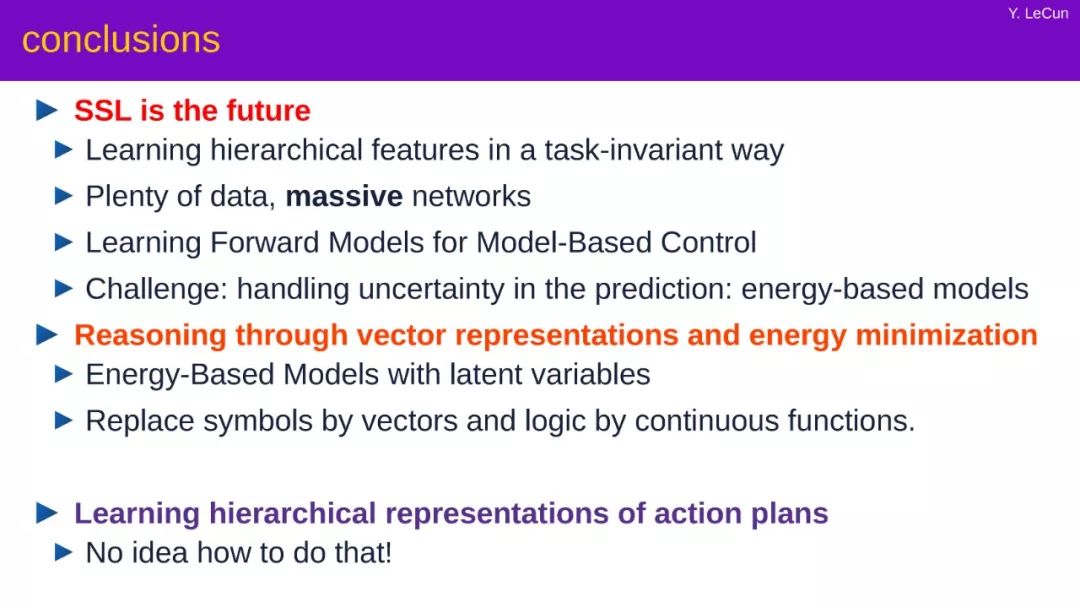

以及在当下整个社区都在推进的三个问题:尝试使用更少的标记样本或者更少的实验去训练,尝试学会推理并超越简单的感知计算,尝试规划复杂的动作序列。

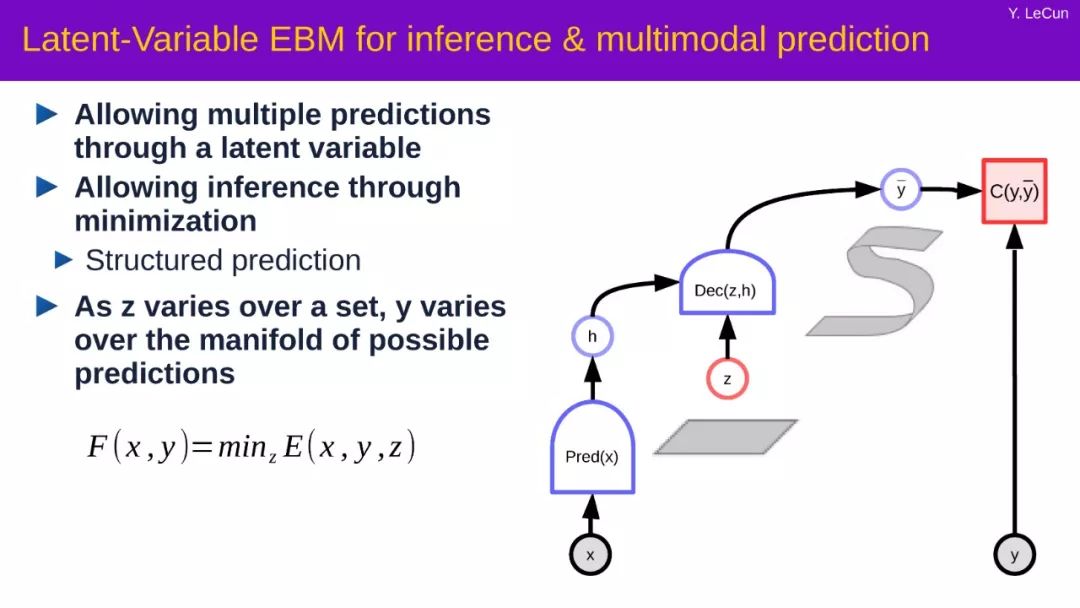

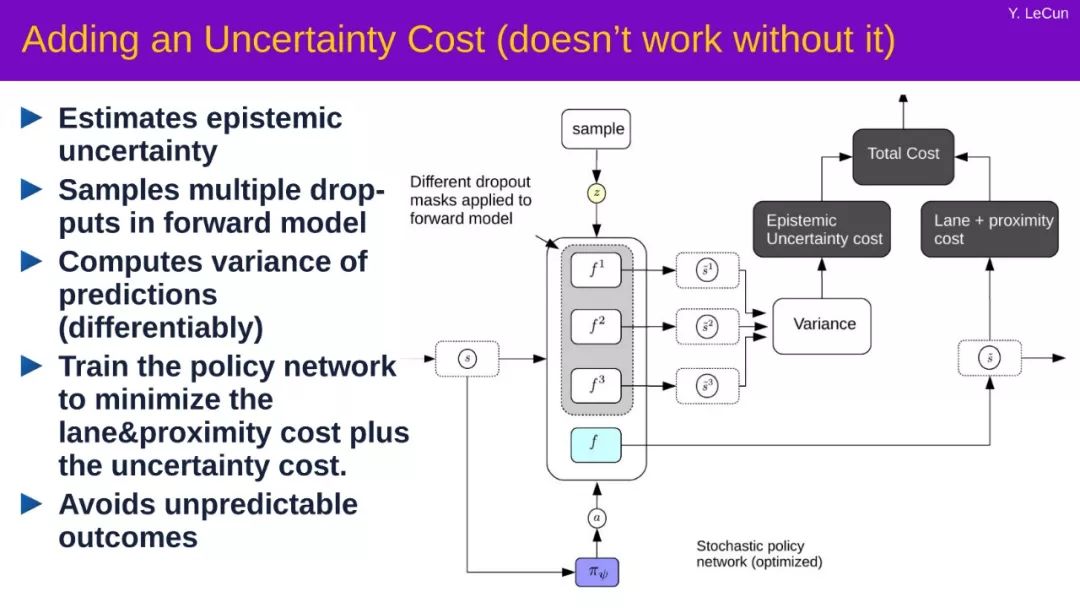

最后,LeCun 表示自监督学习(SSL)才是未来发展的趋势,它能在各种任务中学习到分层特征,以及现实生活中可使用的海量数据作为资源。但并不是尽善尽美,同时也面临处理预测中不确定性的挑战,比如之前的案例基于能源的模型。

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复“SSL20” 就可以获取《AAAI2020Yann Lecun演讲-自监督学习Self-Supervised Learning ,44页ppt》专知下载链接