谷歌大脑发布神经架构搜索新方法:提速1000倍

岳排槐 发自 LZYY

量子位 出品 | 公众号 QbitAI

去年,谷歌大脑团队发布神经网络自动架构搜索(NAS)。这个方法理论上能够更好地、自动化地设计神经网络的架构。

尽管NAS表现出色,但却要耗费大量的计算资源。运行一次,可能需要450块GPU跑上3-4天,大约耗用32400-43200个GPU小时。

一旦投入不够,就得不到理想的结果。

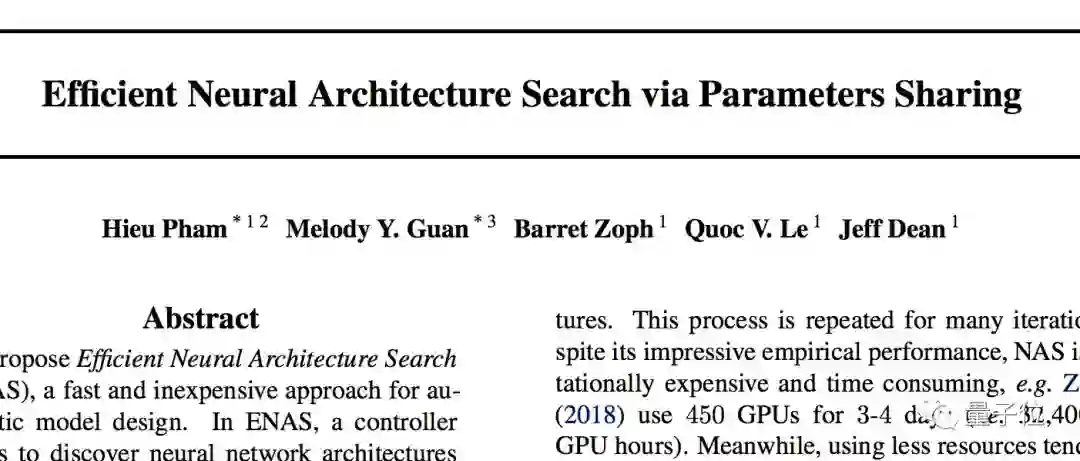

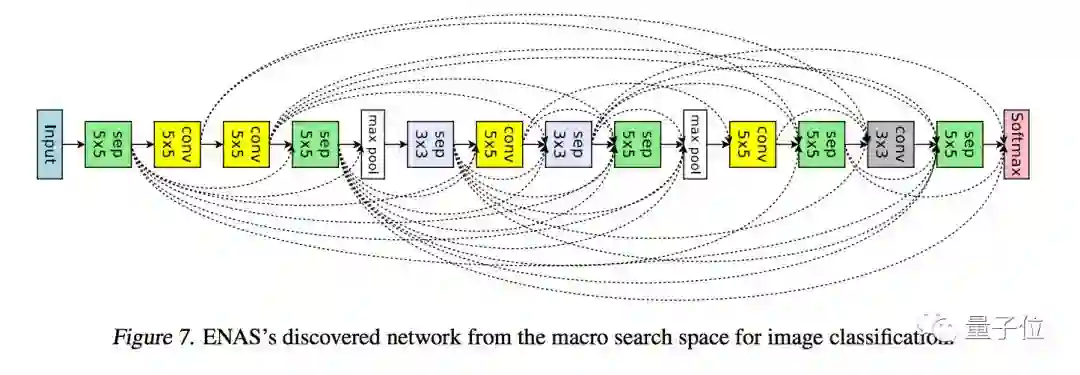

显然大牛们不会坐视不理。一年后,谷歌大脑团队发布了他们最新的研究成果:ENAS,全称是:Efficient Neural Architecture Search。

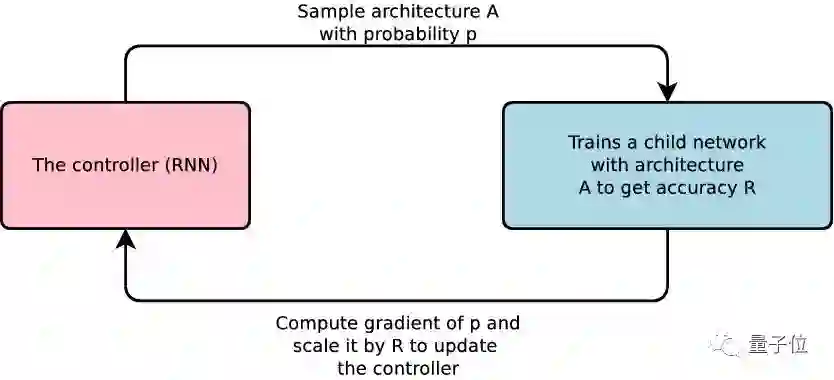

谷歌大脑的团队成员发现,NAS的计算瓶颈在于训练子模型收敛时,只衡量准确率而丢掉了所有训练成的权重。

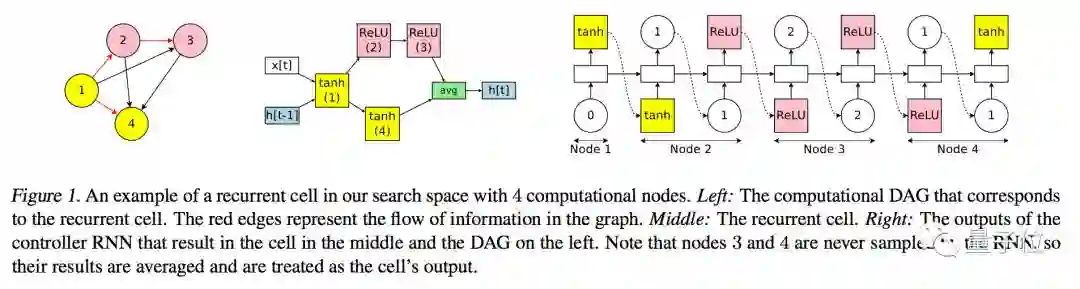

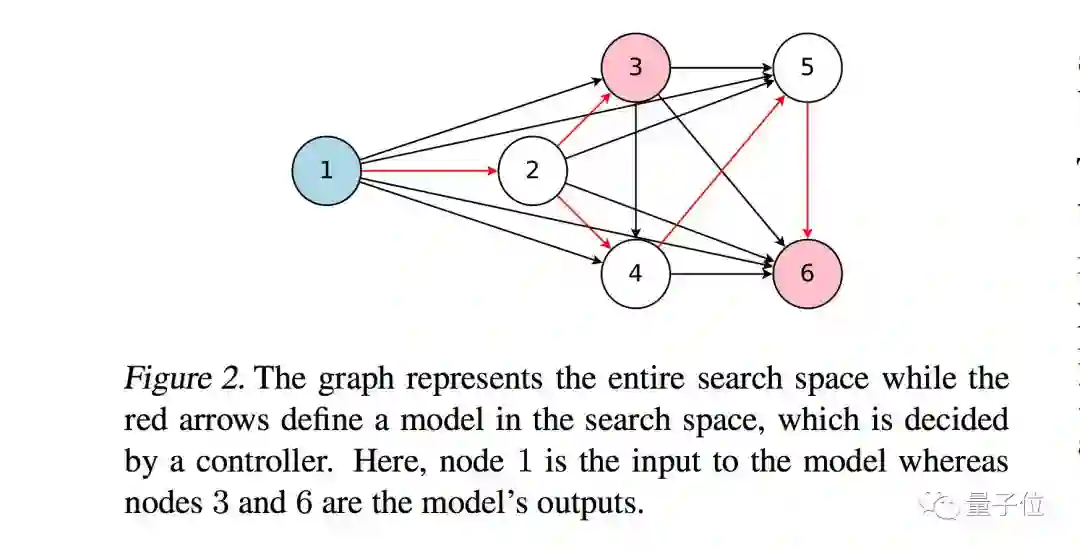

最新的研究,就是强制所有子模型共享权重,来提高NAS的效率。这个方法的复杂性在于,每个子模型的权重使用并不相同。

最终,谷歌大脑团队还是成功了。使用新方法后,仅用一块英伟达GTX 1080Ti显卡,就能在16个小时之内完成架构搜索。

与NAS相比,GPU时间耗用减少了1000倍以上。

这篇论文刚刚提交到arXiv上发表。作者包括:Hieu Pham、Melody Y. Guan、Barret Zoph、Quoc V. Le、Jeff Dean。

如果你对论文细节感兴趣,传送门在此:

https://arxiv.org/abs/1802.03268

另外,在ICLR 2018大会接收的论文中,也有一些算是类似方向的研究。如果你同样感兴趣,请收下这个来自谷歌大脑团队成员@hardmaru分享的传送门:

https://openreview.net/forum?id=rydeCEhs-

https://openreview.net/forum?id=BJQRKzbA-

作者系网易新闻·网易号“各有态度”签约作者

— 完 —

加入社群

量子位AI社群13群开始招募啦,欢迎对AI感兴趣的同学,加小助手微信qbitbot5入群;

此外,量子位专业细分群(自动驾驶、CV、NLP、机器学习等)正在招募,面向正在从事相关领域的工程师及研究人员。

进群请加小助手微信号qbitbot5,并务必备注相应群的关键词~通过审核后我们将邀请进群。(专业群审核较严,敬请谅解)

诚挚招聘

量子位正在招募编辑/记者,工作地点在北京中关村。期待有才气、有热情的同学加入我们!相关细节,请在量子位公众号(QbitAI)对话界面,回复“招聘”两个字。

量子位 QbitAI · 头条号签约作者

վ'ᴗ' ի 追踪AI技术和产品新动态