不可错过!MILA最新《自监督表示学习》课程,附PPT与视频下载

https://sites.google.com/view/ift6268-a2020/schedule

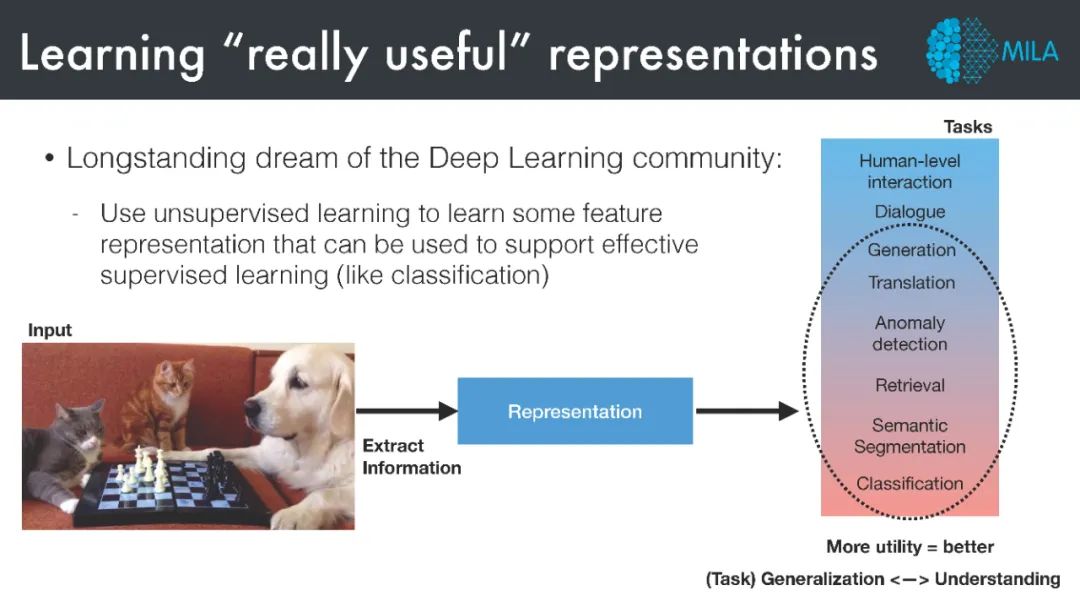

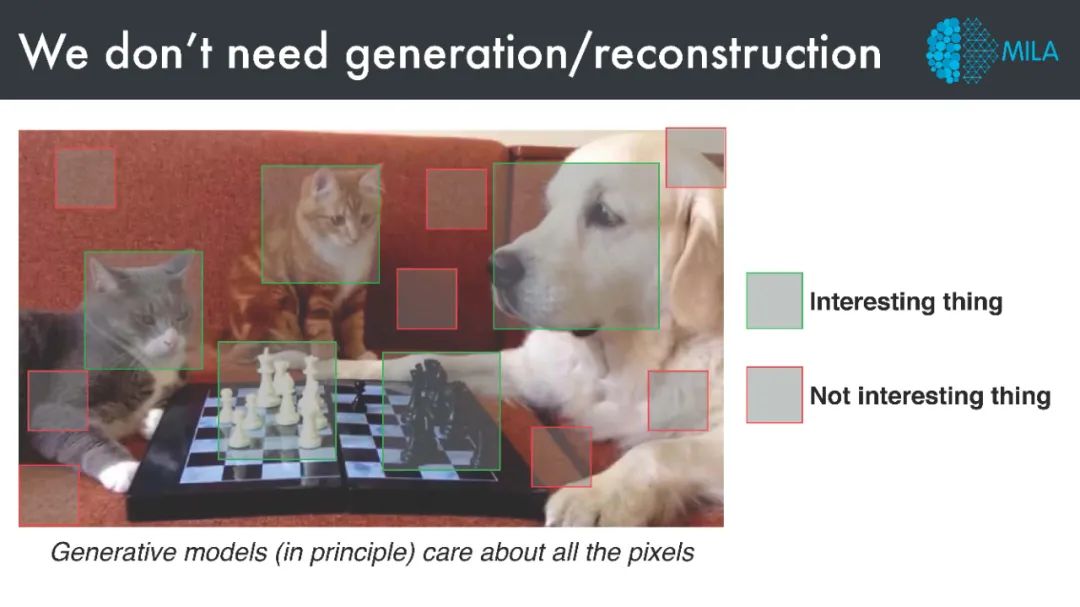

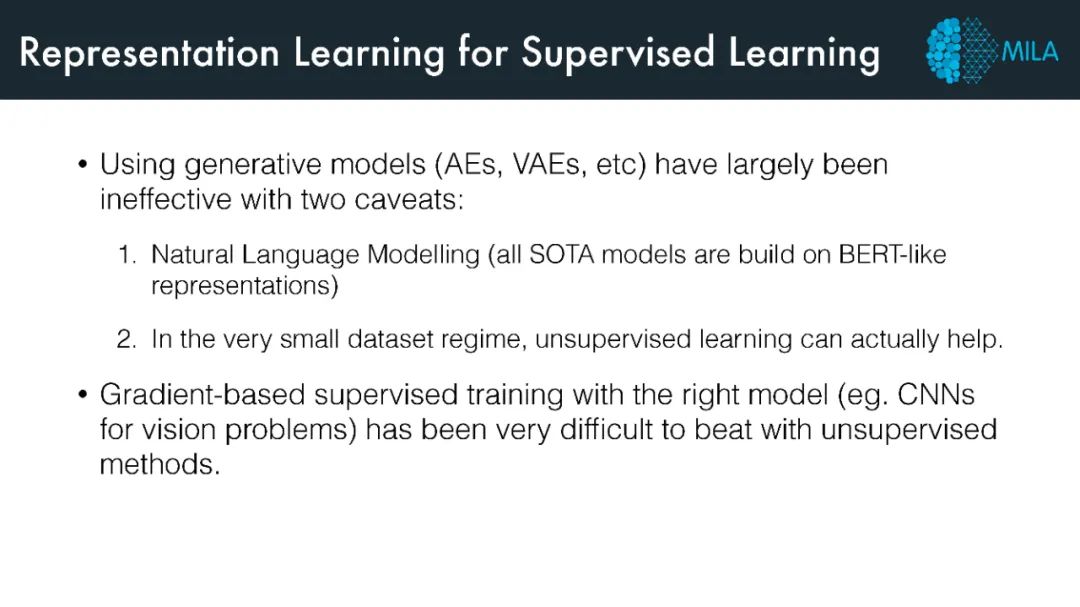

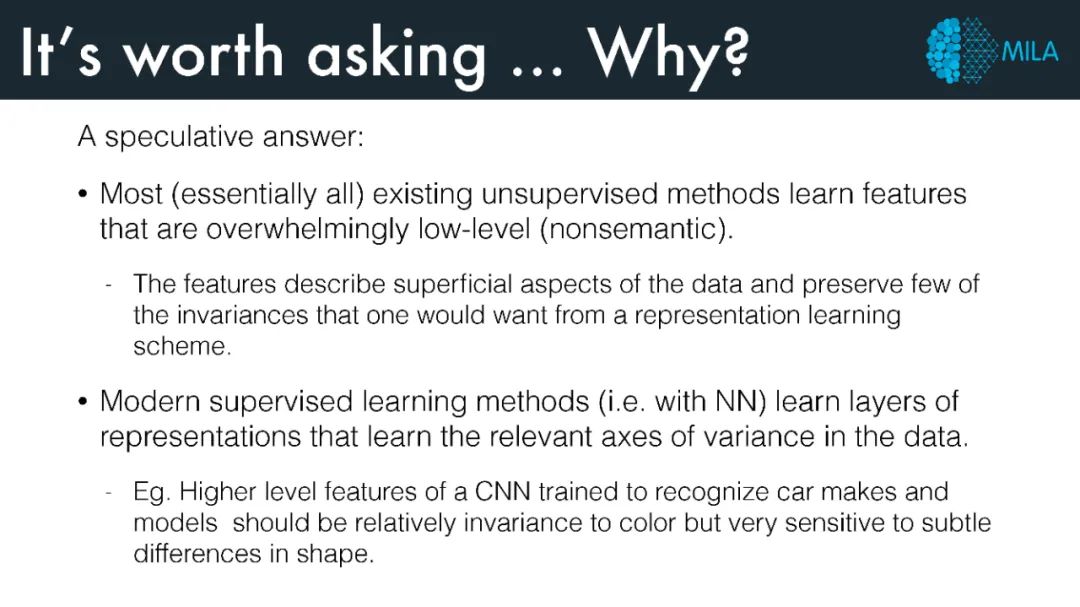

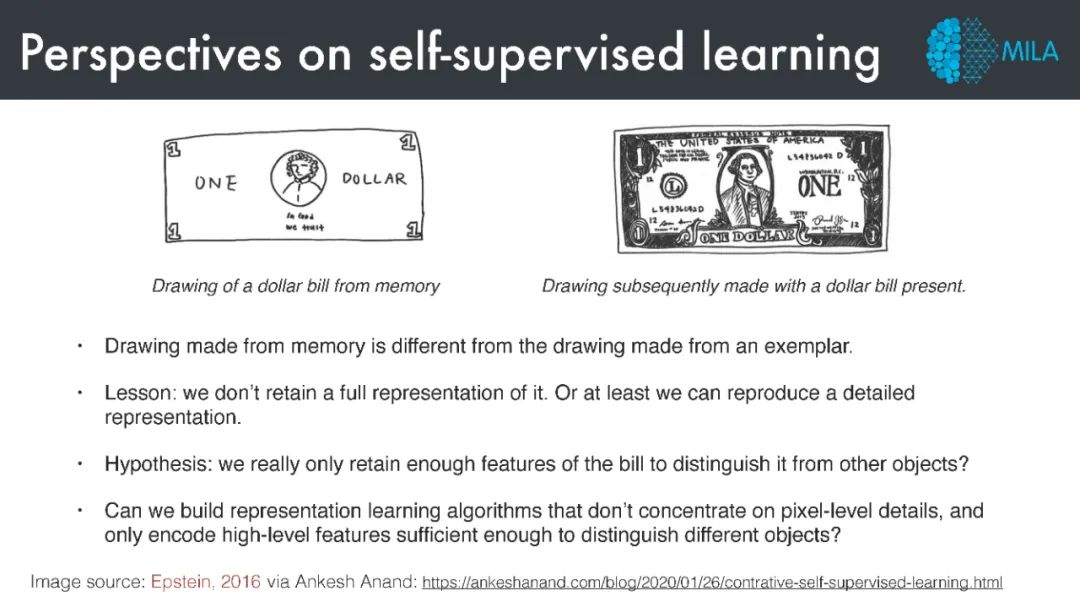

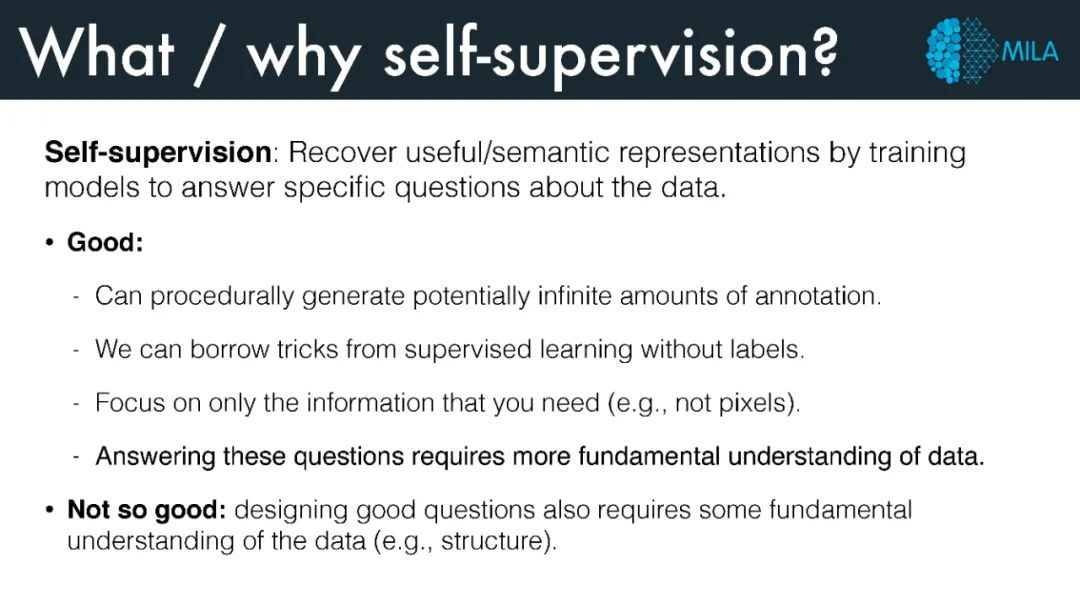

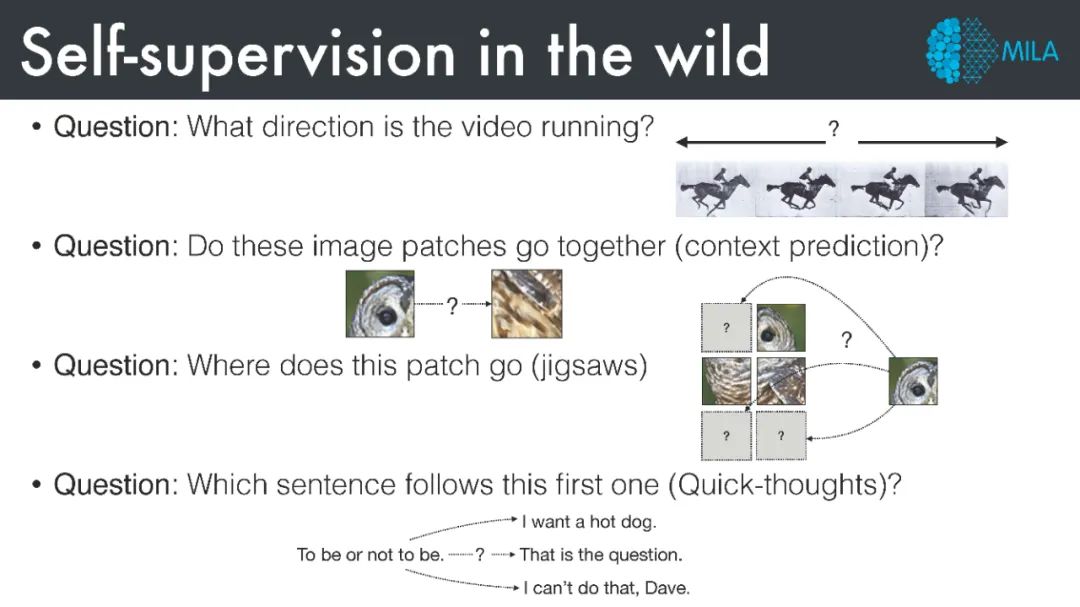

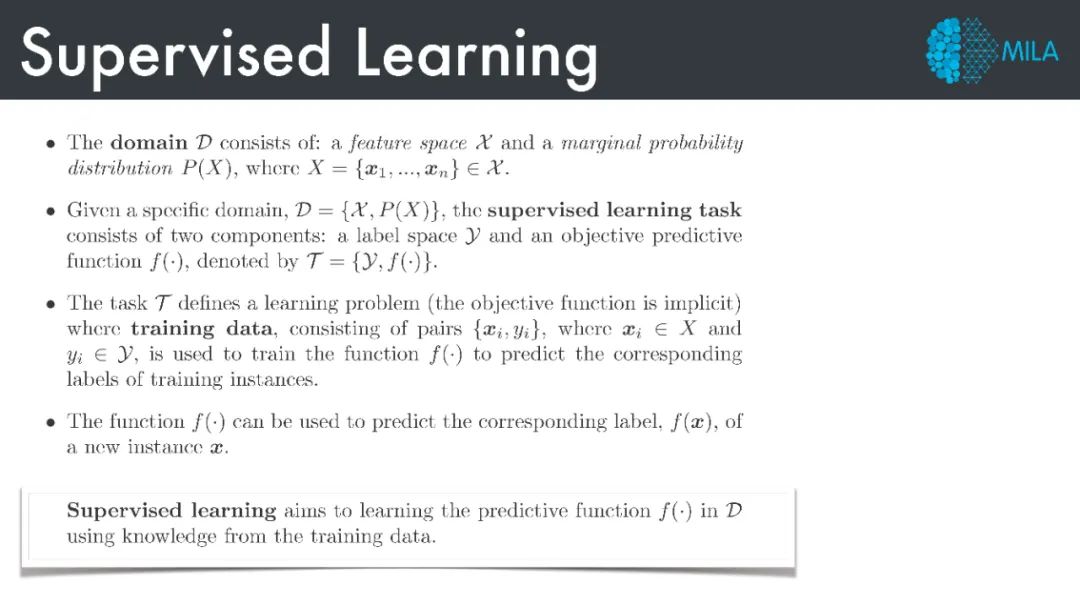

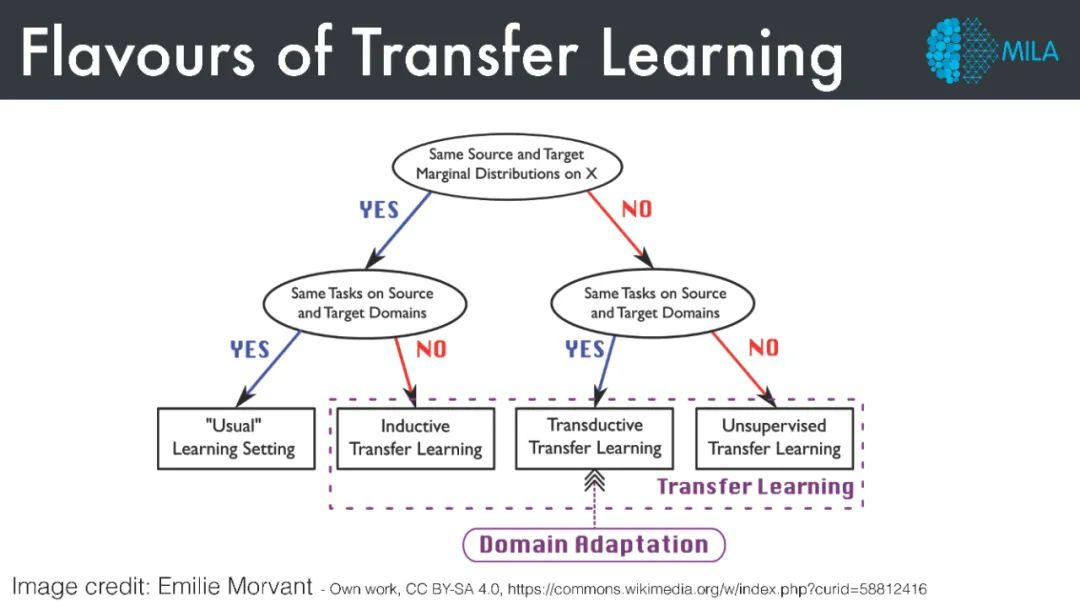

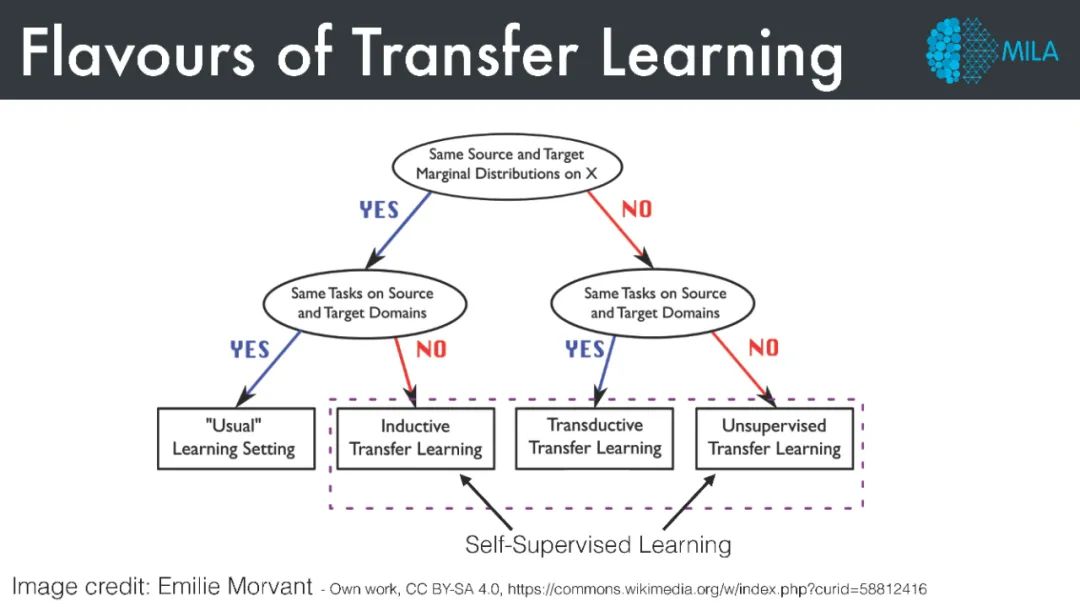

近年来,表示学习取得了很大的进展。大多数都是以所谓的自监督表示学习的形式。在本课程中,我们将对什么是自我监督的学习方法有一个相当广泛的解释,并在适当的时候包括一些无监督学习方法和监督学习方法。我们感兴趣的方法,学习有意义的和有效的语义表示,而不(专门)依赖标签数据。更具体地说,我们将对以下方法感兴趣,如: 数据增广任务,知识蒸馏,自蒸馏,迭代学习,对比方法 (DIM, CPC, MoCo, SimCLR等),BYOL,以及自监督方法的分析。

我们的目标是了解自监督学习方法是如何工作的,以及起作用的基本原理是什么。

这是一个关于这一主题的高级研讨会课程,因此,我们将阅读和讨论大量的最近的和经典的论文。讲座将主要由学生主导。我们假设了解了机器学习的基础知识 (特别是深度学习——正如你在IFT6135中看到的那样),我们还将探索自监督表示学习在广泛领域的应用,包括自然语言处理、计算机视觉和强化学习。

在本课程中,我们将广泛讨论自监督学习(SSL),特别是深度学习。最近,深度学习在许多应用领域取得了大量令人印象深刻的经验收益,其中最引人注目的是在目标识别和图像和语音识别的检测领域。

在本课程中,我们将探讨表示学习领域的最新进展。通过学生领导研讨会,我们将回顾最近的文献,并着眼于建立

本课程所涵盖的特定主题包括以下内容:

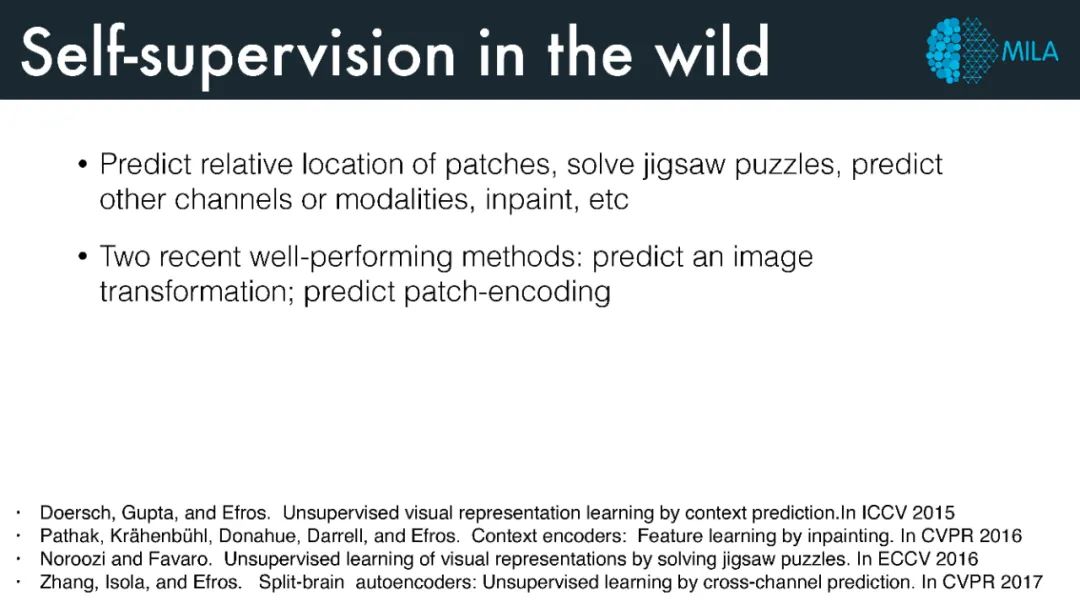

Engineering tasks for Computer Vision

Contrastive learning methods

Generative Methods

Bootstrap Your Own Latents (BYoL)

Self-distillation Methods

Self-training / Pseudo-labeling Methods

SSL for Natural Language Processing

Iterated Learning / Emergence of Compositional Structure

SSL for Video / Multi-modal data

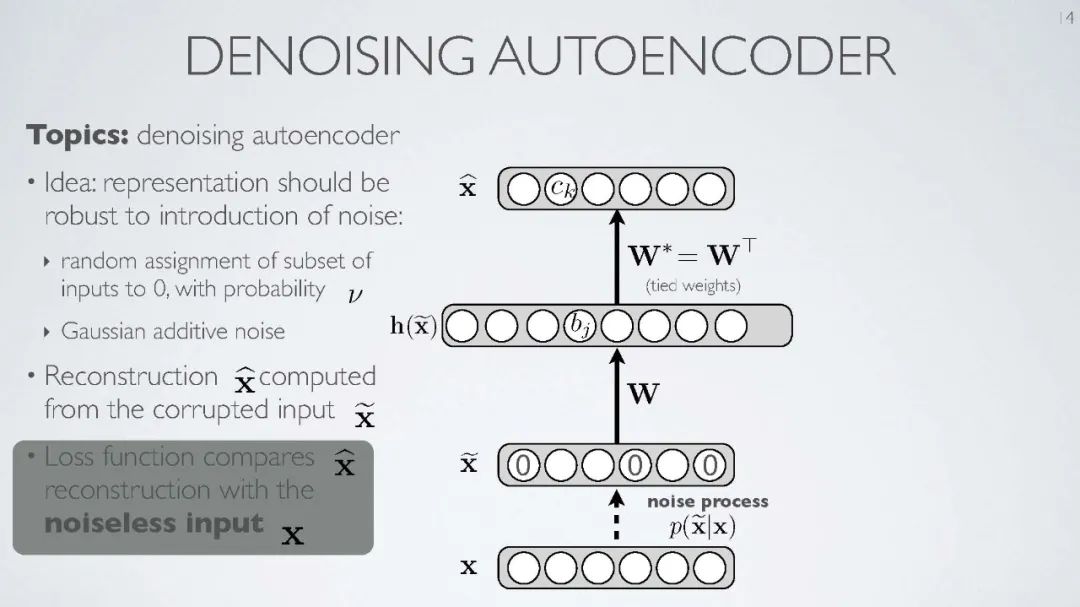

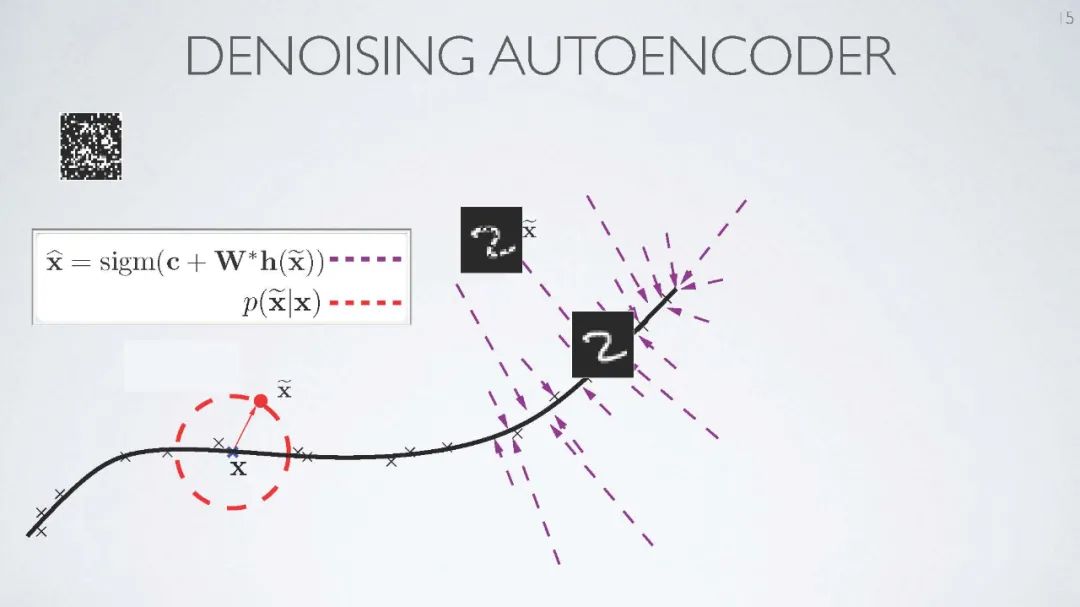

The role of noise in representation learning

SSL for RL, control and planning

Analysis of Self-Supervised Methods

Theory of SSL

Unsupervised Domain Adaptation

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复“自监督学习” 可以获取《不可错过!MILA最新《自监督表示学习》课程,附PPT与视频下载》专知下载链接索引