Nest Hub 的增强型睡眠感知

发布人:Google Health 软件工程师 Michael Dixon 和产品经理 Reena Singhal Lee

今年早些时候,我们发布了 Nest Hub 的非接触式睡眠感知,这是一项可选功能,可帮助用户更好地了解他们的睡眠模式和夜间健康状况。虽然一些关键睡眠数据分析可由一个人的整体时间表和睡眠持续时间得出,但仅凭这一点并不能说明全部情况。人脑具有特殊的神经回路来协调睡眠周期 (Sleep cycle),即深睡、浅睡和快速眼动 (Rapid Eye Movement, REM) 三个睡眠阶段间的转换,睡眠周期不仅对身体和情绪健康至关重要,而且对最佳的身体和认知表现也很重要。将此类睡眠阶段信息和夜间干扰事件相结合,可以帮助您更好地了解睡眠时发生的情况。

日前我们发布了睡眠感知的增强功能,可提供更深入的睡眠数据分析。虽然并非用于医疗目的1,但这些增强功能允许用户通过睡眠阶段更好地了解睡眠,并且可以将用户的咳嗽声和打呼声与房间里其他声音区分开来。本文会介绍我们如何开发这些新技术,如何通过迁移学习技术来估计睡眠阶段,以及如何实现雷达和麦克风信号的传感器融合,以消除睡眠干扰来源。

日前我们发布了

https://blog.google/products/google-nest/let-nest-help-you-rest-holidays/

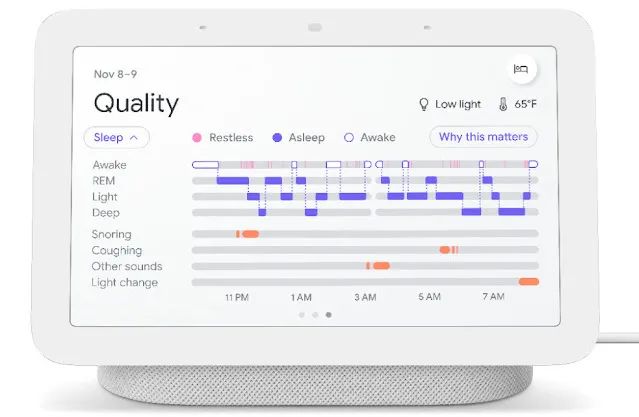

为帮助人们了解他们的睡眠模式,Nest Hub 会显示一个睡眠结构图 (Hypnogram),其绘制了用户在一个睡眠时段中的睡眠阶段。睡眠期间潜在的声音干扰现在将包括时间线里的“其他声音”,以将用户的咳嗽声/打鼾声与其他声音干扰(检测自房间内校准睡眠区之外的来源)区分开来

大多数人每晚的睡眠周期循环 4 到 6 次,每次大约 80 到 120 分钟,有时会在周期之间短暂醒来。意识到让用户了解他们睡眠阶段的价值,我们使用 Soli 扩展了 Nest Hub 的睡眠/清醒算法,以区分浅睡期、深睡期和快速眼动期。

睡眠周期循环

https://www.ncbi.nlm.nih.gov/books/NBK19956/

Soli

https://ai.googleblog.com/2020/03/soli-radar-based-perception-and.html

我们使用了一种与 Nest Hub 原始睡眠检测算法大体相似的设计:处理原始雷达样本的滑动窗口以产生声谱图特征,并将这些特征连续馈送至 Tensorflow Lite 模型。关键区别在于,这种新模型经过训练,可以预测睡眠阶段,而不是简单的睡眠/清醒状态,也因此需要新数据和更复杂的训练过程。

原始睡眠检测算法

https://ai.googleblog.com/2021/03/contactless-sleep-sensing-in-nest-hub.html

Tensorflow Lite

https://tensorflow.google.cn/lite

为了汇编适合训练高性能 ML 模型的丰富数据集,我们利用现有的非雷达数据集并应用迁移学习 (Transfer learning) 技术来训练模型。识别睡眠阶段的黄金标准是多导睡眠图 (Polysomnography, PSG),它采用一系列可穿戴传感器来监测睡眠期间的多种身体功能,例如脑部活动、心跳、呼吸、眼球运动和移动。然后,这些信号可以由训练有素的睡眠技术人员进行解析,以确定睡眠阶段。

为了开发模型,我们使用了来自睡眠心脏健康研究 (SHHS) 和多种族动脉粥样硬化研究 (MESA) 的公开数据,还有来自国家睡眠研究资源的超过 10,000 时段原始 PSG 传感器数据以及相应的睡眠阶段参照标准标签。这些 PSG 数据集中的胸部呼吸感应体积描记法 (Respiratory Inductance Plethysmography, RIP) 传感器数据通过佩戴在患者胸部周围的带子收集,用来测量呼吸引起的运动。虽然这是一种与雷达截然不同的感知模式,但 RIP 和雷达都能提供可用于表现参与者呼吸和运动的信号。这两种模式间的相似性使得利用基于体积描记法的模型,并让其适应雷达成为可能。

睡眠心脏健康研究

https://sleepdata.org/datasets/shhs

多种族动脉粥样硬化研究

https://sleepdata.org/datasets/mesa/pages/README.md

国家睡眠研究资源

https://sleepdata.org/

为此,我们首先根据 RIP 时间序列信号计算声谱图,将其用作特征来训练卷积神经网络 (Convolutional Neural Network, CNN) 以预测真实睡眠阶段。该模型成功学会了识别 RIP 信号中的呼吸和运动模式,这可用来区分不同的睡眠阶段。这表明,在使用基于雷达的信号时,该模型应该同样可行。

为了测试该模型的通用性,我们替换了根据 Nest Hub 的 Soli 传感器计算的类似声谱图特征,并评估了该模型泛化至不同感知模式的能力。正如预期的那样,当使用雷达传感器数据时,通过体积描记传感器训练出的预测睡眠阶段的模型,其准确性要低得多。然而,该模型仍然比随机模型的表现好得多,这表明它已经学习了在两种模式下都相关的特征。

为了改进这一点,我们收集了一个较小的雷达传感器数据的二级数据集(带有相应的基于 PSG 的真实睡眠阶段标签),然后使用该数据集的一部分来微调初始模型的权重。少量的额外训练数据让模型能够适应它从基于体积描记法的睡眠阶段学到的原始特征,并成功将它们泛化至我们的模式。在对从未见过的新雷达数据测试集进行评估时,我们发现微调后的模型产生的睡眠阶段结果和其他消费级睡眠追踪器产生的结果相当。

自定义 ML 模型有效地处理连续的 3D 雷达张量流(如图顶部的声谱图所示),以自动计算每个睡眠阶段(REM、浅睡和深睡)的概率,或者检测用户是否醒着或烦躁不安

基于 Soil 的睡眠跟踪为用户了解睡眠量以及睡眠中断发生的时间提供了方便可靠的方法。然而,要了解和改善睡眠,用户也需要了解导致睡眠中断的原因。我们先前讨论过了 Nest Hub 如何帮助监测咳嗽和打鼾,这些是人们通常意识不到的睡眠干扰因素的常见来源。为了更深入地了解这些干扰因素,知道检测到的打鼾和咳嗽声是否来自自己很重要。

先前讨论过了

https://ai.googleblog.com/2021/03/contactless-sleep-sensing-in-nest-hub.html

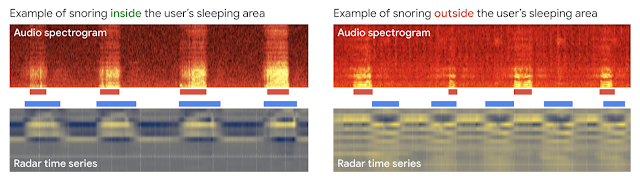

Nest Hub 的原始算法使用基于 CNN 的设备端检测器来处理 Nest Hub 的麦克风信号并检测咳嗽或打鼾事件,但这种纯音频方法并未尝试区分声音的来源。通过将音频感知与基于 Soli 的运动和呼吸提示相结合,我们更新了算法,将用户指定睡眠区域的睡眠干扰因素和房间内其他声音来源分离开。例如,当主用户打鼾时,音频信号中的鼾声会与 Nest Hub 雷达传感器检测到的吸气和呼气密切对应。反之,当鼾声是在校准睡眠区之外检测到的,这两个信号将独立变化。当 Nest Hub 检测到咳嗽或打鼾,但确定音频和运动特征之间的相关性不足时,它会将这些事件从用户的咳嗽或打鼾时间线中排除,并在 Nest Hub 的显示屏上将它们标记为“其他声音”。更新后的模型依旧完全使用设备端音频处理,并采用隐私保护分析,不会将原始音频数据发送到 Google 服务器。然后,用户可以选择将处理结果(声音出现信息,如咳嗽次数和打鼾分钟数)保存在 Google Fit 中,以便查看一段时间内个人夜间的健康状况。

和用户呼吸模式同步的打鼾声(左)会显示在用户的 Nest Hub 鼾声时间线上。和用户呼吸模式不一致的打鼾声(右)会显示在 Nest Hub“其他声音”时间线上

自从 Nest Hub(支持睡眠感知)推出以来,研究人员对使用 Nest Hub 的夜间咳嗽数字量化进行的调查研究表现出了兴趣。例如,由囊性纤维化基金会2 支持的一项小型可行性研究目前正在进行中,目的是评估在患有囊性纤维化 (CF) 儿童的家庭中使用 Nest Hub 测量夜间咳嗽的可行性。囊性纤维化 (CF) 是一种罕见的遗传性疾病,可导致由肺部粘液引起的慢性咳嗽。研究人员正在探索量化夜间咳嗽是否可以作为监测治疗反应的替代方法。

Nest Hub(支持睡眠感知)推出

https://blog.google/products/google-nest/new-nest-hub-soli/

基于保护隐私的雷达和音频信号,Nest Hub 上这些改进的睡眠阶段区分和音频感知功能提供了更深入的数据分析,我们希望这些数据分析能帮助用户根据他们的夜间健康状况,实现可行的整体健康改善。

这项研究是多学科团队通力合作的成果,其中包括软件工程师、研究人员、临床医生和跨职能贡献者。特别感谢睡眠神经学家 Logan Schneider 博士,他宝贵的临床专业知识和贡献持续性地指导了这项研究。除作者外,本研究的主要贡献者还包括 Anupam Pathak、Jeffrey Yu、Arno Charton、Jian Cui、Sinan Hersek、Jonathan Hsu、Andi Janti、Linda Lei、Shao-Po Ma、Jo Schaeffer、Neil Smith、Siddhant Swaroop、Bhavana Koka、Jim Taylor 博士,以及整个团队。感谢 Mark Malhotra 和 Shwetak Patel 的持续领导,并感谢 Nest、健身、和 Google 助理团队与我们合作,在 Nest Hub 上构建和验证这些睡眠感知增强功能。

[1] 并非用于诊断、治愈、缓解、预防或治疗任何疾病或病症

[2] Google 没有参与任何研究设计、执行和投资

点击“阅读原文”访问 TensorFlow 官网

不要忘记“一键三连”哦~

分享

点赞

在看