【伯克利】通过增大模型加速Transformer训练和推理

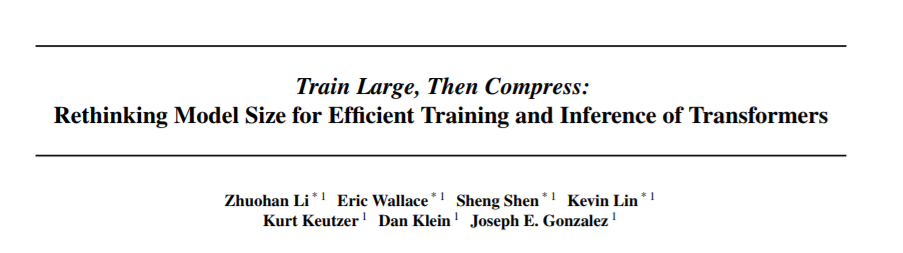

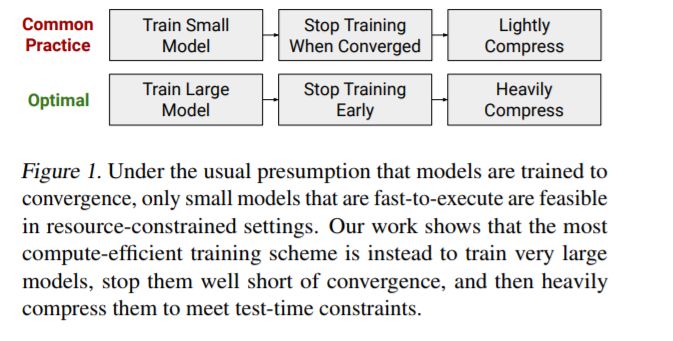

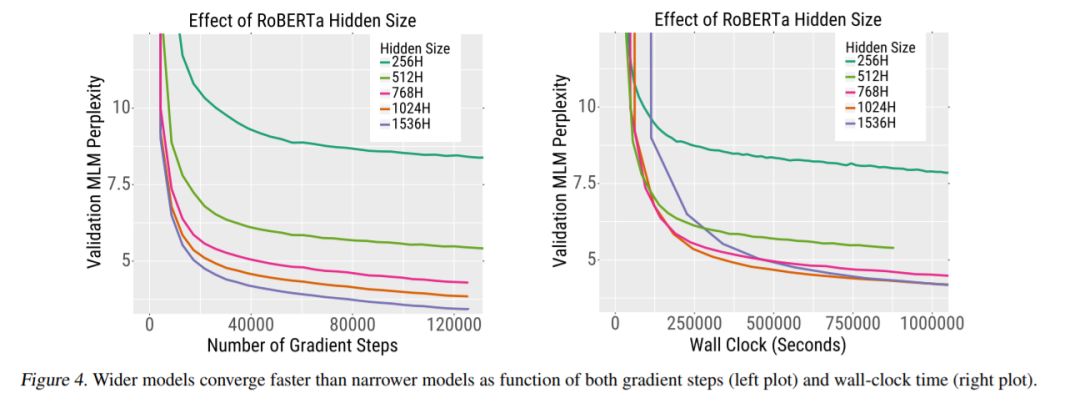

由于硬件资源有限,训练深度学习模型的目标通常是在训练和推理的时间和记忆约束下使准确性最大化。在这种情况下,我们研究了模型大小的影响,重点研究了受计算限制的NLP任务的Transformer模型:自我监督的预训练和高资源机器翻译。我们首先表明,尽管较小的Transformer模型在每次迭代中执行得更快,但是更广泛和更深入的模型在更少的步骤中收敛。此外,这种收敛速度通常超过使用大型模型的额外计算开销。因此,最具计算效率的训练策略是反直觉地训练非常大的模型,但是在少量的迭代之后停止。

这导致大型Transformer 模型的训练效率与小型Transformer 模型的推理效率之间存在明显的权衡。然而,我们证明大型模型比小型模型对量化和剪枝等压缩技术有更强的鲁棒性。因此,我们可以同时利用两个方面的优势:高度压缩的大型模型比轻度压缩的小型模型获得更高的精度。

https://bair.berkeley.edu/blog/2020/03/05/compress/

https://www.zhuanzhi.ai/paper/7104b616141a0bd6b6fa928303769e8b

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复“ETI” 就可以获取《伯克利—通过增大模型加速Transformer训练和推理》专知下载链接

登录查看更多

相关内容

Arxiv

16+阅读 · 2020年3月30日

Arxiv

15+阅读 · 2018年10月11日