ResNet才是YYDS!新研究:不用蒸馏、无额外数据,性能还能涨一波

©作者 | 杜伟、张倩

来源 | 机器之心

基线:我要是用上最新的训练流程,性能还能涨一波。

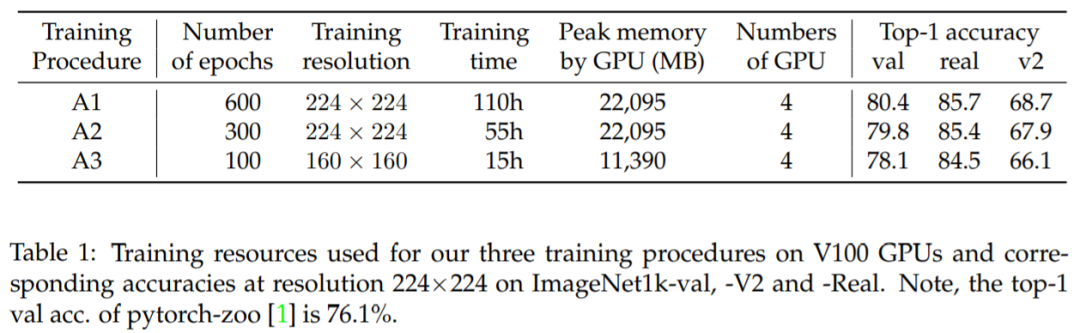

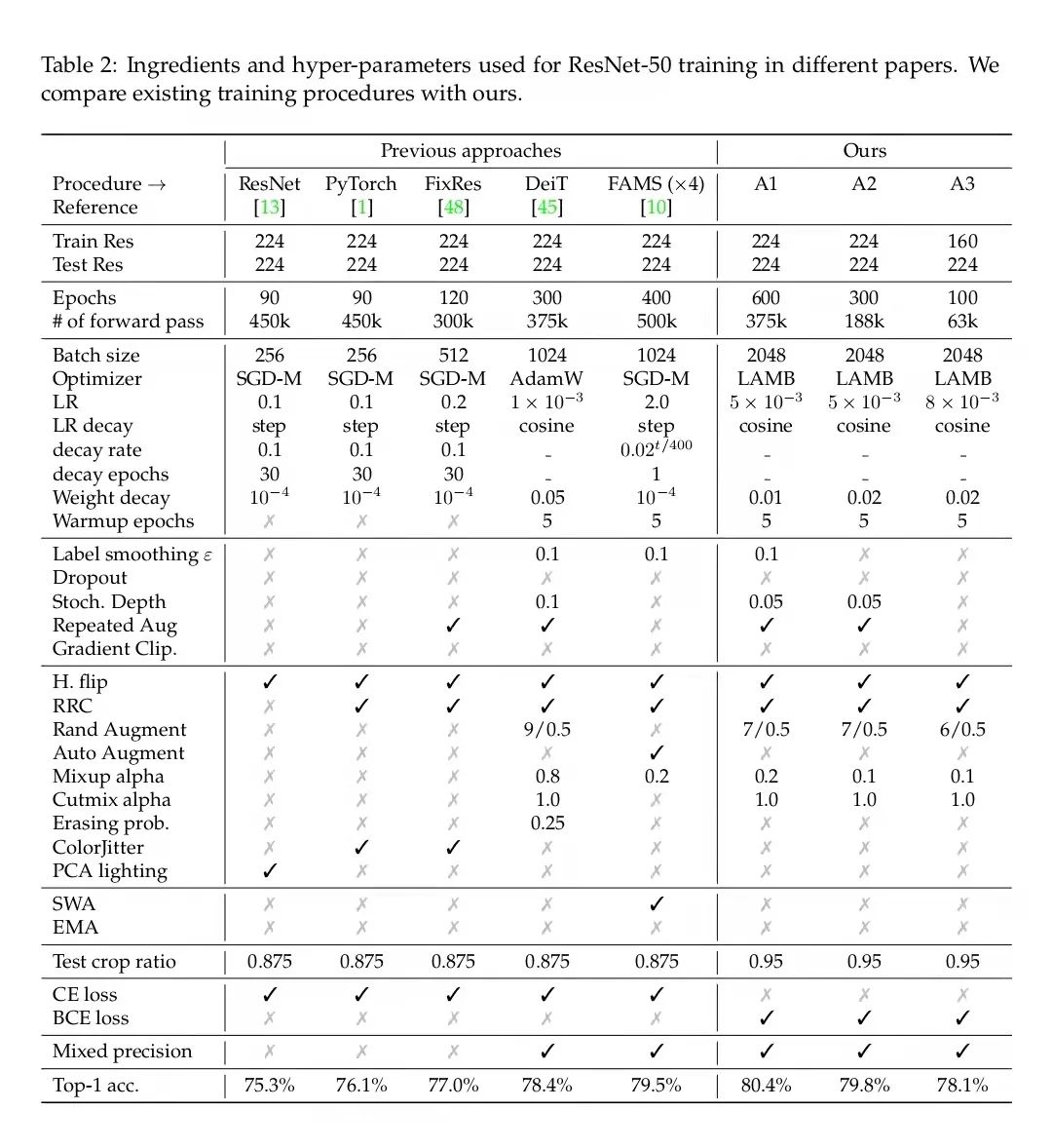

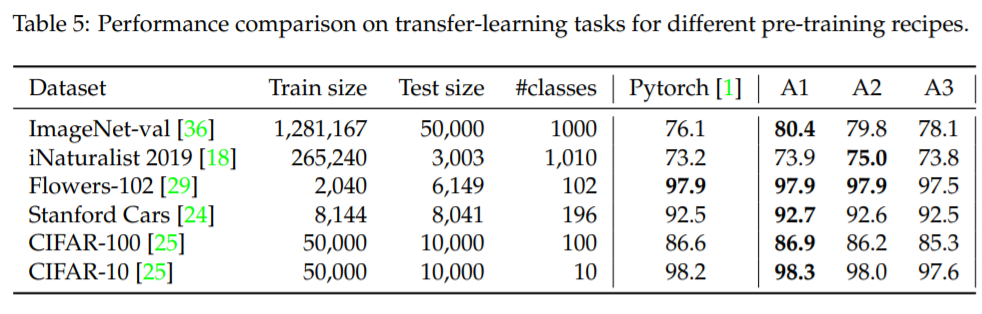

流程 A1 旨在为 ResNet-50 提供最佳性能,因此 epoch 数量最多(600),训练时间最长(在一个配有 4 个 V100 32GB GPU 的节点上训练 4.6 天)

流程 A2 的 epoch 数量为 300,可与 DeiT 等其他几个优秀训练流程媲美,但批大小更大(2048)。

流程 A3 旨在通过 100 个 epoch 和 2048 的批大小超越普通 ResNet-50 的流程,它在 4 个 V100 16GB GPU 上训练了 15 个小时,并且可能是探索性研究的良好设置。

#投 稿 通 道#

让你的文字被更多人看到

如何才能让更多的优质内容以更短路径到达读者群体,缩短读者寻找优质内容的成本呢?答案就是:你不认识的人。

总有一些你不认识的人,知道你想知道的东西。PaperWeekly 或许可以成为一座桥梁,促使不同背景、不同方向的学者和学术灵感相互碰撞,迸发出更多的可能性。

PaperWeekly 鼓励高校实验室或个人,在我们的平台上分享各类优质内容,可以是最新论文解读,也可以是学术热点剖析、科研心得或竞赛经验讲解等。我们的目的只有一个,让知识真正流动起来。

📝 稿件基本要求:

• 文章确系个人原创作品,未曾在公开渠道发表,如为其他平台已发表或待发表的文章,请明确标注

• 稿件建议以 markdown 格式撰写,文中配图以附件形式发送,要求图片清晰,无版权问题

• PaperWeekly 尊重原作者署名权,并将为每篇被采纳的原创首发稿件,提供业内具有竞争力稿酬,具体依据文章阅读量和文章质量阶梯制结算

📬 投稿通道:

• 投稿邮箱:hr@paperweekly.site

• 来稿请备注即时联系方式(微信),以便我们在稿件选用的第一时间联系作者

• 您也可以直接添加小编微信(pwbot02)快速投稿,备注:姓名-投稿

△长按添加PaperWeekly小编

🔍

现在,在「知乎」也能找到我们了

进入知乎首页搜索「PaperWeekly」

点击「关注」订阅我们的专栏吧