百度大脑 EasyDL 专业版最新上线自研超大规模视觉预训练模型

-

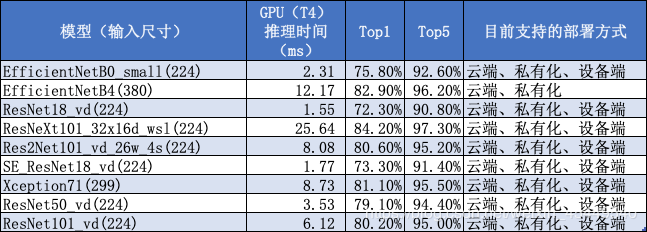

EffcientNetB0_small -

EfficientNetB4 -

MobileNetV3_large_x1_0 -

ResNet18_vd -

ResNeXt101_32x16d_wsl -

Res2Net101_vd_26w_4s -

SE_ResNet18_vd -

Xception71

-

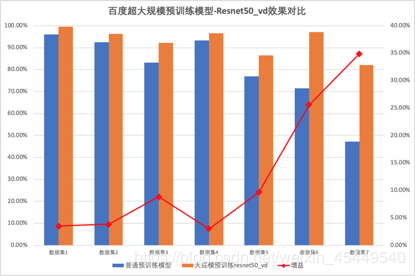

ResNet50_vd -

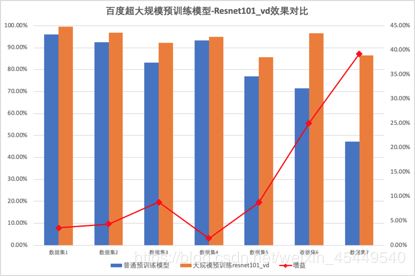

ResNet101_vd -

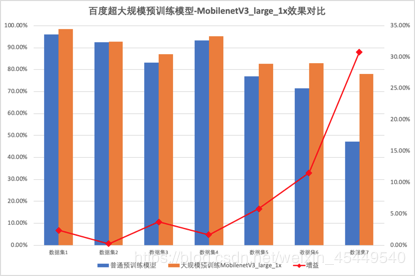

MobileNetV3_large_x1_0

登录查看更多

相关内容

Arxiv

5+阅读 · 2018年1月17日