话到嘴边却忘了?这个模型能帮你 | AAAI 2020

作者 | 岂凡超

编辑 | Camel

本文对清华大学、华为诺亚方舟合作的论文《Multi-channel Reverse Dictionary Model》进行解读。该论文已经被AAAI-20录用。

论文链接:https://arxiv.org/abs/1912.08441

该文关注反向词典问题——即给定对某个词语的描述,希望得到符合给定描述的词语。该文提出了一种受到人的描述→词的推断过程启发的多通道模型,在中英两种语言的数据集上都实现了当前最佳性能(state-of-the-art),甚至超过了最流行的商业反向词典系统。此外,基于该文提出的模型,论文作者还开发了在线反向词典系统,包含首次实现的中文、中英跨语言反向查词功能。

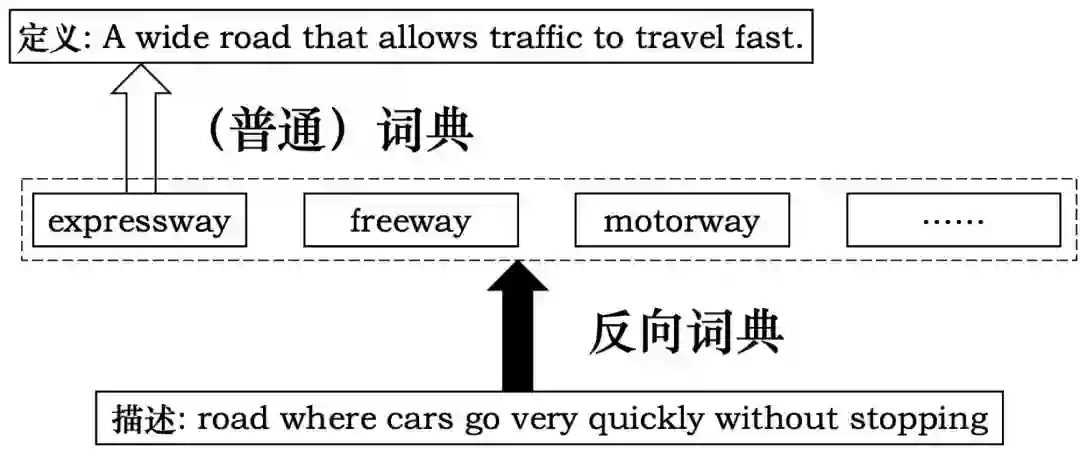

反向词典顾名思义,以对目标词语义的描述为输入,输出目标词以及其他符合描述的词语。

反向词典有重要的实用价值,其最大的用处在于解决舌尖现象(Tip of the tongue)[1],即话到嘴边说不出来的问题——频繁写作的人,如作家、研究人员、学生等经常会遇到这种问题。

此外,反向词典也可以为掌握词汇不多的新语言学习者提供帮助,让他们学习、巩固尚不十分了解的词语。

最后,反向词典还可以帮助选词性命名不能(word selection anomia)[2]的患者——他们知道想说的词语的意思但无法主动说出来。

反向词典同样具有自然语言处理研究价值,比如可以用于评测句子表示学习模型[3],辅助解决问答、信息检索等包含文本到实体映射的任务[4]。

1、相关工作

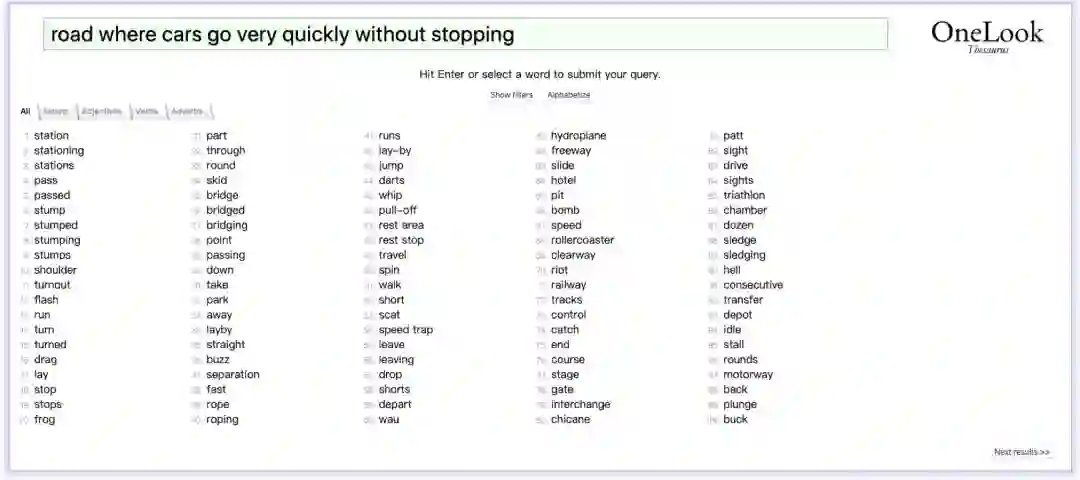

现在已经有一些投入使用的商业化反向词典系统,其中最著名、最流行的是OneLook(https://www.onelook.com/thesaurus/),但其背后的实现原理尚不得知。

在学术研究领域,目前有两类反向词典实现方法。

第一类为基于句子匹配的方法,该方法在数据库中存储足够多的词语及其定义,当进行反向词典查询时,在数据库中检索与输入描述最相似的定义并返回所对应的词语[5-8]。然而反向词典的输入描述非常多变,往往与已存储的词典定义有巨大差别,这种方法很难解决这一问题。

另一类基于神经语言模型的方法由Bengio等人提出[3],该方法使用神经语言模型作为编码器将输入描述编码到词向量空间,返回与之最近的词向量对应的词语。近年来有很多反向词典研究基于这种方法[4, 9-11],尽管这种方法避免了第一类方法面临的输入描述多变导致的性能较差的问题,然而考虑到相当一部分词是低频词,其词向量的学习效果往往较差,在查询这些词时,基于神经语言模型的方法的性能也不甚理想。

2、方法

为了解决第二类方法的问题,受人的描述到词的推断过程的启发,该文提出了多通道反向词典模型。

以图3为例,当人看到“road where cars go very quickly without stopping”这条描述时,除了直接猜目标词以外,还可以推断出目标词应具有的一些特征,比如词性应为名词,词的类型应为实体,以及大概率具有“way”这个词素。

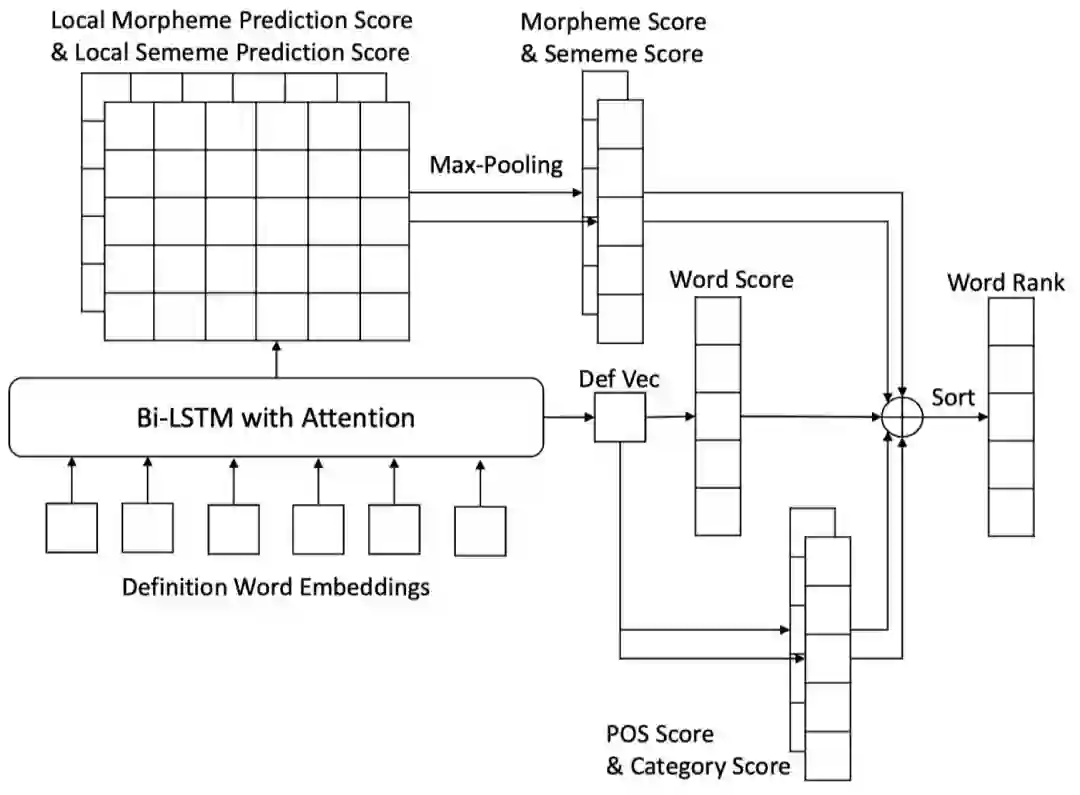

受此启发,该文的模型在对描述编码后直接进行词预测的基础上,额外增加了四个特征预测器。该文将每个特征视作一个信息通道,四个通道可分为两类:

1、内部通道,该类通道预测词本身的特征,包括词性(part-of-speech)和词素(morpheme);

2、外部通道,该类通道预测外部知识库提供的词的特征,包括词类(word category)和义原(sememe)。其中词类信息可由WordNet或同义词词林提供,义原由知网(HowNet)提供。

图4为该文所提模型的图示。该模型以基于注意力机制的双向LSTM对输入定义或描述进行编码得到句子表示,除了用该句子表示直接预测目标词之外,还对目标词的词性(POS)和词类(category)进行预测。而对于另外两个特征词素(morpheme)和义原(sememe)的预测,则采用了不同的方法。

考虑到词的词素或义原和词的描述/定义中的词存在一种局部语义对应关系——如图3中的例子中“expressway”的“express-”与“quickly”、“-way”与“road”分别对应,且义原也有类似的对应关系——因此对于这两个特征的预测,该文用每个词的隐状态(hidden state)分别预测然后对预测分数做max-pooling来得到最终的预测分数。这些特征的预测分数会按一定比例加到符合该特征的词语的预测分数上,得到最终的词语预测分数。

3、实验

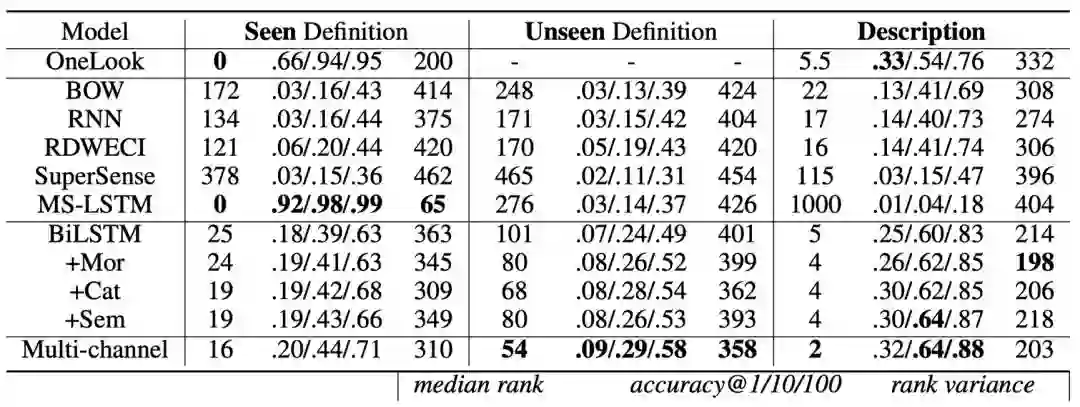

该文在英文、中文多个数据集上进行了实验。对于英文实验,该文使用了前人工作都使用的来自多个英文词典的定义数据集作为训练集,测试集则有3个:

1)见过的词典定义(Seen Definition),由一部分训练集中出现的词典定义构成,这一数据集主要测试模型对以往信息的回忆能力;

2)没见过的词典定义(Unseen Definition),由未在训练集中出现的词典定义构成;

3)人工构造的描述(Description)数据集,该数据集包括人根据给定的词语写出的描述,是最贴合反向词典应用实际的数据集。

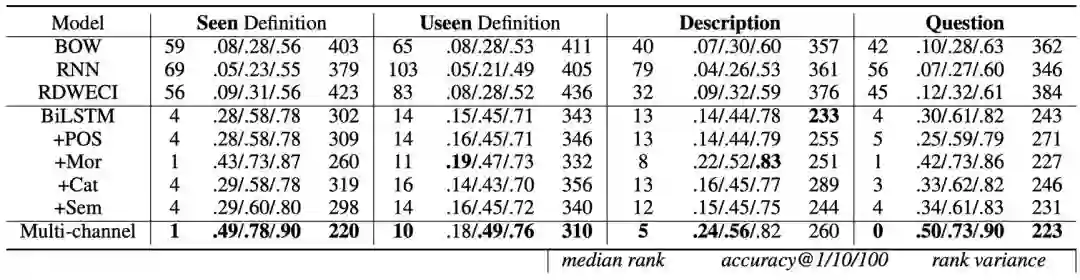

图5给出了英文数据集上的实验结果,可以发现每个特征预测器的增加都会提高模型的效果,而包含所有特征的多通道模型得到了最好的性能,不但超过了此前最佳模型(state-of-the-art) MS-LSTM,而且在真实数据集Description上甚至超过了最流行的反向词典系统OneLook。

图6给出了中文数据集上的实验结果,其中Question数据集包含从互联网搜集的中小学根据描述选择或写出词语的题目。实验结果与英文数据集上的结果类似。

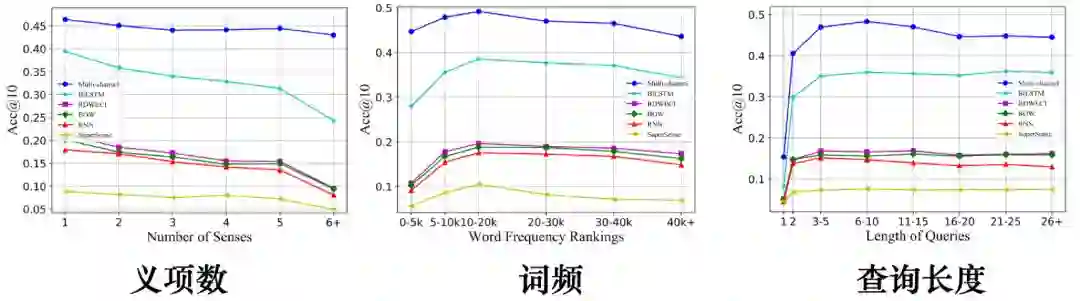

图7 目标词义项数、词频和输入描述对不同模型结果的影响

图7给出了不同模型的性能受目标词义项数、词频和输入描述的影响的结果(以英文数据集为例)。可以看出该文提出的模型有更强的鲁棒性,尤其是对于低频词仍然有很好的预测效果。

4、结论

这篇论文提出一个受人的描述到词的推断过程启发的多通道反向词典模型,其包含词性、词素、词类、义原四个特征预测器,在真实场景数据集上实现了最佳性能。

该文论文已经公开在arXiv:https://arxiv.org/pdf/1912.08441,

代码和数据已经放在GitHub:https://github.com/thunlp/MultiRD,

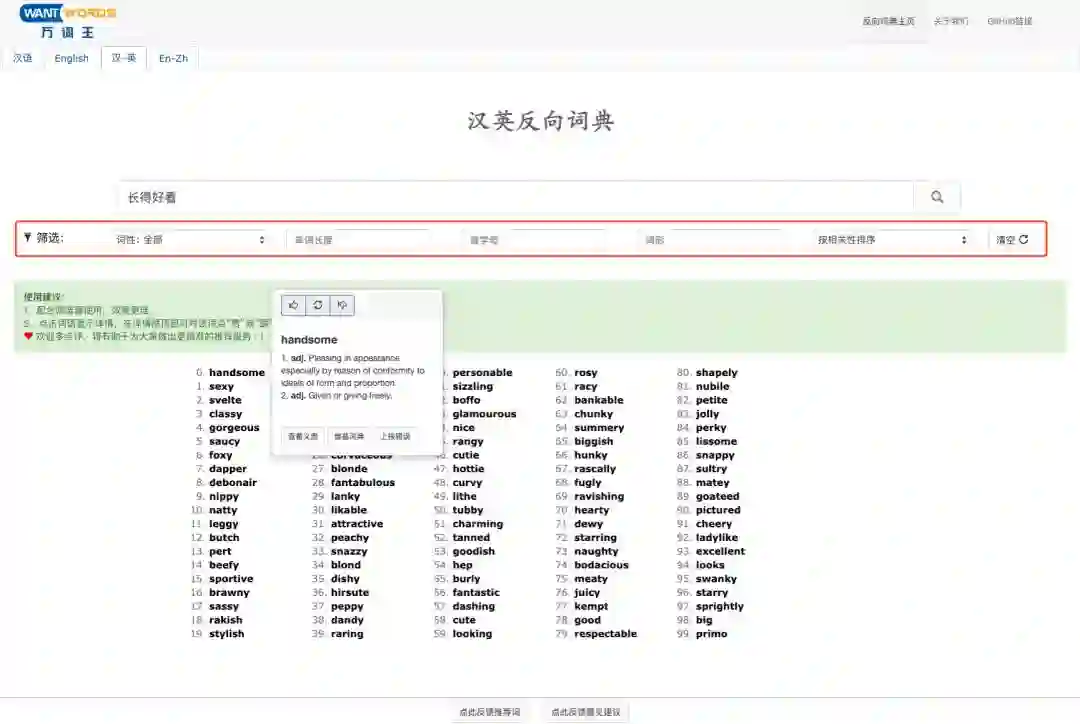

另外基于论文所提模型的在线反向词典系统——万词王(WantWords)也已经上线:https://wantwords.thunlp.org/

如图8所示,该系统不仅支持英文、中文反向查词,还支持英汉、汉英跨语言反向查词,能够显示候选词的词性、定义等基本信息,且支持按照词性、单词长度、词形等对候选词进行筛选,助你更快找到你想要的词。

参考文献

[1] Brown, R., and McNeill, D. 1966. The tip of the tongue phenomenon. Journal of verbal learning and verbal behavior 5(4):325–337.

[2] Benson, D. F. 1979. Neurologic correlates of anomia. In Studies in neurolinguistics. Elsevier. 293–328.

[3] Hill, F.; Cho, K.; Korhonen, A.; and Bengio, Y. 2016. Learning to understand phrases by embedding the dictionary. TACL 4:17–30.

[4] Kartsaklis, D.; Pilehvar, M. T.; and Collier, N. 2018. Mapping text to knowledge graph entities using multi-sense LSTMs. In Proceedings of EMNLP.

[5] Bilac, S.; Watanabe, W.; Hashimoto, T.; Tokunaga, T.; and Tanaka, H. 2004. Dictionary search based on the target word description. In Proceedings of NLP.

[6] Zock, M., and Bilac, S. 2004. Word lookup on the basis of associations: from an idea to a roadmap. In Proceedings of the Workshop on Enhancing and Using Electronic Dictionaries.

[7] Méndez, O.; Calvo, H.; and Moreno-Armend´ariz, M. A. 2013. A reverse dictionary based on semantic analysis using wordnet. In Proceedings of MICAI.

[8] Shaw, R.; Datta, A.; VanderMeer, D. E.; and Dutta, K. 2013. Building a scalable database-driven reverse dictionary. IEEE Transactions on Knowledge and Data Engineering 25:528540.

[9] Morinaga, Y., and Yamaguchi, K. 2018. Improvement of reverse dictionary by tuning word vectors and category inference. In Proceedings of ICIST.

[10] Hedderich, M. A.; Yates, A.; Klakow, D.; and de Melo, G. 2019. Using multi-sense vector embeddings for reverse dictionaries. In Proceedings of IWCS.

[11] Pilehvar, M. T. 2019. On the importance of distinguishing word meaning representations: A case study on reverse dictionary mapping. In Proceedings of NAACL.

100000AI人才为你投票,企业扫码报名