人民大学提出听音识物AI框架,不用人工标注,嘈杂环境也能Hold住,还可迁移到物体检测

明敏 发自 凹非寺

量子位 | 公众号 QbitAI

不用人工标注,也能让AI学会听音寻物。

还能用在包含多种声音的复杂环境中。

比如这个演奏会视频,AI就能判断出哪些乐器在发声,还能定位出各自的位置。

这是中国人民大学高瓴人工智能学院最近提出的新框架。

对于人类而言,听音识物是一件小事,但是放在AI身上就不一样了。

因为视觉和音频之间对应关系无法直接关联,过去算法往往依赖于手动转换或者人工标注。

现在,研究团队使用聚类的方法,让AI能够轻松识别各种乐器、动物以及日常生活中会出现的声音。

同时,这一方法还能迁移到无监督的物体检测任务中,其成果被发表在《IEEE Transactions on Pattern Analysis and Machine Intelligence》 (TPAMI)。

构建物体视觉表征字典

具体来看这个框架,可以分为两个阶段:

在第一阶段,AI要在单一声源场景中学习物体的视觉-音频表征;然后再将这一框架迁移到多声源场景下,通过训练来辨别更多的声源。

通俗一点来讲,就是让AI先能把一种声音和其声源物体的样子联系起来,然后再让它在“大杂烩”里分辨不同的种类。

以听音乐会举例。

研究人员喂给AI的都是乐器独奏视频,可能包含大提琴、萨克斯风、吉他等等。

然后运用聚类的方法,让AI把所有的样本进行划分。聚类的每一个簇,被认为能够代表一种语义类别的视觉表征集合。

由此一来,AI便在无形之中掌握了不同乐器在外观和声音上的关系,也就是可以听音识物了。

在这个过程中,研究人员针对每个簇进行特征提取并打上伪标签,可以构建出一个物体视觉表征字典。

第二阶段中,研究人员让这个框架先能从视觉方面定位出画面中存在的不同物体,然后再根据声音信息过滤掉不发声物体。

其中,定位物体这一步用到了第一阶段中得出的物体视觉表征字典。

具体来看,对于某一帧多声源的场景,AI会先从画面中提取到不同物体的特征,然后再和字典中的各个类别比对,从而完成听音识物的初步定位。

之后,将画面中存在物体的定位结果与发声区域进行哈达玛积,过滤掉不发声的物体,同时还能细化发声物体的定位结果。

从直观识别效果中看,该方法能够很好辨别画面中的发声物体,而且在视觉识别准确度上表现也更好。

△每行前3张为真实演奏场景,后4张为合成场景

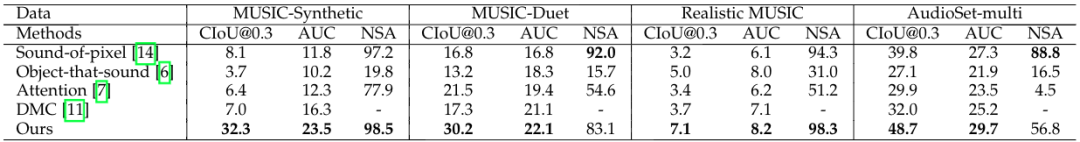

在具体表现上,研究人员分别使用了合成音乐、二重奏等4个数据集来测试这个框架识别的水平。

结果显示,此次提出的新方法表现都非常nice,尤其是在乐器分布更加均衡的数据集上。

那么不听音乐、只听日常的声音,表现又会如何呢?

作者分别展示了成功和失败的一些例子:

△一些成功案例

△一些失败案例

作者表示,出现失败的情况中,一方面是无法定位到正确的声源位置(如上图第一行)。

还有一些是不能辨别某些场景中的特定声音(如上图第二行)。

此外,这种方法还能迁移到物体检测任务中去。比如在ImageNet子集上的无监督物体检测表现也值得关注。

团队主要来自人大AI学院

本项研究由中国人民大学高瓴人工智能学院主导,通讯作者为GeWu实验室胡迪助理教授,主要内容由GeWu实验室博士生卫雅珂负责。

胡迪于2019年博士毕业自西北工业大学,师从李学龙教授。曾荣获2020年中国人工智能学会优博奖,受中国科协青年人才托举工程资助。

主要研究方向为机器多模态感知与学习,以主要作者身份在领域顶级国际会议及期刊上发表论文20余篇。

中国人民大学文继荣教授也参与了此项研究。

他目前为中国人民大学高瓴人工智能学院执行院长、信息学院院长。

主要研究方向为信息检索、数据挖掘与机器学习、大模型神经网络模型的训练与应用。

论文地址:

https://arxiv.org/abs/2112.11749

项目主页:

https://gewu-lab.github.io/CSOL_TPAMI2021/

— 完 —

本文系网易新闻•网易号特色内容激励计划签约账号【量子位】原创内容,未经账号授权,禁止随意转载。

直播报名 | 如何建立AI生态的“Android”

从感知到认知,AI还需要多久才能触及生产核心?从软件到数件,AI生态该如何建立自己“Android”?

3月16日19:30,「量子位·视点」CEO/CTO系列分享活动将邀请天云数据CEO雷涛直播分享个人见解。扫码预约直播围观吧~

量子位 QbitAI · 头条号签约作者

վ'ᴗ' ի 追踪AI技术和产品新动态

一键三连「分享」「点赞」和「在看」

科技前沿进展日日相见 ~