ECCV 2020 目标跟踪论文大盘点

极市导读

本文盘点了ECCV 2020中的目标跟踪相关研究,包括一部分业内非常知名的工作,值得关注。>>加入极市CV技术交流群,走在计算机视觉的最前沿

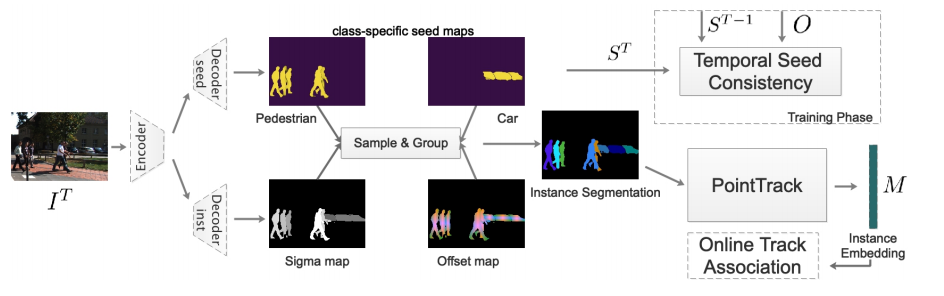

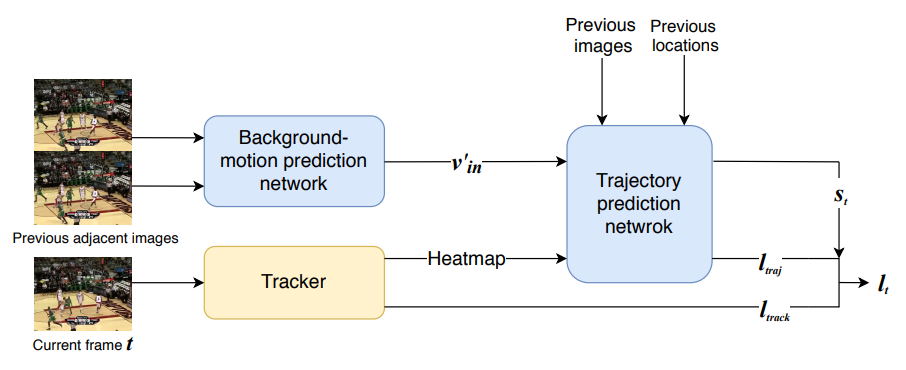

多目标跟踪 MOT

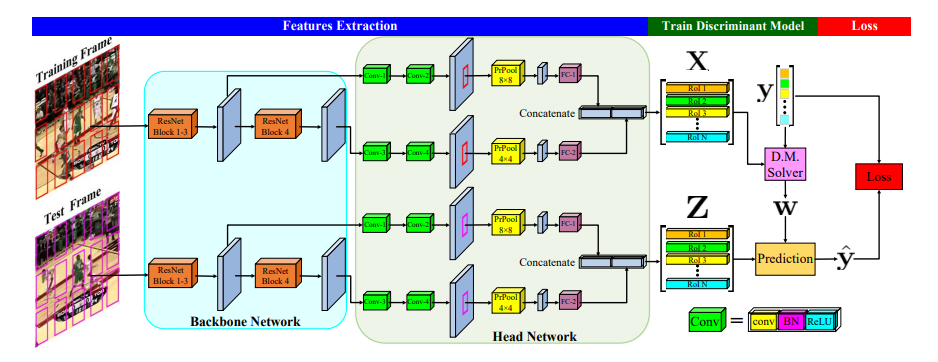

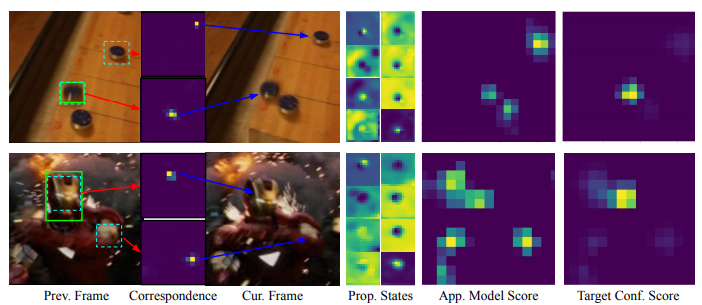

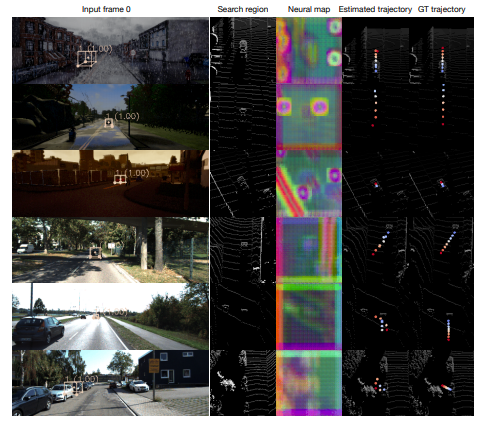

单目标跟踪

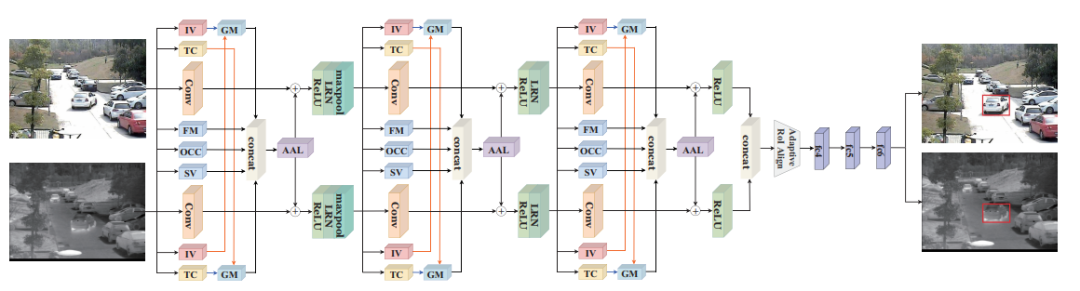

RGBT 跟踪

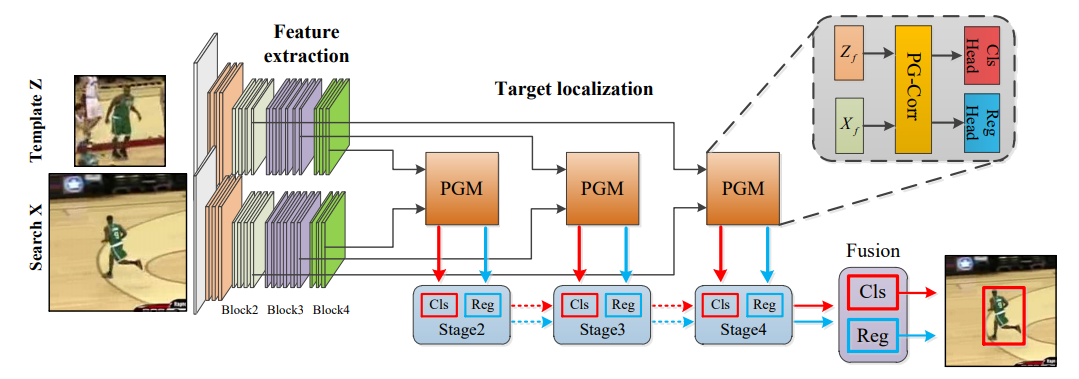

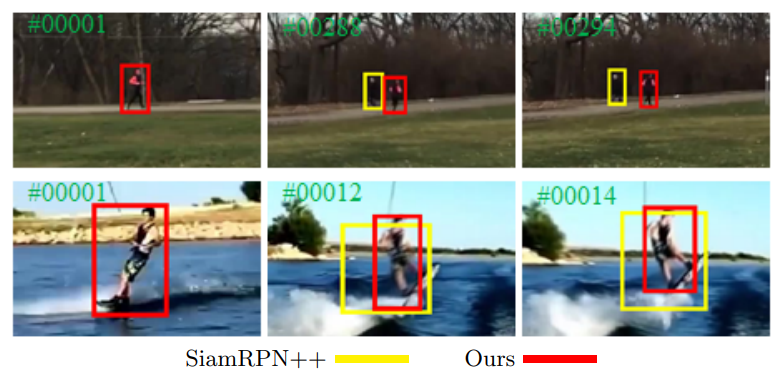

Anchor-free 跟踪

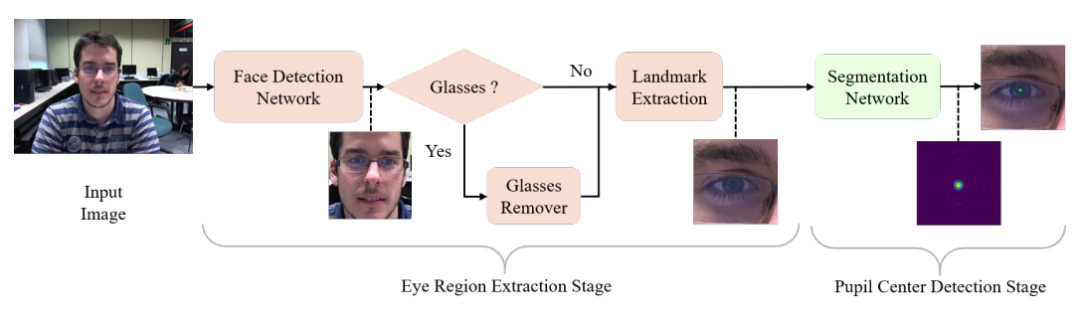

远程眼动跟踪

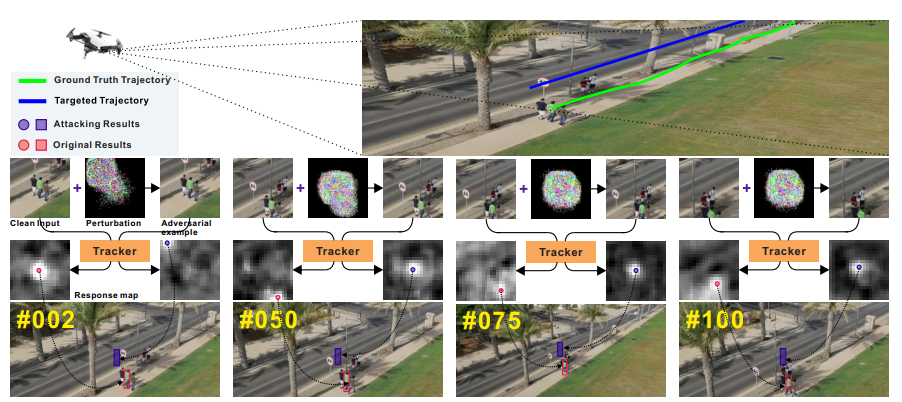

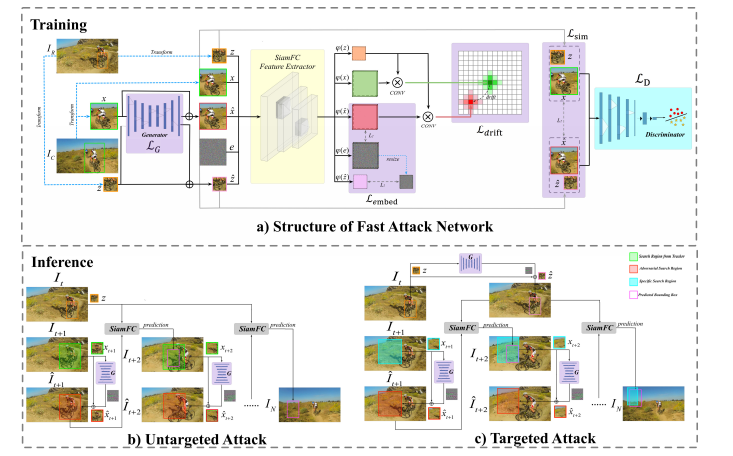

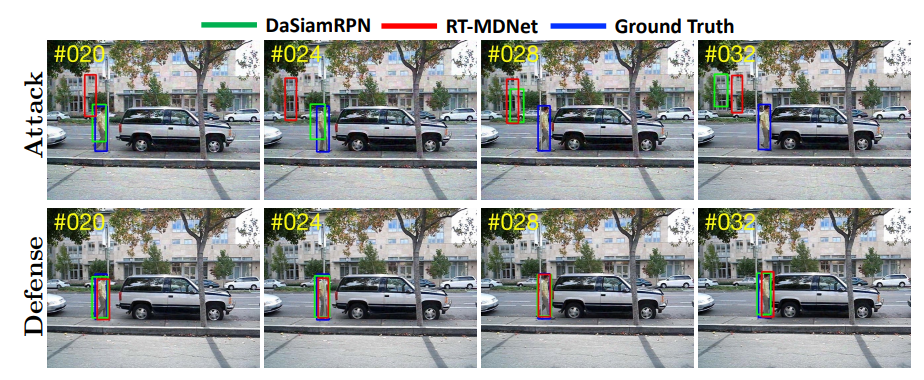

对抗学习+目标跟踪

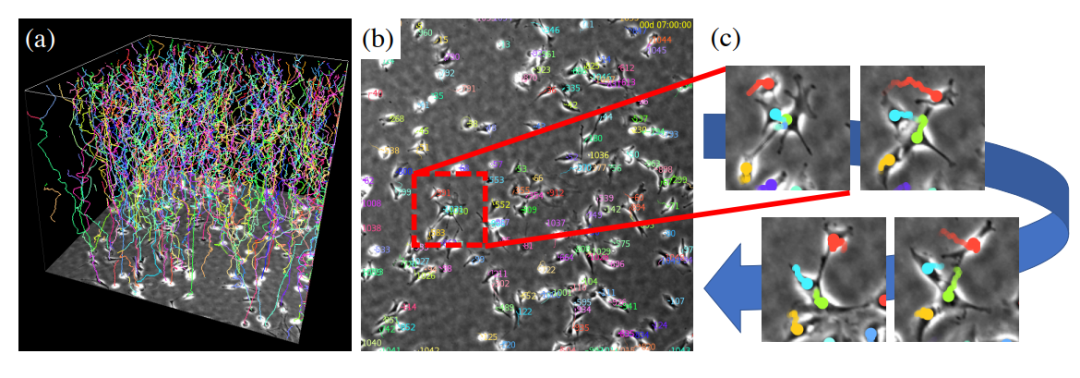

细胞跟踪

数据集

推荐阅读

登录查看更多

相关内容

标跟踪是指:给出目标在跟踪视频第一帧中的初始状态(如位置,尺寸),自动估计目标物体在后续帧中的状态。

目标跟踪分为单目标跟踪和多目标跟踪。

人眼可以比较轻松的在一段时间内跟住某个特定目标。但是对机器而言,这一任务并不简单,尤其是跟踪过程中会出现目标发生剧烈形变、被其他目标遮挡或出现相似物体干扰等等各种复杂的情况。过去几十年以来,目标跟踪的研究取得了长足的发展,尤其是各种机器学习算法被引入以来,目标跟踪算法呈现百花齐放的态势。2013年以来,深度学习方法开始在目标跟踪领域展露头脚,并逐渐在性能上超越传统方法,取得巨大的突破。