ACL 2020 | 最佳主题论文奖“ 迈向NLU:关于数据时代的意义、形式和理解”

本文主要着重分析今年的 Best Theme Paper,文章题目为 Climbing towards NLU: On Meaning, Form, and Understanding in the Age of Data(迈向 NLU:关于数据时代的意义、形式和理解),文章的作者是来自华盛顿大学的 Emily M. Bender 及萨尔兰大学的 Alexander Koller。

研究背景

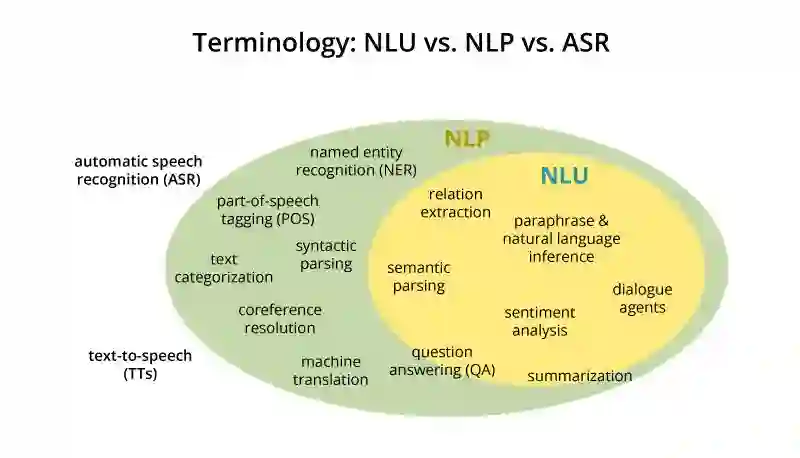

由于语言建模任务只使用形式作为训练数据,原则上不能引导模型对语言意义的学习。“ 语言模型(LM) ”这个术语指的是任何只对字符串预测任务进行训练的系统,无论它是在字符、单词还是句子上的操作,也无论是否按顺序操作。语言的意义是一种语言形式和交际意图之间的关系。

大型神经语言模型在许多自然语言处理任务上的成功是令人兴奋的。然而,研究发现这些成功有时会导致炒作,其中这些模型被描述为 “ 理解 ” 语言或捕捉 “ 意义 ” 。在这篇论文的观点中,作者认为,一个只在形式上训练的系统在先验上是没有办法学习到意义的。明确理解形式和意义之间的区别,将有助于引导该领域朝着围绕自然语言理解的科学方向更好地发展。

来源: https://nlp.stanford.edu/~wcmac/papers/20140716-UNLU.pdf

虽然大型神经语言模型 LMs 很可能最终成为全面解决 NLU 的重要组成部分,但是对于这个巨大的挑战,至今还没有现成的解决方案。

NLU 领域的真正进展是攀登正确的山坡,而不仅仅是目前所处的山坡,这取决于围绕大局观念保持清晰度,例如任务设计中的意义和理解以及实验结果的报告。

大型神经语言模型 LMs 的炒作与分析

尤其是在学术论述中,如果不慎使用术语会产生严重的后果,可能会助长大众媒体对人工智能的炒作。随着 NLP 越来越被大众所知晓,极其应用范围的不断扩大,准确地体现系统的实际能力显得越来越重要。在某些情况下,自然语言处理领域的专家在与媒体交谈时应当适当地谨慎些,正如《纽约时报》的这两段引文所述:

-

这些系统离真正理解流水散文还有很长的路要走。 -

虽然 BERT 模型通过了实验室的常识测试,但机器离人类常识的人工版本还有很大的距离。

然而,他们成功引发了一个旨在回答这个问题的分支学科 BERTology 。探究任务方法的研究表明,LMs 至少学习了一些关于英语主谓一致性、构成类型、依赖标签、NER 和 ( 核心 ) 语义角色类型等内容。

根据前人研究总结发现, LMs 可以学习语言形式结构的各个方面,但系统在训练中还是只停留于形式,原则上无法学习语言的意义。

意义的定义

“ 形式 ” 是任何可观察到的语言所表述内容的一种实现,比如页面上的标记、数字文本表征中的像素或字节、发音器的运动:

“ 意义 ” 是形式与语言之外的事物之间的关系。

1 意义与交际意图

人类使用语言是有目的的,我们说话不是为了使发音器官快乐的振动,而是为了达到一些 交际意图 。交际意图有很多种:可能是为了向对方传递一些信息,亦或是要求对方做某件事,也可能只是为了社交。当我们说 “ Open the window !或 When was Malala Yousafzai born ? ” 时,交际意图是建立在对话双方共同居住的现实世界中。当然,交际意图也可以是关于抽象世界的,如银行账户、计算机文件系统,或者是说话人心中的一个纯粹的假设世界。

在文中,作者将语言的意义 M 看作是自然语言表达式 E 和交际意图 I 之间的一种关系,将语言系统的常规意义 C 看作是自然语言表达式 E 和固定意义 S 之间的一种关系。

语言学家将交际意图与常规的意义区分开来,对于一个单词、短语或句子的表达,其常规意义在所有可能的使用语境中是不变的。常规意义是一个抽象的对象,它代表了一种形式的交际潜力,给定了它所出自的语言系统。

当我们努力理解 NLU 任务和系统在这些任务上的表现是如何与构建模拟人类自然语言理解系统的更大目标相关联时,干净利落地区分形式、常规意义和交际意图是很有用处的。

作者认为,纯粹以形式为基础进行训练的自然语言模型是无法学习意义的,如果训练数据只是形式,那么就没有足够的信号来学习该形式与人类语言使用者的非语言意图之间的关系 ,也没有足够的信号来学习形式与语言系统赋予每个形式的常规意义之间的关系。

2 意义和智慧

长期以来,意义和理解被视为智能的关键。正如图灵提出的那样,如果一个机器在与人类进行任意的书面对话后,人们无法分辨出他是人还是机器,就可以说机器是会思考的。 然而,人类很快就会把意义甚至是智慧归结到人工代理上,大众对于 ELIZA 软件形成依恋也就证明了这一点。

这意味着我们在设计对机器理解的评价时必须格外小心,正如著名哲学家 Searle 在他的 "中文房间 " 实验中所阐述的那样,他发展了一个系统的隐喻,在这个系统中,一个不会说中文的人通过查阅一个中文书库,按照预定义的规则回答中文问题,甚至在这个系统内部有实际理解的情况下,系统看似也能理解中文。

最近自然语言处理的很多工作都宣称要构建系统,不仅是运行环境系统,事实上构建系统的过程也只涉及形式。 语言是用来交流说话者所处真实的物理或精神世界的,而产生有意义的回应背后的推理必须将感知输入的意义与这个世界的信息联系起来。 这也意味着,如果我们希望和机器交流,就需要在和我们自己尽可能相似的环境中训练他们,且不能仅仅是对话!

在文中,为了说明仅从形式上学习意义所面临的挑战,作者以一个 “ 章鱼测试 ” 的情景进行阐述。位于两个独立岛屿上的 A 和 B ,通过水下电缆相互交流,一个超智能的深海章鱼 O 在监听了一段时间他们的谈话以后,冒充 B 和 A 谈话。尽管 O 学习了许多 A 与 B 之间的对话形式,并利用语言形式的统计规律性,在一些日常交流上没有问题,但 O 并未真正学习到语言的意义,因此当 A 遇到需要 O 提供建议、解决危急问题的时候,O 就显得有些无力。

这个实验表明,人类交流所使用的的语言是有交际意图的,通过语言的意义关系投射到语言形式上,如果机器不能获得假设和检验底层交际意图的手段,仅从形式中重建交际意图,是无法像人类一样进行对话。章鱼测试也表明 机器在学习人类对话的过程中,不仅要学习完整的交际系统,还要学习如何推理出既连贯又对现实世界有帮助的答案,需要进行语言形式和意义的双重学习。

人类语言的习得

语言系统的习得过程,就像人类的交流一样,依赖于共同的注意和主观间性,即能够意识到另一个人类在注意什么,并猜测他们打算交流什么。 儿童不会只从形式中学习意义,我们也不应该期望机器能做到这一点。

分布式语义

关于攀登正确的山丘

可以从两个不同的角度来看待一个领域的进展。

-

从自下而上的角度看,科学界的努力是通过确定具体的研究挑战来推动的。如果一项科学成果至少部分地解决了这样一个具体的挑战,那么它就算得上是一种成功。只要这种成功经常出现并令人满意,就会形成持续进步的总体氛围。

-

从自上而下的角度看,人们关注的是 “ 为整个领域提供一个完整的、统一的理论 ” 这一遥远的终极目标。这种观点招致了人们对尚未完全解释所有现象的焦虑,并提出 “ 自下而上的进展是否将我们引向正确方向?” 这样的问题。

毫无疑问,NLP目前正处于快速爬坡的过程中,技术更新迭代迅速,我们从自下而上的角度来看,一切都很顺利。但从自上而下的角度来看,问题是我们正在迅速攀登的山丘是否是正确的山丘?

爬山诊断

为减少在攀登 NLP 领域的山峰的过程中,出现方向错误的问题,作者提出了以下最佳做法:

-

最重要的是,培养对语言的谦逊态度,提出自上而下的问题。神经方法不是 NLP 中第一个自下而上的成功,它们可能也不会是最后一个。 -

意识到任务的局限性。 -

重视并支持精心创建新任务的工作。 -

评估跨任务的意义模型。固定意义是与任务无关的,所以一个能够捕捉意义的系统应该在多个任务上表现良好。 -

对系统的错误和成功都要进行彻底的分析。

这篇文章提出了一种观点,即与当前的一些炒作相反, 意义不能仅仅从形式中学习 。这意味着,即使是像 BERT 这样的大型语言模型也不能学习意义,它们学习的是意义在语言形式中的一些反映,这在应用中非常有用。 作者希望借此文鼓励自然语言处理领域有一个自上而下的视角,帮助研究人员在攀登 NLP 领域的高峰时,能够选择正确的山丘,向人类模拟 NLU 攀登。

论文地址:

https://www.aclweb.org/anthology/2020.acl-main.463.pdf

登录查看更多

相关内容

Arxiv

4+阅读 · 2018年4月13日