Spark 2.4重磅发布:优化深度学习框架集成,提供更灵活的流式接收器

更多优质内容请关注微信公众号“AI 前线”(ID:ai-front)

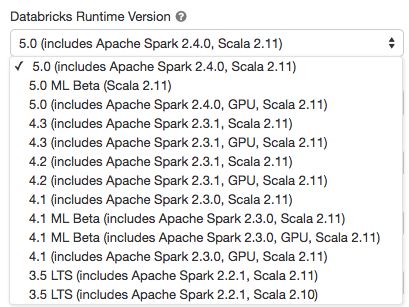

Databricks 正式发布 Apache Spark 2.4,作为 Databricks Runtime 5.0 的一部分。

Release Note 详情:

https://spark.apache.org/releases/spark-release-2-4-0.html

Spark 2.4 继续以更快、更简单、更智能为目标,带来了以下新特性:

一种支持屏障模式的调度器,以便与基于 MPI 的程序(比如分布式深度学习框架)更好地集成;

引入一些内置的高阶函数,让处理复杂的数据类型(即数组和 map)变得更容易;

提供对 Scala 2.12 的实验性支持;

允许对 notebook 中的 DataFrame 进行及早求值,便于调试和排除故障;

引入新的 Avro 数据源。

除了这些新特性外,新版本把重点放在可用性、稳定性和优化上,解决了 1000 个问题。由 Spark 贡献者带来的其他特性还包括:

去掉了 2 GB 块大小限制;

Pandas UDF 改进;

图像模式数据源;

Spark SQL 增强功能;

内置文件源改进;

Kubernetes 集成增强。

接下来将简要介绍一些高级别的特性和改进,在未来几天,Databrick 将发布有关这些特性的深度介绍。有关所有 Spark 组件和 JIRA 已解决的主要特性的完整列表,请参阅 Apache Spark 2.4.0 发行说明(https://spark.apache.org/releases/spark-release-2-4-0.html)。

屏障执行模式是 Hydrogen(https://databricks.com/blog/2018/07/25/bay-area-apache-spark-meetup-summary-databricks-hq.html)的一部分,Hydrogen 是一项 Apache Spark 计划,旨在将最先进的大数据和 AI 技术结合在一起。它可以将来自 AI 框架的分布式训练作业嵌入到 Spark 作业中。他们通常需要探索像 All-Reduce 这种复杂的通信模式,因此需要同时运行所有任务。Spark 当前使用的 MapReduce 模式不满足这样的需求。在这种新的执行模式下,Spark 启动所有训练任务(例如 MPI 任务),并在任务失败时重新启动所有任务。Spark 还为屏障任务引入了一种新的容错机制。在执行过程中如果有任何屏障任务失败,Spark 将中止所有任务并重新启动该执行阶段。

在 Spark 2.4 之前,有两种典型的解决方案用于直接操作复杂类型(例如数组类型):一个是将嵌套结构展开为单独的行,应用一些函数,然后再次创建原先的结构,一个是使用用户定义函数(UDF)。新的内置函数可以直接操作复杂类型,可以使用匿名 lambda 函数操作复杂的值,类似于 UDF,但具有更好的性能。

你可以查看一些有关高阶和内置函数的示例:https://databricks-prod-cloudfront.cloud.databricks.com/public/4027ec902e239c93eaaa8714f173bcfc/142158605138935/3773509768457258/7497868276316206/latest.html。

Apache Avro 是一种非常流行的数据序列化格式,被广泛用在 Apache Spark 和 Apache Hadoop 生态系统中,尤其适用于基于 Kafka 的数据管道。从 Apache Spark 2.4 开始,Spark 为 Avro 数据的读写提供内置支持。新的内置 spark-avro 模块最初来自 Databricks 的开源项目 Avro Data Source for Apache Spark(从现在开始称为 spark-avro,https://github.com/databricks/spark-avro)。此外,它还提供了:

新的函数 from_avro() 和 to_avro(),用于在 DataFrame 中读写 Avro 数据,而不仅仅是文件;

Avro 逻辑类型支持,包括 Decimal、Timestamp 和 Date 类型;

2 倍的读取吞吐量提升和 10%的写入吞吐量改进。

从 Spark 2.4 开始,Spark 将支持 Scala 2.12,并使用 Scala 2.11 和 2.12 进行交叉构建,这两个版本都可以在 Maven 存储库和下载页面中找到。现在,用户可以使用 Scala 2.12 来编写 Spark 应用程序。

Scala 2.12 带来了与 Java 8 更好的互操作性,Java 8 提供了更好的 lambda 函数序列化。它还带来了一些用户期待的新特性和错误修复。

Pandas UDF 最初是在 Spark 2.3.0 中引入的。在新版本中,根据用户反馈不断改进 Pandas UDF。

除了错误修复之外,Spark 2.4 还带来了 2 个新特性:基于 Pandas UDF 定义窗口函数和聚合函数。这些新特性将进一步改善 Pandas UDF 的使用,并在下一版本中继续改进 Pandas UDF。

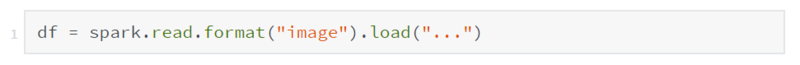

社区看到越来越多图像 / 视频 / 音频处理方面的使用场景。在 Spark 中为这些场景提供内置数据源简化了用户将数据导入 ML 训练方面的工作。在 Spark 2.3 版本中,图像数据源是通过 ImageSchema.readImages 实现的。Spark 2.4 引入了一个新的 Spark 数据源,可以将目录中的图像文件递归加载为 DataFrame。现在加载图像非常简单:

Spark 2.4 带来了很多与 Kubernetes 集成的增强特性。首先,新版本支持在 Kubernetes 上运行容器化的 PySpark 和 SparkR 应用程序。Spark 为用户提供了 Python 和 R 语言的 Dockerfiles 文件,供用户构建基础镜像或自定义镜像。其次,提供了客户端模式。用户可以在运行在 Kubernetes 集群中 pod 上或集群外的客户端计算机上运行交互式工具(例如 shell 或 notebook)。最后,支持挂载以下类型的 Kubernetes 卷:emptyDir、hostPath 和 persistentVolumeClaim。

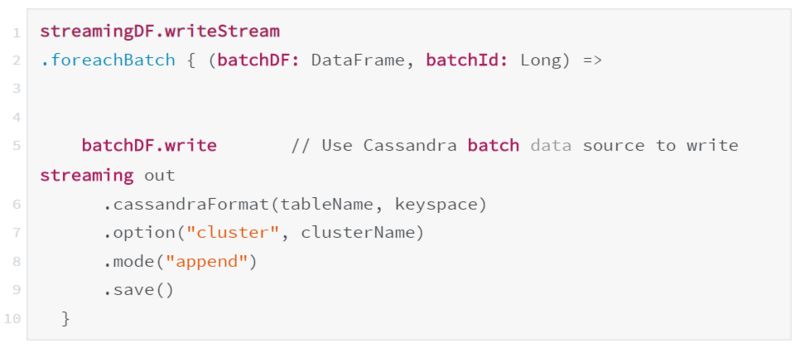

很多外部存储系统已经提供了批次连接器,但并非所有外部存储系统都有流式接收器(sink)。在新版本中,即使存储系统不支持流式接收器,仍然可以通过 streamingDF.writeStream.foreachBatch(…) 在每个微批次输出上使用批次数据写入器。例如,你可以在 foreachBatch 中使用现有的 Apache Cassandra 连接器直接将流式查询的输出写入 Cassandra。

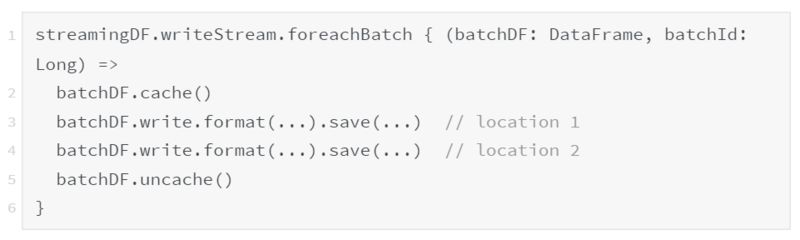

同样,你也可以用它将很多流式 DataFrame 不支持的 DataFrame/Dataset 操作应用在每个微批次输出上。例如,foreachBatch 可用于避免在写入多个位置时重新计算流式查询。

英文原文:

https://databricks.com/blog/2018/11/08/introducing-apache-spark-2-4.html

今日荐文

点击下方图片即可阅读

谷歌开源机器学习工作流Kubeflow Pipelines并推出AI Hub

【阿里的运维技术秘籍请查看】又是一年双十一,淘宝一直被模仿,但从未被超越~

从 2009 年的 0.5 亿元到 2017 年的 1862 亿的成交额,天猫在这 8 年里完成的是一个奇迹!在数千倍激增的成交额背后是数以万亿不断激增的流量。面对这些流量的冲击,阿里的程序员们完成了一个有一个“不可能完成的任务”... 他的智能化运维到底有何独到之处?

点击「阅读原文」了解,有任何问题欢迎咨询售票小姐姐 Joy,电话:13269078023(微信同号)。

如果你喜欢这篇文章,或希望看到更多类似优质报道,记得给我留言和点赞哦!