纽约大学《机器学习入门》课程讲义(附PDF下载)

允中 编译整理

量子位 出品 | 公众号 QbitAI

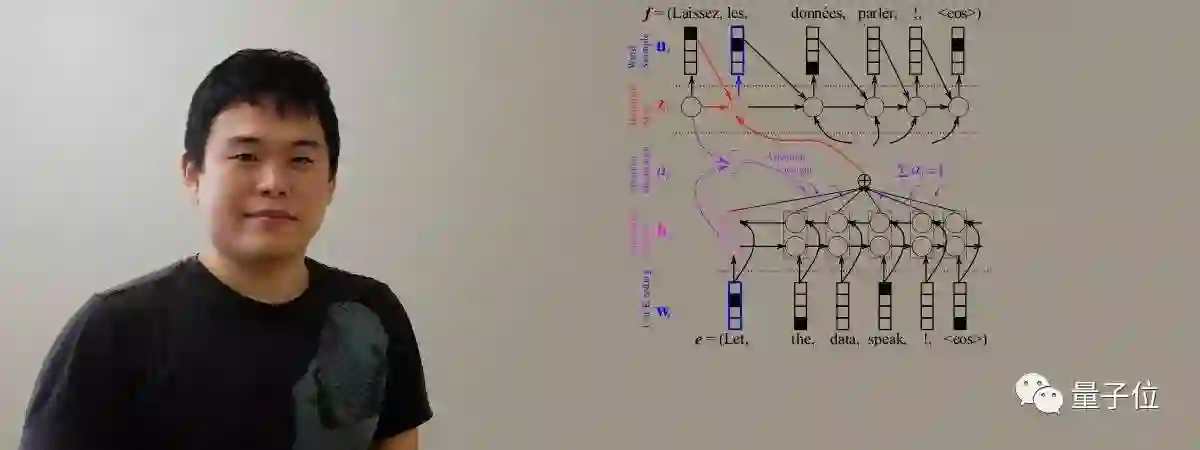

今年春天,Kyunghyun Cho开始在纽约大学教授本科生《机器学习入门》课程。今天,他把这门课程的讲义和相关资料整理发布出来。

Kyunghyun Cho是纽约大学计算机和数据科学的助理教授,也曾经作为博士后在蒙特利尔大学接受Yoshua Bengio的指导。

以下是Kyunghyun Cho对这门课程的简介:

之前这门课程由David Sontag教授,但现在他已经转去了麻省理工。我考虑过继续使用他的教材,相关资料可以在这里看到:http://cs.nyu.edu/~dsontag/courses/ml16/ 。这些内容很棒,强烈推荐。

Sontag的课程覆盖面很广,但是我觉得可能不适合作为本科生的入门课程。所以我决定重新创建一个课程体系。对于本科生来说,最低限度的机器学习知识是什么?1)至少掌握机器学习的高级观点,2)毕业后可以在实践中应用机器学习。

所以就像上一年的NLP课程一样,我开始着手写讲义。

首先是分类。引入感知器和逻辑回归作为例子,展示传统计算机科学与机器学习之间的区别。然后开始介绍(线性)支持向量机。不过由于时间限制,我并没有教授Kernel SVM。接着使用softmax把逻辑回归泛化为多分类逻辑回归。

为了教授如何处理线性不可分的问题,我使用了一种非正统的方法。我从紧邻算法分类器开始,最后将其扩展为自适应基函数网络,我称其为深度学习。讲到这里,大约有一半的学生已经不来上课了……

然后接着讲回归。这里我着重介绍概率机器学习。我介绍了贝叶斯线性回归等。

对于无监督学习,我再次使用了一个非常规的教授路径。令人惊讶的是,学生们对无监督学习更感兴趣,热情超过监督学习,当我教授非线性分类器的时候,流失的学生们已经回来了。

课程的最后,我简要介绍了梯度策略,也是用一个非常规的方式:把强化学习视作一个分类器序列。这方面的研究人员肯定会不开心,但我觉得这样是一种更直观的方法。另外,推荐Joelle Pineau写的强化学习入门:http://videolectures.net/deeplearning2016_pineau_reinforcement_learning/ 。

安妮薇,我全部的讲义都可以在此看到:

https://github.com/nyu-dl/Intro_to_ML_Lecture_Note/raw/master/lecture_note.pdf

有任何的建议可以访问:

https://github.com/nyu-dl/Intro_to_ML_Lecture_Note

不过,就算我接纳您的建议,也得等明年春天再修改讲义了~

另外在授课过程中,我还推荐给学生们以下的资料:

Hans Rosling:这是你见过的最好数据(可视化的重要性)

https://www.ted.com/talks/hans_rosling_shows_the_best_stats_you_ve_ever_seen

李飞飞:如何让电脑看懂图片

https://www.ted.com/talks/fei_fei_li_how_we_re_teaching_computers_to_understand_pictures

专访Hinton:生命的代码

https://www.youtube.com/watch?v=XG-dwZMc7Ng

Larry Jacke:贝尔实验室的机器学习和神经网络

http://techtalks.tv/talks/machine-learning-and-neural-nets-at-bell-labs-holmdel/63005/

下载

下载上述讲义的PDF版本,可以在量子位微信公众号(QbitAI)对话界面,回复:“cho”三个字母。

【完】

交流沟通

量子位读者5群即将满员,对人工智能感兴趣的朋友,欢迎加量子位小助手的微信qbitbot2,申请入群,一起探讨AI。

想要更深一步的交流?

量子位还有大咖云集的自动驾驶技术群和NLP群,仅接纳相应领域的在校学生或一线工程师。申请方式:加qbitbot2为好友,备注“自动驾驶”或“NLP”申请加入~

(审核较严,敬请谅解)

诚挚招聘

量子位正在招募编辑/记者等岗位,工作地点在北京中关村。期待有才气、有热情的同学加入我们!相关细节,请在量子位公众号(QbitAI)对话界面,回复“招聘”两个字。

△ 扫码强行关注『量子位』

追踪人工智能领域最劲内容