来自南京大学叶翰嘉的博士论文,入选2021年度“CCF优秀博士学位论文奖”初评名单!

https://www.ccf.org.cn/Focus/2021-11-22/750448.shtml

开放环境下的度量学习研究

利用对象之间的相似性关系,度量学习为样本学到有效的特征表示,使得 在该表示空间中,样本之间的距离度量能够精确反映样本之间的相似与不相 似关系。有效的距离度量与表示空间极大地辅助了后续的多样化任务。在度 量学习的研究中,传统的方法依赖于静态的、封闭的环境,需要无干扰、不变 化的特征,大量的训练样本,且只能处理单一的对象语义。而实际应用场景 比较复杂,是开放的,并存在“输入噪声多”、“训练样本少”、“特征变化 快”、“语义表示广”等特点。本文从模型在开放环境下输入、输出层面上面 临的挑战作为切入点,提出针对或利用度量学习特性的具体算法,从理论和应 用等多个角度使得度量学习的研究能够契合开放的环境。

1. 从理论上分析了度量学习的泛化能力,并提出策略以降低其样本复杂度。传统机器学习方法要求大量有标记的训练样本,而实际场景中,对于某些 类别,考虑到样本搜集和标注的代价,只能获取极少量的有标记的样本。本文从目标函数性质以及度量重用两个角度进行泛化能力的理论分析,相 对于以往的分析结果,提出如何能获得更快的泛化收敛率,即如何利用更 少的样本得到同样的泛化误差。同时,本文通过大量实验进行验证,说明 满足理论假设时,各因素对样本复杂度的影响与理论中给出的趋势一致。

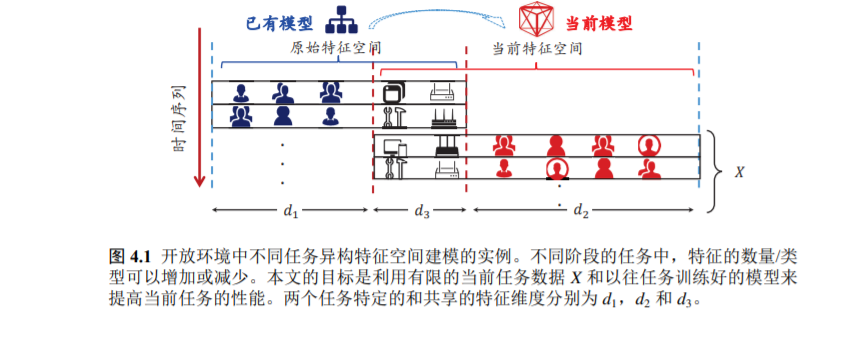

2. 提出一种应用度量语义变换在小样本情况下应对特征变化的学习方法。

除了仅有少量的训练样本,当在开放环境下处理新的任务时,模型也会 面临特征空间变化的挑战。本文利用特征之间的关联性,提出构建特征的 “元表示”空间,利用在该空间中学习的度量,将已有特征空间的分类器 转换到新的特征空间上,以“重用”已有的训练好的异构分类器。提出的 ReForm 方法也降低了学习算法的样本和计算需求。值得一提的是,在ReForm 方法重用分类器的过程中,没有历史训练数据的传输,而仅仅需 要已有的模型,这也保护了不同阶段、不同任务之间数据的隐私性。

3. 提出能够灵活挖掘并自适应利用开放环境中复杂语义的多度量学习框架。

图片、文本等对象在不同场景下往往存在丰富的语义。以往的度量学习 方法只针对对象的单一语义进行建模,而忽略了语义的多样性。本文提出 “语义度量”这一概念以及统一的框架 Uආ2 අ,学习多个局部度量,不但能 统一已有的方法、灵活挖掘出对象本身的不同语义,也能够提升后续众多 实际问题的性能。针对度量数目的选择,本文也提出自适应的多度量学习 框架 Lංൿඍ,利用全局度量的辅助,动态地为不同的语义分配度量的数目。Lංൿඍ 一方面防止模型过拟合、提升分类能力,一方面也降低了存储开销。

4. 提出一种利用分布扰动以适应输入特征和对象关系噪声的度量学习方法。开放动态的环境容易受到噪声的影响。一方面,输入的样本特征容易附带 噪声,导致样本特征的描述不够精确;另一方面,对象之间的关联关系也 会不准确,使后续相似性的学习更加困难。针对这一难点,本文首先对样 本之间的距离做概率化分析,指出上述两种噪声都来源于样本特征的扰 动。并提出一种基于“期望距离”的度量学习方法 Drift。该方法在学习 过程中动态地引入噪声,有效地增广数据,使模型有更好的泛化能力。利 用 Drift 学到的距离度量更加鲁棒,能够更真实地反映对象之间的关系。

![]()

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

专知,专业可信的人工智能知识分发

,让认知协作更快更好!欢迎注册登录专知www.zhuanzhi.ai,获取5000+AI主题干货知识资料!

欢迎微信扫一扫加入专知人工智能知识星球群,获取最新AI专业干货知识教程资料和与专家交流咨询!

点击“

阅读原文

”,了解使用

专知

,查看获取5000+AI主题知识资源