CVPR 2018 | 哈工大提出STRCF:克服遮挡和大幅形变的实时视觉追踪算法

选自arXiv

作者:Feng Li等

机器之心编译

参与:Nurhachu Null、刘晓坤

视觉追踪在多样本的历史追踪结果中学习时,可能遭遇过拟合问题,并在有遮挡的情况下导致追踪失败。为此,哈尔滨工业大学在本文中提出了 STRCF。通过引入时间正则化,STRCF 可以在有遮挡情况下来成功追踪目标,同时能够很好地适应较大的外观变化。该模型在准确率、鲁棒性和速度方面都表现良好,可实时追踪目标。

最近几年我们见证了判别相关滤波器(DCF)在视觉追踪领域的飞速进展。利用训练样本的周期性假设,通过快速傅立叶变换 ( FFT ) 可以在频域中非常高效地学习 DCF。例如,最早的基于 DCF 的追踪器 (即 MOSSE[4] 的追踪速度可以达到每秒 700 帧 ( FPS )。随着特征表示 [ 14,28]、非线性核 [ 19]、尺度估计 [ 11,23,24]、最大边缘分类器 [43]、空间正则化 [ 13,18] 以及连续卷积 [5] 的引入,基于 DCF 的追踪算法得到了显著的改进,极大地提高了追踪准确率。然而,这种性能改进也带来了额外成本。大多数排名靠前的追踪器,例如 SRDCF [13] 和 C-COT [15],已经逐渐失去早期的基于 DCF 追踪器的特征速度和实时追踪能力。例如,使用人工设计的 HOG 特征的 SRDCF [13] 的速度为大约 6 FPS,而基线 KCF [19] 的速度大约是 170 FPS。

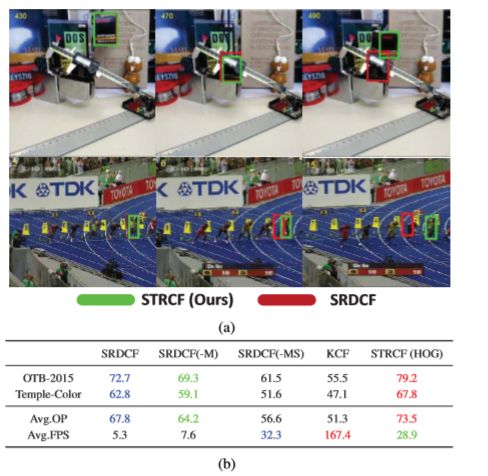

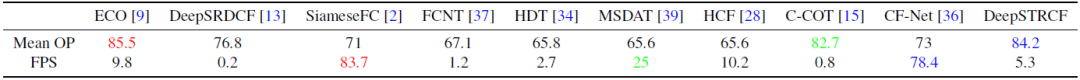

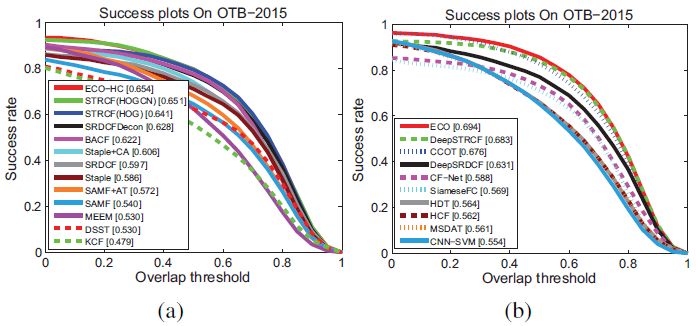

图 1:(a)STRCF 和 SRDCF[13] 方法在具有遮挡和形变的两个序列上的结果。(b)SRDCF 的变体和使用 HOG 特征的 STRCF 在 OTB-2015 和 Temple-Color 数据集上关于 OP(%)和速度(FPS)的比较。最佳结果分别以红色、蓝色和绿色字体显示。

为了更好地理解这个问题,本文剖析了 SRDCF 中准确率和速度之间的权衡。一般而言,SRDCF 的低效率可归因于三个因素: ( i ) 尺度估计;( ii ) 空间正则化;以及 ( iii ) 大规模训练集形式。图 1b 列出了 SRDCF 及其变体在两个流行基准上的追踪速度和准确率,其中包括 SRDCF (—M ) (即去除了 ( iii ) )、SRDCF (—MS ) (即去除 ( ii ) &和 ( iii ) ),以及 KCF (即去除 ( i) 、( ii ) 和 ( iii ) )。作者注意到,在去除 ( iii ) 时,可以采用线性插值 [ 4,11 ] 作为在线模型更新的替代策略。从图 1(b) 中可以看出,当添加尺度估计时,追踪器仍然保持实时能力 (约 33FPS )。但随着空间正则化和大规模训练集形式的进一步引入,追踪速度明显下降。因此,开发一种使用 ( ii ) 和 ( iii ) 的解决方案而不损失效率才是有价值的。

本文研究了在不损失效率的情况下,利用空间正则化和大型训练集形式的优点的方法。一方面,SRDCF 的高复杂度主要来源于对多幅图像的训练形式。通过去除约束条件,单图像样本上的 SRDCF 可以通过 ADMM 有效地解决。由于 SRDCF 的凸性,ADMM 也能保证收敛到全局最优。另一方面,在 SRDCF 算法中,将空间正则化集成到多幅图像的训练形式中,实现了 DCF 学习与模型更新的耦合,提高了追踪准确率。在在线被动攻击 ( PA ) 学习 [ 6] 的启发下,作者将时间正则化方法引入到单图像 SRDCF 中,得到了时空正则化相关滤波器 ( STRCF )。STRCF 是多训练图像上 SRDCF 形式的合理近似,也可用于同时进行 DCF 学习和模型更新。此外,ADMM 算法也可以直接用于求解 STRCF。因此,本文提出的 STRCF 将空间正则化和时间正则化结合到 DCF 中,可以用来加速 SRDCF。

此外,作为在线 PA 算法 [6] 的扩展,STRCF 还可以在外观大幅变化的情况下实现比 SRDCF 更鲁棒的外观建模。图 1(a)展示了对具有遮挡和变形的两个序列的追踪结果。与 SRDCF 相比,引入时间正则化后的 STRCF 对遮挡具有更强的鲁棒性,同时能够很好地适应较大的外观变化。

从图 1(b) 中可以看出,STRCF 不仅以实时追踪速度 ( 约 30FPS ) 运行,而且通过在两个数据集上的平均 OP,其性能比 SRDCF 提高了 5.7 %。综上所述,STRCF 在所有数据集上均比基线 SRDCF 有显著改进,追踪速度提高了 5 倍以上。

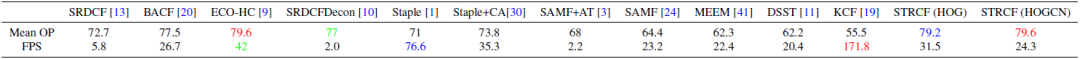

作者在几个基准上进行了比较实验,包括 OTB-2015 [40]、Temple-Color[25]、VOT-2016 [22]。与最先进的基于 CF(相关滤波器)和 CNN 追踪器相比,STRCF 在准确率、鲁棒性和速度方面都表现良好。

这篇论文的主要贡献如下:

通过将空间和时间正则化纳入 DCF 框架,提出了 STRCF 模型。基于在线 PA 的 STRCF 不仅可以合理地逼近多幅训练图像上的 SRDCF 形式,而且在较大的外观变化情况下比 SRDCF 具有更强的鲁棒性。

为高效求解 STRCF,开发了一种 ADMM 算法,其中每个子问题都有封闭形式的解。并且本文提出的算法可以在非常少的迭代中经验地收敛。

本文提出的 STRCF 具有人工设计的特征,可以实时运行,相比 SRDCF 在准确率上有了显著的提升。此外,STRCF 与最先进的追踪器 [9,15] 相比,性能良好。

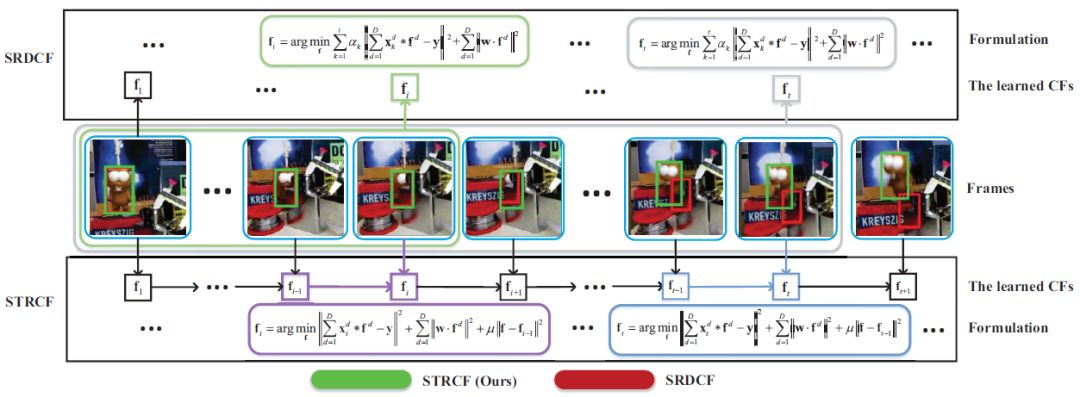

图 2 : SRDCF 和 STRCF 在模型学习方面的比较。SRDCF 从历史追踪结果中学习到具有多个样本的相关滤波器,并着重于最近的样本。因此,它可能遭遇对最近不准确样本的过拟合问题,并且在有遮挡的情况下导致追踪失败。相比之下,本文提出的 STRCF 使用来自当前帧的样本和学习到的 CF f_ t-1 来训练 CF f_t。利用在线 PA,STRCF 可以在遮挡情况下通过被动更新相关滤波器来成功追踪目标。

表 1 : OTB-2015 上具有人工设计特征的追踪器的平均 OP (% ) 和追踪速度(FPS)的结果。最好的三个结果分别以红色、蓝色和绿色字体显示。

论文:Learning Spatial-Temporal Regularized Correlation Filters for Visual Tracking(学习用于视觉追踪的空间-时间正则化相关滤波器)

论文链接:https://arxiv.org/abs/1803.08679

判别相关滤波器 ( DCF ) 在视觉追踪中是很高效的,但是会受到边界效应的影响。空间正则化 DCF ( SRDCF ) 通过对 DCF 系数施加空间惩罚来解决这一问题,在提高了追踪性能的同时不可避免地增加了复杂度。为了解决在线更新问题,SRDCF 在多幅训练图像上建立模型,进一步增加了提高效率的难度。本文将时间正则化方法引入到单样本 SRDCF 中,提出了一种时空正则化相关滤波器 ( STRCF )。在在线被动攻击 ( PA ) 算法的启发下,我们将时间正则化引入到单样本 SRDCF 中,得到了时空正则化相关滤波器 ( STRCF )。STRCF 形式不仅可以合理地逼近多训练样本的 SRDCF,而且在大的外观变化情况下比 SRDCF 具有更强的鲁棒性。此外,它可以通过乘数的交替方向法 ( ADMM ) 有效地求解。通过结合时间和空间正则化,我们的 STRCF 可以处理边界效应,同时不损失效率,并且在准确率和速度上优于 SRDCF。实验在三个基准数据集上进行: OTB-2015、Temple-Color 和 VOT-2016。与 SRDCF 相比,STRCF 采用人工设计的特征,速度提高了 5 倍,OTB-2015 和 Temple-Color 的 AUC 分数分别提高了 5.4 % 和 3.6 %。此外,与 CNN 特征相结合的 STRCF 与基于 CNN 的最先进追踪器相比,性能良好,OTB-2015 的 AUC 得分为 68.3 %。

本文为机器之心编译,转载请联系本公众号获得授权。

✄------------------------------------------------

加入机器之心(全职记者/实习生):hr@jiqizhixin.com

投稿或寻求报道:editor@jiqizhixin.com

广告&商务合作:bd@jiqizhixin.com